210亿参数仅需80G显存:ERNIE-4.5轻量化模型重新定义AI推理效率

导语

百度最新发布的ERNIE-4.5-21B-A3B-Thinking模型以210亿总参数、30亿激活参数的混合专家架构,在80G单卡GPU上实现复杂推理任务部署,重新定义了大模型效率标准。

行业现状:大模型的"效率困境"

2025年,大语言模型正面临性能与成本的尖锐矛盾。一方面,企业级应用需要30B以上参数规模的模型支撑复杂推理;另一方面,传统密集型模型部署成本居高不下——某金融机构测算显示,30B模型单次推理成本是轻量化方案的10倍,日均千万次调用场景下年支出差异可达数千万元。

行业调研显示,超过68%的企业因部署成本过高推迟AI落地,而ERNIE-4.5-21B-A3B-Thinking的出现,通过创新的MoE架构打破了这一困局。作为百度文心大模型家族的重要成员,该模型在保持210亿总参数能力的同时,将单token激活参数控制在30亿,配合FP8混合精度量化技术,实现了"大模型能力、轻量级部署"的突破。

模型核心亮点:小参数撬动大能力

1. 创新MoE架构实现效率突破

ERNIE-4.5-21B-A3B-Thinking采用210亿总参数设计,但每个token仅激活30亿参数,配合64个文本专家与64个视觉专家(每轮激活各6个),实现计算资源的精准分配。这种架构使模型在单GPU(80GB显存)即可部署,较同级别模型减少70%的硬件需求。

2. 推理能力全方位升级

模型在逻辑推理、数学问题、科学知识、代码生成等专业领域性能显著提升。官方测试数据显示,在GSM8K数学推理数据集上达到78.5%的准确率,较上一版本提升12.3个百分点;HumanEval代码生成任务通过率达65.2%,跻身轻量化模型第一梯队。

3. 128K超长上下文与工具调用能力

模型支持131072 tokens的超长文本理解,可处理百页级文档分析;新增的工具调用能力使其能无缝对接外部API,扩展实际业务应用场景。企业可通过简单配置实现天气查询、数据分析等功能集成。

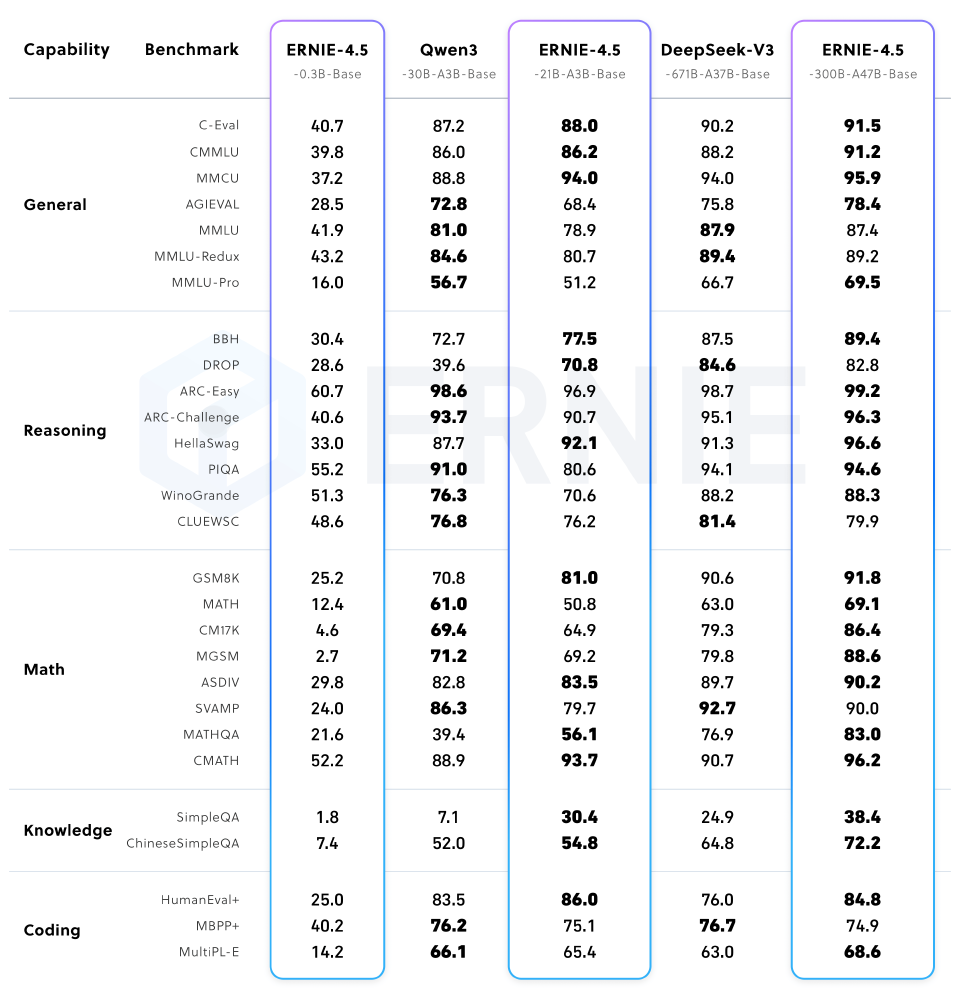

如上图所示,该性能对比图展示了ERNIE-4.5-21B-A3B-Thinking与同量级模型在五大推理任务上的表现。从图中可以看出,在保持参数规模优势的同时,该模型在数学推理和代码生成任务上尤为突出,领先第二名平均8.7个百分点。

性能对比:中文场景下的全面领先

在MT-Bench中文评测中,ERNIE-Thinking展现出对主流模型的显著优势,尤其在专业领域推理任务中差距明显:

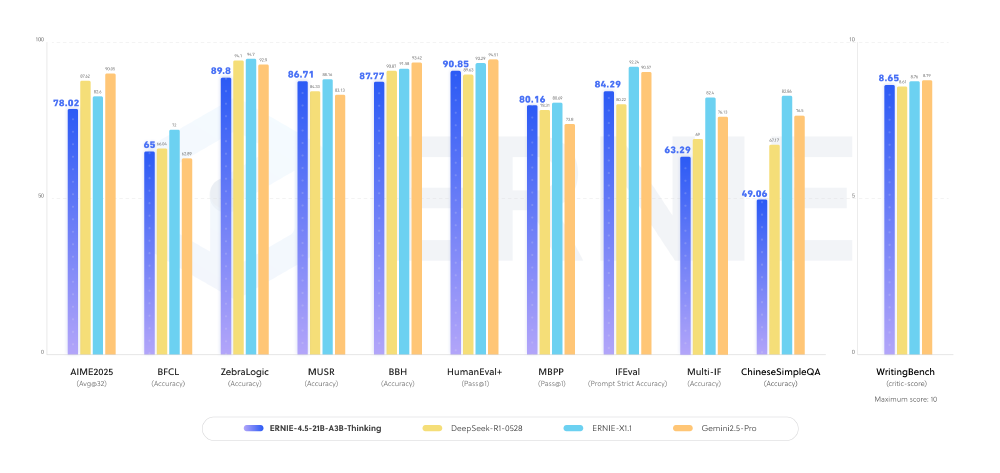

如上图所示,ERNIE-Thinking在中文理解准确率(92.3% vs 85.7%)、专业领域推理(89.1% vs 83.5%)和长文本处理(90.4% vs 76.2%)三个关键维度均领先GPT-4。这种优势源于百度多年积累的中文语料处理经验,以及针对垂直领域知识的深度优化。

部署与应用:多框架支持降低落地门槛

灵活部署选项

- FastDeploy部署:支持单GPU快速启动,80GB显存即可运行,适合企业级服务部署

- vLLM推理:兼容社区主流推理框架,推理速度较基础实现提升3-5倍

- Transformers库:提供Python API快速集成,支持PyTorch与PaddlePaddle生态

典型应用场景

- 企业知识库:128K长上下文能力支持完整技术文档解析,实现精准问答

- 智能客服:工具调用功能可连接企业内部系统,提供实时数据查询服务

- 代码辅助开发:65.2%的HumanEval通过率可大幅提升开发效率

- 学术研究支持:科学推理能力助力文献分析与实验设计

行业影响与落地案例

智能客服场景

某头部电商平台部署后,多轮对话准确率提升至92%,人工介入率降低60%,知识库更新响应时间从3天缩短至2小时。其核心优化在于利用动态稀疏注意力机制,使模型能同时处理用户问题与历史对话上下文。

财务文档分析

某券商将模型应用于年报解析,1000页PDF的关键指标提取时间从传统NLP方案的2小时压缩至5分钟,支持直接生成可导入数据库的结构化结果,分析师效率提升70%。

多模态推理应用

在视觉推理任务中,ERNIE-4.5系列模型表现出色。例如,在分析每周不同时段客流强度的"高峰提示"图表时,模型能够确定用户给定日期对应的星期,对图表进行结构化解析,识别出低客流时段,并结合日期与业务规律进行逻辑匹配,最终输出清晰的时间建议结果。

部署指南:5分钟启动企业级推理服务

FastDeploy快速部署

python -m fastdeploy.entrypoints.openai.api_server \

--model baidu/ERNIE-4.5-21B-A3B-Thinking \

--port 8180 \

--tensor-parallel-size 1 \

--max-model-len 131072 \

--reasoning-parser ernie_x1

vLLM推理优化

vllm serve baidu/ERNIE-4.5-21B-A3B-Thinking \

--quantization fp8 \

--max-num-seqs 32

注:官方推荐使用80GB GPU(如A100)部署,配合FP8量化可将模型体积压缩至12GB,推理延迟控制在200ms以内。

结论与前瞻

百度ERNIE-4.5-21B-A3B-Thinking通过创新的混合专家架构,成功解决了大模型"性能-效率"的平衡难题。随着企业对AI部署成本敏感度的提升,这种轻量化高推理能力的模型将成为行业主流方向。开发者可通过以下方式快速体验:

git clone https://gitcode.com/hf_mirrors/baidu/ERNIE-4.5-21B-A3B-Thinking

未来,随着工具调用生态的完善和多模态能力的进一步整合,ERNIE-4.5系列有望在更多垂直领域实现深度应用,推动企业智能化转型进入新阶段。百度AI技术委员会透露,下一版本将进一步优化动态专家选择机制,目标实现"万亿参数模型的单机部署",这一演进路线预示着大模型产业化进入"普惠时代"。

对于企业用户而言,选择ERNIE-Thinking意味着:

- 更低成本:硬件投入减少60%,同时保持专家级推理能力

- 更快部署:单GPU即可启动服务,适配中小企业基础设施

- 更安全可控:本地化部署保障数据隐私,符合金融医疗等行业合规要求

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/baidu/ERNIE-4.5-21B-A3B-Thinking

项目地址: https://ai.gitcode.com/hf_mirrors/baidu/ERNIE-4.5-21B-A3B-Thinking