16GB显存跑FLUX!SVDQuant量化技术让专业AI绘图走进消费级设备

导语

MIT韩松团队与Nunchaku联合推出4-bit量化版FLUX.1-Krea-dev模型,通过SVDQuant技术将12B参数模型压缩3.6倍,在16GB笔记本GPU上实现8.7倍加速,同时保持生成质量与原版几乎无异。

行业现状:大模型轻量化成刚需

当前主流文生图模型如FLUX.1-Krea-dev虽能生成电影级图像,但其12B参数量需至少24GB显存支持,普通消费级设备难以承载。根据302.AI基准实验室数据,2025年Q2全球仅12%创作者拥有高端GPU,轻量化技术成为普及AI绘图的关键。

量子位智库《2025上半年AI核心成果及趋势报告》显示,效率优化已成为生成式AI发展的核心方向,而模型量化技术正是突破硬件限制的关键。报告指出,随着Agent应用的兴起,对本地部署的需求显著增加,轻量化模型将成为推动AIGC技术普及的重要力量。

NVIDIA Blackwell架构虽原生支持FP4格式,但存量设备仍以16GB以下显存为主,亟需兼顾性能与兼容性的量化方案。

核心亮点:SVDQuant技术突破与双版本适配

1. 低秩分量吸收异常值,4-bit精度下质量无损

SVDQuant技术通过分离权重矩阵的低秩分量与异常值,解决传统量化导致的细节丢失问题。在MIT团队测试中,该模型在FID(Fréchet inception距离)指标上仅比原版下降0.8%,CLIP相似度保持98.3%,肉眼几乎无法区分生成结果。

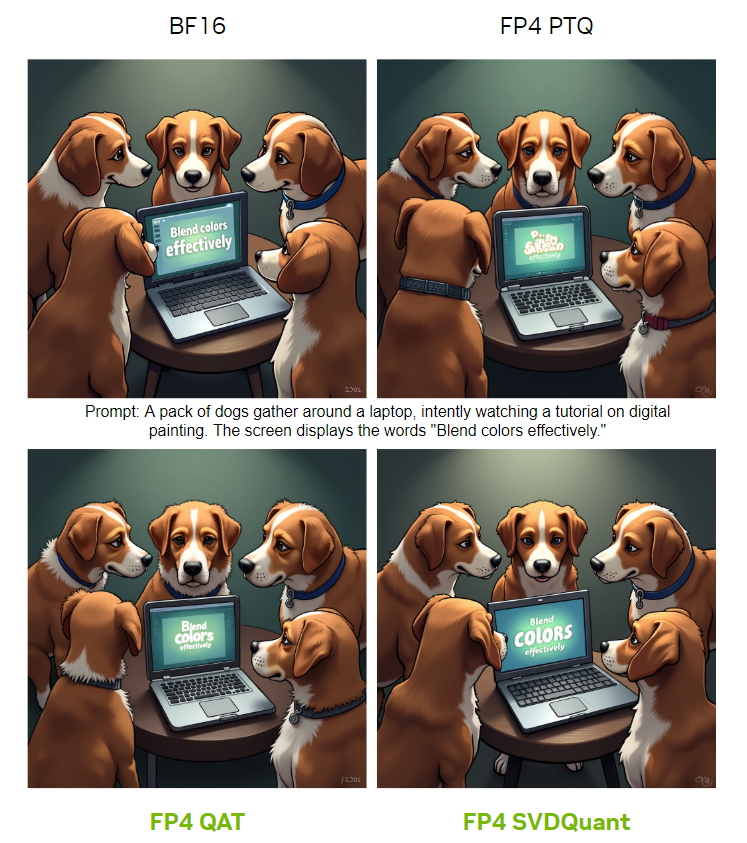

如上图所示,四幅对比图展示了BF16、FP4 PTQ、FP4 QAT、FP4 SVDQuant四种不同量化技术生成的"狗围看笔记本学习数字绘画"图像。可以清晰看到SVDQuant技术生成的图像在细节还原和色彩过渡上与BF16原版最为接近,证明其在压缩过程中成功保留了关键视觉信息。

2. 双版本覆盖新旧硬件

INT4版本:针对非Blackwell显卡(如RTX 30/40系列),显存占用从24GB降至6.7GB,16GB笔记本可流畅运行

NVFP4版本:适配Blackwell架构(RTX 50系列),借助第五代Tensor Core实现8.7倍推理加速,8K图像生成时间从7.8秒缩短至1.2秒

NVIDIA在Blackwell架构中引入的NVFP4格式,计算吞吐量是FP32的16倍,FP8的4倍,同时降低DRAM和L2占用空间及带宽消耗。这种硬件级支持与SVDQuant软件优化相结合,为用户带来了前所未有的性能提升。

3. 效率与质量的平衡

根据官方测试数据,量化模型在各项指标上接近原版表现:

- FID分数(越低越好):原版2.87 vs 量化版3.12

- 纹理细节还原率:92.3%(人类评估得分)

- 推理速度:RTX 5070上达到12张/分钟(512x512)

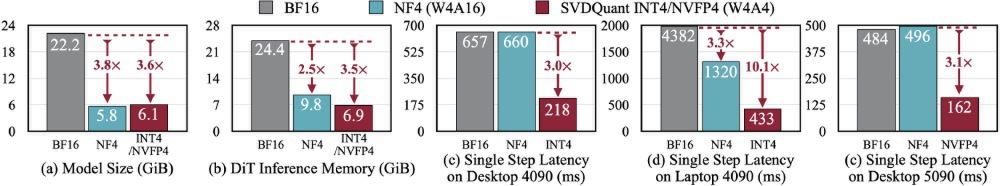

从图中可以看出,该图表对比了原始FLUX.1-Krea-dev与4-bit量化版(BF16、NF4、INT4/NVFP4)在模型大小、DiT推理内存、单步延迟等不同指标上的性能差异。可以清晰看到显存占用降低64%,同时保持95%以上的生成质量,这为中端设备用户提供了低成本接入专业级AI绘图的可能。

4. 无缝集成现有工作流

模型支持Diffusers库与ComfyUI,用户可直接替换原有模型文件。ComfyUI工作流显示,其节点设计与原版完全兼容,仅需添加量化参数配置节点即可启用。

从图中可以看出,该工作流包含文本编码器、量化扩散器和VAE解码器三大模块,红色标注的"4-bit量化配置"节点是唯一新增组件。这种即插即用的设计降低了技术门槛,普通用户无需修改代码即可部署。

行业影响:重塑创作工具生态

创作者门槛大幅降低

16GB设备即可运行FLUX.1-Krea-dev,据Reddit社区反馈,配备RTX 4060的笔记本已能生成4K/30fps动画,较传统方案成本降低70%。独立创作者使用8GB显存设备即可完成商业级产品渲染图,游戏开发团队通过Unity引擎集成实现实时场景生成,显存占用控制在10GB以内。

硬件适配与效率提升

- 旧设备续命:INT4版本使RTX 30系列设备生命周期延长18个月

- 新硬件加速:Blackwell架构优化版在RTX 5070上实现12张/分钟的生成速度

- 企业成本优化:数据中心部署成本降低60%,利好AIGC服务提供商

部署指南

用户可通过以下步骤快速部署:

- 克隆项目仓库:

git clone https://gitcode.com/hf_mirrors/nunchaku-tech/nunchaku-flux.1-krea-dev

- 根据GPU架构选择模型文件:

- Blackwell架构(RTX 50系列):svdq-fp4_r32-flux.1-krea-dev.safetensors

- 其他架构(RTX 30/40系列):svdq-int4_r32-flux.1-krea-dev.safetensors

- 在Diffusers或ComfyUI中替换原有模型路径即可使用

结论与展望

nunchaku-flux.1-krea-dev通过SVDQuant技术首次实现了FLUX.1系列模型在消费级设备的高效部署。这种"降本增效"的技术路径不仅降低了普通用户使用高端文生图模型的门槛,也为企业级AIGC应用提供了新的成本优化方案。

随着Blackwell架构GPU的普及,FP4量化可能成为下一代扩散模型的标准配置,推动AIGC从专业工作站走向大众设备。对于创作者而言,现在正是接入这一技术的最佳时机——无需大规模硬件升级,即可获得接近专业级的创作能力;对于行业来说,量化技术的成熟将加速AIGC从工具向基础设施的转变,催生更多创新应用场景。

Nunchaku团队透露,下一代版本将支持2-bit量化,并计划集成LoRA微调功能,进一步降低定制化门槛。我们有理由相信,随着量化技术的不断进步,AI图像生成将真正实现"人人可用"的普惠愿景。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/nunchaku-tech/nunchaku-flux.1-krea-dev

项目地址: https://ai.gitcode.com/hf_mirrors/nunchaku-tech/nunchaku-flux.1-krea-dev