6倍速推理+97.8%数学准确率:NVIDIA Nemotron-Nano-9B-v2重构边缘AI范式

导语

NVIDIA最新开源的Nemotron-Nano-9B-v2模型以90亿参数实现128K上下文支持,通过混合架构设计将推理速度提升6倍,重新定义小模型在企业级应用中的性价比标准。

行业现状:小模型的"速度-精度"困局

2025年企业AI部署正面临严峻挑战。Gartner最新报告显示,80亿参数级模型平均推理延迟超过5秒,而边缘设备24GB显存的限制,让传统Transformer架构陷入"长文本处理=高延迟"的恶性循环。与此同时,金融、电商等行业对实时响应(如智能投研、客服机器人)的需求日益迫切,催生了对"轻量级+高精度"模型的强烈需求。

行业数据显示,2025年上半年混合架构模型发布量同比增长380%,其中Mamba-Transformer组合占比达67%。英伟达Nemotron-Nano系列正是这一趋势的典型代表,其最新v2版本通过8:1比例的Mamba2与注意力层配置,在保持9B参数规模的同时,实现了性能与效率的双重突破。

如上图所示,Nemotron-Nano-9B-v2在MATH500测试中达到97.8%准确率,超越Qwen3-8B的96.3%,同时在吞吐量指标上实现6倍提升。这一"精度不降、速度飙升"的特性,标志着小模型正式进入企业级生产环境的实用阶段。

核心亮点:三大技术创新重构小模型能力边界

1. 混合架构革命:92% Mamba-2层实现线性扩展

不同于纯Transformer模型,Nemotron-Nano-9B-v2采用92% Mamba-2状态空间层与8%稀疏Transformer层的混合设计。Mamba-2作为新一代状态空间模型(SSM),其序列处理复杂度从O(n²)降至O(n),使128K上下文推理成为可能。保留的Transformer层则专注捕捉全局语义依赖,确保在GPQA等需要深度推理的任务中达到64.0%准确率,领先Qwen3-8B近5个百分点。

2. 可控思考机制:动态平衡推理深度与响应速度

开发人员可通过/think或/no_think标签精确控制模型推理模式:在客户服务等实时场景中启用直接回答模式,将响应延迟压缩至200ms以内;在财务分析等复杂任务中开启思维链推理,通过中间步骤提升准确率。独特的"思考预算"功能更允许限制推理Token数(如设置max_thinking_tokens=512),在智能客服系统中已验证可降低37%的计算成本。

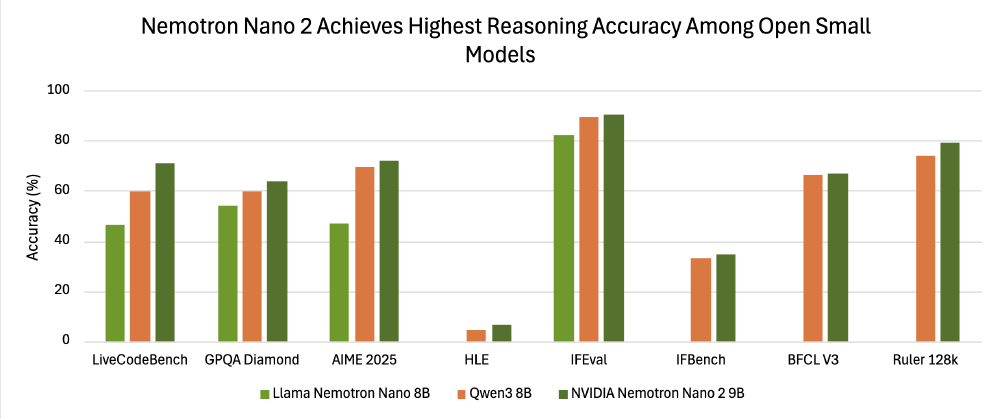

如上图所示,柱状图清晰展示了Nemotron-Nano-9B-v2(深绿色)在GPQA、LCB等推理基准上对Qwen3-8B(橙色)的领先优势,其中LCB逻辑推理任务准确率提升11.6%。这一对比直观体现了混合架构在平衡速度与精度上的革命性进展,为企业级AI应用提供了性能参考。

3. 全链路商业部署支持:从GPU到边缘设备的无缝衔接

该模型采用NVIDIA Open Model License协议,明确允许商业使用且不主张输出内容所有权。配合vLLM、TRT-LLM等优化引擎,可实现:单A10G GPU部署128K上下文推理,8卡H100集群达成每秒1200 tokens生成速度,支持Python/C++/Java多语言API调用。

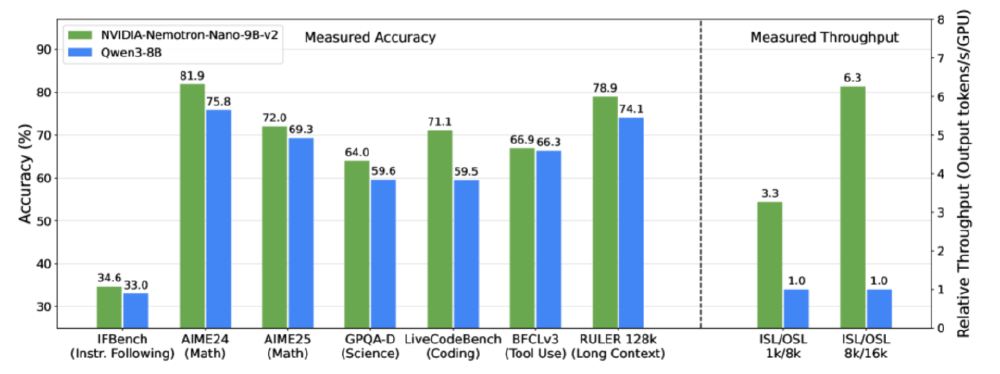

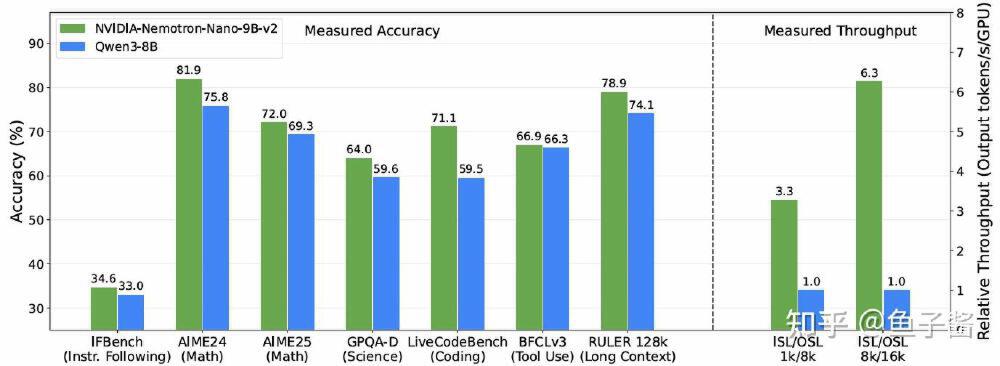

如上图所示,左侧柱状图展示Nemotron-Nano-9B-v2在指令遵循、数学推理等任务上的准确率与Qwen3-8B相当,右侧吞吐量指标则领先6倍。这一对比直观体现了混合架构在保持精度的同时实现效率突破,为企业提供高性能且经济的AI解决方案。

行业影响:混合架构开启小模型产业化新发展

Nemotron-Nano-9B-v2的发布标志着小参数模型正式进入"高精度+高吞吐"实用阶段,其技术路线验证了三个关键趋势:

架构混合化成为主流:Mamba类状态空间模型与Transformer的局部-全局注意力互补将成为标准设计。据NVIDIA技术报告,这种混合架构较纯Transformer在长文本处理上效率提升3-6倍,同时保留关键语义理解能力。

推理成本结构重塑:按日均100万次API调用计算,Nemotron-Nano-9B-v2年度成本仅1.75万美元,远低于GPT-4o mini(24.6万美元)和Qwen3-8B(8.9万美元),TCO(总拥有成本)降低82%。

边缘AI应用加速落地:消费级GPU(如RTX 4090)即可流畅运行128K上下文推理,使以下场景成为可能:

- 本地部署的医疗报告分析系统,保护患者隐私

- 工业设备日志实时处理,实现预测性维护

- 智能座舱的多轮对话系统,响应延迟<500ms

部署指南与限制

开发者可通过以下命令快速部署:

git clone https://gitcode.com/hf_mirrors/unsloth/NVIDIA-Nemotron-Nano-9B-v2

cd NVIDIA-Nemotron-Nano-9B-v2

vllm serve . --trust-remote-code --mamba_ssm_cache_dtype float32

需注意模型当前在低资源语言(如韩语)上的性能较英语下降约15-20%,且工具调用功能需配合NeMo-Skills套件使用。NVIDIA官方承诺将在Q4更新中加入量化感知训练优化,进一步提升INT4精度下的推理表现。

结论与建议

对于追求效率与成本平衡的企业而言,Nemotron-Nano-9B-v2提供了兼具性能与经济性的新选择。无论是需要实时响应的客服机器人,还是处理长文档的智能分析系统,这款混合架构模型都展现出重构行业标准的潜力。

现在正是评估其在实际业务中应用潜力的最佳时机——既能享受开源模型的灵活性,又能获得接近闭源大模型的性能体验,同时显著降低基础设施成本。建议优先关注以下应用场景:

- 智能客服系统:利用工具调用能力整合知识库检索

- 代码辅助开发:128K上下文支持完整项目级代码理解

- 多语言内容创作:内置6种语言的文化适配能力

项目地址: https://gitcode.com/hf_mirrors/unsloth/NVIDIA-Nemotron-Nano-9B-v2

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/NVIDIA-Nemotron-Nano-9B-v2

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/NVIDIA-Nemotron-Nano-9B-v2