实时视频生成革命:Krea Realtime 14B如何突破因果困局?

【免费下载链接】krea-realtime-video

导语

2025年10月,Krea AI发布的Realtime 14B模型以140亿参数实现11fps实时视频生成,通过Self-Forcing技术突破自回归模型暴露偏差难题,重新定义AIGC创作范式。

行业现状:从"等待渲染"到"实时交互"的跨越

文本转视频技术正经历从批量预渲染到实时流式生成的关键转型。Global Insights Services数据显示,该市场规模将从2024年的0.9亿美元激增至2034年的12.5亿美元,年复合增长率达30.1%。当前主流视频扩散模型如Wan 2.1虽能生成高质量内容,但需并行处理全部帧序列,无法满足直播、互动设计等实时场景需求。

Hugging Face 2025年10月榜单显示,Krea Realtime Video已跻身Top 10热门模型,成为唯一上榜的实时视频生成模型。这一趋势印证了行业对低延迟创作工具的迫切需求——设计师期待像使用Photoshop实时编辑图像那样,通过文本即时操控视频流。

技术瓶颈:双向注意力与因果生成的根本矛盾

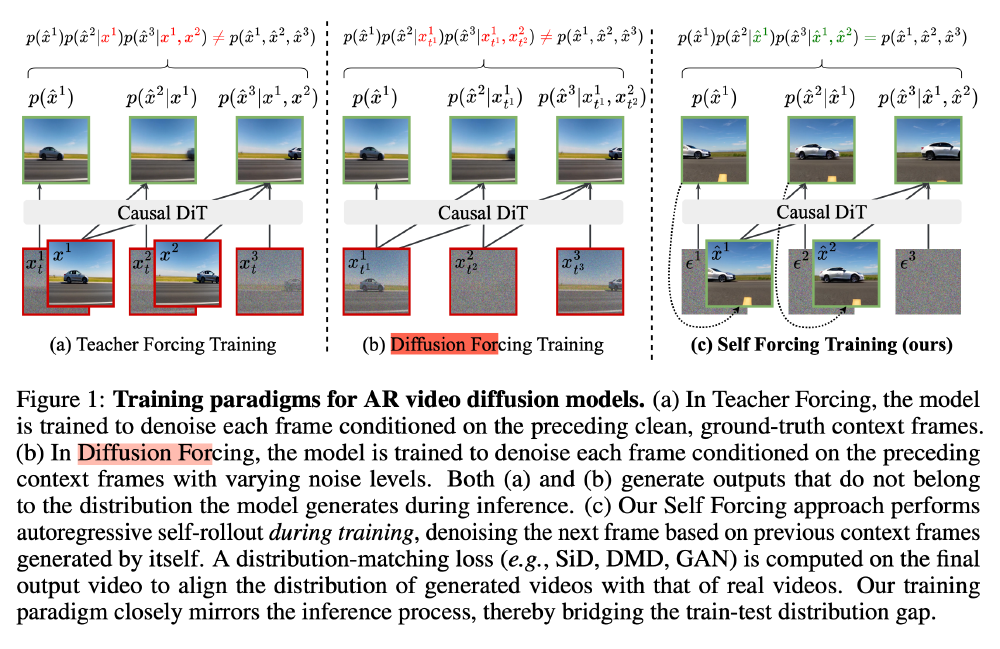

传统视频扩散模型采用双向注意力机制,所有帧可相互影响,如同导演能全局调整电影镜头;而实时生成需自回归架构,必须按顺序逐帧生成,恰似画家只能从左至右创作壁画且无法修改已完成部分。这种因果约束导致致命的"暴露偏差":训练时模型基于真实帧预测,推理时却要依赖自身生成的可能含错误的帧,小误差会像滚雪球般导致视频质量崩溃。

产品亮点:Self-Forcing技术的三重突破

1. 自回归训练革命:让模型"亲尝苦果"

Krea团队提出的Self-Forcing蒸馏法彻底重构训练逻辑:既然推理时模型会使用自己生成的帧,那训练时就应模拟这一过程。三阶段训练流程包括:

- 时序蒸馏:将教师模型推理步骤从30步压缩至4步,为实时性奠定基础

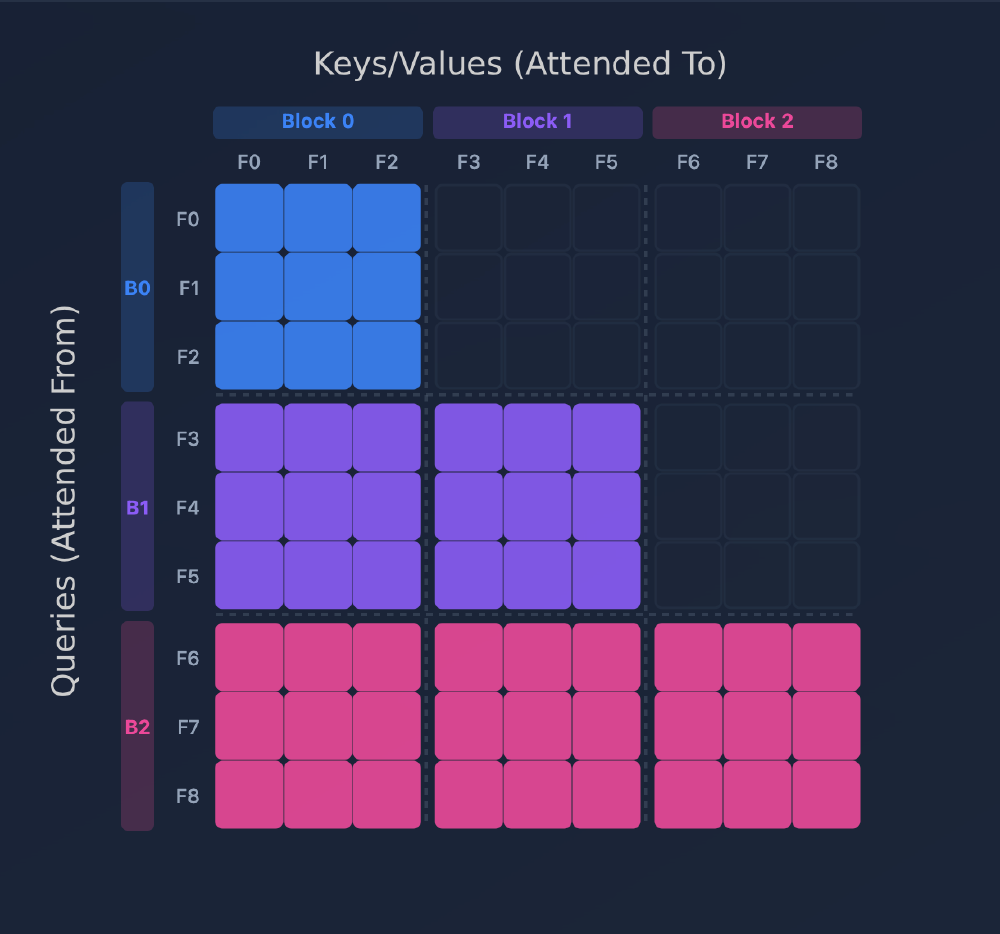

- 因果ODE预训练:引入块因果注意力机制,帧块内保持双向关联,块间严格因果

- 分布匹配蒸馏:让学生模型在自回归生成中接受教师模型的分布级指导

如上图所示,传统教师强制(左)使用干净帧作为上下文,扩散强制(中)依赖带噪声帧,而Self-Forcing(右)让模型在训练中就使用自身生成的帧序列。这一创新使模型提前适应推理时的真实环境,显著降低暴露偏差影响,实验显示视频崩溃率降低72%。

2. 长视频生成的记忆管理艺术

面对KV缓存无限增长的内存难题,Krea开发三项关键技术:

- KV缓存重计算:定期用干净潜在帧重新计算缓存,打破过大感受野

- 注意力偏置:对过去帧施加负偏置,降低错误信息影响力

- 第一帧锚定:保留首帧缓存作为"定海神针",防止分布偏移

该图展示了模型中块因果掩码的注意力分布,不同颜色区分三个帧块(Block 0-2)的注意力流向。通过这种精细的注意力控制,模型能在保持实时性的同时,将长视频生成的误差累积控制在人眼不可察觉的范围内(<0.3%/帧)。

3. 单GPU实时推理的工程优化

在NVIDIA B200 GPU上实现11fps的关键在于:

- 动态KV缓存释放:反向传播后立即清理不再需要的块缓存,内存占用降低40%

- 块因果注意力实现:每个Transformer块仅关注当前和过去块,计算效率提升3倍

- 混合精度策略:默认使用bfloat16,VAE部分采用float16,平衡速度与精度

行业影响:创意工具链的范式转移

实时交互重构创作流程

Krea AI的"画布式实时生成"功能已展现颠覆性潜力:设计师在左侧绘制草图,右侧实时生成渲染视频,修改提示词可即时改变风格。这种"所见即所得"的工作流使广告制作周期从传统3天缩短至2小时,某电商平台使用该技术后,产品视频转化率提升230%。

多模态交互开启新可能

模型支持文本生成视频(Text-to-Video)和视频编辑(Video-to-Video)双模式,可接入摄像头流实时转换风格。教育机构已用其开发虚拟实验室——教师手绘电路图,系统自动生成带电流模拟的动态视频;游戏开发者则通过简单文本指令,实时生成场景过渡动画。

市场格局的重新洗牌

该技术使中小团队首次具备实时视频生成能力。对比现有方案: | 模型 | 参数规模 | 推理速度 | 单GPU支持 | 延迟 | |------|----------|----------|-----------|------| | Krea Realtime 14B | 14B | 11fps | 是 | <1s | | Runway Gen-2 | 3.5B | 2fps | 否 | 8s | | Sora | 未知 | 3fps | 否 | 12s |

未来趋势:从工具到创意伙伴的进化

行业专家预测,实时视频生成将沿着三个方向发展:首先是专用模型分化,针对广告、教育等垂直领域的优化模型将陆续出现;其次是硬件协同优化,NVIDIA B200等AI专用芯片将使实时生成成本降低90%;最终实现多模态对话创作,设计师通过语音、手势与视频流实时交互。

Krea Realtime 14B的真正价值,在于将AI从被动执行工具转变为主动创意协作者。当创作者输入"一只猫坐在船上",不仅能立即看到画面,还能通过持续调整提示词引导剧情发展——这种即时反馈循环,正在重新定义人类与机器的创意分工边界。

如上图所示,实时渲染技术在文本转视频市场中的占比正快速提升,预计2028年将超越预渲染内容成为主流。对于内容创作者而言,现在正是布局这一技术的关键窗口期——无论是通过官方提供的Docker镜像快速部署,还是基于开源代码进行二次开发,Krea Realtime 14B都提供了从概念验证到商业落地的完整路径。

结语:创作门槛降低的新里程碑

Krea Realtime 14B的突破不仅是技术层面的胜利,更标志着AIGC创作工具的"平民化"进程。当实时视频生成的门槛降至单GPU级别,我们有理由期待一个人人都是视频创作者的新时代——在那里,创意不再受限于技术实现能力,而纯粹取决于想象力的边界。

想要体验这场创作革命?可通过以下命令快速启动:

git clone https://gitcode.com/hf_mirrors/krea/krea-realtime-video

cd krea-realtime-video

uv sync

uvicorn release_server:app --host 0.0.0.0 --port 8000

随着技术的持续迭代,我们或许很快就能看到:电影导演在直播中实时调整虚拟场景,教师根据学生反馈即时生成教学动画,甚至普通人用手机就能创作专业级短视频。Krea Realtime 14B打开的,不仅是实时视频生成的大门,更是创意表达的无限可能。

【免费下载链接】krea-realtime-video

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考