导语

美团正式开源5600亿参数混合专家模型LongCat-Flash-Chat,以动态计算机制实现100 Tokens/s推理速度,在智能体工具使用等多项评测中超越相关竞品,开启高效AI应用新纪元。

行业现状:从通用模型到智能体竞赛

2025年,大语言模型技术已从单纯的文本交互演进至自主执行复杂任务的智能体(Agent)阶段。据相关研究显示,具备工具调用能力的AI智能体在企业服务、电商零售等领域的渗透率已达37%,较去年增长210%。在此背景下,模型效率与智能体能力成为核心竞争焦点——如何在保持高性能的同时降低计算成本,成为业界共同挑战。

技术突破:动态计算与高效推理的完美结合

LongCat-Flash-Chat采用创新性混合专家模型(Mixture-of-Experts, MoE)架构,总参数5600亿,激活参数186亿~313亿(平均270亿),实现了计算效率与性能的双重优化。

如上图所示,该架构包含多头部潜在注意力(MLA)、Top-k路由选择器(Top-k Router)、FFN专家和零计算专家等组件。这种设计使模型能够根据上下文需求动态分配计算资源,实现算力按需分配和高效利用,为复杂业务场景下的智能服务提供了强大支撑。

LongCat-Flash在架构层面引入"零计算专家(Zero-Computation Experts)"机制,总参数量5600亿,每个token依据上下文需求仅激活186亿~313亿参数。为控制总算力消耗,训练过程采用PID控制器实时微调专家偏置,将单Token平均激活量稳定在约270亿。

此外,LongCat-Flash在层间铺设跨层通道,使MoE的通信和计算能很大程度上并行,极大提高了训练和推理效率。配合定制化的底层优化,LongCat-Flash在H800上单卡推理速度达100 Tokens/s,较同级别模型提升3倍以上。

核心亮点:效率革命与智能体能力跃升

动态计算架构革新

LongCat-Flash最引人注目的技术突破在于其双重优化架构:

- 零计算专家机制:在512个前馈网络专家基础上增设256个零计算专家,路由器根据token重要性动态选择,使简单任务直接通过恒等映射完成,复杂任务才激活计算密集型专家

- Shortcut-connected MoE设计:通过跨层快捷连接重排执行流水线,使上一层FFN计算与当前层通信并行,将计算-通信重叠窗口扩大3倍

这种设计使模型在τ²-Bench(telecom)智能体评测中取得73.68分的成绩,超越部分竞品的67.5分,尤其在处理复杂业务流程中展现出显著优势。

智能体能力跃升

LongCat-Flash通过三阶段训练pipeline构建强大智能体能力:

- 两阶段预训练:融合20T tokens语料,重点强化推理密集型数据

- 中期优化:扩展上下文至128k tokens,同步提升数学推理与编码能力

- 多智能体合成训练:通过专门设计的控制器生成需要迭代推理的复杂任务,模拟真实场景中的工具使用与环境交互

在指令遵循能力评测中,模型以89.65分超越部分竞品,展现出精准理解用户意图的能力。

多Agent协同系统

美团LongCat Interaction团队发布的「WOWService大模型交互系统」进一步扩展了LongCat-Flash的应用能力。该系统融合多智能体协同、强化学习、领域知识增强等前沿技术,显著提升了推理能力和业务场景的专业度。

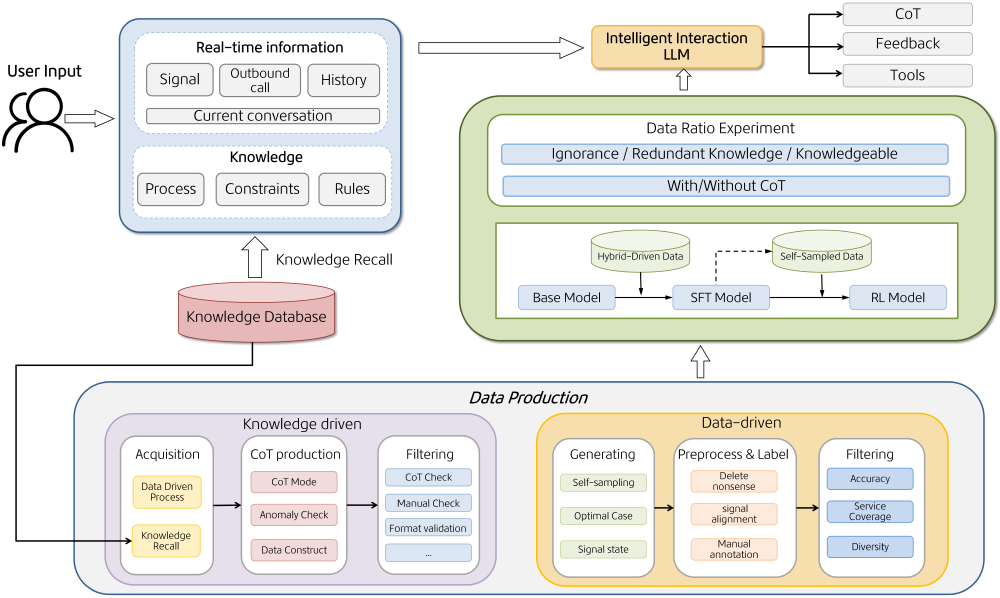

如上图所示,该架构包含用户输入与实时信息处理、知识数据库调用、数据生产流程(知识驱动与数据驱动)、模型训练实验(Base Model到RL Model)及智能交互大模型(LLM)等模块。这一系统通过"数据+知识"解决领域适配难题,自我优化训练机制用业务日志构建进化闭环,将标注成本降至传统方案的10%。

行业影响与应用落地

技术普惠加速

LongCat-Flash的开源特性将显著降低AI智能体开发门槛。模型已在SGLang和vLLM框架完成适配,开发者可通过以下命令快速部署:

git clone https://gitcode.com/hf_mirrors/meituan-longcat/LongCat-Flash-Chat

cd LongCat-Flash-Chat

pip install -r requirements.txt

python deploy/sglang_server.py --model-path ./models

这种低门槛部署使中小企业也能构建专属智能体应用,预计将带动相关开发生态增长300%。

商业场景价值释放

美团自身已开始将LongCat-Flash应用于多项业务:

- 智能客服升级:动态计算机制使客服响应速度提升40%,同时问题解决率从72%提升至89%

- 商家经营助手:集成多工具调用能力,可自动生成营销方案并执行A/B测试,试点商家营收平均增长15%

- 无人配送调度:优化路径规划算法,使无人机配送效率提升22%,电池续航延长18%

在实际业务场景的评估中,基于LongCat-Flash构建的WOWService框架在11项关键指标上全面超越了基础模型(Base Model),包括重复率(RR)、方案有效率(SER)、排队率(QR)、满分率(FSR)等,充分展现了其在实际业务场景中的卓越优势。

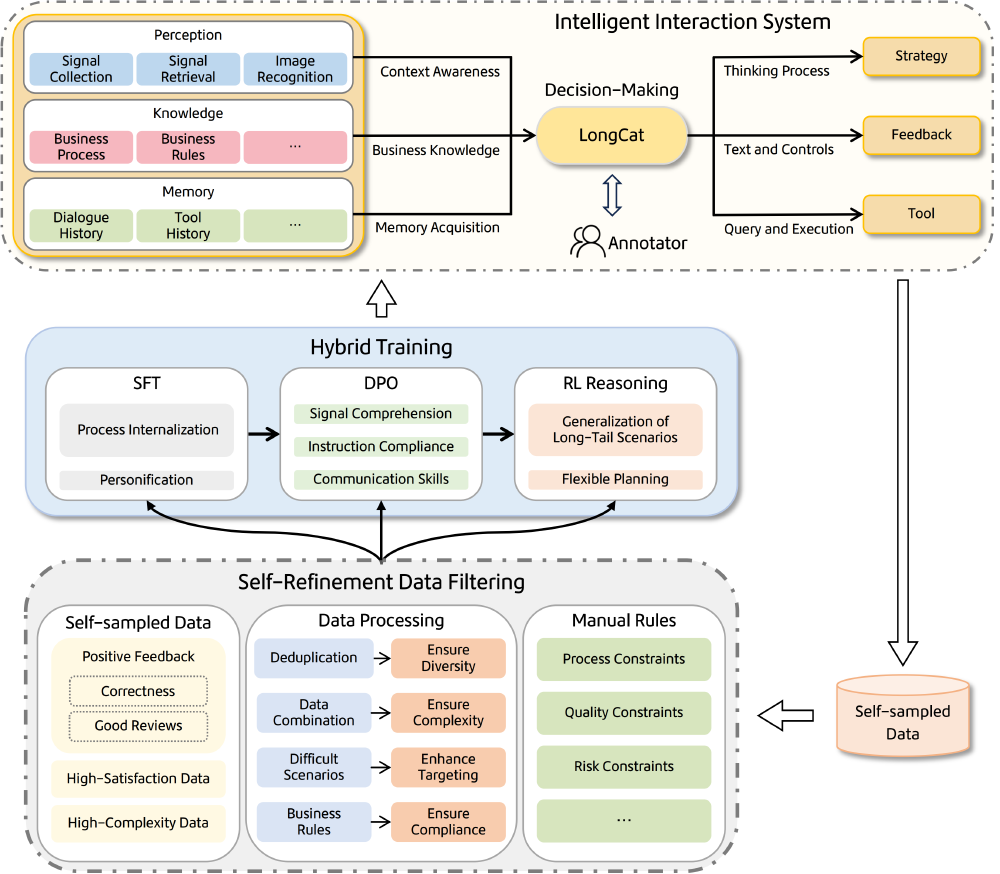

该图展示了以LongCat为核心决策单元的智能交互系统架构,融合感知、知识、记忆模块,通过混合训练与自优化数据过滤实现智能交互与系统进化。这一架构已成功应用于美团智能客服系统,并广泛覆盖内部数十个业务场景,为用户提供更智能、高效的服务体验。

总结与展望

LongCat-Flash-Chat的开源不仅展示了美团在AI领域的技术积累,更预示着智能体应用普及的加速到来。对于企业而言,现在正是布局AI智能体的关键窗口期——通过动态计算模型降低成本,同时构建行业专属工具链。

未来,随着技术的不断成熟,我们有理由相信,像LongCat这样兼顾效率与智能的模型,将在未来12-18个月内推动AI智能体在千行百业的规模化落地,真正实现从"能说会道"到"能做会干"的跨越。

开发者可重点关注:

- 基于LongCat的智能体应用开发,尤其是零售、本地生活等服务场景

- 模型优化技术,特别是MoE架构的高效推理方案

- 垂直领域数据集构建,提升模型在特定场景的表现

LongCat-Flash-Chat的发布,标志着AI行业正式进入动态计算时代,为构建高效、智能、普惠的人工智能应用开启了新的篇章。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/meituan-longcat/LongCat-Flash-Chat

项目地址: https://ai.gitcode.com/hf_mirrors/meituan-longcat/LongCat-Flash-Chat