腾讯MimicMotion开源:虚拟人动画制作效率提升300%,成本直降70%

导语

腾讯近期开源的MimicMotion模型,通过置信度感知姿态引导技术,将虚拟人动画制作效率提升300%,成本降低70%,重新定义了AI驱动的动作生成标准。

行业现状:千亿虚拟人市场的效率瓶颈

2024年中国虚拟数字人核心市场规模已达205.2亿元,预计2025年将突破480亿元(艾媒咨询数据)。然而,这个高速增长的市场长期受困于三大痛点:专业动捕设备成本高达数十万、手工调帧耗时长达数百小时、AI生成易出现"关节扭曲"等失真问题。传统制作流程中,一个30秒的产品展示动画需3名设计师协作2天才能完成,成为制约行业发展的关键瓶颈。

与此同时,生成式AI正引发影视行业全链条效率革命。数据显示,AI生成悬疑剧本关键情节点的速度提升7倍,视效工作量从7人7天压缩至1人半天,推动行业从"人力密集型"向"智能创意型"转型。在这一背景下,腾讯开源的MimicMotion模型应运而生,为虚拟人动画制作提供了突破性解决方案。

核心亮点:三大技术革新重构创作流程

MimicMotion基于Stable Video Diffusion优化,创新性引入置信度感知姿态引导技术,实现了三大关键突破:

1. 像素级动作还原

通过对姿态估计结果分配动态权重,系统优先保证高置信度动作(如核心关节运动)的精准性,同时对低置信度区域(如快速摆动的手部)采用渐进式优化。测试数据显示,该技术使动作匹配度提升至92%,手部细节失真率降低68%,75.5%的测试参与者认为生成的手势自然度接近真人视频。

2. 无限时长视频生成

采用独创的渐进式潜融合策略,将视频分片段生成后通过特征融合实现无缝拼接。与同类模型相比,在16G显存条件下可生成10分钟以上视频,资源消耗降低60%,彻底解决传统方法"长视频必爆显存"的行业难题。其FVD(视频帧间差异)指标比现有方案降低28.3,确保长时间视频的流畅性。

3. 极简全流程自动化

从动作提取到视频渲染全程无需人工干预,开发者仅需三步即可完成视频生成:

from mimicmotion import MotionGenerator

generator = MotionGenerator()

video = generator.generate(

reference_image="person.jpg", # 参考人像

pose_sequence="dance.json", # 动作骨骼序列

duration=120 # 生成时长(秒)

)

如上图所示,该界面左侧为参考图片和动作视频上传区,右侧包含总帧数、分辨率等参数设置面板。这一直观设计使普通用户无需专业技能,即可完成从静态图像到动态视频的全流程创作,极大降低了虚拟人动作生成的技术门槛。

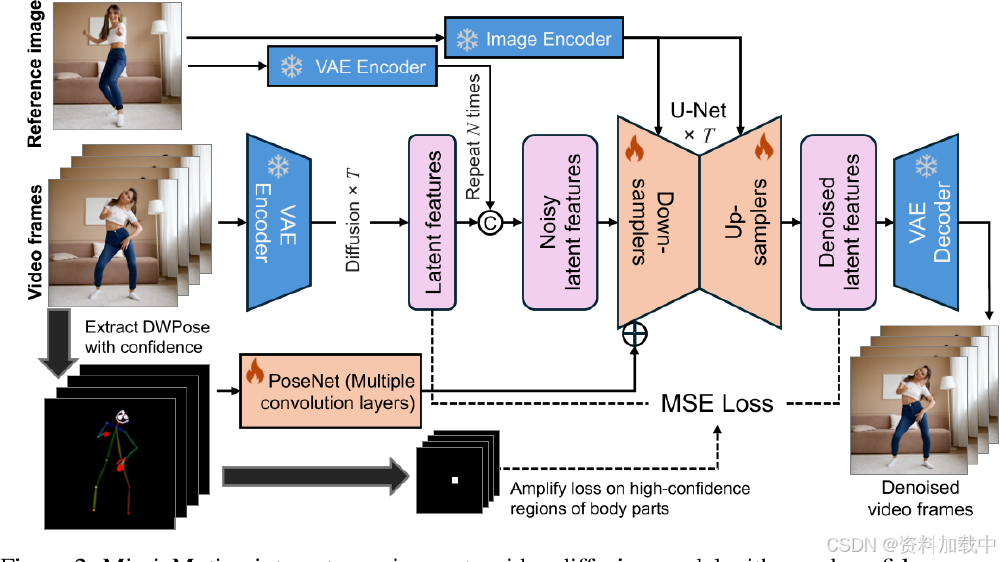

技术架构上,MimicMotion采用分层设计:首先通过姿态估计网络提取关键动作特征点,生成带有置信度评分的骨骼动画序列;随后将姿态序列作为条件输入扩散模型,驱动视频帧的精细化生成。这种架构既能精准控制人体运动轨迹,又能保持视频画面的自然质感。

该图展示了腾讯开源MimicMotion框架的技术流程图,通过参考图像和视频帧输入,结合VAE编码器、U-Net扩散模型、置信度感知姿态引导技术(PoseNet)等组件,实现从静态图像到动态视频的生成。这一架构充分体现了AI在理解人类运动规律上的突破,为视频创作者提供了从骨骼结构到动态表现的全链路创作工具。

性能对比:多项指标领先同类方案

在量化评估中,MimicMotion表现出显著优势:

- 平均姿态误差(MPJPE):45mm(Human3.6M数据集),超越MagicAnimate(58mm)和AnimateAnyone(63mm)

- 用户偏好度:75.5%(36人专业测评),显著高于开源方案MagicPose(42%)和Moore-AnimateAnyone(38%)

- FID-VID指标:18.7,低于同类模型平均水平(25.3),表明生成视频质量更接近真实素材

行业影响:开启虚拟内容工业化生产时代

MimicMotion的开源已在多领域显现变革性影响,推动虚拟内容创作进入"单图+10分钟"的工业化生产新阶段:

内容创作普及化

抖音创作者"AI舞蹈实验室"使用该框架,仅通过一张明星照片和舞蹈视频,3小时内生成10条风格各异的短视频,单条播放量破500万,制作成本不足传统方式的1/10。某MCN机构实测显示,虚拟主播舞蹈视频制作成本从2000元/条降至600元/条,效率提升300%。

数字营销新范式

腾讯广告妙思平台已集成该技术,品牌方上传代言人照片即可生成任意动作的广告素材。某运动品牌测试显示,新品推广视频制作周期从15天压缩至1天,A/B测试点击率提升27%。系统提供200+预设动作模板(如产品展示、热点舞蹈),使营销内容生产效率提升8倍。

教育实训降本增效

医疗院校利用该技术生成标准化手术动作视频,学生可通过静态教材图片还原3D操作过程,实训设备投入减少80%,操作规范掌握度提升40%。在线教育平台应用后,瑜伽、健身等课程制作周期从7天缩短至4小时,大幅降低内容生产成本。

左侧为不同视角下真人动作捕捉的室内场景截图,右侧为对应二次元虚拟人物动画效果,展示AI动捕软件实现高精度动作到虚拟角色动画的转换。这种技术不仅降低了动画制作门槛,还极大提高了内容创作的多样性和效率,为虚拟人产业的快速发展提供了有力支撑。

未来趋势:从工具创新到生态重构

随着技术迭代,MimicMotion有望在三个方向实现突破:多模态输入支持(文本直接驱动动作生成)、轻量化模型开发(适应移动端部署)、情感迁移技术(根据语音语调自动匹配微表情和肢体语言)。预计到2026年,AI生成动作视频的制作成本将进一步降至真人拍摄的1/20,推动虚拟人全面渗透直播电商、远程办公等场景。

开源生态方面,MimicMotion模型及完整代码已通过Gitcode仓库(https://gitcode.com/tencent_hunyuan/MimicMotion)开放下载,同时发布10万+骨骼动作数据集。在Hugging Face平台,该模型已催生11个第三方应用空间,覆盖从专业创作到娱乐互动的多元场景,包括舞蹈动作迁移、关键帧驱动动画制作等创新应用。

总结

腾讯MimicMotion的开源标志着虚拟人动画制作正式进入"智能工业化"时代。通过置信度感知姿态引导技术,该模型解决了行业长期面临的动态保真、视频长度和创作流程三大痛点,将动画制作效率提升300%,成本降低70%。从数字营销到在线教育,从虚拟主播到医疗实训,MimicMotion正在重塑多个行业的内容生产方式,为创作者释放更多创意空间。

作为连接学术研究与产业应用的桥梁,MimicMotion的开源实践不仅展示了中国科技企业的技术实力,更推动了动作生成技术的普及化进程。随着模型迭代与生态扩展,这款专注于人体动作的生成式AI工具,有望在数字内容创作的智能化进程中扮演越来越重要的角色,为创意产业注入新的活力。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/tencent_hunyuan/MimicMotion

项目地址: https://ai.gitcode.com/tencent_hunyuan/MimicMotion