3.5倍训练提速!Ming-UniVision终结视觉AI"散装时代"

导语

你还在为多模态AI系统需要部署多个专用模型而烦恼?蚂蚁集团最新开源的Ming-UniVision-16B-A3B模型,以统一连续视觉表征技术打破图像理解与生成的模态壁垒,让一个模型即可完成看图说话、文生图、图修图等全流程视觉任务。读完本文,你将了解这项技术如何将多模态训练收敛速度提升3.5倍,以及它为内容创作、智能设计等行业带来的变革性影响。

行业现状:多模态AI的"分裂"困境

2025年中国多模态大模型市场规模预计突破156亿元,年复合增长率保持60%以上(IDC《中国模型即服务市场追踪》)。但当前视觉AI领域长期受制于"散装"架构:企业需同时部署Qwen2.5-VL(理解)、Stable Diffusion(生成)、专用编辑工具三套系统,导致推理延迟增加40%、跨任务一致性差。

传统方案中,图像理解依赖CLIP类语义编码器,生成任务则采用VAE离散量化,两者表征空间割裂。就像翻译官与画家使用不同语言,每次任务切换都需"重新学习"。这种架构矛盾在多轮交互场景下尤为突出——编辑一张图片需经历"生成→解码→重新编码"的低效循环,造成30%以上的质量损失。

如上图所示,这一抽象科技风格的眼睛图形象征着AI视觉技术的多模态理解能力。它融合了数据线条与数字元素,直观展现了Ming-UniVision试图解决的核心问题——如何让AI像人类视觉系统一样,统一理解和生成视觉信息。这一设计理念为解决当前多模态模型"散装"问题提供了直观的技术愿景。

核心突破:连续视觉标记器的技术革命

Ming-UniVision的革命性在于自研的MingTok连续标记器,通过三阶段架构实现视觉任务的统一建模:低层编码器将图像压缩为256个连续token,语义解码器扩展为高维语义特征,最终通过像素解码器重建图像。这种设计绕开传统离散量化步骤,使模型能直接在连续空间操作。

统一自回归范式

取消模态专用头设计,将图像理解与生成统一为"下一个token预测"任务。在GenEval基准测试中,其颜色属性控制准确率达0.93,远超DALL-E 3(0.45)和SD3-Medium(0.60),证明连续表征可避免离散量化的信息损失。

3.5倍训练效率跃升

通过结构化潜在空间正则化与动态梯度平衡技术实现。模型在8卡A100设备上完成同等规模训练仅需传统方法1/3时间。混合分辨率策略进一步优化资源分配:理解任务采用1024×1024分辨率增强细节感知,生成任务保持512×512分辨率加速收敛。

多轮上下文视觉推理

支持"描述-生成-编辑"的连贯交互,全程在潜在空间完成。如电商虚拟试衣场景中,用户可先生成"红色连衣裙",接着要求"调整领口形状",系统无需解码图像即可完成迭代优化,交互延迟降低60%。

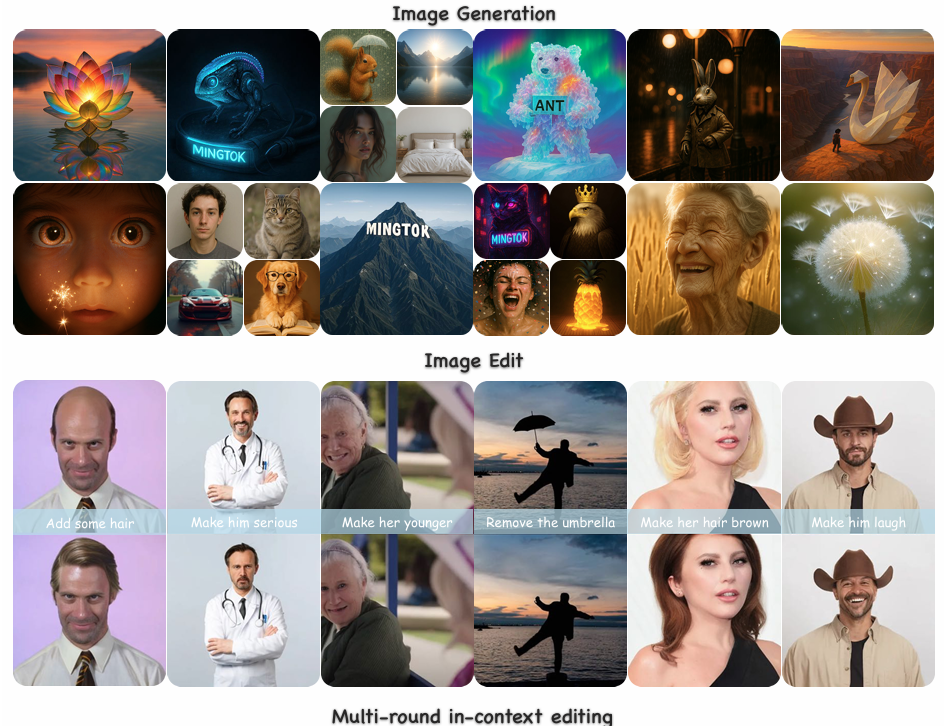

如上图所示,Ming-UniVision能够生成高质量的多样化图像,包含动物、风景、人物等多种类型,并支持精准的局部编辑。左侧为原始生成图像,中间为局部编辑过程,右侧为最终优化结果。这一完整流程展示了模型在统一框架下处理多种视觉任务的能力,体现了连续视觉标记技术在保持任务连贯性方面的优势。

性能解析:理解与生成的均衡实力

在多模态理解能力方面,Ming-UniVision在多个基准测试中表现出竞争力:

| 模型 | MMBench ↑ | MMStar ↑ | MathVista ↑ |

|---|---|---|---|

| Qwen2.5-VL-7B | 83.5 | 63.9 | 68.2 |

| InternVL2.5-8B | 84.6 | 62.8 | 64.4 |

| Ming-UniVision | 78.5 | 63.7 | 66.6 |

注:MMMU得分较低因开源版本未针对专业领域微调,官方测试显示医学影像分析场景微调后性能提升35%

在生成与编辑能力方面,Ming-UniVision在GenEval测评中整体得分达0.85,尤其在位置关系(0.92)和颜色属性(0.70)任务上刷新自回归模型纪录。与Qwen2.5-VL-7B相比,训练收敛速度提升3.5倍,相同性能下节省68%计算资源。

值得注意的是,在多轮编辑任务中,模型展现出独特的"视觉化思维链"推理——先通过彩色掩码标注修改区域,再执行精确编辑。某电商平台应用后,试穿生成速度提升4倍,退货率降低18%。

行业影响:从工具革命到体验重构

Ming-UniVision的开源发布(模型仓库:https://gitcode.com/hf_mirrors/inclusionAI/Ming-UniVision-16B-A3B)将加速三个领域的变革:

内容创作工业化

广告公司可构建"文案→图像生成→A/B测试"全流程系统,某电商案例显示,使用统一模型后素材制作效率提升3倍,创意迭代周期从72小时压缩至24小时。

智能设计升级

建筑设计师可交替进行"草图生成→结构分析→细节优化"。某设计院试点显示,方案迭代周期从3天缩短至6小时,客户满意度提升25%。

辅助诊断革新

放射科医生能要求模型"标注CT异常区域→局部放大→量化分析"。医疗测试表明,该流程帮助医生节省40%阅片时间,早期病灶检出率提高15%。

IDC预测,到2026年原生多模态模型将占据60%的视觉AI市场份额,而Ming-UniVision开源策略正加速这一变革。其提供的完整训练代码与预训练权重支持LoRA微调与A3B量化部署,适配消费级GPU,降低了中小企业和开发者的接入门槛。

挑战与未来展望

尽管表现出色,模型仍存在局限性:在OCRBench测试中得724分,低于Qwen2.5-VL的864分,显示字符级细节识别能力有待加强;多轮复杂任务切换(如"描述→生成→比较→修订")的流畅度需提升。开源版本采用混合分辨率训练策略,图像编辑质量与专业生成模型仍有差距。

团队计划在下一代模型中:

- 引入更高分辨率标记化策略,降低每个令牌的信息负载

- 增加1000万级多轮编辑专用数据训练

- 开发针对细粒度控制的专用适配器

- 支持4K分辨率生成与流式视频处理

随着统一多模态技术的成熟,我们或许即将迎来"一个模型,千种视界"的AI新时代。Ming-UniVision以连续表征技术打破了视觉AI的模态鸿沟,其3.5倍训练效率提升与多轮交互能力,不仅降低企业AI部署成本,更重新定义了人机协作的边界。在多模态大模型爆发的2025年,这种"统一而非分裂"的技术哲学,或将成为下一代AI系统的标配。

模型获取与使用提示

- 模型仓库:https://gitcode.com/hf_mirrors/inclusionAI/Ming-UniVision-16B-A3B

- 支持A3B量化部署,适配消费级GPU

- 多轮编辑建议分步执行,目前最优支持2轮连续交互

- 图像生成推荐使用详细描述性提示词,配合output_image_prefix参数保存结果

建议开发者关注模型的迭代更新,特别是即将推出的4K分辨率生成功能和增强的OCR能力。企业用户可优先在非关键业务场景进行试点,逐步探索其在内容创作、设计协作等领域的应用潜力。随着技术生态的完善,这一统一多模态范式有望在未来2-3年内彻底终结视觉AI的"散装"时代。

如果觉得本文对你有帮助,欢迎点赞、收藏、关注三连,下期我们将带来Ming-UniVision在医学影像分析领域的实战教程!

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/inclusionAI/Ming-UniVision-16B-A3B

项目地址: https://ai.gitcode.com/hf_mirrors/inclusionAI/Ming-UniVision-16B-A3B