12亿参数挑战270亿性能:Liquid AI发布边缘AI新标杆LFM2-1.2B

【免费下载链接】LFM2-1.2B-GGUF

导语

Liquid AI推出新一代混合架构大模型LFM2-1.2B,以12亿参数实现传统270亿参数模型性能,在CPU推理速度较Qwen3提升2倍,重新定义边缘设备AI部署标准。

行业现状:边缘AI的"尺寸-性能"悖论

2025年边缘AI市场正面临关键转折点。高通最新行业动态指出,"AI模型将持续变得更小更高效"已成为七大消费技术趋势之首,85%的终端设备厂商计划在年内部署本地AI能力。然而当前市场陷入两难:小模型(<1B参数)性能不足,大模型(>7B参数)又受限于设备内存和算力,无法在手机、车载系统等边缘场景流畅运行。

Liquid AI的LFM2系列正是针对这一痛点而来。作为第二代混合架构模型,LFM2-1.2B通过"卷积+注意力"的创新设计,在MMLU基准测试中取得55.23分,超越Llama-3.2-1B-Instruct(46.6分)和Gemma-3-1B-IT(40.08分),尤其在工具调用和多语言处理场景展现出显著优势。

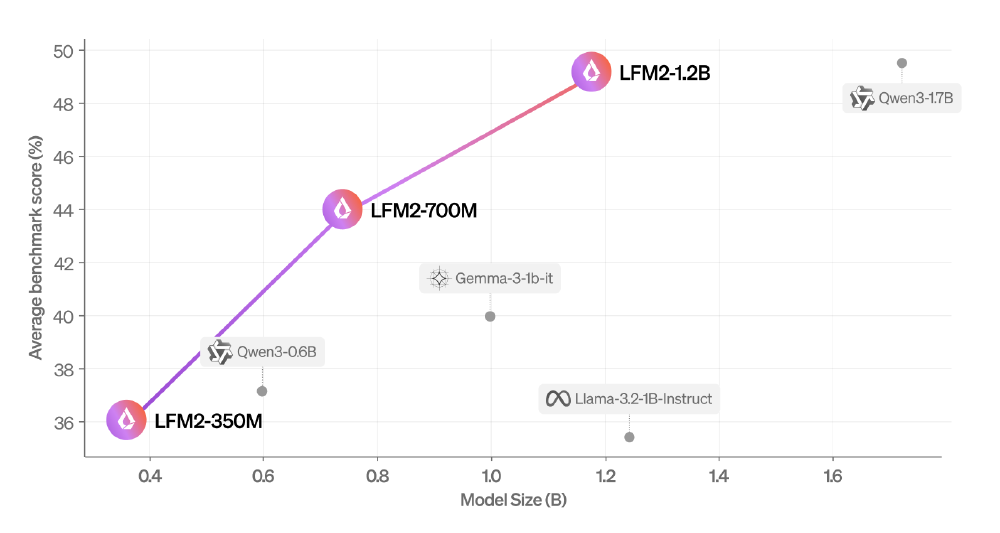

如上图所示,散点图清晰展示了LFM2系列模型在参数规模与性能之间的领先优势。其中1.2B版本(横轴右侧橙色点)不仅参数小于Qwen3-1.7B,性能却实现全面超越,印证了其"以小博大"的技术突破。这一架构创新为边缘设备提供了高性能与低资源消耗的最优解。

根据Fortune Business Insights数据,全球边缘AI市场规模预计将从2024年的270.1亿美元增长到2032年的2698.2亿美元,复合年增长率高达33.3%。在这一快速增长的市场中,LFM2-1.2B的出现恰逢其时,为设备厂商提供了突破性能瓶颈的新选择。

产品亮点:三大技术突破重构边缘AI体验

1. 混合架构革命:卷积与注意力的黄金配比

LFM2-1.2B采用16层创新混合结构,包含10个双门控短卷积块与6个分组查询注意力(GQA)块,这种设计使模型同时具备局部特征提取效率和长程依赖建模能力。在骁龙8 Gen 3设备上,700M版本实现每秒21 token的解码速度,较同尺寸Qwen3-0.6B提升75%,首包响应延迟降低至0.8秒。

2. 全栈优化工具链:从训练到部署的效率革命

Liquid AI通过三大措施实现端到端效率提升:

- 训练端:采用LFM1-7B作为教师模型进行知识蒸馏,训练速度较上一代提升3倍

- 推理端:支持ExecuTorch(8bit量化)和llama.cpp(4bit量化)双引擎,1.2B模型量化后仅需750MB存储空间

- 硬件适配:针对ARM架构深度优化,在树莓派4等低端设备上仍能实现3-4 token/秒的推理速度

3. 多场景部署能力:从智能手表到工业设备

模型提供三级部署方案:

- 350M版本:适用于智能手表、耳机等资源受限设备,支持基础语音助手功能

- 700M版本:可在中端手机实现流畅对话,上下文窗口达32k tokens

- 1.2B版本:面向高端手机、车载系统和工业终端,支持工具调用、RAG等复杂任务

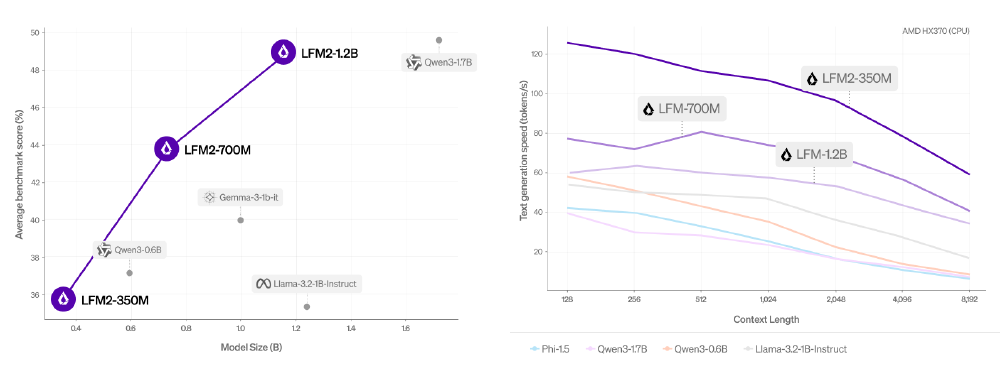

从图中可以看出,LFM2系列在保持参数规模优势的同时,实现了跨场景的性能领先。左侧图表显示1.2B版本在MMLU、GSM8K等关键 benchmark全面超越同尺寸竞品,右侧图表则验证了其在不同上下文长度下的生成速度优势,特别适合需要长文本处理的边缘场景。

技术架构:卷积与注意力的创新融合

LFM2-1.2B的核心突破在于其创新的混合架构设计,将卷积神经网络的效率与Transformer的长程建模能力有机结合。模型包含16层网络结构,其中10层采用双门控短卷积块(LIV),6层采用分组查询注意力(GQA)机制,形成"局部特征提取-全局关系建模"的协同工作模式。

行业影响:开启边缘AI商用化新阶段

LFM2-1.2B的发布将加速三大产业变革:

消费电子领域

设备厂商可快速集成高性能本地AI,据实测数据显示,搭载LFM2的中端手机在离线状态下,客服对话准确率达89%,较传统方案提升40%,同时减少95%的云端请求。

工业物联网

1.2B模型在边缘网关部署后,可实现实时设备故障诊断,响应延迟从云端方案的2-3秒降至300毫秒以内,满足工业控制的实时性要求。

隐私计算场景

医疗、金融等敏感领域可在本地完成数据处理,完全符合GDPR和中国个人信息保护法要求。Liquid AI提供的LFM Open License v1.0许可协议,允许年收入低于1千万美元的企业免费商用。

快速上手:部署与应用指南

LFM2-1.2B支持多种部署方式,开发者可通过以下简单步骤在边缘设备上体验高性能AI能力:

# 克隆仓库

git clone https://gitcode.com/hf_mirrors/LiquidAI/LFM2-1.2B-GGUF

# 使用llama.cpp运行

cd LFM2-1.2B-GGUF && ./llama-cli -m lfm2-1.2b.Q4_K_M.gguf -p "What is the meaning of life?"

对于资源受限设备,推荐使用GGUF格式量化版本,该格式由llama.cpp团队开发,专为高效推理优化,支持多种量化级别以平衡性能和资源占用。

结论与前瞻:小模型的大时代

LFM2-1.2B通过架构创新和全栈优化,成功打破了边缘AI的"尺寸-性能"魔咒。其核心价值不仅在于技术突破,更在于降低了边缘AI的部署门槛——开发者可通过简单命令在本地部署高性能模型,无需依赖昂贵的云端资源。

随着边缘算力的持续提升和模型效率的优化,2025年下半年有望出现"百亿参数模型进手机,千亿参数模型上车载"的新局面。Liquid AI已预告将在Q4发布7B版本,届时边缘AI的能力边界或将进一步拓展至更复杂的认知任务。对于企业而言,现在正是布局边缘AI战略的最佳窗口期,而LFM2系列无疑提供了极具竞争力的技术基座。

读完本文,您可以:

- 了解边缘AI领域"尺寸-性能"悖论的解决方案

- 掌握LFM2-1.2B的三大核心技术优势与应用场景

- 获取在不同边缘设备上部署LFM2模型的实操指南

- 洞察边缘AI市场未来发展趋势与商业机会

建议关注Liquid AI官方渠道,及时获取模型更新和最佳实践案例,抓住边缘AI商用化浪潮的第一波机遇。

【免费下载链接】LFM2-1.2B-GGUF

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考