阿里云Wan 2.2多模态模型震撼发布:MoE架构引领AIGC视频创作新范式

【免费下载链接】Wan2.2-T2V-A14B

阿里云近日正式推出新一代多模态生成模型——通义万相2.2(Wan 2.2),凭借创新技术架构与强大功能,重新定义AI视频生成的质量标准与应用边界。该模型突破性采用混合专家(Mixture of Experts, MoE)架构,通过动态调配高噪专家模型与低噪专家模型,依据去噪过程的时间步智能分配计算资源,实现视频生成质量与效率的双重跃升。

作为当前AIGC领域的标杆产品,Wan 2.2构建起三大核心技术壁垒。其影视级美学控制系统深度整合电影工业的视觉标准体系,支持从光影层次感、色彩调性到构图法则的全方位精细化调控,使AI生成内容具备专业级视觉表现力;在动态效果处理方面,模型通过强化运动轨迹预测与帧间一致性优化,可精准还原复杂物理运动场景,显著提升视频流畅度与动作可控性;而精准语义遵循技术则解决了多对象交互场景下的逻辑一致性难题,确保生成内容与用户创意意图高度吻合。

针对多样化创作需求,Wan 2.2提供文生视频、图生视频等全链路生成能力,已广泛应用于广告创意、数字艺术、在线教育等领域。值得关注的是,该系列模型基于Apache 2.0开源协议开放商业使用权限,其中文生视频专项模型Wan2.2-T2V-A14B凭借140亿参数量的深度优化,成为当前文本驱动视频生成领域的性能标杆。

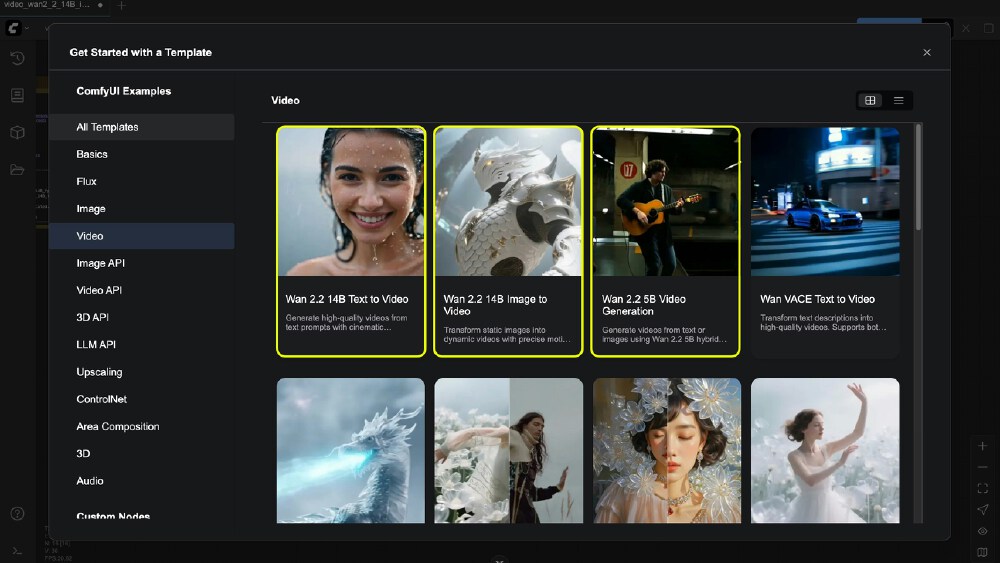

如上图所示,该界面直观呈现了Wan2.2-T2V-A14B模型在ComfyUI中的工作流配置方案。这一可视化操作界面降低了专业模型的使用门槛,帮助创作者快速掌握高质量视频的生成技巧,为实现创意落地提供了直观的技术路径。

如上图所示,该界面直观呈现了Wan2.2-T2V-A14B模型在ComfyUI中的工作流配置方案。这一可视化操作界面降低了专业模型的使用门槛,帮助创作者快速掌握高质量视频的生成技巧,为实现创意落地提供了直观的技术路径。

开发者可通过GitCode仓库获取完整模型资源(仓库地址:https://gitcode.com/hf_mirrors/Wan-AI/Wan2.2-T2V-A14B)。在实际部署时,需在ComfyUI环境中完成高噪/低噪双专家模型的协同加载,并配套相应的文本编码器与VAE模型组件。通过简单配置视频尺寸、帧数参数及创意提示词,即可启动专业化视频生成流程。随着开源生态的持续完善,Wan 2.2有望推动AI视频创作从专业领域向大众化应用加速渗透,为数字内容产业注入全新发展动能。

【免费下载链接】Wan2.2-T2V-A14B

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考