Qwen3-30B-A3B-Instruct-2507-FP8:新一代大语言模型性能突破与技术解析

核心升级亮点

我们正式发布Qwen3-30B-A3B-FP8非思考模式的升级版模型——Qwen3-30B-A3B-Instruct-2507-FP8,该版本在原有基础上实现了多维度能力跃升,主要增强特性包括:

- 通用能力全面强化:在指令遵循、逻辑推理、文本理解、数学运算、科学分析、代码生成及工具调用等核心任务上取得显著进步

- 跨语言长尾知识覆盖拓展:大幅提升多语种场景下的专业知识储备与应用精度

- 主观任务对齐度优化:在开放式对话与创意生成任务中更精准捕捉用户偏好,输出内容质量与实用性双提升

- 超长上下文理解突破:原生支持256K上下文窗口,实现更深度的长文本处理与复杂任务建模

模型架构解析

本仓库提供的Qwen3-30B-A3B-Instruct-2507-FP8是基于FP8量化技术的高效版本,具备以下核心架构参数:

- 模型类型:因果语言模型(Causal Language Models)

- 训练阶段:预训练与指令微调双阶段优化

- 参数规模:总计305亿参数,激活参数33亿

- 非嵌入层参数:299亿

- 网络层数:48层

- 注意力机制:GQA架构(查询头32个,键值头4个)

- 专家系统:128个专家单元,每次激活8个

- 上下文长度:原生支持262,144 tokens

重要说明:该模型仅支持非思考模式,输出内容不会包含</think>superscript:标记块。同时,用户无需额外设置enable_thinking=False参数即可正常使用。

关于模型的基准测试结果、硬件配置要求及推理性能数据等详细信息,可参考官方博客、代码仓库及技术文档获取全面解析。

如上图所示,该图片展示了Qwen3-30B-A3B-Instruct-2507模型的技术架构示意图。这一可视化呈现直观展示了模型的层级结构与核心组件关系,为开发者理解模型工作原理提供了清晰的技术参考。

如上图所示,该图片展示了Qwen3-30B-A3B-Instruct-2507模型的技术架构示意图。这一可视化呈现直观展示了模型的层级结构与核心组件关系,为开发者理解模型工作原理提供了清晰的技术参考。

多维度性能评测

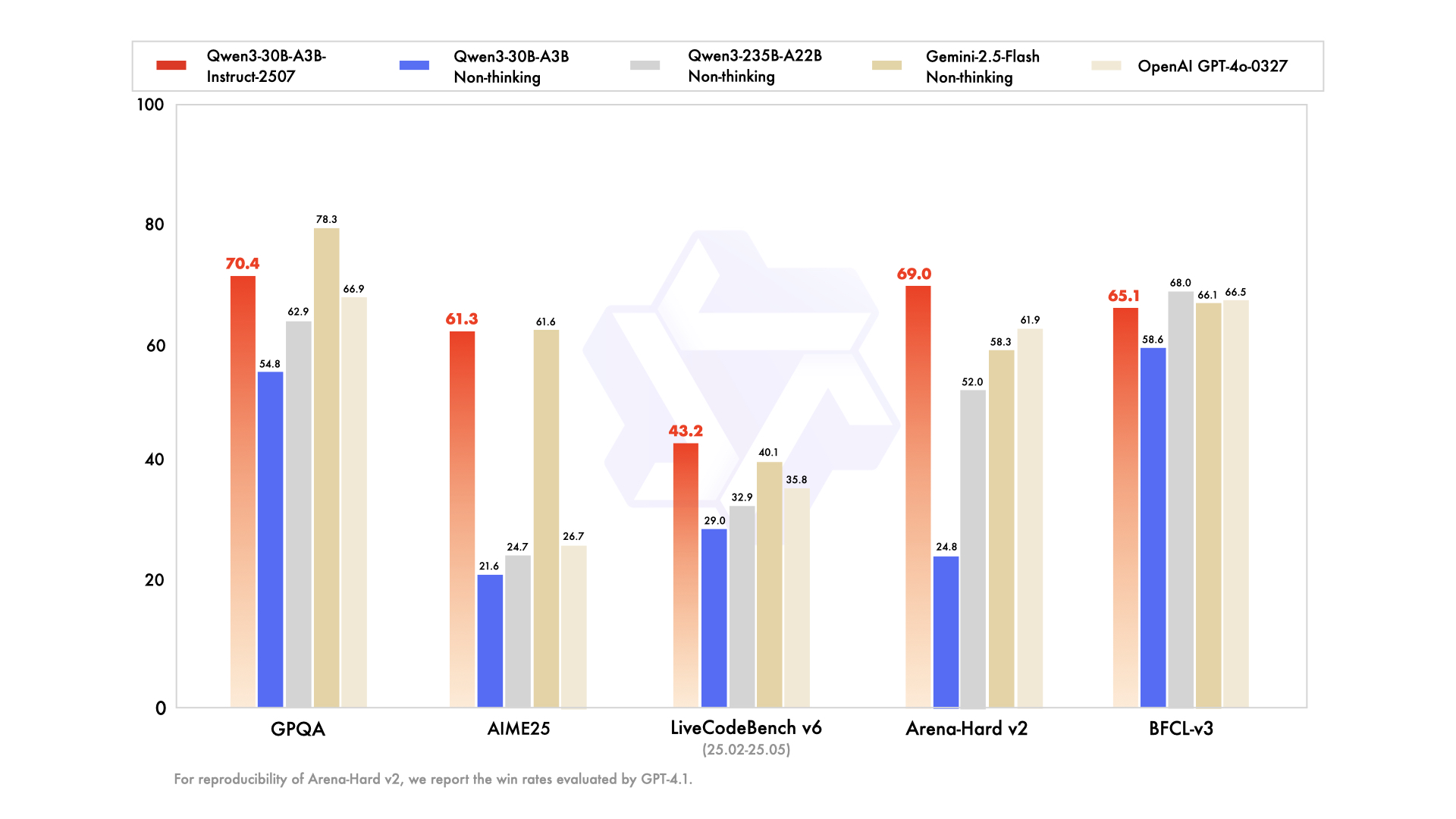

通过在标准基准测试集上的全面评估,Qwen3-30B-A3B-Instruct-2507展现出强劲的综合性能,以下是与主流模型的对比结果:

| 评估维度 | Deepseek-V3-0324 | GPT-4o-0327 | Gemini-2.5-Flash Non-Thinking | Qwen3-235B-A22B Non-Thinking | Qwen3-30B-A3B Non-Thinking | Qwen3-30B-A3B-Instruct-2507 |

|---|---|---|---|---|---|---|

| 知识掌握能力 | ||||||

| MMLU-Pro | 81.2 | 79.8 | 81.1 | 75.2 | 69.1 | 78.4 |

| MMLU-Redux | 90.4 | 91.3 | 90.6 | 89.2 | 84.1 | 89.3 |

| GPQA | 68.4 | 66.9 | 78.3 | 62.9 | 54.8 | 70.4 |

| SuperGPQA | 57.3 | 51.0 | 54.6 | 48.2 | 42.2 | 53.4 |

| 逻辑推理能力 | ||||||

| AIME25 | 46.6 | 26.7 | 61.6 | 24.7 | 21.6 | 61.3 |

| HMMT25 | 27.5 | 7.9 | 45.8 | 10.0 | 12.0 | 43.0 |

| ZebraLogic | 83.4 | 52.6 | 57.9 | 37.7 | 33.2 | 90.0 |

| LiveBench 20241125 | 66.9 | 63.7 | 69.1 | 62.5 | 59.4 | 69.0 |

| 代码生成能力 | ||||||

| LiveCodeBench v6 (25.02-25.05) | 45.2 | 35.8 | 40.1 | 32.9 | 29.0 | 43.2 |

| MultiPL-E | 82.2 | 82.7 | 77.7 | 79.3 | 74.6 | 83.8 |

| Aider-Polyglot | 55.1 | 45.3 | 44.0 | 59.6 | 24.4 | 35.6 |

| 对齐能力 | ||||||

| IFEval | 82.3 | 83.9 | 84.3 | 83.2 | 83.7 | 84.7 |

| Arena-Hard v2* | 45.6 | 61.9 | 58.3 | 52.0 | 24.8 | 69.0 |

| Creative Writing v3 | 81.6 | 84.9 | 84.6 | 80.4 | 68.1 | 86.0 |

| WritingBench | 74.5 | 75.5 | 80.5 | 77.0 | 72.2 | 85.5 |

| 智能体能力 | ||||||

| BFCL-v3 | 64.7 | 66.5 | 66.1 | 68.0 | 58.6 | 65.1 |

| TAU1-Retail | 49.6 | 60.3# | 65.2 | 65.2 | 38.3 | 59.1 |

| TAU1-Airline | 32.0 | 42.8# | 48.0 | 32.0 | 18.0 | 40.0 |

| TAU2-Retail | 71.1 | 66.7# | 64.3 | 64.9 | 31.6 | 57.0 |

| TAU2-Airline | 36.0 | 42.0# | 42.5 | 36.0 | 18.0 | 38.0 |

| TAU2-Telecom | 34.0 | 29.8# | 16.9 | 24.6 | 18.4 | 12.3 |

| 多语言能力 | ||||||

| MultiIF | 66.5 | 70.4 | 69.4 | 70.2 | 70.8 | 67.9 |

| MMLU-ProX | 75.8 | 76.2 | 78.3 | 73.2 | 65.1 | 72.0 |

| INCLUDE | 80.1 | 82.1 | 83.8 | 75.6 | 67.8 | 71.9 |

| PolyMATH | 32.2 | 25.5 | 41.9 | 27.0 | 23.3 | 43.1 |

*注:为确保结果可复现,所有胜率数据均由GPT-4.1进行评估。

#注:由于无法访问GPT-4o-0327原生函数调用API,相关结果使用GPT-4o-20241120版本生成。

快速上手指南

Qwen3-MoE系列模型代码已集成至最新版Hugging Face transformers库,建议使用最新版本以获得最佳体验。使用transformers<4.51.0版本可能会出现以下错误:

KeyError: 'qwen3_moe'

以下代码片段展示了如何使用模型进行文本生成:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-30B-A3B-Instruct-2507-FP8"

# 加载分词器与模型

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# 准备输入内容

prompt = "请简要介绍什么是大型语言模型。"

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

# 生成文本

generated_ids = model.generate(

**model_inputs,

max_new_tokens=16384

)

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

content = tokenizer.decode(output_ids, skip_special_tokens=True)

print("生成结果:", content)

对于服务部署,可使用sglang>=0.4.6.post1或vllm>=0.8.5构建兼容OpenAI API的服务端点:

- SGLang部署:

python -m sglang.launch_server --model-path Qwen/Qwen3-30B-A3B-Instruct-2507-FP8 --context-length 262144 - vLLM部署:

vllm serve Qwen/Qwen3-30B-A3B-Instruct-2507-FP8 --max-model-len 262144

内存优化提示:如遇内存不足(OOM)问题,可尝试将上下文长度调整为较小值(如32,768)。

在本地应用场景中,Ollama、LMStudio、MLX-LM、llama.cpp及KTransformers等工具均已支持Qwen3系列模型的运行。

FP8量化技术优势

为平衡性能与效率,我们特别提供FP8量化版本(模型名称以-FP8结尾),采用块大小为128的细粒度量化方案。量化配置细节可参考config.json中的quantization_config字段。

该量化版本可直接兼容主流推理框架,包括transformers、sglang和vllm,使用体验与原生bfloat16模型一致,同时显著降低硬件资源需求。

智能体应用指南

Qwen3系列在工具调用领域表现卓越,推荐使用Qwen-Agent框架充分发挥其智能体能力。该框架内置工具调用模板与解析器,大幅降低开发复杂度。

工具定义支持三种方式:MCP配置文件导入、框架内置工具集成或自定义工具开发。以下是基本使用示例:

from qwen_agent.agents import Assistant

# 配置语言模型

llm_cfg = {

'model': 'Qwen3-30B-A3B-Instruct-2507-FP8',

# 使用兼容OpenAI API的自定义端点:

'model_server': 'http://localhost:8000/v1', # API基础地址

'api_key': 'EMPTY',

}

# 定义工具集

tools = [

{'mcpServers': { # 可指定MCP配置文件

'time': {

'command': 'uvx',

'args': ['mcp-server-time', '--local-timezone=Asia/Shanghai']

},

"fetch": {

"command": "uvx",

"args": ["mcp-server-fetch"]

}

}

},

'code_interpreter', # 内置代码解释器工具

]

# 创建智能体实例

bot = Assistant(llm=llm_cfg, function_list=tools)

# 流式生成示例

messages = [{'role': 'user', 'content': 'https://qwenlm.github.io/blog/ 请介绍Qwen的最新发展动态'}]

for responses in bot.run(messages=messages):

pass

print(responses)

最佳实践指南

为充分发挥模型性能,建议采用以下优化配置:

-

采样参数设置:

- 推荐配置:

Temperature=0.7,TopP=0.8,TopK=20,MinP=0 - 在支持的框架中,可将

presence_penalty参数设置在0-2之间以减少重复生成,但较高值可能导致偶尔的语言混合现象及轻微性能下降

- 推荐配置:

-

输出长度配置:对于大多数指令任务,建议设置16,384 tokens的输出长度,足以满足复杂指令需求

-

输出格式标准化:在基准测试场景中,建议通过提示词规范输出格式:

- 数学问题:添加"请分步推理,并将最终答案放在\boxed{}中。"

- 选择题:要求使用JSON结构输出,如"请将答案以

"answer": "选项字母"格式呈现。"

技术发展前瞻

Qwen3-30B-A3B-Instruct-2507-FP8的发布标志着高效能大语言模型在产业落地方面的重要进展。通过MoE架构与FP8量化技术的深度融合,该模型在保持300亿级参数性能优势的同时,显著降低了部署门槛。

未来发展将聚焦三个方向:进一步拓展多模态能力边界、优化超长上下文理解的效率、构建更完善的工具生态系统。这些改进将使Qwen3系列在企业级知识库构建、智能客服、代码辅助开发等场景中发挥更大价值,推动大语言模型技术从实验室走向更广泛的产业应用。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-30B-A3B-Instruct-2507-FP8

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-30B-A3B-Instruct-2507-FP8