Apache Doris与Kafka实时接入:流数据处理最佳实践

你是否还在为实时数据接入延迟高、可靠性差而烦恼?Apache Doris作为一款高性能的分析型数据库,提供了与Kafka的无缝集成方案,能够轻松应对流数据处理场景。本文将详细介绍Apache Doris与Kafka的实时接入方案,帮助你快速掌握流数据处理的最佳实践。

读完本文后,你将能够:

- 了解Apache Doris与Kafka集成的架构原理

- 掌握Routine Load实现Kafka数据接入的方法

- 学会配置Kafka数据导入任务的关键参数

- 解决常见的Kafka数据接入问题

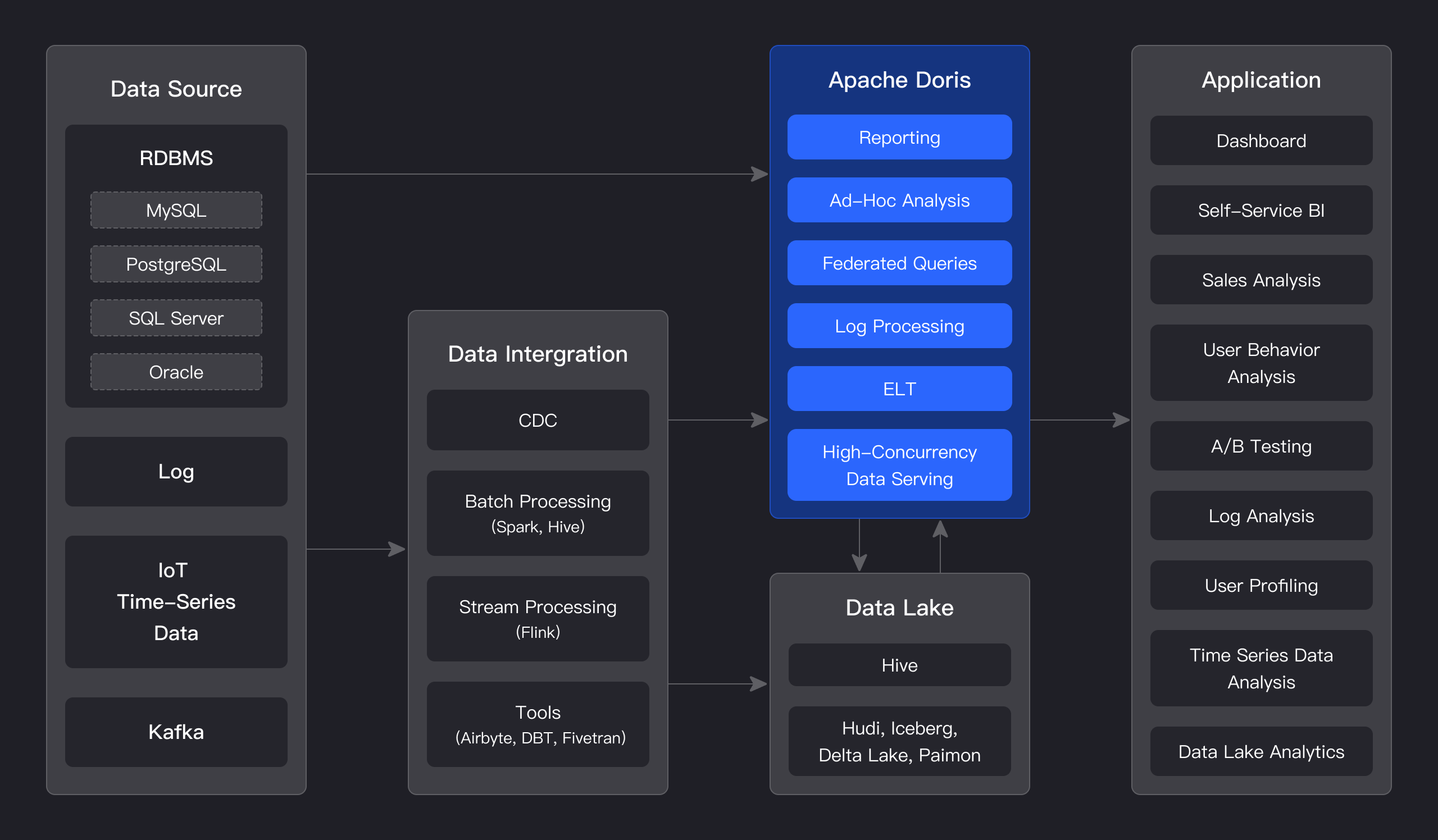

集成架构概述

Apache Doris通过Routine Load(例行导入)功能实现与Kafka的实时数据接入。Routine Load是一种异步、持续的数据导入方式,能够定期从Kafka主题中拉取数据并导入到Doris表中。

如上图所示,Kafka中的流数据通过Routine Load机制导入到Apache Doris中,Doris的Frontend(FE)负责任务调度和元数据管理,Backend(BE)负责实际的数据存储和查询执行。这种架构保证了数据导入的高吞吐量和低延迟。

相关实现代码可以参考:be/src/runtime/routine_load/data_consumer.cpp

快速开始:Kafka数据导入实战

环境准备

在开始之前,请确保你已经:

- 部署了Apache Doris集群

- 部署了Kafka集群

- 创建了需要导入数据的Doris表

创建目标表

首先在Doris中创建一个用于接收Kafka数据的表:

CREATE TABLE user_behavior (

user_id BIGINT,

item_id BIGINT,

category_id BIGINT,

behavior STRING,

ts DATETIME

)

DUPLICATE KEY(user_id, item_id)

DISTRIBUTED BY HASH(user_id) BUCKETS 10

PROPERTIES (

"replication_num" = "3"

);

创建Routine Load任务

使用以下SQL命令创建一个从Kafka导入数据的Routine Load任务:

CREATE ROUTINE LOAD doris_test.user_behavior_loader ON user_behavior

COLUMNS TERMINATED BY '\t'

COLUMNS (user_id, item_id, category_id, behavior, ts)

PROPERTIES

(

"desired_concurrent_number" = "3",

"max_batch_interval" = "20",

"max_batch_rows" = "300000",

"max_batch_size" = "209715200",

"strict_mode" = "false"

)

FROM KAFKA

(

"kafka_broker_list" = "kafka-1:9092,kafka-2:9092,kafka-3:9092",

"kafka_topic" = "user_behavior",

"kafka_partitions" = "0,1,2",

"kafka_offsets" = "OFFSET_BEGINNING"

);

关键参数配置详解

Routine Load任务有多个关键参数需要根据实际场景进行优化配置,以下是一些重要参数的说明:

| 参数 | 说明 | 默认值 | 建议值 |

|---|---|---|---|

| desired_concurrent_number | 导入并发度 | 3 | 根据Kafka分区数调整 |

| max_batch_interval | 最大批处理间隔(秒) | 30 | 5-20 |

| max_batch_rows | 每批最大行数 | 500000 | 100000-500000 |

| max_batch_size | 每批最大大小(字节) | 104857600 | 104857600-209715200 |

| strict_mode | 是否开启严格模式 | false | 生产环境建议true |

详细的参数说明可以参考官方文档:docs/devel.txt

数据导入监控与管理

查看任务状态

创建Routine Load任务后,可以通过以下命令查看任务状态:

SHOW ALL ROUTINE LOAD;

查看任务详情

SHOW ROUTINE LOAD FOR user_behavior_loader;

暂停和恢复任务

-- 暂停任务

PAUSE ROUTINE LOAD FOR user_behavior_loader;

-- 恢复任务

RESUME ROUTINE LOAD FOR user_behavior_loader;

停止任务

STOP ROUTINE LOAD FOR user_behavior_loader;

高级特性与优化

数据转换与过滤

Routine Load支持在数据导入过程中进行简单的数据转换和过滤:

CREATE ROUTINE LOAD doris_test.user_behavior_loader ON user_behavior

COLUMNS TERMINATED BY '\t'

COLUMNS (user_id, item_id, category_id, behavior, ts,

dt = date_trunc('day', ts),

hour = hour(ts)

)

WHERE behavior IN ('click', 'purchase')

PROPERTIES (

"desired_concurrent_number" = "3"

)

FROM KAFKA

(

"kafka_broker_list" = "kafka-1:9092",

"kafka_topic" = "user_behavior"

);

Exactly-Once语义保证

Apache Doris通过事务机制和Kafka的offset管理实现了Exactly-Once的数据导入语义。相关实现可以参考:be/src/runtime/routine_load/data_consumer.cpp

性能优化建议

- 合理设置批处理大小:根据Kafka消息大小和Doris集群性能调整

max_batch_rows和max_batch_size - 调整并发度:

desired_concurrent_number建议设置为Kafka分区数的1/3到1/2 - 使用适当的存储模型:对于实时分析场景,建议使用Aggregate Key模型

- 定期清理历史数据:设置表的TTL属性自动清理过期数据

常见问题与解决方案

问题1:数据导入延迟高

可能原因:

- 批处理间隔设置过大

- 并发度不足

- Doris集群负载过高

解决方案:

- 减小

max_batch_interval - 增加

desired_concurrent_number - 优化Doris集群性能,增加BE节点

问题2:导入任务频繁失败

可能原因:

- Kafka集群不稳定

- 数据格式不匹配

- Doris表结构变更

解决方案:

- 检查Kafka集群状态:be/src/runtime/routine_load/kafka_consumer.cpp

- 开启严格模式验证数据格式

- 确保Doris表结构与Kafka数据字段匹配

问题3:数据重复导入

可能原因:

- Routine Load任务异常重启

- Kafka消息重复消费

解决方案:

- 启用Doris的去重机制

- 使用Kafka的事务消息

总结与展望

Apache Doris与Kafka的集成提供了一种高效、可靠的流数据处理方案,通过Routine Load功能可以轻松实现Kafka数据的实时导入和分析。本文介绍的最佳实践涵盖了从任务创建、参数配置到监控管理的各个方面,帮助你快速构建稳定的实时数据处理 pipeline。

随着Apache Doris的不断发展,未来还将提供更多与Kafka集成的高级特性,如更丰富的数据转换功能、更精细的监控指标等。建议持续关注官方文档和更新日志,及时了解新功能:CHANGELOG.md

希望本文对你的流数据处理工作有所帮助,如有任何问题,欢迎在社区讨论区交流。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://gitcode.com/gh_mirrors/dori/doris

项目地址: https://gitcode.com/gh_mirrors/dori/doris