11fps实时视频生成革命:Krea Realtime 14B如何重塑内容创作

【免费下载链接】krea-realtime-video

导语

2025年10月20日,Krea AI发布140亿参数的实时视频生成模型Krea Realtime 14B,通过创新的Self-Forcing蒸馏技术,在单张NVIDIA B200 GPU上实现11fps的文本到视频推理速度,较现有开源模型规模提升10倍,首次实现文本到视频的实时交互创作。

行业现状:视频生成的"速度-质量"悖论

2025年AIGC市场报告显示,短视频内容需求同比增长217%,但传统视频生成技术面临严峻挑战:主流模型如Wan 2.1 1.3B虽能完成基础视频转换任务,却难以平衡生成速度与内容质量。传统视频扩散模型采用双向注意力机制,所有帧并行去噪,虽生成质量高但无法实时响应,而小型实时模型则受限于参数规模,难以处理复杂运动和精细细节。

实时视频生成的三大痛点:

- 逻辑断层:生成视频可能"画面精美但情节混乱",前一秒在海边后一秒突然跳到城市

- 控制困难:需要极其详细的Prompt,如"镜头从30度俯拍,主角迈左脚速度0.5m/s"

- 交互割裂:无法自然调整内容,修改细节需重新生成整个视频

如上图所示,这是ModelScope平台上"krea-realtime-video"模型页面截图,展示了Krea Realtime 14B模型的核心特性:通过Self-Forcing蒸馏技术实现11fps文本到视频推理速度,支持单张NVIDIA B200 GPU运行,具备实时交互生成能力。这一页面直观呈现了模型的技术参数和应用场景,为开发者提供了快速了解和接入的入口。

技术突破:Self-Forcing蒸馏与自回归架构

Krea Realtime 14B通过三大技术创新打破了传统视频生成的固有局限,实现了速度与质量的双重突破。

核心架构:从双向到因果的范式转换

传统视频扩散模型使用双向注意力机制,所有帧并行去噪,未来帧可以影响过去帧,这种方式虽生成质量高但无法实时输出。Krea Realtime 14B采用自回归架构,按顺序生成帧序列——先生成第一帧,再基于第一帧生成第二帧,依此类推,实现实时流式输出。

Krea Realtime 14B采用约140亿参数的扩散变换器混合架构,专门针对视频序列数据优化。模型融合了CLIP编码器(负责捕捉画面风格与视觉元素)和T5-XXL编码器(提供长文本理解能力),实现对复杂提示词的精准还原。

Self-Forcing技术:解决暴露偏差的关键

自回归模型面临的核心挑战是"暴露偏差"(Exposure Bias):训练时基于"真实"过去帧预测下一帧,推理时却要基于"自己生成的"可能包含错误的过去帧,导致小错误如滚雪球般累积。

Krea团队创新的Self-Forcing蒸馏技术通过在训练时就让模型适应自身生成的帧,成功解决了这一问题。该技术包含三个阶段:时序蒸馏(将教师模型推理步骤从30步压缩到4步)、因果ODE预训练(平衡短期质量与长期一致性)、分布匹配蒸馏(接受教师模型的"分布级指导")。

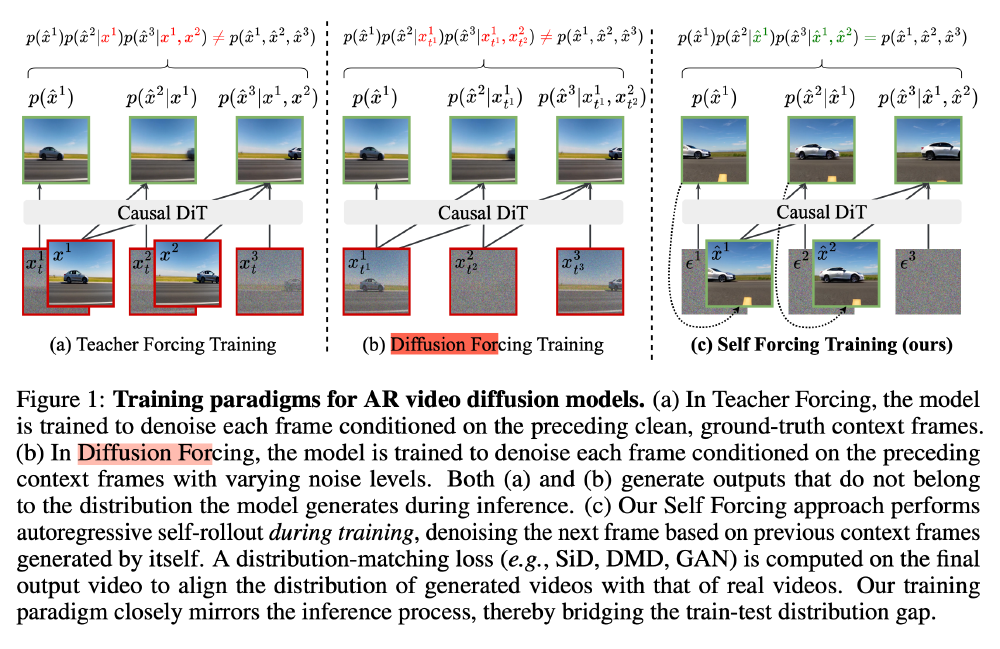

图中展示了AR视频扩散模型的三种训练范式对比:教师强制训练、扩散强制训练及Krea采用的自强制训练。其中自强制训练通过在训练时就让模型使用自身生成的帧作为上下文,解决了传统方法中训练与推理环境不匹配的问题,显著降低了错误累积。这一技术创新是Krea Realtime 14B实现高质量实时视频生成的核心基础。

内存优化:KV缓存管理与长视频生成

为实现长视频生成,Krea Realtime 14B开发了多项内存优化技术:

- KV缓存重计算:定期用干净潜在帧重新计算缓存,减少早期错误影响

- KV缓存注意力偏置:给过去帧的注意力施加负偏置,降低其影响力

- 第一帧锚定:永远保留第一个帧的缓存,作为生成过程的"定海神针"

性能对比:重新定义实时视频生成标准

Krea Realtime 14B在单张NVIDIA B200 GPU上实现11fps的文本到视频推理速度,且首帧生成时间低于1秒,较同类模型有显著提升:

| 模型名称 | 参数量 | 推理速度 | 推理步数 | 最小显存 | 支持实时交互 |

|---|---|---|---|---|---|

| Krea Realtime 14B | 140亿 | 11fps | 4步 | 80GB(B200) | 是 |

| Wan 2.1 1.3B | 13亿 | 24fps | 4步 | 16GB | 否 |

| Wan 2.1 14B | 140亿 | 0.8fps | 30步 | 80GB(B200) | 否 |

应用场景与实战案例

Krea Realtime 14B支持文本到视频和视频到视频两种模式,在多个创意领域展现出广泛应用潜力:

实时视频编辑与风格迁移

模型支持将输入视频实时转换为指定风格,如将普通街景视频转换为梵高星空风格。开发者可通过以下代码实现基本风格迁移功能:

def video_style_transfer(pipe, input_video_path, style_prompt, output_path):

# 读取输入视频并提取帧

import cv2

cap = cv2.VideoCapture(input_video_path)

input_frames = []

while True:

ret, frame = cap.read()

if not ret:

break

# 转换颜色空间 BGR to RGB

frame_rgb = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

input_frames.append(frame_rgb)

cap.release()

# 自回归生成风格化视频帧

# ...(省略实现细节)

# 导出结果视频

export_to_video(output_frames, output_path, fps=16)

return output_path

创意产业应用前景

- 电影与动画制作:实时生成概念视频和故事板,导演可即时可视化场景构想

- 游戏开发:实时生成游戏过场动画和动态内容,降低小型团队开发成本

- 广告与营销:根据市场反馈实时调整广告视频风格和内容,实现个性化营销

- 教育内容创作:教师快速将抽象概念转化为可视化视频,提升学习体验

该图展示了AR视频扩散模型的三种训练范式:教师强制训练、扩散强制训练和自强制训练,其中自强制训练通过在训练期间执行自动回归生成来缩小训练与推理的分布差距。这一技术图解帮助我们理解Krea Realtime 14B如何通过创新训练方法解决传统自回归模型的"暴露偏差"问题,为实时视频生成奠定了理论基础。

行业影响与未来趋势

Krea Realtime 14B的发布标志着AI视频生成正从"一次性输出"的工具,向"持续对话"的创意伙伴演变。该模型对行业的影响主要体现在:

创作流程重构

传统视频创作流程(构思→脚本→拍摄→剪辑)需要数天时间,而Krea Realtime 14B将其缩短至几分钟,且支持实时调整。创作者可在生成过程中修改提示词,实时调整视频风格和内容,实现"所想即所得"的创作体验。

技术路线分化

Krea Realtime 14B的成功验证了大参数自回归模型在实时视频生成领域的潜力,预计未来行业将出现两条技术路线:一是继续扩大模型规模以提升质量,二是优化现有架构以降低硬件门槛。

商业模式创新

实时视频生成技术可能催生新的商业模式,如"实时视频即服务"(Real-time Video as a Service),允许用户按使用次数付费,无需前期巨额投资。同时,该技术也为个性化内容推荐、虚拟主播、互动广告等领域带来新机遇。

部署指南与快速上手

环境配置步骤

# 1. 安装系统依赖

sudo apt update

sudo apt install ffmpeg

sudo apt install nvidia-cuda-toolkit

# 2. 创建Python虚拟环境

python -m venv krea_env

source krea_env/bin/activate

# 3. 克隆项目仓库

git clone https://gitcode.com/hf_mirrors/krea/krea-realtime-video

cd krea-realtime-video

# 4. 使用uv安装Python依赖

uv sync

# 5. 安装Flash Attention优化

uv pip install flash_attn --no-build-isolation

# 6. 下载模型文件

huggingface-cli download Wan-AI/Wan2.1-T2V-1.3B \

--local-dir-use-symlinks False \

--local-dir wan_models/Wan2.1-T2V-1.3B

huggingface-cli download krea/krea-realtime-video \

krea-realtime-video-14b.safetensors \

--local-dir-use-symlinks False \

--local-dir checkpoints/krea-realtime-video-14b.safetensors

启动推理服务器

export MODEL_FOLDER=Wan-AI

export CUDA_VISIBLE_DEVICES=0 # 指定使用的GPU

export DO_COMPILE=true # 启用编译优化

# 启动推理服务器

uvicorn release_server:app --host 0.0.0.0 --port 8000

服务器启动后,可通过浏览器访问http://localhost:8000/使用Web界面,或通过API接口调用模型生成视频。

结论与前瞻

Krea Realtime 14B通过140亿参数规模、Self-Forcing蒸馏技术和创新的内存管理方案,首次实现了文本到视频的实时交互创作。这一突破不仅解决了视频生成"速度-质量"的长期矛盾,更为内容创作行业带来了革命性变革。

未来,随着硬件成本降低和算法优化,我们有理由相信实时视频生成技术将从专业领域走向大众应用,让每个人都能通过自然语言轻松创建高质量视频内容。同时,该技术也面临内容版权、伦理规范等挑战,需要行业共同努力制定标准。

对于开发者和创意工作者而言,现在正是探索这一技术的最佳时机。通过Krea Realtime 14B提供的开源工具和API,我们可以预见一个充满想象力的内容创作新未来。

点赞+收藏+关注,获取更多AI视频生成技术前沿资讯!下期我们将带来Krea Realtime 14B与其他主流视频生成模型的实战对比测评,敬请期待!

【免费下载链接】krea-realtime-video

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考