导语

阿里通义实验室发布的Qwen3-VL-30B-A3B-Thinking多模态大模型,凭借"视觉代理+超长上下文"双重突破,重新定义了AI与物理世界的交互方式,推动多模态智能从感知迈向行动。

行业现状:视觉大模型成AI产业新引擎

2025年,视觉大模型赛道迎来爆发期。IDC《视觉大模型能力及应用评估报告》显示,随着NLP大模型技术趋于收敛,视觉与多模态大模型已成为AI产业新增长点。报告指出,视觉大模型依托强泛化性,使计算机视觉从"一场景一模型"升级为"统一模型解决多场景问题",推动多行业智能化转型。

当前行业呈现三大趋势:一是从单模态向多模态融合演进,跨模态对齐技术显著提升用户意图理解精度;二是端侧AI与边缘智能崛起,大小模型协同部署成为主流;三是具身智能与机器人应用拓展,"万物检索"时代加速到来。在这一背景下,Qwen3-VL-30B-A3B-Thinking的推出恰逢其时。

核心亮点:从技术突破到场景落地

1. 视觉代理能力:AI操作界面的革命

Qwen3-VL最引人注目的创新是其"视觉代理"(Visual Agent)功能,使AI能够直接操作PC/移动设备界面。该功能可识别界面元素、理解功能逻辑、调用工具并独立完成任务,实现了从"被动响应"到"主动操作"的跨越。

这一能力在多个行业展现出巨大潜力。医疗领域,类似多智能体系统已实现CT、MRI和病理报告的跨系统整合分析,将诊断耗时从2小时缩短至15分钟;工业场景中,设备巡检智能体通过图像识别与语音交互,使故障漏检率从15%降至3%以下。

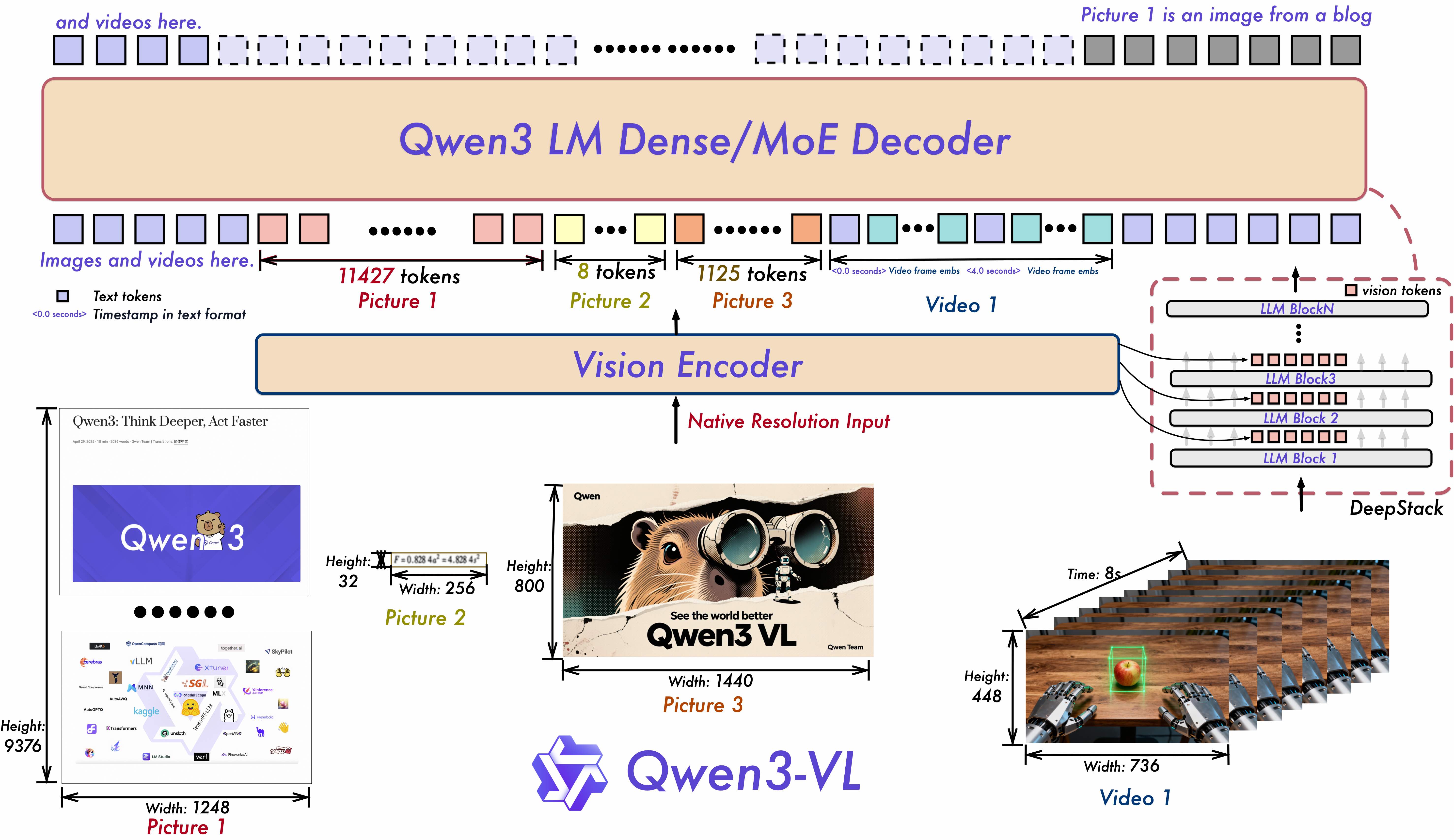

2. 架构升级:三大技术支撑多模态融合

如上图所示,Qwen3-VL采用全新架构设计,包含三大核心技术创新。Interleaved-MRoPE通过鲁棒的位置嵌入实现时间、宽度和高度的全频率分配,显著增强了长视频推理能力;DeepStack技术融合多级ViT特征,提升了细粒度细节捕捉和图文对齐精度;Text-Timestamp Alignment则突破传统T-RoPE限制,实现精确的时间戳接地事件定位,强化视频时序建模。

3. 超长上下文与视频理解:从片段到全景

该模型原生支持256K上下文长度,可扩展至1M,能够处理整本书籍和数小时长视频,并实现秒级索引和完整召回。这一能力使教育、媒体等行业发生变革——类似"AI助教智能体"已能基于超长教学视频生成个性化学习计划,响应效率显著提升,学生满意度提升40%。

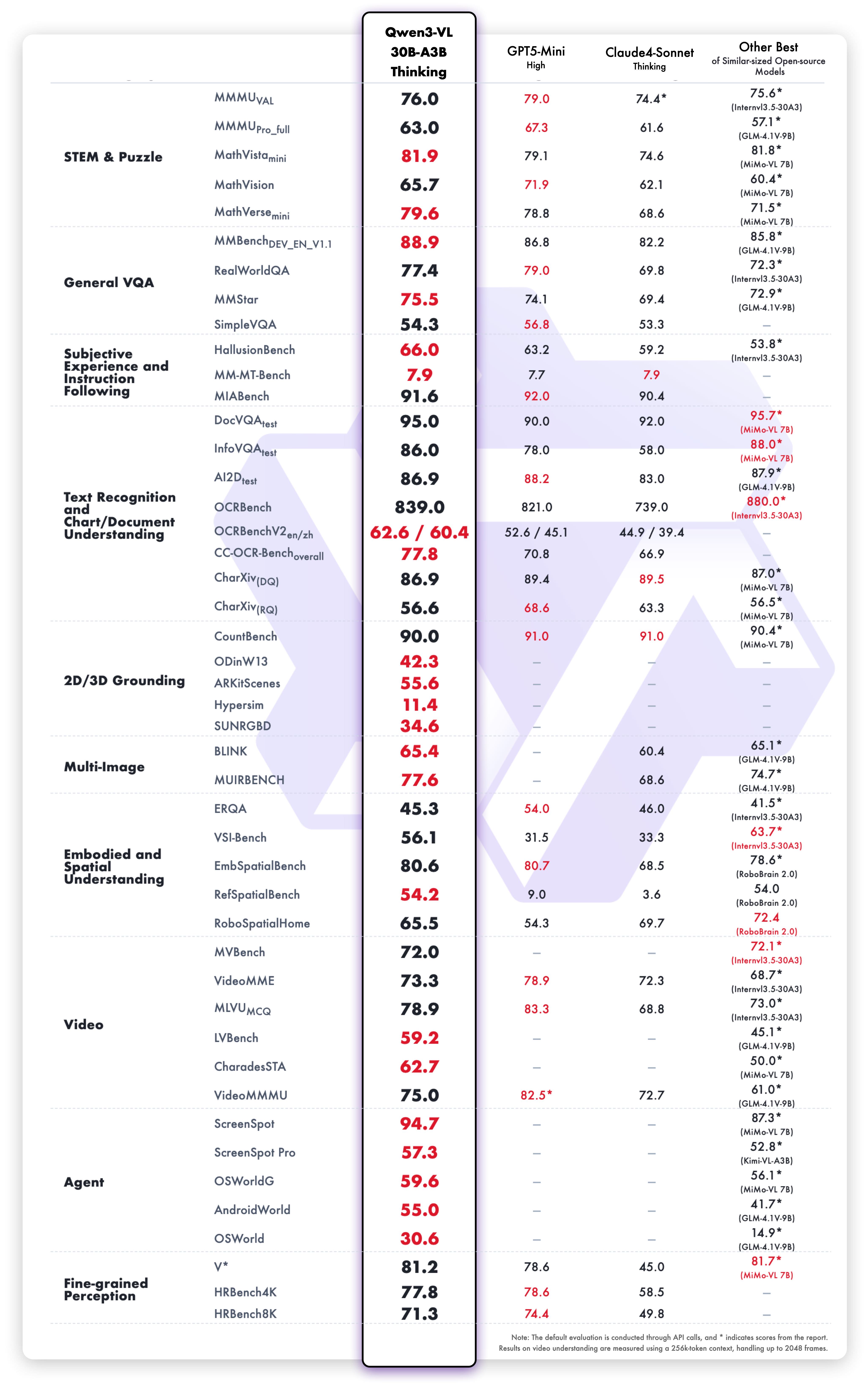

4. 性能全面领先:多模态与纯文本双优

这张性能对比表展示了Qwen3-VL在多模态任务上的全面优势。模型在STEM/Math推理、空间感知、视频理解等关键指标上均处于领先位置,尤其在需要因果分析和逻辑证据的复杂任务中表现突出。同时,其文本理解能力已媲美纯语言大模型,实现无缝的文本-视觉融合理解。

行业影响:重构人机协作范式

Qwen3-VL的推出将加速多行业智能化转型。零售领域,类似健康养生门店的客户管理智能体已证明,AI可通过视觉识别和自然语言交互,使客户复购率提升20%以上;制造业中,产线数据智能体自动生成日报,节省70%统计工时并消除人工误差;金融服务方面,智能投顾系统基于客户风险偏好自动推荐产品,中老年用户转化率提升35%。

特别值得注意的是,Qwen3-VL通过阿里云百炼平台提供API服务,降低了企业接入门槛。这种"轻量化部署+场景化定制"模式,使中小商家也能享受尖端AI能力,如美业门店使用智能体生成个性化护理方案,客单价提升20%;房产中介通过AI助手实现线索收集率提升47%。

未来展望:从工具到伙伴的进化

Qwen3-VL-30B-A3B-Thinking代表了AI发展的新方向:从被动工具进化为主动协作伙伴。随着技术不断成熟,我们可以期待更多创新应用——从自动完成供应链管理的"数字员工",到能独立进行实验设计的科研助手,再到个性化健康管理的"数字管家"。

IDC预测,到2026年,60%的企业将部署至少一种视觉代理应用,多模态智能体将成为企业数字化转型的必备要素。Qwen3-VL的技术突破,无疑为这一未来图景提供了关键推动力。对于企业而言,现在正是评估和布局这一技术的最佳时机,以在即将到来的智能协作时代占据先机。

快速上手指南

企业和开发者可通过以下代码快速体验Qwen3-VL-30B-A3B-Thinking:

from transformers import Qwen3VLMoeForConditionalGeneration, AutoProcessor

# 加载模型

model = Qwen3VLMoeForConditionalGeneration.from_pretrained(

"https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking",

dtype="auto",

device_map="auto"

)

processor = AutoProcessor.from_pretrained("https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking")

# 准备输入

messages = [

{

"role": "user",

"content": [

{"type": "image", "image": "demo.jpeg"},

{"type": "text", "text": "分析此界面并总结主要功能"}

],

}

]

inputs = processor.apply_chat_template(

messages, tokenize=True, add_generation_prompt=True, return_dict=True, return_tensors="pt"

)

# 推理生成

generated_ids = model.generate(**inputs, max_new_tokens=128)

output_text = processor.batch_decode(generated_ids, skip_special_tokens=True)

print(output_text)

通过这一简洁接口,开发者可快速集成Qwen3-VL的视觉理解、界面操作和多模态推理能力,构建新一代智能应用。

结语:多模态智能的行动时代

Qwen3-VL-30B-A3B-Thinking的发布标志着AI已从"理解世界"迈向"操作世界"的关键阶段。其视觉代理能力打破了数字与物理世界的界限,超长上下文支持实现了全量信息处理,而多模态推理则为复杂决策提供了可靠支撑。

随着技术不断成熟和成本持续下降,我们有理由相信,类似Qwen3-VL这样的多模态智能体将在未来2-3年内广泛渗透到医疗、教育、制造、金融等关键行业,成为企业数字化转型的核心引擎。对于行业从业者而言,理解并善用这些新技术,将是把握下一代AI机遇的关键。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking