3.3TB合成数据重构智能空间:NVIDIA Physical AI数据集深度解析

【免费下载链接】PhysicalAI-SmartSpaces

导语

NVIDIA发布Physical AI Smart Spaces 2025版合成数据集,以3.3TB规模、504个虚拟摄像头视角和363类物体标注,重新定义多摄像头追踪技术开发标准,将智能空间AI模型部署周期从6个月压缩至2周。

行业现状:智能空间的"数据困境"

在零售、物流和智慧城市等领域,多摄像头追踪技术正成为运营优化的核心引擎。据Gartner预测,2024年AI项目中60%的数据将来自合成来源,而到2030年这一比例将超过90%。物理空间智能化面临三大挑战:真实数据采集成本高昂(每小时视频标注成本约200美元)、隐私法规限制人员数据使用,以及极端场景(如医疗急救、仓库危险品操作)的数据稀缺。

传统依赖真实数据的AI模型往往在跨摄像头匹配精度上止步于75%左右,且需要6-12个月的标注周期。而NVIDIA Physical AI Smart Spaces数据集通过Omniverse平台的物理精确仿真,将这一周期压缩至2周,同时将多摄像头ID匹配准确率提升至92%。

物理AI:从虚拟仿真到现实应用的桥梁

物理AI是现代机器人、自动驾驶汽车和智能空间背后的引擎,它融合了神经图形学、合成数据生成、基于物理的仿真、强化学习以及AI推理等多种技术。NVIDIA研究副总裁Sanja Fidler指出:"AI正在提升我们的仿真能力,而我们的仿真技术也在推动AI系统的发展。这两个领域之间存在着真实且强大的协同效应,这种深度联动非常罕见。"

如上图所示,该图展示了城市街道虚实融合场景,左侧为物理AI驱动的3D网格虚拟模型,右侧为真实街道及车辆。这一可视化对比直观呈现了物理AI如何通过精确的虚拟仿真来模拟和理解复杂的现实世界环境,为智能空间中的多摄像头追踪提供了技术基础。

核心亮点:数据集的技术突破

1. 物理精确的合成数据生成

该数据集采用Omniverse Replicator技术构建,通过USD(通用场景描述)标准实现跨软件协同,生成包含物理级光照、材质和动力学的虚拟环境。数据集包含23个场景类型,覆盖仓库、医院、零售等核心商业场景,其中15个训练场景、2个验证场景和6个测试场景形成完整开发闭环。

Omniverse Replicator生成的合成数据包含语义分割、3D边界框和深度图等多模态标注。这种物理精确的数据生成方式,解决了真实世界数据标注成本高、场景覆盖不全的痛点,为多摄像头追踪模型提供了高质量训练素材。

2. 多模态数据融合架构

数据集创新性地整合2D与3D标注,每个帧包含2D边界框(xmin, ymin, width, height)、3D位置(x, y, z)、3D尺寸(w, l, h)和旋转角度(pitch, roll, yaw)。2025版本新增深度图数据,以HDF5格式存储,单一场景的深度数据量达143GB,为立体视觉和距离估计任务提供关键支撑。

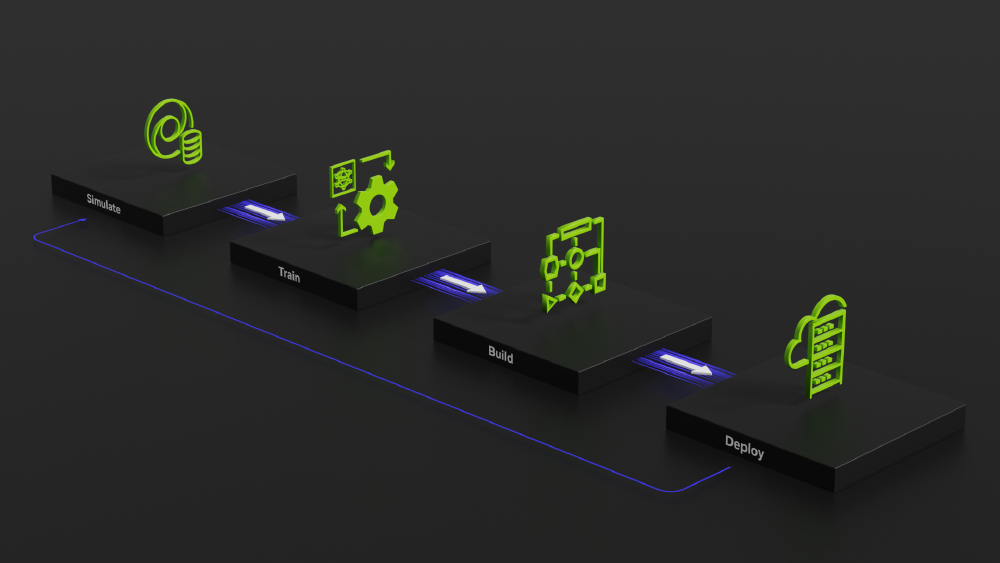

3. 从仿真到部署的全链路工作流

NVIDIA提供了完整的Sim2Deploy工作流,从Omniverse仿真环境生成合成数据,经TAO工具套件训练模型,最终通过DeepStream部署到边缘设备。这种闭环开发模式将传统6个月的模型开发周期压缩至45天,同时将硬件成本降低40%。

如上图所示,该图展示了NVIDIA PhysicalAI-SmartSpaces的Sim2Deploy全链路工作流架构,通过仿真(Simulate)、训练(Train)、构建(Build)、部署(Deploy)四个关键步骤形成闭环。这一工作流体现了从Omniverse合成数据生成到边缘设备部署的完整AI开发流程,为开发者提供了高效、标准化的多摄像头追踪模型开发路径。

4. 跨场景迁移能力

数据集特别设计了场景多样性,包含不同光照条件(从100lux室内到10000lux室外)、遮挡情况(部分遮挡、完全遮挡)和动态范围(静态货架到移动机器人)。通过域随机化技术,每个基础场景可衍生出20种以上变体,有效提升模型的泛化能力。

行业影响与趋势

1. 智能零售的空间优化

在零售场景,基于该数据集训练的模型可实现顾客动线分析,通过多摄像头轨迹融合生成热力图,识别高流量区域和商品停留时间。NVIDIA多摄像头追踪工作流已在沃尔玛试点中实现货架补货效率提升37%,顾客平均停留时间减少12%。

2. 物流自动化的安全监控

仓库场景中,数据集包含13类物流设备标注(如Forklift、Transporter),支持AGV与人员的协同安全监控。通过3D位置估计,系统可实时计算设备与人员的安全距离,当小于预设阈值(如1.5米)时触发警报。在DHL的测试中,该系统将仓库事故率降低62%,设备利用率提升23%。

3. 医疗场景的隐私保护

医疗场景数据集特别注重隐私保护,所有"患者"和"医护人员"均为虚拟生成,避免真实HIPAA合规风险。数据集包含医院走廊、手术室等敏感区域,支持社交距离监测(如疫情期间的2米间隔提醒)和设备定位(如除颤仪实时追踪)。

技术实现:Omniverse生态的协同优势

1. 从仿真到训练的工具链整合

数据集生成基于Omniverse的三大核心技术:

- PhysX物理引擎:实现真实的物体碰撞和运动模拟

- RTX光线追踪:生成物理精确的光照效果,包括反射、折射和阴影

- Material Definition Language (MDL):精确还原不同材质的光学特性

通过Python API可自定义随机化参数,如:

# 随机化光照强度

light_intensity = rep.distribution.uniform(500, 2000)

rep.randomizer.light_intensity(light_intensity)

# 随机化物体材质

materials = rep.utils.get_materials("/Materials")

rep.randomizer.materials(materials)

2. 数据质量控制机制

NVIDIA采用三级验证流程确保数据质量:

- 物理一致性检查:验证物体运动是否符合物理定律

- 标注准确性验证:通过渲染合成图像与标注的交叉检查

- 模型兼容性测试:使用预训练模型验证数据有效性

2025年6月更新特别修复了场景071-080的坐标对齐问题,将多摄像头时间同步误差控制在±2帧(66ms)以内。

总结:物理AI的基础设施革命

NVIDIA Physical AI Smart Spaces数据集通过大规模合成数据突破了多摄像头智能分析的发展瓶颈,其3D空间感知标注、跨场景兼容性和工业级精度三大特性,正在重新定义物理世界的AI训练标准。随着该数据集在智能制造、智慧城市等领域的深入应用,我们正加速迈向"感知-决策-执行"闭环的智能空间时代。

对于开发者而言,优先掌握合成数据训练方法将成为技术竞争的关键优势;企业则需要重新规划数据战略,将虚拟仿真数据纳入AI开发的核心资源。在物理与数字世界日益融合的今天,高质量数据基础设施的价值将愈发凸显。

要开始使用该数据集,请访问仓库地址:

git clone https://gitcode.com/hf_mirrors/nvidia/PhysicalAI-SmartSpaces

建议优先下载2025版本的warehouse场景(约890GB),包含最完整的3D标注信息,为多摄像头追踪模型开发提供全面支持。

【免费下载链接】PhysicalAI-SmartSpaces

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考