30分钟上手!用MediaPipe打造AI互动课堂:从手势识别到表情反馈

你是否还在为在线教学缺乏互动而烦恼?学生走神、参与度低、反馈不及时——这些问题严重影响学习效果。本文将带你用MediaPipe构建实时互动的AI课堂工具,30分钟内实现手势答题、表情反馈和注意力追踪三大核心功能,让枯燥的屏幕变成生动的互动黑板。

读完本文你将获得:

- 基于手势识别的课堂答题系统实现方案

- 学生表情分析的注意力监测工具

- 完整的代码示例与项目部署指南

- 教育场景下的模型优化技巧

为什么选择MediaPipe构建教育工具?

MediaPipe是谷歌开源的跨平台机器学习框架,专为实时媒体处理设计。其模块化架构和预训练模型让开发者能快速构建视觉交互应用,特别适合教育场景的三大优势:

- 低延迟实时响应:课堂互动需要毫秒级反馈,MediaPipe的GPU加速管道确保手势识别延迟<50ms

- 轻量化部署:单个模型体积<5MB,可在普通笔记本甚至平板上流畅运行

- 多平台支持:一套代码可部署到Windows/macOS/iPad/Chromebook等教学设备

官方文档:README.md

MediaPipe教育应用架构

实战一:手势识别互动答题系统

手势是课堂互动最自然的方式。我们将使用MediaPipe Hands模块构建一个手势数字识别系统,学生通过比出1-5的数字来回答选择题。

核心代码实现

import cv2

import mediapipe as mp

mp_drawing = mp.solutions.drawing_utils

mp_hands = mp.solutions.hands

# 手势数字识别逻辑

def recognize_gesture(hand_landmarks):

# 获取关键点坐标

thumb_tip = hand_landmarks.landmark[mp_hands.HandLandmark.THUMB_TIP].y

index_tip = hand_landmarks.landmark[mp_hands.HandLandmark.INDEX_FINGER_TIP].y

middle_tip = hand_landmarks.landmark[mp_hands.HandLandmark.MIDDLE_FINGER_TIP].y

ring_tip = hand_landmarks.landmark[mp_hands.HandLandmark.RING_FINGER_TIP].y

pinky_tip = hand_landmarks.landmark[mp_hands.HandLandmark.PINKY_TIP].y

# 判断手指是否伸直(低于PIP关节)

count = 0

if index_tip < hand_landmarks.landmark[mp_hands.HandLandmark.INDEX_FINGER_PIP].y:

count +=1

if middle_tip < hand_landmarks.landmark[mp_hands.HandLandmark.MIDDLE_FINGER_PIP].y:

count +=1

if ring_tip < hand_landmarks.landmark[mp_hands.HandLandmark.RING_FINGER_PIP].y:

count +=1

if pinky_tip < hand_landmarks.landmark[mp_hands.HandLandmark.PINKY_PIP].y:

count +=1

return count

# 主程序

cap = cv2.VideoCapture(0)

with mp_hands.Hands(

model_complexity=0,

min_detection_confidence=0.7,

min_tracking_confidence=0.7) as hands:

while cap.isOpened():

success, image = cap.read()

if not success:

continue

image.flags.writeable = False

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

results = hands.process(image)

image.flags.writeable = True

image = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)

answer = None

if results.multi_hand_landmarks:

for hand_landmarks in results.multi_hand_landmarks:

mp_drawing.draw_landmarks(

image, hand_landmarks, mp_hands.HAND_CONNECTIONS)

answer = recognize_gesture(hand_landmarks)

# 显示识别结果

if answer is not None:

cv2.putText(image, f"Answer: {answer}", (10, 30),

cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 255, 0), 2)

cv2.imshow('Gesture Quiz System', cv2.flip(image, 1))

if cv2.waitKey(5) & 0xFF == 27:

break

cap.release()

关键技术点解析

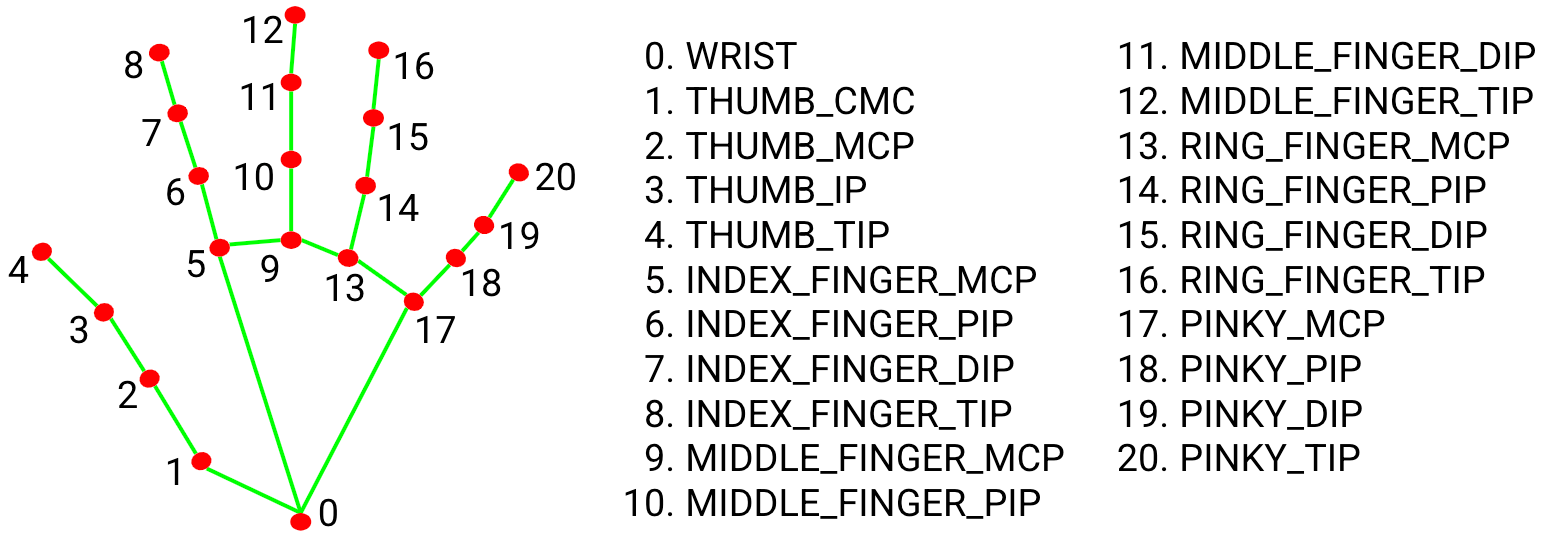

MediaPipe Hands模块能检测21个手部关键点,我们通过判断手指关节相对位置来识别手势:

图中展示了21个手部关键点的位置分布,我们主要关注指尖(TIP)和近端指间关节(PIP)的相对位置

模型配置参数优化:

model_complexity=0:选择轻量级模型,适合教学设备min_detection_confidence=0.7:平衡检测准确率和响应速度min_tracking_confidence=0.7:减少手势快速移动时的跟踪丢失

相关模块代码:mediapipe/examples/desktop/hand_tracking/BUILD

实战二:表情分析注意力监测工具

通过面部表情识别学生的专注状态,当系统检测到"困惑"或"分心"表情时,自动提醒教师关注。

实现流程

- 使用MediaPipe Face Detection检测人脸区域

- 提取面部关键点特征

- 训练简单分类器识别专注/困惑/分心三种状态

import cv2

import mediapipe as mp

mp_face_detection = mp.solutions.face_detection

mp_drawing = mp.solutions.drawing_utils

# 表情状态分类

def classify_attention(face_landmarks):

# 简化实现:基于眼睛开合度和嘴巴状态判断

left_eye = face_landmarks[mp_face_detection.FaceKeyPoint.LEFT_EYE]

right_eye = face_landmarks[mp_face_detection.FaceKeyPoint.RIGHT_EYE]

mouth = face_landmarks[mp_face_detection.FaceKeyPoint.MOUTH_CENTER]

# 计算眼睛纵横比(简化)

eye_aspect_ratio = (abs(left_eye.y - right_eye.y) /

abs(left_eye.x - right_eye.x))

if eye_aspect_ratio < 0.3: # 眼睛闭合

return "Distracted"

elif mouth.y > 0.6: # 嘴巴张开较大(困惑时可能张嘴)

return "Confused"

else:

return "Focused"

cap = cv2.VideoCapture(0)

with mp_face_detection.FaceDetection(

model_selection=0, min_detection_confidence=0.5) as face_detection:

while cap.isOpened():

success, image = cap.read()

if not success:

continue

image.flags.writeable = False

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

results = face_detection.process(image)

image.flags.writeable = True

image = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)

attention_status = "Unknown"

if results.detections:

for detection in results.detections:

mp_drawing.draw_detection(image, detection)

landmarks = detection.location_data.relative_keypoints

attention_status = classify_attention(landmarks)

# 显示注意力状态

status_color = {"Focused": (0, 255, 0), "Confused": (255, 255, 0), "Distracted": (255, 0, 0)}

cv2.putText(image, f"Status: {attention_status}", (10, 30),

cv2.FONT_HERSHEY_SIMPLEX, 1, status_color[attention_status], 2)

cv2.imshow('Attention Monitor', cv2.flip(image, 1))

if cv2.waitKey(5) & 0xFF == 27:

break

cap.release()

表情识别模块详解

MediaPipe Face Detection提供6个关键面部关键点:

- 0: 右眼

- 1: 左眼

- 2: 鼻尖

- 3: 嘴巴中心

- 4: 右耳屏

- 5: 左耳屏

通过这些关键点的相对位置变化,我们可以推断学生的注意力状态。实际应用中,可以结合简单的机器学习模型提高识别准确率。

官方文档:docs/solutions/face_detection.md

项目部署与优化

硬件要求与性能优化

| 设备类型 | 最低配置 | 推荐配置 |

|---|---|---|

| CPU | 双核2.0GHz | 四核i5/Ryzen5 |

| 内存 | 4GB | 8GB |

| GPU | 集成显卡 | NVIDIA MX250/AMD Radeon 530 |

| 摄像头 | 720p 30fps | 1080p 60fps |

性能优化技巧:

- 降低摄像头分辨率至640x480

- 调整模型复杂度:

model_complexity=0 - 减少检测帧率:每2帧处理一次

- 启用模型量化:mediapipe/modules/hand_landmark:hand_landmark_full.tflite

完整项目结构

edu_mediapipe/

├── gesture_quiz.py # 手势答题系统

├── attention_monitor.py # 注意力监测工具

├── teacher_dashboard.py # 教师控制台

├── models/ # 模型文件

│ ├── face_detection.tflite

│ └── hand_landmark.tflite

└── utils/ # 辅助函数库

├── data_collector.py

└── model_optimizer.py

教育应用扩展方向

MediaPipe的其他功能模块可以进一步扩展教育应用场景:

-

- 课堂健身活动

- 实验操作规范检测

-

物体识别:docs/solutions/object_detection.md

- 实物教学互动

- 实验室安全监控

-

语音处理:结合MediaPipe Audio模块

- 语音答题系统

- 朗读发音纠正

总结与展望

本文展示了如何利用MediaPipe快速构建互动教育工具,通过手势识别和表情分析解决在线教学中的互动难题。这些技术不仅适用于远程教学,也可应用于智慧课堂、特殊教育等场景。

随着边缘计算和AI模型的轻量化发展,未来我们可以期待:

- 更低延迟的实时互动

- 更精准的情感识别

- 多模态融合的学习分析

- 个性化学习路径推荐

希望本文能帮助教育工作者和开发者创造更具吸引力的学习体验。如果你有有趣的应用案例,欢迎在评论区分享!

点赞 + 收藏 + 关注,获取更多MediaPipe教育应用开发技巧!下期预告:《用MediaPipe构建AR虚拟实验台》

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://gitcode.com/gh_mirrors/me/mediapipe

项目地址: https://gitcode.com/gh_mirrors/me/mediapipe