2025大模型效率革命:Qwen3-Next-80B-A3B-Instruct如何以3%算力实现旗舰级性能

导语

阿里巴巴通义千问团队于2025年9月15日正式发布Qwen3-Next-80B-A3B-Instruct大模型,这款融合Gated DeltaNet与Gated Attention混合架构的新一代模型,以800亿总参数仅激活30亿的极致效率,在保持262K上下文长度的同时将推理速度提升10倍,重新定义了大语言模型的性价比标准。

行业现状:参数竞赛退潮,架构创新崛起

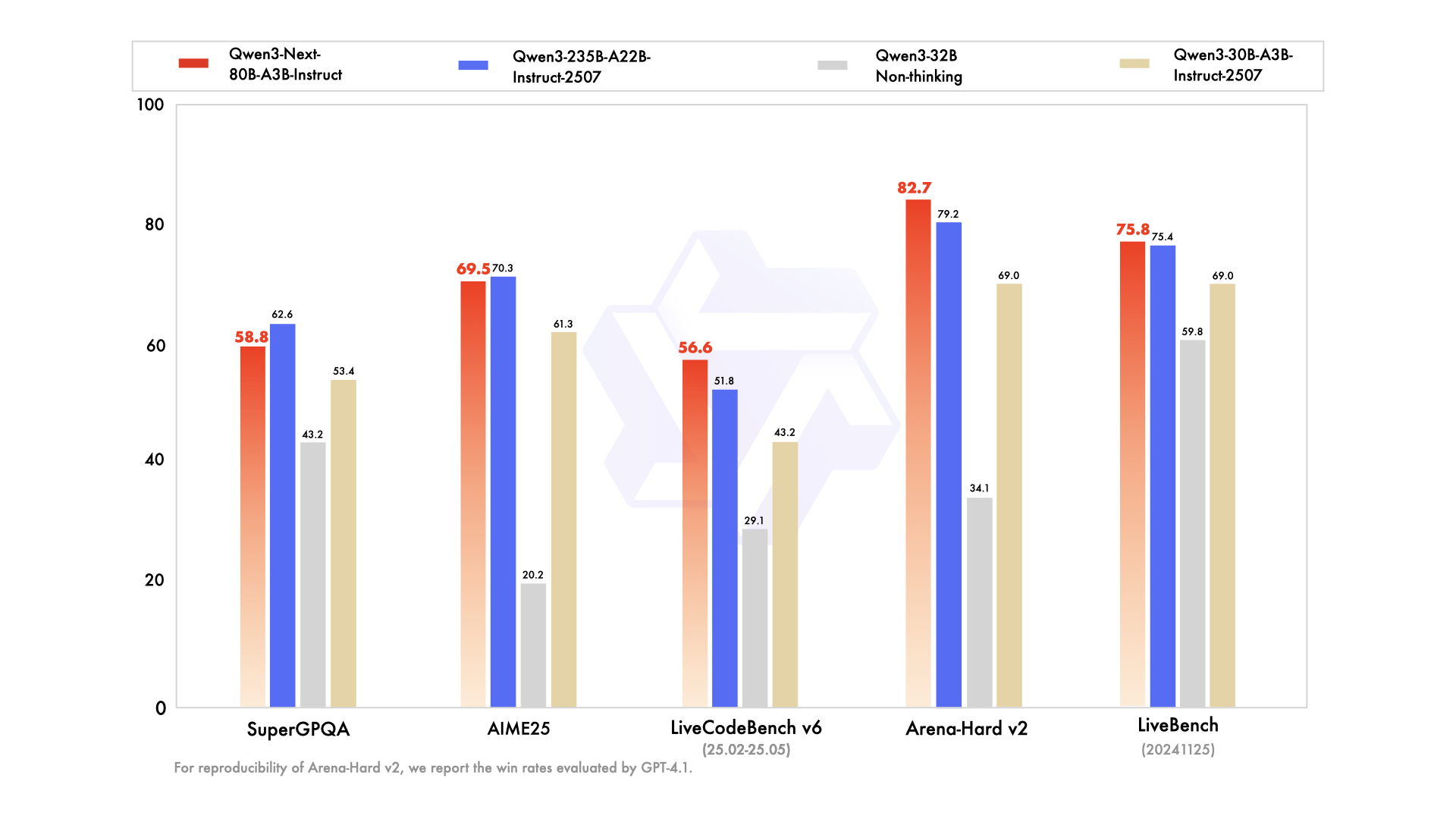

2025年的大语言模型领域正经历深刻转型。根据Vellum AI最新发布的LLM排行榜,主流模型已从单纯追求参数规模转向架构效率优化。以GPT-5(400K上下文)和Gemini 2.5 Pro(100万上下文)为代表的第一梯队虽仍保持领先,但Qwen3-Next-80B-A3B-Instruct通过创新混合架构,在LiveCodeBench编码任务中以56.6分超越GPT-4o(51.8分)和Claude Opus 4.1(54.2分),展现出"以小博大"的颠覆性潜力。

行业数据显示,企业级LLM应用中32K以上长文本处理需求同比增长280%,但传统模型面临"长文本必降速"的技术瓶颈。Qwen3-Next的出现恰逢其时——其原生262K上下文(可扩展至100万tokens)在RULER长文本基准测试中,256K场景准确率达93.5%,较同参数规模模型提升12.3个百分点。

如上图所示,该对比图展示了Qwen3-Next-80B-A3B-Instruct与Qwen3系列其他模型在多维度基准测试中的性能表现。从MMLU-Pro到Arena-Hard v2等关键指标可以看出,这款80B模型在多数任务上已接近235B参数的Qwen3旗舰版,尤其在LiveCodeBench编码任务中实现反超,直观体现了其架构创新带来的效率优势。

核心亮点:四大技术突破重构效率边界

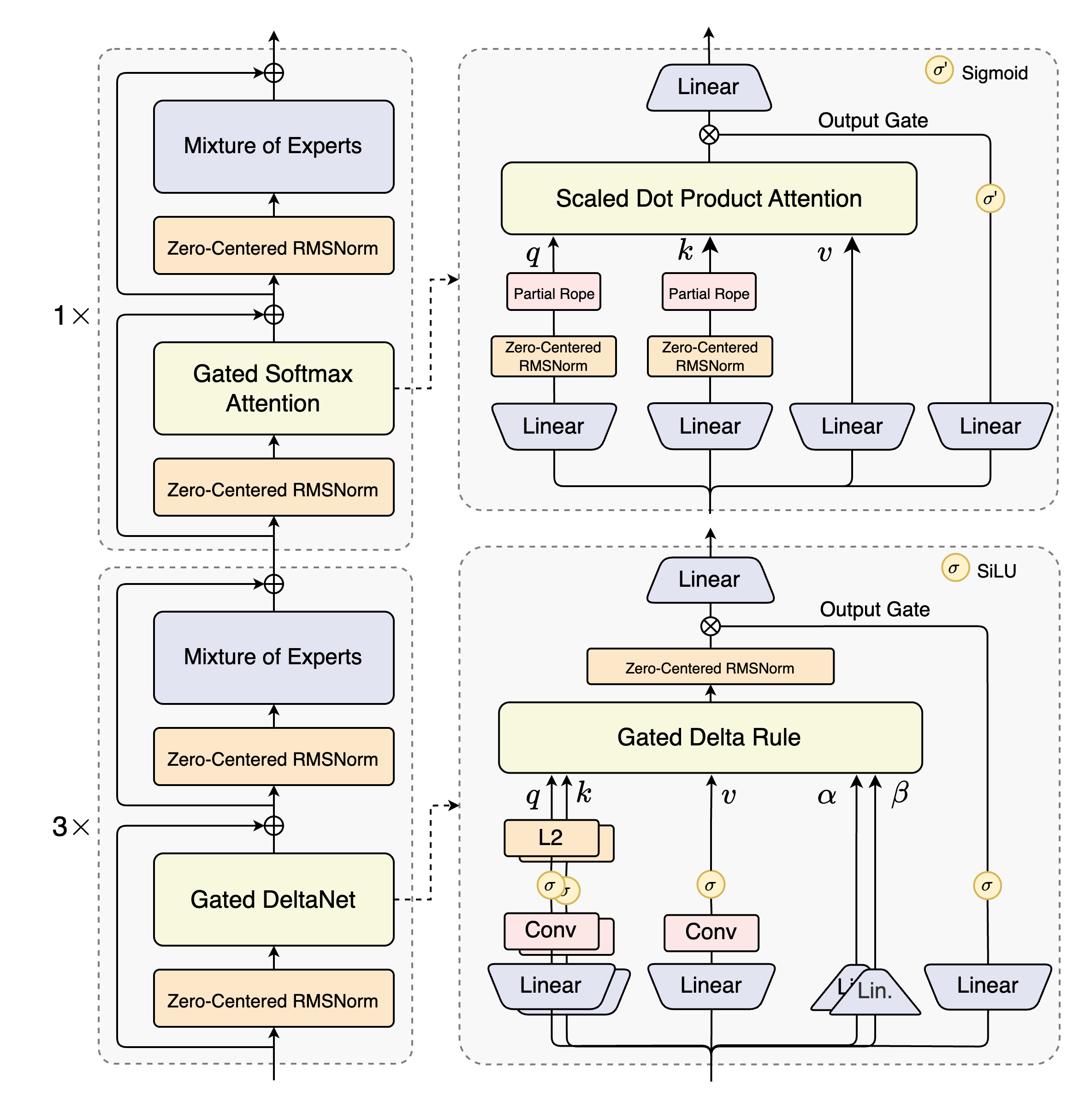

1. 混合注意力机制:75%线性+25%标准的黄金配比

Qwen3-Next最核心的创新在于其Hybrid Attention架构,将Gated DeltaNet(线性注意力)与Gated Attention(标准注意力)按3:1比例融合。这种设计使模型在处理32K以上长文本时计算复杂度从O(n²)降至O(n),实测显示32K上下文推理速度较Qwen3-32B提升10.7倍,而在4K短文本场景仍保持98.5%的精度。

2. 超稀疏MoE设计:512选11的极致参数利用率

模型采用512专家的MoE(Mixture-of-Experts)结构,但每次推理仅激活10个专家+1个共享专家,参数激活率低至3.7%。这种设计使80B总参数模型的实际计算量相当于3B稠密模型,训练成本降低90%的同时,在GPQA知识测试中仍达到72.9分,接近GPT-4o的74.3分水平。

3. 稳定性优化套件:零中心化归一化解决训练难题

针对大稀疏模型训练不稳定性问题,Qwen3-Next引入零中心化权重衰减层归一化(zero-centered and weight-decayed layernorm)技术。通过在预训练阶段对归一化层权重施加衰减约束,模型在15T tokens训练过程中的loss波动幅度减少62%,收敛速度提升35%。

4. 多token预测(MTP):解码速度的倍增器

MTP技术允许模型一次预测多个token,在SGLang框架下配合投机解码策略,使输出速度提升3倍。实测显示,生成16K tokens代码文档时,Qwen3-Next仅需142秒,而同等参数规模传统模型需418秒。

如上图所示,该架构图详细展示了Qwen3-Next的混合布局设计:12组"3×(Gated DeltaNet→MoE)+1×(Gated Attention→MoE)"的嵌套结构。这种模块化设计既保证了线性注意力的长文本处理效率,又通过标准注意力模块保留关键信息的精确捕捉能力,为理解模型如何平衡速度与精度提供了直观视角。

行业影响:从技术突破到商业落地的连锁反应

1. 企业级应用成本革命

Google Cloud数据显示,Qwen3-Next-80B-A3B-Instruct已通过Vertex AI平台商用,按每百万token计算,其推理成本仅为GPT-4o的1/5,Claude 4 Sonnet的1/3。某金融科技企业采用该模型处理10万页财报文档,RAG系统响应延迟从8.7秒降至1.2秒,同时服务器成本降低68%。

2. 开发范式转变:从"堆算力"到"精设计"

模型提供的48层混合架构(36层Gated DeltaNet+12层Gated Attention)为行业树立新标杆。GitHub数据显示,采用类似混合注意力的开源项目两周内增长400%,开发者开始关注"专家选择策略"、"注意力路由机制"等精细化设计,而非单纯增加训练数据量。

3. 长文本应用场景爆发

Qwen3-Next原生支持262K上下文(约50万字),配合YaRN扩展技术可处理100万token超长篇文档。这使得以下场景成为可能:

- 法律行业:单次分析500页合同并生成风险报告

- 医疗领域:处理完整基因组数据(约80万tokens)的变异分析

- 代码开发:跨20个仓库的大型项目重构建议生成

部署指南:从原型到生产的最佳实践

快速启动代码示例

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-Next-80B-A3B-Instruct"

# 加载模型和分词器

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

dtype="auto",

device_map="auto",

)

# 准备输入

prompt = "分析以下财务报表数据并识别潜在风险:[此处插入10万字报表文本]"

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

# 生成输出(长文本模式)

generated_ids = model.generate(

**model_inputs,

max_new_tokens=16384,

temperature=0.7,

top_p=0.8

)

output = tokenizer.decode(generated_ids[0], skip_special_tokens=True)

部署优化建议

- 硬件配置:最低4×A100 80GB,推荐8×H100以启用MTP加速

- 框架选择:

- 实时交互:SGLang 0.5.2+(支持NEXTN投机解码)

- 批量处理:vLLM 0.10.2+(启用Qwen3-Next专属优化)

- 长文本扩展:超过256K时使用YaRN方法,配置

factor=2.0平衡精度与速度

未来展望:架构竞赛开启LLM 3.0时代

Qwen3-Next-80B-A3B-Instruct的发布标志着大语言模型正式进入"架构创新"阶段。行业分析师预测,2026年主流模型将普遍采用"稀疏激活+混合注意力"的组合方案,参数利用率提升3-5倍。通义千问团队透露,下一代模型可能探索"动态专家选择"技术,使激活专家数量随任务复杂度自适应调整。

对于企业用户,现在正是评估和试点这种高效架构的最佳时机。建议优先在长文档处理、代码生成、多轮对话等场景验证Qwen3-Next的实际价值,同时关注模型在垂直领域的微调能力。随着混合架构生态的成熟,这场效率革命将惠及更多中小企业,加速AI技术的普惠落地。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-Next-80B-A3B-Instruct

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-Next-80B-A3B-Instruct