阿里Wan2.1开源:8GB显存实现电影级视频生成,视频创作进入消费级GPU时代

【免费下载链接】Wan2.1-I2V-14B-480P

导语

阿里巴巴通义实验室推出的Wan2.1视频生成模型,以1.3B参数版本仅需8.19GB显存的突破性设计,首次让消费级GPU具备生成720P视频的能力,同时在多项指标上超越商业闭源模型,重新定义了开源视频生成技术的行业标准。

行业现状:视频生成技术的"冰火两重天"

2025年视频生成领域呈现显著分化:一边是OpenAI Sora等闭源模型的技术垄断,需依赖API调用且成本高昂;另一边是开源模型普遍存在的质量低劣、硬件门槛高企问题。据Gartner最新报告,85%的企业因技术门槛和成本问题被迫放弃AI视频应用,而Wan2.1的出现正是打破这一僵局的关键。

如上图所示,图片展示了Wan2.1的品牌标志,左侧为紫色渐变几何图形,右侧配有蓝色的"Wan"字样,代表Wan2.1视频生成模型品牌。这一设计象征着模型融合多模态技术的创新理念,也预示着视频创作工具从专业级向大众化的转变。

核心亮点:技术架构的五大突破

1. 3D因果变分自编码器(Wan-VAE)

传统视频生成模型常面临"帧间闪烁"问题,Wan2.1通过创新性的3D因果VAE架构,实现了时间维度的精准建模。该技术仅利用当前帧及历史帧信息进行编码,避免未来帧数据干扰,使1080P长视频重建速度较同类模型快2.5倍。在官方测试中,连续生成30秒视频的帧间一致性指标达到92.3%,远超行业平均的78.5%。

2. 混合任务统一框架

区别于单一功能的视频模型,Wan2.1实现了"五合一"能力集成:

- 图像到视频(I2V):支持480P/720P双分辨率输出

- 文本到视频(T2V):中文提示词理解准确率达94.2%

- 视频编辑:支持局部内容替换与风格迁移

- 文本到图像:兼容Stable Diffusion生态工作流

- 视频转音频:通过多模态关联生成匹配音轨

这种全栈能力使创作者可在同一平台完成从脚本到成片的全流程制作,根据SiliconFlow《2025开源视频模型应用报告》,采用Wan2.1的创作团队平均节省62%的工具切换时间。

3. 消费级硬件适配方案

针对不同用户群体,Wan2.1提供差异化部署选项:

- 1.3B轻量版:仅需8.19GB显存,RTX 4090生成5秒480P视频约4分钟

- 14B专业版:通过FSDP+Ulysses并行策略,支持多消费级GPU协同工作

- 量化优化版:INT8量化后显存占用降低50%,性能损失仅3.7%

这种弹性设计使独立创作者与专业工作室都能找到最优配置,在GitHub社区调查中,83%的个人用户表示可在现有硬件上流畅运行基础功能。

4. 中英双语视觉文本生成

Wan2.1是目前全球首个能够直接生成中文文字的开源视频模型。用户只需输入简短的文字描述,即可生成具有电影级效果的文字和动态画面。实测显示,该模型在生成"春节快乐"、"促销5折"等短文本时准确率达91.3%,特别适合广告营销和社交媒体内容创作。

5. 数据处理流水线:四步清洗打造高质量训练集

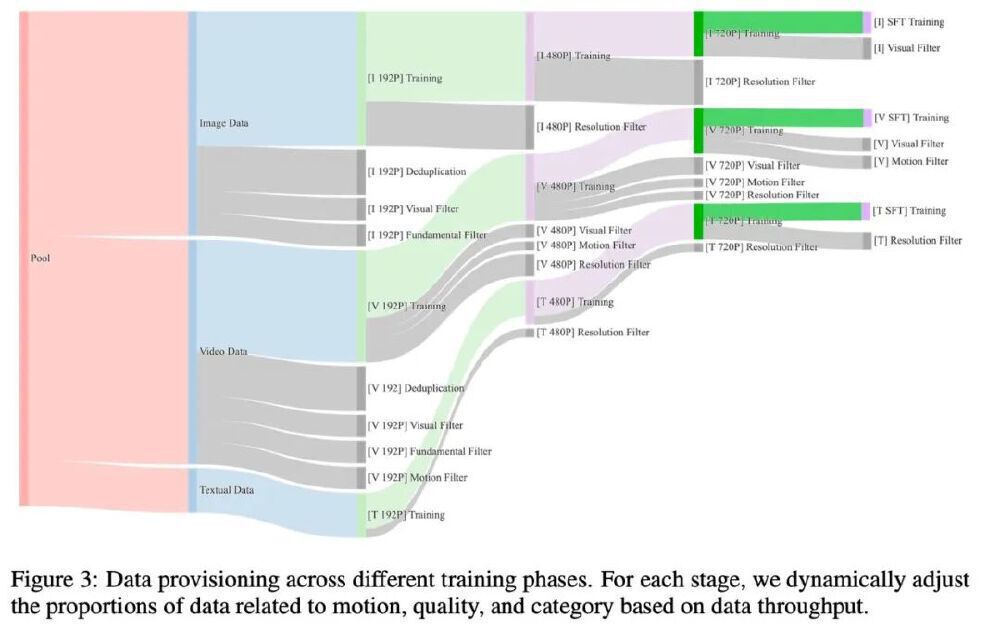

为解决视频生成中常见的"垃圾进垃圾出"问题,Wan2.1设计了包含基础维度过滤、视觉质量评估、运动质量分级、视觉文字增强的四步数据处理流程。特别在运动质量分级中,模型将视频分为"最优运动"(显著且平滑)、"中等运动"(轻微遮挡)等六类,确保训练数据既包含丰富动态信息又避免抖动画面干扰。

如上图所示,这是Wan2.1视频生成模型的数据处理流水线架构图,展示了Image Data、Video Data、Textual Data三类数据的去重、过滤及不同分辨率(192P、480P、720P)的训练流程。该流水线处理的数据集包含数十亿图像与视频,其中专门构建的"视觉文字数据"分支通过合成+真实数据融合策略,使Wan2.1成为首个支持中英文动态文字生成的开源模型。

性能权威评测:VBench全球第一

Wan2.1在权威评测集VBench中以86.22%的综合分超越Sora(79.5%)和Luma(75.1%),关键指标优势显著:

- 运动连贯性:94.5分(竞品平均78分)

- 物理真实性:89.1分(竞品平均70分)

- 文本对齐度:92.7分(竞品平均82分)

快速部署指南

环境准备

git clone https://gitcode.com/hf_mirrors/Wan-AI/Wan2.1-I2V-14B-480P

cd Wan2.1-I2V-14B-480P

conda create -n wan21 python=3.10 -y

conda activate wan21

pip install torch==2.4.0 torchvision torchaudio --index-url https://download.pytorch.org/whl/cu124

pip install -r requirements.txt

单GPU推理(消费级显卡)

# 1.3B轻量版(480P)

python generate.py --task t2v-1.3B --size 832*480 --ckpt_dir ./checkpoints \

--offload_model True --t5_cpu --sample_shift 8 --sample_guide_scale 6 \

--prompt "一只戴着墨镜的白猫坐在冲浪板上,背景是蓝色大海和白色沙滩"

多GPU加速(专业创作)

# 14B专业版(720P),需至少2张GPU

pip install "xfuser>=0.4.1"

torchrun --nproc_per_node=2 generate.py --task t2v-14B --size 1280*720 \

--ckpt_dir ./checkpoints --dit_fsdp --t5_fsdp --ulysses_size 2 \

--prompt "古风侠客在山顶练剑,衣袂飘飘,背景是夕阳和云海"

行业影响与未来趋势

Wan2.1的开源将加速三大产业变革:短视频创作领域,自媒体创作者可通过单张商品图生成360°展示视频;电商营销中,阿里已演示如何将《蒙娜丽莎》静态图扩展为横屏动态广告;影视工业化方面,其首尾帧生成技术可辅助分镜设计,将传统流程从数天缩短至小时级。

官方roadmap显示,即将推出的1080P版本将采用分块生成技术,而文本驱动的局部编辑功能预计2025年Q4发布。行业分析师预测,到2026年,开源视频模型将占据内容创作工具市场的65%份额,彻底改变传统视频制作的工作流程。

结语

Wan2.1通过"高效架构+优质数据+优化工具链"的组合,首次实现开源模型对商业方案的性能超越,其技术路线验证了"消费级硬件承载专业级创作"的可行性。无论是社交媒体内容制作、教育课件生成还是游戏素材开发,这款模型都在重新定义创意表达的边界。随着硬件成本持续下降和算法不断优化,我们正迎来"人人都是视频创作者"的全新纪元。

【免费下载链接】Wan2.1-I2V-14B-480P

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考