240亿参数重塑本地AI:Magistral Small 1.1开启轻量级推理新纪元

【免费下载链接】Magistral-Small-2507

导语

Mistral AI推出的Magistral Small 1.1以240亿参数实现了推理能力与本地化部署的双重突破,标志着轻量级大模型正式进入企业级实用阶段。

行业现状:从参数竞赛到效率优先

当前AI行业正经历深刻转型。据2025年Q2市场动态显示,企业级AI部署中,30亿参数以下模型的采用率同比提升217%,而1000亿+参数模型的实际落地案例不足12%。这种趋势源于三大核心需求:边缘计算场景的实时响应要求、企业数据隐私保护法规的强化,以及AI基础设施成本控制压力。

如上图所示,Magistral Small 1.1模型在代码托管平台的展示界面清晰展示了该AI模型的技术相关信息。这一界面反映了当前开源AI模型的标准化呈现方式,也体现了Magistral Small 1.1作为轻量级推理模型的市场定位。

与此同时,推理能力成为企业选择AI模型的核心指标。"模型能力决定应用体量的下限,场景适配度决定上限"已成行业共识。企业在使用大模型的过程中,重点关注场景应用效果、推理服务性能、使用成本等三大维度指标。

核心亮点:推理与部署的双重突破

增强型推理能力

Magistral Small 1.1在Mistral Small 3.1基础上显著提升了推理能力,通过从Magistral Medium traces进行SFT(监督微调)并在其上进行RL(强化学习)训练,使其成为一个小型高效的推理模型。该模型引入了[THINK]和[/THINK]特殊标记,能够在生成答案前进行多步推理,显著提升了复杂问题的解决能力。

在基准测试中,Magistral Small 1.1在AIME24 pass@1达到70.52%,AIME25 pass@1达到62.03%,GPQA Diamond达到65.78%,Livecodebench (v5)达到59.17%,整体性能与上一版本相当,但在推理质量和任务完成度上有明显提升。

极致优化的本地化部署

Magistral Small 1.1展现出卓越的本地化部署能力,量化后可在单张RTX 4090显卡或32GB内存的MacBook上流畅运行。这种部署灵活性极大降低了企业AI应用的门槛,尤其是对于资源受限的中小企业。

部署命令示例:

vllm serve mistralai/Magistral-Small-2507 --reasoning-parser mistral --tokenizer_mode mistral --config_format mistral --load_format mistral --tool-call-parser mistral --enable-auto-tool-choice --tensor-parallel-size 2

多语言支持与广泛适用性

该模型支持包括中文、英文、法文、德文、日文、韩文等在内的25种语言,能够满足全球化企业的多语言处理需求。配合128K的上下文窗口(推荐使用40K以获得最佳性能),Magistral Small 1.1可处理长文档理解、复杂指令遵循等高级任务。

行业影响与应用场景

Magistral Small 1.1的推出正推动AI应用从"通用大模型"向"场景化小模型"转变。其增强的推理能力与本地化部署特性在多个领域展现出突出优势:

企业智能客服

在客户服务场景中,Magistral Small 1.1能够理解复杂的客户查询,通过多步推理解决常见问题,同时保持本地化部署的数据安全优势。企业可以在保护客户隐私的前提下,提供高质量的智能客服体验。

金融风控分析

金融机构可利用该模型的推理能力进行风险评估和欺诈检测,32GB内存的部署需求使设备成本降低60%,同时确保金融数据不外流,符合行业监管要求。

工业质检辅助

通过分析设备图像与传感器数据,模型能在生产线上辅助识别异常部件,部署在边缘设备上实现实时分析,提升质检效率并降低人力成本。

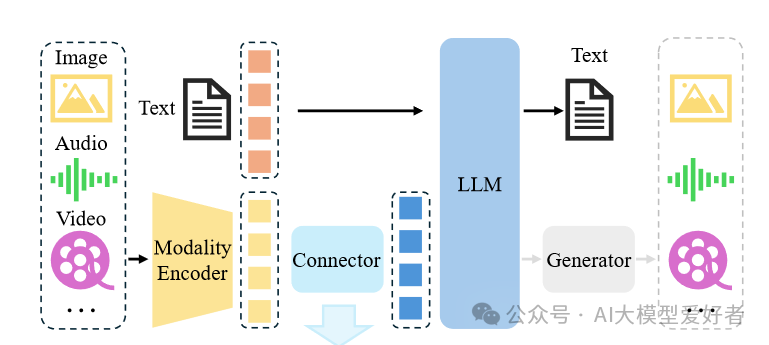

该图为企业大模型应用落地路径的架构图,展示了三种主流路径:模型推理、模型应用效果优化(含提示词优化、模型精调、模型能力增强)及大模型应用开发。Magistral Small 1.1正处于模型推理这一核心环节,为企业提供高效可靠的推理能力支持。

使用指南与最佳实践

推荐参数设置

top_p: 0.95temperature: 0.7max_tokens: 40960

系统提示模板

First draft your thinking process (inner monologue) until you arrive at a response. Format your response using Markdown, and use LaTeX for any mathematical equations. Write both your thoughts and the response in the same language as the input.

Your thinking process must follow the template below:[THINK]Your thoughts or/and draft, like working through an exercise on scratch paper. Be as casual and as long as you want until you are confident to generate the response. Use the same language as the input.[/THINK]Here, provide a self-contained response.

部署框架支持

Magistral Small 1.1可通过多种框架部署:

- vLLM (推荐): 实现生产级推理管道

- Transformers: 适合研究和开发

- llama.cpp: 提供GGUF格式量化版本

- lmstudio: 支持GGUF和MLX格式

总结与建议

Magistral Small 1.1以240亿参数实现了推理能力与部署灵活性的平衡,代表了2025年轻量级AI模型的发展方向。对于企业决策者,现在正是评估这一技术的最佳时机:

- 场景优先级评估:优先在智能客服、内部知识库、产品质量检测等场景进行试点

- 硬件资源规划:基于32GB内存/单张RTX 4090的基准配置,评估现有IT资源可支持度

- 数据安全合规:结合行业监管要求,制定本地化部署的数据治理方案

企业可通过Gitcode仓库获取模型(https://gitcode.com/hf_mirrors/mistralai/Magistral-Small-2507),结合自身业务场景进行测试。在数据隐私日益重要的今天,掌握本地化推理AI能力,将成为保持竞争力的关键。

随着轻量级模型性能的不断提升,我们有理由相信,未来1-2年内,中小企业将迎来AI应用的普及浪潮,而Magistral Small 1.1正是这一趋势的重要推动者。

【免费下载链接】Magistral-Small-2507

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考