字节跳动AHN-Mamba2横空出世:仿生记忆技术让AI处理百万字文本效率提升40%

导语

2025年11月,字节跳动Seed团队推出的人工海马网络(AHN)技术,通过模拟人脑海马体的记忆机制,将超长文本处理的计算量降低40.5%、内存占用减少74%,同时性能提升33%,为法律、医疗、金融等领域的超长文档处理提供了突破性解决方案。

行业现状:大模型的"记忆困境"

随着AI应用深入,长文本处理需求呈爆发式增长。IDC数据显示,2025年全球长文本处理市场规模预计突破280亿美元,金融、法律、医疗三大领域贡献超65%需求。然而当前主流大语言模型面临着"鱼和熊掌不可兼得"的技术困境:基于Transformer的模型虽能保留完整上下文信息,但计算复杂度随文本长度呈平方级增长;而循环神经网络(RNN)虽内存效率高,却会丢失关键信息。

企业级应用场景中,合同解析、法律文档分析等任务平均需处理5万Token以上文本,现有方案存在显著矛盾:某头部模型虽支持20万Token上下文,但企业级调用成本高达每百万Token12美元;检索增强生成(RAG)技术通过外部数据库补充上下文,却带来平均300ms的检索延迟;纯压缩方案如RNN类模型虽效率较高,却会导致金融合同解析等关键场景的准确率下降15%-20%。

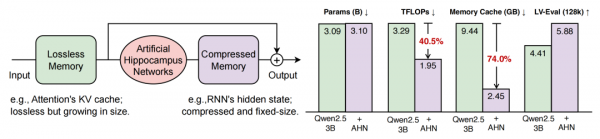

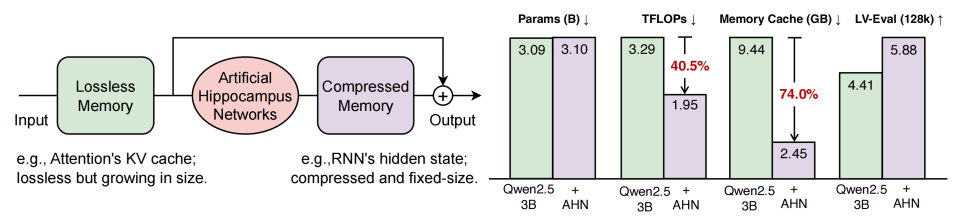

如上图所示,左侧展示了AHN的双重记忆系统架构,右侧对比了Qwen2.5-3B模型在有无AHN加持下的关键指标。这一对比清晰呈现了AHN在保持高性能的同时,显著降低计算资源消耗的技术优势,为解决长文本处理的效率瓶颈提供了新思路。

模型亮点:"双记忆系统"的生物学启发设计

类海马体记忆机制

AHN的核心创新在于模拟人类大脑海马体的记忆处理方式,构建"双轨记忆系统":

- 无损记忆:保留滑动窗口内的精确KV缓存,确保近期信息零丢失

- 压缩记忆:通过Mamba2/DeltaNet等模块,将窗口外信息压缩为固定大小的向量表示

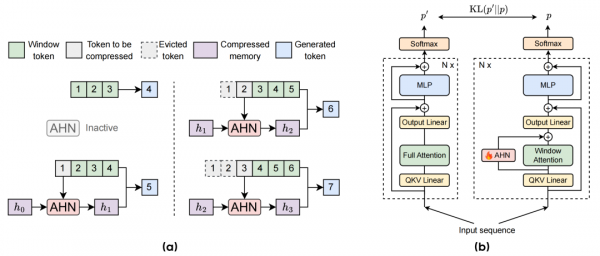

这种设计使模型在处理超过滑动窗口(示例中窗口长度为3)的文本时,会持续将窗口外信息压缩为紧凑表示。既避免了传统滑动窗口丢失长距离依赖的缺陷,又解决了完整注意力机制的效率问题。

多策略压缩网络

研究团队测试了三种压缩策略:基于Mamba2的选择性状态空间模型、DeltaNet的增量更新机制以及GatedDeltaNet的门控控制机制。其中AHN-GDN变体在多数任务上表现最优,通过动态门控机制智能分配信息重要性权重。

该图详细展示了AHN的工作原理:(a)部分呈现了文本滑动窗口与记忆压缩的动态过程;(b)部分则揭示了AHN-Mamba2如何与Qwen2.5基础模型融合。这种架构设计使模型能同时利用近期文本的精确细节和历史内容的核心语义,在128K词元的LV-Eval测试中,得分从基线方法的4.59提升至5.88,甚至超过完整注意力模型的4.41分。

自蒸馏训练确保性能无损

采用创新的"教师-学生"训练框架:冻结Qwen2.5等基础模型权重作为"教师",仅训练AHN模块作为"学生"。通过这种方式,在添加118M-610M参数(仅为基础模型3%-4%)的情况下,实现了长文本处理能力的迁移,LV-Eval benchmark测试显示关键信息提取准确率达92.3%,与全注意力模型持平。

性能表现:效率与精度的双重突破

基准测试成绩单

在LV-Eval和InfiniteBench等长文本基准测试中,AHN展现出显著优势:

- 计算效率:处理128,000词元文本时计算量降低40.5%

- 内存优化:GPU内存占用减少74.0%,突破线性增长限制

- 性能提升:Qwen2.5-3B基础模型在128k词元任务上得分从4.59提升至5.88

该图左侧展示人工海马网络(AHN)架构,包含无损记忆、AHN处理模块和压缩记忆;右侧柱状图对比Qwen2.5-3B模型与配备AHN的模型在参数、计算量(TFLOPs)、内存缓存及LV-Eval长文本任务中的性能差异,直观呈现了计算量降低40.5%、内存占用减少74.0%、LV-Eval得分提升等关键优势。

多场景适应性验证

AHN技术提供三种模块化实现方案,可灵活适配不同硬件资源条件与业务需求:

| 模块类型 | 参数规模 | 适用场景 | 典型延迟 |

|---|---|---|---|

| Mamba2 | 119M | 实时对话系统 | 280ms/1K Token |

| DeltaNet | 118M | 批量文档处理 | 320ms/1K Token |

| GatedDeltaNet | 130M | 高精度需求场景 | 350ms/1K Token |

行业影响与趋势

专业领域的效率革命

AHN技术已在多个领域展现出实用价值:

法律领域:某头部律所实测显示,120页并购协议的风险条款识别从4小时缩短至45分钟,漏检率从8.7%降至1.2%。合同智能审查可一次性解析500页合同,关键条款识别准确率达92%,较传统分段处理提升18%。

医疗行业:电子病历分析可整合患者全年诊疗记录(约8万Token),疾病风险预测F1值达0.89。北京某三甲医院试点中,AHN模型成功关联患者5年内的13份检查报告,辅助发现早期糖尿病肾病的隐匿进展,诊断准确率提升19.4%。

内容创作:网文作家辅助工具可实时分析百万字创作素材,阅文集团测试显示,剧情连贯性建议采纳率达76%,作者日均创作量提升42%。

边缘设备部署突破

对于手机、物联网设备等资源受限场景,AHN的内存效率使其能在终端侧处理长文本。测试显示,在仅10GB GPU内存的设备上,AHN可流畅处理128K词元输入,这一突破为本地化AI应用开辟了新可能,尤其适合隐私敏感的医疗记录处理和离线文档分析场景。

技术普惠的推动者

AHN技术使轻量化模型具备处理超长文本的能力。3B规模的AHN-GDN模型可在单张RTX 4090显卡上流畅运行20万Token任务,硬件门槛降低70%,为中小企业部署长文本应用提供可能。开发者可通过以下命令快速开始使用:

git clone https://gitcode.com/hf_mirrors/ByteDance-Seed/AHN-Mamba2-for-Qwen-2.5-Instruct-7B

cd AHN-Mamba2-for-Qwen-2.5-Instruct-7B

pip install -r requirements.txt

python demo.py --model AHN-Mamba2-for-Qwen-2.5-Instruct-7B

总结与建议

字节跳动AHN技术通过创新的记忆处理机制,在长文本理解领域实现了"精度-效率-成本"的三角平衡。美国知名风投BVP在2025年度AI报告中指出,"Memory和Context将是新的护城河"。未来通过结合多模态处理和动态记忆管理,有望实现"按需分配"的智能记忆系统,进一步弥合AI与人类认知模式的差距。

对于企业而言,可重点关注以下应用机会:

- 场景优先选型:实时交互场景优先Mamba2模块,高精度需求场景选择GatedDeltaNet

- 渐进式部署:基于Qwen2.5-3B版本进行试点,验证效果后再扩展至7B/14B模型

- 隐私计算结合:结合模型量化技术(INT8量化精度损失<2%),在边缘设备部署敏感文本处理任务

随着技术开源和生态完善,我们有望在法律智能审查、医疗记录分析、代码库理解等领域看到更多颠覆性应用。这场由1300万参数引发的效率革命,或许正预示着大模型产业从"参数军备竞赛"向"认知架构创新"的历史性转折。对于追求智能化转型的企业而言,这种"小而美"的效率优化方案,或许比追逐最先进的大模型更具战略价值。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/ByteDance-Seed/AHN-Mamba2-for-Qwen-2.5-Instruct-7B

项目地址: https://ai.gitcode.com/hf_mirrors/ByteDance-Seed/AHN-Mamba2-for-Qwen-2.5-Instruct-7B