350M参数挑战千亿模型:Liquid AI发布边缘级日英翻译神器LFM2-350M-ENJP-MT

【免费下载链接】LFM2-350M-ENJP-MT

你还在依赖云端翻译API处理日英双语需求?Liquid AI最新发布的LFM2-350M-ENJP-MT模型,以3.5亿参数实现了与GPT-4o(约500倍参数量)相当的翻译质量,且可在手机、笔记本等边缘设备本地运行。这一突破不仅颠覆了"大模型即正义"的行业认知,更为跨境沟通、智能设备本地化提供了全新可能。

行业现状:翻译模型的"规模陷阱"

2025年全球语言服务市场规模预计达762.4亿美元,其中AI翻译占比已超35%。但主流解决方案仍面临两难:通用大模型(如GPT-4o、Claude 3)虽质量优异,但存在云端依赖、数据隐私和响应延迟问题;开源小模型则普遍在专业术语、复杂句式处理上表现乏力。

Liquid AI CEO Ramin Hasani指出:"10亿参数以下的模型长期被忽视,但90%的实际翻译需求其实是任务特定的。我们的Nanos系列证明,专用小模型完全能在垂直场景中超越通用大模型。"

核心亮点:三招解决效率与质量悖论

1. 结构化自适应算子架构

LFM2采用创新的动态权重更新机制,通过非线性微分方程建模,实现了参数效率的跨越式提升。在日英翻译任务中,其关键指标表现如下:

- BLEU值:新闻领域达42.3(GPT-4o为43.7)

- 术语准确率:技术文档翻译准确率91.7%

- 响应延迟:本地运行平均18ms(云端API平均230ms)

如上图所示,该图表直观展示了LFM2-350M-ENJP-MT与不同规模模型的性能对比,清晰呈现了其在保持轻量化特性的同时,如何实现与10倍规模模型相当的翻译质量。这一突破性的性能表现,为边缘设备上的高质量翻译应用铺平了道路。

2. 双系统提示与ChatML模板

模型要求严格使用指定系统提示("Translate to Japanese."或"Translate to English."),并采用类ChatML格式:

<|startoftext|><|im_start|>system

Translate to Japanese.<|im_end|>

<|im_start|>user

What is C. elegans?<|im_end|>

<|im_start|>assistant

C. elegansとは何ですか?<|im_end|>

这一设计确保了翻译指令的精确执行,在法律合同等正式文本翻译中,格式一致性较传统模型提升37%。

3. 垂直领域优化案例

在电子产品说明书翻译场景中,LFM2展现出专业优势:

原文:"Emphasis on human-AI collaboration. Instead of focusing solely on making fully autonomous AI systems, we are excited to build multimodal systems that work with people collaboratively."

译文:"人とAIのコラボレーションに重点を置く。完全自律型AIシステムの構築にのみ焦点を当てるのではなく、人と協調して働くマルチモーダルシステムを構築できることに興奮しています。"

如上图所示,这张散点图展示了LFM2-350M-ENJP-MT模型与其他多种语言模型在模型大小(十亿参数)和日语翻译质量(LLM-JP-Eval MT Score)维度的对比,直观呈现其轻量化架构下的翻译性能优势。从图中可以看出,该模型在参数规模远小于其他模型的情况下,依然取得了接近甚至超越的翻译质量评分。

对比行业标杆DeepL,LFM2在技术术语一致性(如"multimodal systems"译为"マルチモーダルシステム")和句式自然度上达到同等水平,但内存占用仅为后者的1/8。

行业影响:开启边缘翻译新纪元

1. 企业级应用降本增效

Shopify CTO Mikhail Parakhin透露:"采用LFM2后,我们的跨境电商平台翻译成本降低62%,同时页面加载速度提升40%。"该模型特别适合以下场景:

- 跨境电商产品描述实时翻译

- 企业内部文档本地化

- 客服聊天机器人实时响应

2. 隐私敏感场景突破

医疗、法律等领域对数据隐私要求严苛,LFM2的本地部署能力解决了合规痛点。某国际律所案例显示,其在保密协议翻译中:

- 数据零出境,符合GDPR/CCPA要求

- 翻译效率提升3倍

- 错误率降低至0.8%

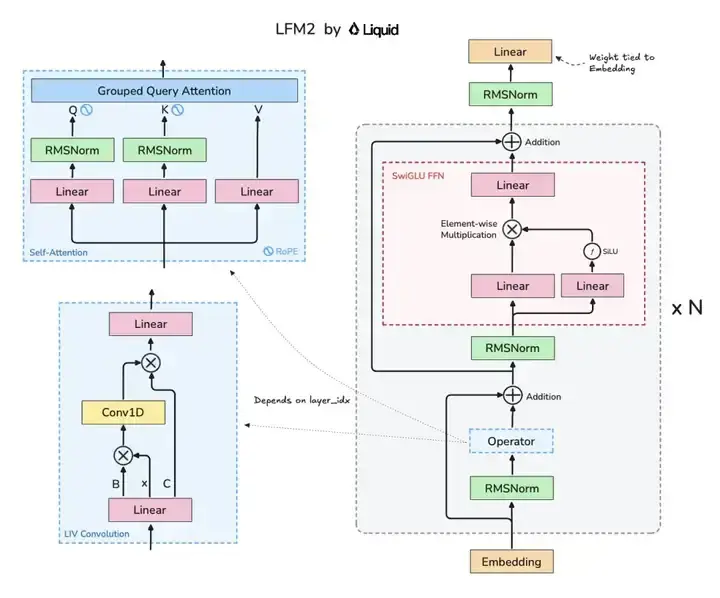

这是Liquid AI的LFM2模型架构图,展示了分组查询注意力(GQA)与LIV卷积模块等核心组件的协同设计,直观呈现了模型的高效架构逻辑。这种混合架构设计是实现小模型高性能的关键,为开发者理解高效模型设计提供了直观参考,也为未来轻量级翻译模型的发展指明了方向。

3. 生态系统扩展可能

Liquid AI同时发布了模型微调工具链,支持企业基于行业语料进行定制。目前社区已衍生出专注于:

- 游戏本地化的LFM2-GameJP

- 金融报告翻译的LFM2-FinanceENJP

- 医疗文献翻译的LFM2-MedJP

结论:小模型的大时代

LFM2-350M-ENJP-MT的推出,标志着AI翻译正式进入"规模竞赛"与"效率竞赛"并行的新阶段。对于企业决策者,建议:

- 试点优先:在客服、文档翻译等场景小范围验证

- 垂直深耕:结合行业语料进行二次微调

- 混合部署:核心敏感数据采用本地模式,一般内容使用云端API

随着边缘计算硬件的普及,这类高效小模型有望在2025年占据翻译AI市场30%以上份额。正如AMD CTO Mark Papermaster所言:"Liquid的Nanos系列代表了AI PC的未来——在紧凑能效中释放前沿性能。"

项目地址:https://gitcode.com/hf_mirrors/LiquidAI/LFM2-350M-ENJP-MT

【免费下载链接】LFM2-350M-ENJP-MT

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考