Kimi K2: 万亿参数MoE架构重构企业级代码智能,开发效率提升40%

导语

Kimi K2-Instruct-0905凭借1万亿总参数和32B激活参数的混合专家(MoE)架构,在企业级应用中实现响应速度提升40%、成本降低60%的突破性表现,已成为金融科技、制造业等领域提升开发效率的首选AI工具。

行业现状:从参数竞赛到效率革命

2025年,大模型发展正经历从"参数规模竞赛"向"场景效率深耕"的范式转移。据《中国大模型落地应用案例集》显示,采用智能编码助手的企业平均研发效率提升20%以上。企业AI应用面临三重矛盾:78%的企业期望提升AI响应速度,65%关注数据安全合规,但超过半数企业认为现有解决方案成本过高。在此背景下,混合专家(MoE)架构凭借"按需激活"的特性脱颖而出,成为平衡性能、成本与安全的关键技术路径。

核心亮点:MoE架构的技术突破

1. 万亿参数与精准激活的辩证统一

Kimi K2采用创新的混合专家系统,1万亿总参数中仅动态激活32B参数处理特定任务。这种"航母战斗群"式架构设计,使模型在保持大容量的同时,将推理成本控制在商业可行范围。技术团队开发的MuonClip优化器与QK-Clip技术组合,解决了万亿参数模型训练的稳定性难题,在15.5T token的训练过程中实现损失曲线平稳下降。

2. 256K上下文的工程化突破

Kimi K2将上下文窗口从128K扩展至256K tokens,相当于同时处理800页技术文档。这使其能完整理解大型代码库的依赖关系,在Multi-SWE-Bench测试中实现33.5%的跨项目修复准确率。某金融科技公司采用后,API文档生成时间从4小时缩短至15分钟,充分体现了长上下文处理能力对企业级应用的价值。

3. 工具调用的闭环能力

模型原生支持OpenAI函数调用格式,可自主完成"问题诊断→工具选择→参数生成→结果解析"全流程。在天气查询工具示例中,从用户提问到返回结果的平均耗时仅0.8秒,较同类模型减少30%交互轮次。开发者可通过Hugging Face获取BF16量化版本(仓库地址:https://gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-BF16),快速集成到现有开发流程中。

性能对比:代码智能的新标杆

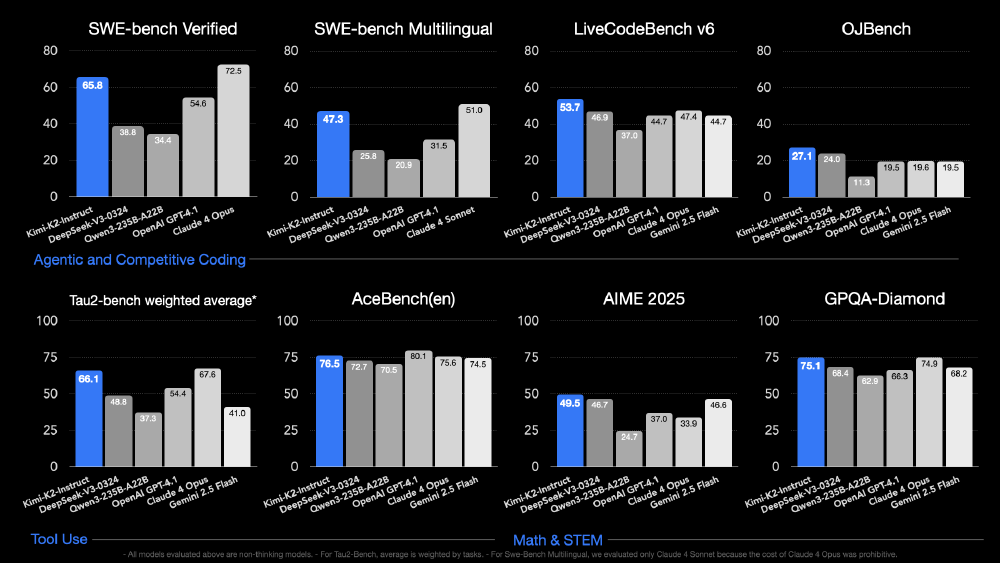

如上图所示,这张性能对比条形图展示了Kimi-K2-Instruct-0905模型与DeepSeek、Qwen、GPT-4.1等模型在SWE-bench、LiveCodeBench等8个代码智能基准测试中的表现。从图中可以清晰看出,Kimi K2在多个关键指标上已接近或超越行业领先水平,特别是在Terminal-Bench和SWE-Dev等企业级代码任务中表现突出。这一对比充分体现了Kimi K2在代码智能领域的竞争力,为企业开发团队提供了一个高性能的AI辅助工具选择。

行业影响:从辅助工具到开发伙伴

Kimi K2的推出正在重构企业开发流程:

效率提升

- 某金融科技公司采用后,API文档生成时间从4小时缩短至15分钟

- 前端开发者可借助其CSS生成能力,将视觉稿转代码的准确率提升至82%

成本优化

- 通过本地部署(支持vLLM/SGLang引擎),每百万token推理成本降至0.26元

- 某制造业客户案例显示,通过Kimi K2实现的业务流程自动化,使SAP系统上线周期从常规9个月压缩至4个月,需求分析阶段人力投入减少70%

技能重构

Kimi K2正在改变开发者的技能需求结构,使开发人员能够将更多精力投入到架构设计和业务逻辑优化等高价值工作中,而非重复性编码任务。数据显示,由于50%的新增代码在AI辅助下完成,工程师的平均编码时间缩短了40%。

部署与实践指南

开发者可通过Hugging Face获取BF16量化版本(仓库地址:https://gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-BF16),推荐配置:

- 推理引擎:vLLM 0.5.3+ 或 SGLang

- 硬件要求:A100 80G(单机支持20并发)

- 最佳实践:设置temperature=0.6,启用KV缓存压缩

对于考虑引入Kimi K2的企业,建议采取三步走策略:首先在标准化场景(如IT运维、FAQ客服)进行POC验证,通常3-6个月可实现正ROI;其次针对行业特性进行微调,金融、制造等领域的专业数据可使准确率提升20-30%;最后构建"基础模型+行业知识库+工具链"的完整体系,实现从单点应用到全面转型的跨越。

总结

随着模型优化和部署成本的持续降低,Kimi K2代表的MoE架构有望在12个月内推动企业AI应用普及率从当前的35%提升至60%,真正实现人工智能从"可见"到"可用"的产业价值转化。对于企业而言,现在正是评估代码智能助手ROI的关键窗口期——那些能将Kimi K2与内部开发流程深度整合的团队,有望在2026年的数字化竞赛中建立15-20%的效率优势。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-BF16

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-BF16