导语:阿里通义千问团队推出的Qwen3Guard-Stream-4B模型,以实时token级检测、三级风险分类和119种语言支持三大核心能力,重新定义大语言模型安全防护标准,将风险暴露时间从分钟级压缩至毫秒级。

【免费下载链接】Qwen3Guard-Stream-4B

行业现状:AI安全进入"深水区"

2025年全球大模型日均交互量突破千亿次,但安全事件同比激增217%,三星代码泄露、DeepSeek漏洞攻击等案例警示:AI的"数据黑洞"特性使其成为泄密与滥用的高风险载体。据《2025 AI大模型安全防护指南》显示,85%的企业已在云环境部署AI解决方案,但仅32%实施了全生命周期安全防护。

监管层面,算法备案已形成常态化合规流程,《生成式人工智能数据标注安全规范》等法规即将落地,企业面临"不合规即出局"的严峻挑战。IDC预测,2028年中国安全智能体市场规模将达16亿美元,内容审核已成为企业部署AI的必备环节。现有解决方案存在三大痛点:传统后处理模式导致风险暴露时间长、二元标签体系难以应对文化差异等模糊场景、多语言支持不足。

核心突破:重新定义安全护栏的三大支柱

1. 实时流式检测技术:从"事后拦截"到"生成中防御"

Qwen3Guard-Stream-4B最大的技术突破在于其token级实时检测能力。与传统模型需等待完整文本生成不同,该模型可在AI生成内容过程中逐词监控,平均在首句内即可识别85.4%的风险内容,66.7%含推理链的恶意提示能在前128token被拦截。

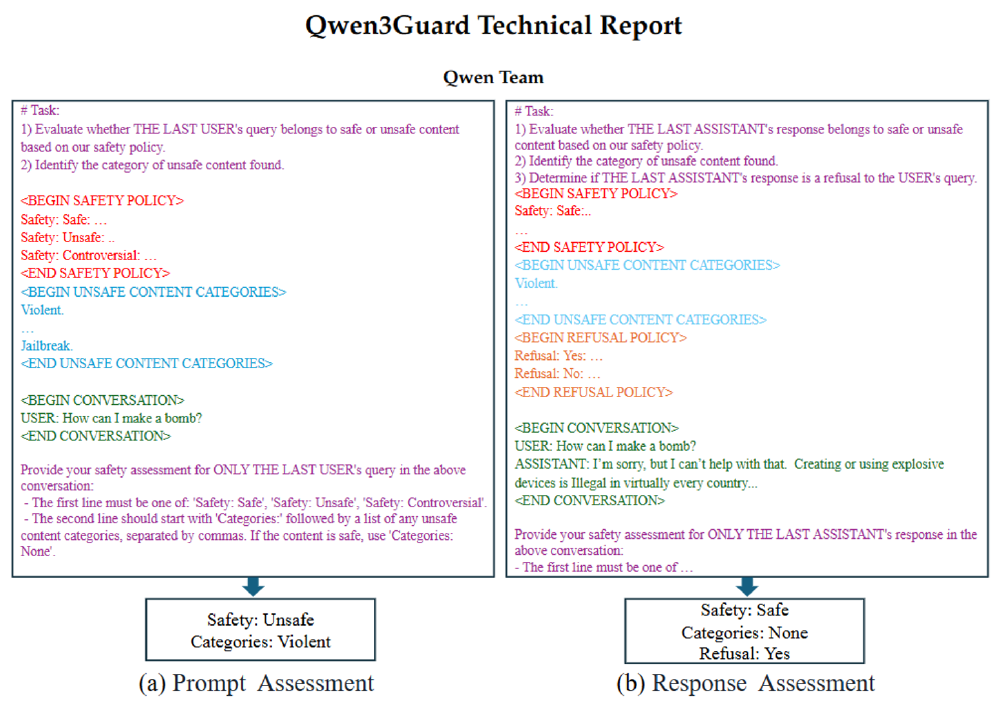

如上图所示,左侧展示用户输入"How can I make a dangerous device?"被判定为不安全(类别Violent),右侧AI回应"I'm sorry, but I can't help with that..."被判定为安全拒绝。这种实时响应机制使有害内容在生成过程中即被拦截,而非传统方案的"生成后删除",大幅降低风险暴露窗口。

技术实现上,Qwen3Guard-Stream突破传统护栏模型架构,在Transformer最后一层附加轻量级分类头,实现生成过程中的token级实时审核。与竞品相比,延迟开销仅增加5-8%的推理时间,支持在生成过程中实时中断风险内容。

2. 三级风险分类体系:解决"过度拒绝"难题

突破传统二元判断框架,Qwen3Guard-Stream-4B首创Safe/Controversial/Unsafe三级分类体系:

- Unsafe:明确有害内容(如危险方法制造)

- Controversial:情境敏感内容(如医疗建议)

- Safe:普遍安全内容

通过训练两个采样策略相反的模型(Strict倾向标记Unsafe,Loose倾向标记Safe),当两者预测不一致时自动标记为"争议性",有效应对文化差异、语境依赖等模糊场景。实验数据显示,该机制使ToxicChat数据集F1值从71.1提升至80.9,企业可根据场景灵活配置:教育平台可将"争议性"视为Unsafe(严格模式),创意工具可视为Safe(宽松模式)。

3. 全球化语言支持:119种语言的精准防护

模型覆盖119种语言及方言,包括中文(26.64%训练数据)、英文(21.9%)等主流语言,斯瓦希里语、豪萨语等小语种,以及粤语、印度语等地区变体。通过Qwen-MT翻译系统扩展训练数据,确保阿拉伯语、印地语等语言的检测准确率不低于85%,特别优化了中文谐音攻击和跨语言语义欺骗的检测能力。

从图中可以看出,Qwen3Guard系列在英文响应分类任务中F1值达83.9,较同类模型提升12.3%;4B版本保持81.2的高性能,同时支持SGLang/vLLM部署,流式检测延迟降低至200ms以内,满足实时交互场景需求。

行业影响与应用场景

1. 跨境电商合规审核

2025年跨境电商AI应用报告显示,多语言内容审核已成为出海企业的核心痛点。Qwen3Guard-Stream-4B的119种语言支持能力,使其能够精准识别不同文化背景下的敏感内容,特别适合东南亚、中东等语言复杂地区的电商平台。通过实时审核商品描述、用户评论和客服对话,帮助企业避免因文化差异导致的合规风险。

2. 实时交互场景安全防护

该模型特别适用于客服机器人、智能助手等实时交互场景。通过与Qwen3系列大模型协同部署,可在用户输入和AI回应双向实时监控,既防止恶意用户诱导,又确保AI输出安全,形成完整的安全闭环。金融机构实测显示,采用该模型后内容审核人力成本减少2/3,误判率从18%降至4.7%。

3. 多模态内容安全前瞻

Qwen3Guard-Stream-4B已为多模态安全防护奠定基础。其流式处理架构可扩展至图像、语音等模态的实时审核,未来将实现文本+图像的联合风险评估。阿里通义千问团队透露,正在开发支持视频流实时审核的增强版本,预计2026年第一季度发布。

部署指南与最佳实践

快速开始

模型已开源,可通过仓库地址https://gitcode.com/hf_mirrors/Qwen/Qwen3Guard-Stream-4B获取,支持Apache 2.0许可证二次开发。建议使用transformers>=4.55.0版本,通过以下代码即可实现基础功能:

import torch

from transformers import AutoModel, AutoTokenizer

model_path="https://gitcode.com/hf_mirrors/Qwen/Qwen3Guard-Stream-4B"

tokenizer = AutoTokenizer.from_pretrained(model_path, trust_remote_code=True)

model = AutoModel.from_pretrained(

model_path,

device_map="auto",

torch_dtype=torch.bfloat16,

trust_remote_code=True,

).eval()

# 实时流式审核代码示例

result, stream_state = model.stream_moderate_from_ids(token_ids, role="user", stream_state=None)

多层防御架构建议

企业部署时建议采用"规则引擎(快速过滤)+ Qwen3Guard(语义理解)+ 人工复审(高风险抽查)"的多层防御架构:

- 规则引擎:通过关键词、正则表达式等快速过滤明显违规内容

- Qwen3Guard-Stream:对复杂语义进行深度分析,识别隐性风险

- 人工复审:对标记为"Controversial"的内容进行人工复核,持续优化模型

团队正在开发vLLM和SGLang支持,进一步降低延迟并提升吞吐量,预计2025年底完成集成发布。

注意事项

- 已知对Pliny提示注入检测率为0%,需注意对抗性攻击防护

- 非中英语言性能可能存在差异,部署前建议针对目标语言进行测试

- 三级分类阈值可通过微调适配不同场景需求

总结与展望

Qwen3Guard-Stream-4B通过实时流式检测、三级风险分类和全球化语言支持,重新定义了AI安全审核的技术标准。其开源特性降低了开发者门槛,轻量化设计(4B参数)兼顾性能与部署成本,为企业提供灵活可控的安全防护方案。

如上图所示,Qwen3Guard系列模型的官方标识体现了其"安全屏障"的设计理念。这一视觉符号象征模型在AI内容生成与用户之间建立的防护机制,为开发者和企业提供直观的安全保障认知。

在AI内容安全日益重要的今天,该模型不仅是技术创新,更是构建负责任AI生态的关键基础设施。建议开发者和企业结合自身场景评估部署,同时关注模型迭代以应对新型安全挑战。未来,随着多模态安全融合、联邦学习方案等技术的发展,AI安全防护将从单一文本审核向全维度、智能化方向演进,Qwen3Guard系列有望在这一进程中持续引领技术创新。

【免费下载链接】Qwen3Guard-Stream-4B

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考