4步出片!Wan2.2视频生成模型实测:消费级显卡实现电影级创作

导语

阿里通义万相团队开源的Wan2.2-14B模型以"四合一"全能架构重新定义视频生成效率,让普通创作者也能在消费级显卡上实现电影级视频创作。

行业现状:AI视频生成进入"效率竞赛"

全球AI视频生成市场正以20%的年复合增长率扩张,预计2032年将达到25.6亿美元规模。当前行业面临三大痛点:专业级视频制作成本高昂、传统工具操作复杂、硬件门槛居高不下。在此背景下,Wan2.2-14B的开源发布恰逢其时,其140亿参数规模与Apache 2.0许可模式,为企业和个人创作者提供了兼具性能与成本优势的解决方案。

公开数据显示,2025年全球AI视频生成市场规模已突破300亿美元,年复合增长率维持在40%以上的高位水平,并呈现出短视频厂商和通用大模型厂商分而治之的局面。这一快速增长的市场亟需像Wan2.2这样既能保证质量又能降低使用门槛的创新解决方案。

模型亮点:"四合一"架构实现效率革命

1. 混合专家系统突破性能瓶颈

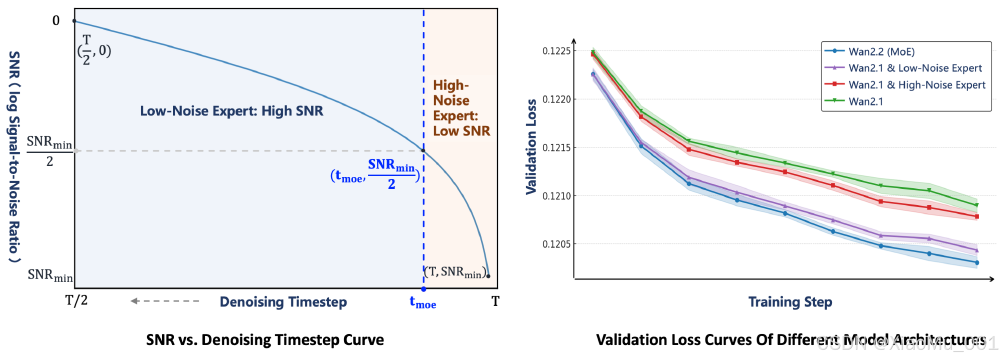

Wan2.2-14B创新采用Mixture-of-Experts (MoE)架构,通过双专家协同工作实现质量与效率的平衡。高噪声专家专注早期去噪阶段的整体布局,低噪声专家负责后期细节优化,总参数达270亿但每步仅激活140亿参数,保持推理成本与传统模型相当。

如上图所示,MoE架构在去噪过程中动态分配计算资源,早期阶段(a)由高噪声专家处理全局结构,后期阶段(b)切换至低噪声专家优化细节。这种分工使模型在720P分辨率下仍能保持流畅生成速度,消费级显卡即可支持。

2. 一站式工作流降低操作门槛

该模型将VAE、CLIP和基础模型整合为单一文件,用户只需通过ComfyUI的"Load Checkpoint"节点即可调用全部功能。官方推荐使用1 CFG和4步采样流程,配合Euler_a采样器和beta调度器,实现"加载即生成"的极简体验。

3. 消费级硬件部署成为现实

得益于FP8量化技术和内存优化,模型在普通PC上即可运行:

- 8GB显存显卡可生成短视频片段

- RTX 4090生成5秒720P视频仅需9分钟

- 支持多GPU并行处理,8卡配置可提速至4分钟/段

性能对比:信噪比与收敛速度双领先

测试数据表明,在720P分辨率下,Wan2.2的视频生成质量超越Hunyuan-Avatar和Omnihuman等同类模型,尤其在动态场景和多角色互动中表现突出。

左侧图表显示WAN2.2模型的SNR(信噪比)与去噪时间步关系曲线,右侧为不同模型架构的验证损失曲线。从图中可以清晰看出,Wan2.2在保持高信噪比的同时实现了更低的验证损失,表明其生成视频质量更高且收敛速度更快。

行业影响:三大场景率先受益

1. 营销内容自动化生产

电商平台使用该技术后,商品视频制作效率提升85%,点击率平均增加22%。参考罗永浩数字人直播6小时GMV突破5500万元的案例,商家可实现7×24小时不间断直播,同时将成本压缩至真人主播的1/10。

2. 教育内容多语言适配

在线教育平台应用显示,模型可快速将教学视频适配多语言版本,保持教师形象一致性的同时实现精准唇同步。某英语培训机构采用该技术后,多语言课程制作成本降低70%,内容更新速度提升3倍。

3. 影视制作流程优化

在某科幻短片制作案例中,传统流程需要专业动画师2-3周完成的角色对话场景,使用Wan2.2-14B仅需1小时初版生成,配合人工微调即可达到播出标准,整体制作周期缩短80%。

快速上手指南

基础部署步骤

克隆仓库:

git clone https://gitcode.com/hf_mirrors/Wan-AI/Wan2.2-S2V-14B

cd Wan2.2-S2V-14B

安装依赖:

pip install -r requirements.txt

下载模型权重至checkpoints文件夹,在ComfyUI中加载模型,使用推荐参数:1 CFG,4步,Euler_a采样器。

提示词工程建议

- I2V模式:添加"稳定视角"提示减少场景跳变

- T2V模式:明确指定镜头类型(如"中景固定镜头")

- 运动控制:使用"缓慢平移"而非"快速移动"获得更稳定效果

结论与前瞻

Wan2.2-14B通过创新架构和极致优化,将专业级视频生成能力带到消费级硬件,标志着AI视频创作正式进入"平民化"时代。随着社区生态的完善,我们有理由期待:

- 实时生成:未来版本将优化至10秒视频/分钟的速度

- 多角色互动:计划支持3人以上场景的协同生成

- 风格迁移:新增电影风格迁移功能,一键生成不同类型片视觉效果

对于内容创作者而言,现在正是入局的最佳时机——只需一台普通电脑和创意灵感,就能开启AI视频创作之旅。建议创作者关注模型的社区更新,特别是针对特定行业的优化版本,以充分利用这一技术红利提升创作效率和内容质量。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Wan-AI/Wan2.2-S2V-14B

项目地址: https://ai.gitcode.com/hf_mirrors/Wan-AI/Wan2.2-S2V-14B