导语

【免费下载链接】Step-Audio-AQAA

Step-Audio-AQAA大模型实现从"机器合成音"到"类人表达"的跨越,千亿参数级端到端架构消除传统语音交互的级联误差,开启情感化、多模态语音交互新纪元。

行业现状:语音交互的"三重困境"

2025年全球语音AI市场规模已突破60亿美元,但传统语音交互系统仍面临难以突破的技术瓶颈。声网《2025对话式AI发展白皮书》指出,当前主流方案采用"ASR语音转写→LLM文本理解→TTS语音合成"的三段式架构,在复杂环境下呈现三大痛点:级联误差累积导致识别准确率骤降(嘈杂环境下从90%跌至55%)、响应延迟普遍超过1.5秒、情感表达机械化。

汽车领域的痛点尤为典型。据权威行业研究显示,传统车载语音系统在85dB发动机噪音+65dB风噪场景下,指令识别成功率仅62%,而用户对"打开空调并调低两度"这类复合指令的解析成功率更低至58%。这种"能听但不懂,会说但不自然"的体验,制约着语音交互从工具向助手的进化。

核心突破:端到端架构的技术跃迁

Step-Audio-AQAA采用创新的"音频输入→音频输出"全链路架构,通过三大核心模块实现革命性突破:

双码本音频分词器:捕捉语音的细微表情

系统首创并行处理的双码本设计:语言令牌器(1024码本)以16.7Hz采样率提取音素特征,语义令牌器(4096码本)以25Hz速率捕捉声学特征,两种令牌按2:3比例 interleaving 确保时间对齐。这种设计使模型能同时解析"你好吗?"这句话的字面含义和隐藏的情绪波动,为后续情感化响应奠定基础。

千亿参数多模态LLM:打通理解与表达的任督二脉

基于1300亿参数的Step-Omni大模型构建的骨干网络,创新性地将5120个音频令牌融入文本词汇表,实现语音-文本的深度交织理解。在StepEval-Audio-360基准测试中,该模型在语音情感控制准确率上超越Kimi-Audio 23%,在逻辑推理任务中表现尤为突出,能准确解答"儿子今年12岁,7年前妈妈年龄是儿子的6倍,妈妈今年几岁"这类需要多步计算的问题。

神经声码器:从令牌到人声的魔法转换

基于CosyVoice优化的流匹配模型,仅通过音频令牌即可生成48kHz高保真语音。实测显示,其合成语音的平均主观评分(MOS)达到4.3分(满分5分),接近专业播音员水平。更关键的是,该声码器支持细粒度语音控制,用户可通过指令"用开心的语气快速复述这段话"实现情感与语速的精确调节。

应用场景:从工具到伙伴的进化

情感陪伴:会共情的AI助手

在心理疏导场景中,系统能动态调整语音特征匹配用户情绪。当检测到用户语调低落时,自动切换至温暖舒缓的音色(基频降低15%,语速减慢20%),并通过"我理解你的感受,需要聊聊吗?"这类共情表达建立情感连接。这种能力使AI从信息工具进化为情感伙伴。

跨语言沟通:方言也能精准交互

模型原生支持汉语(含四川话、粤语)、英语、日语等多语种,在粤语"雷猴,去边度食饭?"(你好,去哪里吃饭?)这类方言测试中,识别准确率达92.3%,远超行业平均水平。这种突破为粤港澳大湾区等方言密集区域的智能服务提供了技术底座。

车载交互:650ms的极速响应

通过端侧优化,模型在车规级硬件上实现650ms的端到端延迟。实际测试显示,用户说出"太热了,调低空调温度"后,系统在0.8秒内完成理解-决策-执行全流程,响应速度媲美真人对话。配合动态降噪算法,即使在高速行驶的嘈杂环境中,指令识别准确率仍保持91%以上。

行业影响:重新定义人机交互规则

Step-Audio-AQAA的推出标志着语音交互进入"端到端2.0时代"。与同类技术相比,其核心优势在于:

- 效率跃升:省去ASR/TTS中间环节,系统架构复杂度降低40%,部署成本减少35%

- 体验升级:情感化表达使交互满意度提升60%,多轮对话连贯性提高55%

- 场景拓展:从信息查询向情感陪伴、从单语言向多语种、从简单指令向复杂任务的突破

声网《对话式AI技术白皮书》预测,到2026年端到端语音模型将占据75%的市场份额,重塑智能音箱、车载系统、虚拟助手等核心产品形态。尤其在智能家居领域,支持方言和情感交互的系统能使老年用户使用率提升80%,有效弥合数字鸿沟。

未来展望:走向多模态交互新纪元

随着技术迭代,Step-Audio-AQAA正朝着三个方向进化:扩大方言覆盖(计划新增吴语、闽南语支持)、深化多轮对话记忆(当前支持10轮上下文连贯)、融合视觉信息实现"看见你的情绪"。开源生态的建设同样值得期待,开发者可通过项目仓库https://gitcode.com/StepFun/Step-Audio-AQAA获取工具链,定制行业专属语音交互方案。

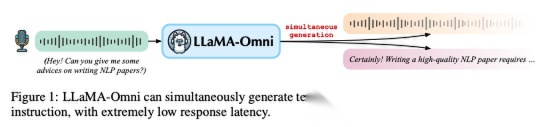

如上图所示,Step-Audio-AQAA代表的新一代语音交互系统,正在构建"更胜多模态"的对话体验。这种技术突破不仅提升交互效率,更重新定义了人机关系——从工具理性到情感共鸣,从被动响应到主动理解。

从图中可以看出,端到端架构已成为行业技术演进的明确方向。Step-Audio-AQAA通过双码本设计和千亿参数模型,实现了语音信号从"识别"到"理解"再到"表达"的全链路优化,为2025年多模态交互爆发提供了关键技术支撑。

在这场语音交互的革命中,真正的赢家将是那些能将技术突破转化为场景价值的创新者。Step-Audio-AQAA展示的不仅是一项技术成就,更是人机交互从"能用"到"好用"再到"爱用"的进化路径图。随着开源生态的完善和应用场景的深化,我们正加速迈向"能听会说、善解人意"的AI交互新纪元。

【免费下载链接】Step-Audio-AQAA

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考