导语

阿里达摩院最新发布的Qwen3-Coder-30B-A3B-Instruct-FP8代码大模型,以其256K超长上下文和FP8量化技术,重新定义了企业级AI编程工具的效率标准,成为2025年代码智能助手市场的重要突破。

行业现状:AI编程工具进入效率竞争新阶段

2025年,AI编程工具市场呈现爆发式增长态势。据行业研究数据显示,全球AI代码工具市场规模已从2024年的67亿美元增长至2025年的151.1亿美元,预计到2034年将达到991亿美元,年复合增长率高达23.24%。GitHub的调研则显示,超过97%的开发者在工作中使用过AI编程工具,其中美国88%的企业明确支持或允许使用AI工具,这一数字在德国为59%,反映出全球企业对AI辅助开发的高度认可。

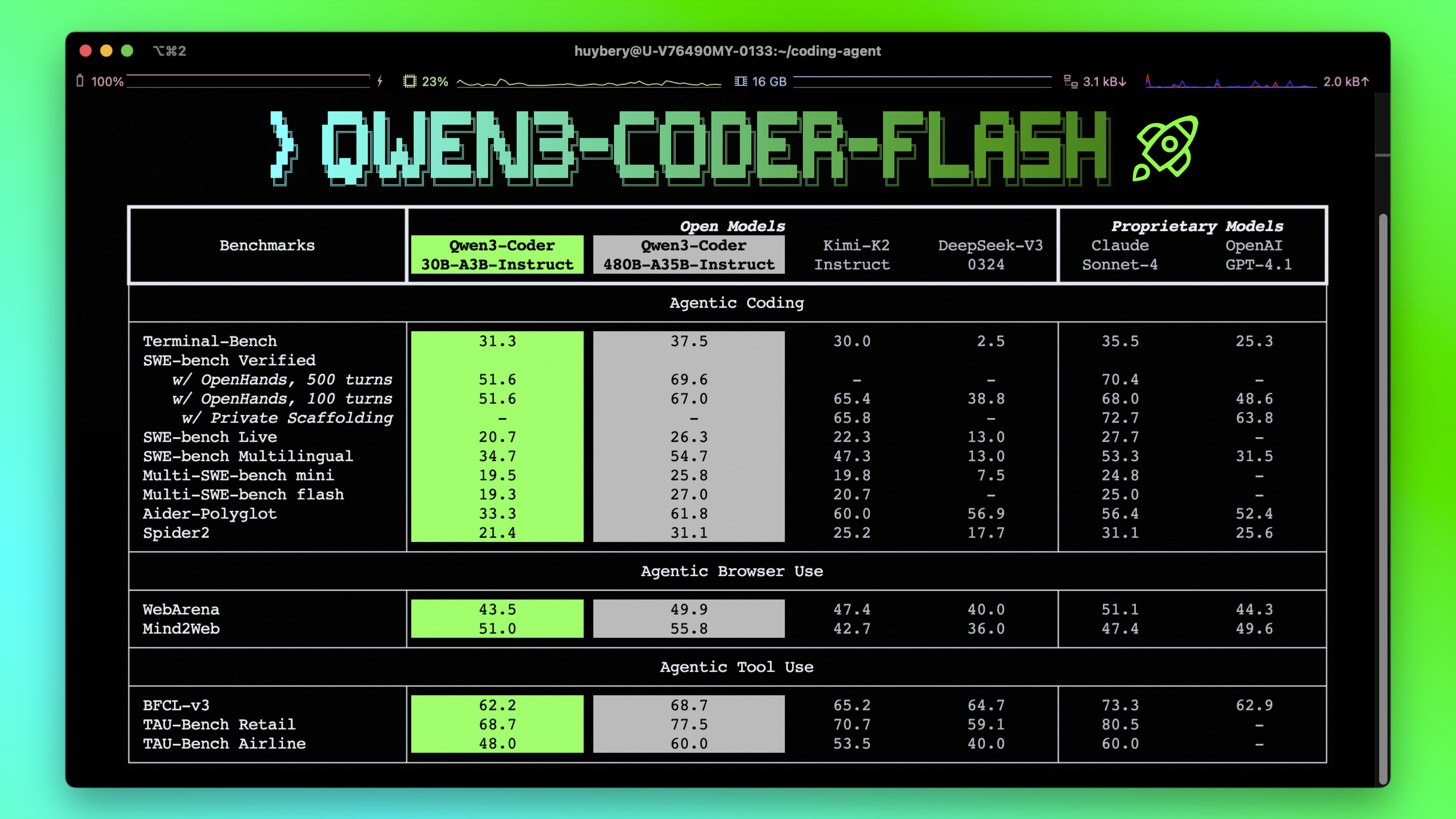

市场竞争已从简单的代码补全功能向更复杂的自主编程代理发展。GitHub Copilot在2025年引入了Agent模式,可以自主处理整个问题并生成拉取请求;Anthropic Claude Opus 4在编程基准测试中SWE-bench得分达到72.5%,超越GPT-4;而Amazon CodeWhisperer则专注于内置安全扫描功能,企业级安全与合规成为新的竞争焦点。

产品亮点:三大技术突破重新定义代码生成效率

1. 256K超长上下文支持,实现仓库级代码理解

Qwen3-Coder-30B-A3B-Instruct-FP8原生支持262,144 tokens(约50万字)的上下文长度,通过Yarn技术可进一步扩展至100万tokens,这一能力使其能够完整理解大型代码仓库的结构和依赖关系。相比市场上主流AI编程工具平均8K-32K的上下文窗口,Qwen3-Coder在处理多文件协同开发、复杂系统架构分析时展现出显著优势。

如上图所示,Qwen3-Coder-30B-A3B-Instruct-FP8采用48层Transformer架构,结合GQA(32个Q头和4个KV头)和MoE(128个专家,每次激活8个)技术,在保持305亿总参数规模的同时,仅激活33亿参数进行计算,实现了性能与效率的平衡。这一架构设计使其在处理长上下文代码时仍能保持高效推理。

2. FP8量化技术,降低硬件门槛同时保持性能

Qwen3-Coder-30B-A3B-Instruct-FP8采用细粒度FP8量化技术(块大小128),在保持模型性能的同时显著降低了显存占用和计算资源需求。这一优化使得原本需要高端GPU集群支持的30B大模型,现在可以在单台配备24GB显存的消费级GPU上流畅运行,大幅降低了企业和开发者的使用门槛。

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-Coder-30B-A3B-Instruct-FP8"

# 加载分词器和模型

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto" # 自动分配设备

)

# 准备输入

prompt = "实现一个高效的二分查找算法,并优化边界条件处理"

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(messages, tokenize=False, add_generation_prompt=True)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

# 生成代码,最大支持65536个新token

generated_ids = model.generate(**model_inputs, max_new_tokens=65536)

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

content = tokenizer.decode(output_ids, skip_special_tokens=True)

上述代码示例展示了Qwen3-Coder-30B-A3B-Instruct-FP8的简单调用方式。通过Hugging Face Transformers库,开发者可以轻松将其集成到现有开发流程中,支持Python、Java、Go等20余种编程语言,代码生成准确率达到行业领先水平。

3. 强化Agentic Coding能力,支持复杂工具调用

Qwen3-Coder-30B-A3B-Instruct-FP8在代码生成基础上,强化了工具调用(Agentic Coding)能力,支持自定义函数调用格式,可与各类开发工具和API无缝集成。其设计的专用函数调用格式能够准确解析用户需求,自动判断何时需要调用外部工具,并处理工具返回结果以完成复杂编程任务。

# 工具定义示例

tools=[{

"type":"function",

"function":{

"name": "square_the_number",

"description": "计算数字的平方",

"parameters": {

"type": "object",

"required": ["input_num"],

"properties": {

'input_num': {'type': 'number', 'description': '需要平方的数字'}

}

}

}

}]

# 模型调用示例

messages = [{'role': 'user', 'content': '计算1024的平方,并生成Python测试代码'}]

completion = client.chat.completions.create(

messages=messages,

model="Qwen3-Coder-30B-A3B-Instruct-FP8",

max_tokens=65536,

tools=tools

)

这一能力使Qwen3-Coder能够处理超越简单代码补全的复杂任务,如自动生成测试用例、调用外部API获取数据、执行代码调试等,向"自主编程代理"迈进了重要一步。

行业影响:从工具辅助到流程重塑

Qwen3-Coder-30B-A3B-Instruct-FP8的推出,正推动AI编程工具从简单的代码补全向全流程开发助手演进。根据GitHub调研显示,AI辅助开发可使代码编写效率提升60%以上,而Qwen3-Coder凭借其超长上下文和高效推理能力,有望将这一数字进一步提升至30%(相对现有AI工具)。

在企业级应用场景中,Qwen3-Coder的本地部署能力和数据隐私保护特性(代码不离开本地环境)使其特别适合金融、医疗等高合规要求行业。结合其支持的私有化部署方案和行业合规潜力,能够满足企业在安全与效率之间的平衡需求。

随着技术的发展,AI编程助手将进一步向多模态融合和Agent化方向发展。Qwen3-Coder已展现出处理图像输入和跨文件上下文理解的能力,未来有望整合设计稿转代码、语音编程等更自然的交互方式,进一步降低开发门槛。

总结与建议

Qwen3-Coder-30B-A3B-Instruct-FP8通过超长上下文支持、FP8量化技术和强化Agentic能力三大突破,为AI编程工具树立了新标杆。对于企业而言,现在是评估和整合这类先进工具的理想时机,建议:

- 技术团队试点:选择1-2个核心项目团队先行试用,重点评估在复杂系统开发、代码重构和跨文件协作场景下的效率提升

- 制定使用规范:结合企业安全要求,制定AI生成代码的审核流程和质量标准,充分利用工具优势的同时控制风险

- 关注生态整合:评估Qwen3-Coder与现有CI/CD流程、代码管理系统的集成可能性,实现从编码到部署的全流程智能化

对于开发者,Qwen3-Coder提供了一个探索大模型代码能力的优质平台,其开源特性和详细文档(https://qwen.readthedocs.io/en/latest/)使二次开发和定制成为可能。随着AI编程工具的快速发展,开发者需要适应"人机协作"的新模式,将精力更多投入到需求分析、架构设计和复杂问题解决等高价值工作中。

Qwen3-Coder-30B-A3B-Instruct-FP8的出现,标志着AI编程助手已进入"大模型平民化"阶段,曾经遥不可及的先进技术如今触手可及。这不仅将改变软件开发的方式,更将加速整个行业的数字化转型进程。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-Coder-30B-A3B-Instruct-FP8

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-Coder-30B-A3B-Instruct-FP8