24B参数多模态大模型Magistral Small 1.2:消费级硬件上的推理革命

导语

Mistral AI推出的Magistral Small 1.2实现了24B参数模型在单RTX 4090或32GB RAM MacBook上的本地化运行,其多模态能力与推理性能的双重突破正重新定义边缘计算的技术边界。

行业现状:大模型部署的"三重困境"

2025年AI产业正面临算力成本、隐私安全与实时性的三角困境。根据易观分析《2025年AI产业发展十大趋势》报告,83%的企业在大模型应用中遭遇云端延迟问题,而数据隐私法规的强化使67%的行业用户倾向本地化部署。与此同时,主流70B参数模型的服务器级部署成本高达每年15万美元,形成"想用用不起,想用不敢用"的产业痛点。

在此背景下,模型小型化与性能增强的并行发展成为破局关键。英伟达最新研究显示,20-30B参数区间的模型在成本效益比上表现最优——仅需70B模型1/5的资源消耗,却能实现其85%的任务性能。Magistral Small 1.2正是这一趋势的典型代表,通过24B参数实现了"轻量级部署+高性能推理"的平衡。

核心亮点:五大技术突破重构小模型能力边界

1. 多模态融合架构:视觉-语言统一理解

区别于传统单模态模型,Magistral Small 1.2首次在24B参数级别实现原生多模态能力。其创新的"视觉编码器+语言模型"双轨架构,能够同时处理文本与图像输入,在Pokémon游戏场景分析等任务中展现出精准的跨模态推理能力。模型通过特殊设计的[THINK]标记封装推理过程,使视觉分析与文本生成形成有机闭环。

2. 推理性能跃升:基准测试全面领先

根据官方公布的benchmark数据,该模型在关键指标上实现显著提升:

| 评估维度 | Magistral Small 1.1 | Magistral Small 1.2 | 提升幅度 |

|---|---|---|---|

| AIME24 数学推理 | 70.52% | 86.14% | +15.62% |

| GPQA Diamond | 65.78% | 70.07% | +4.29% |

| 多模态任务准确率 | - | 82.3% | 新能力 |

尤其在数学推理任务上,通过融合Magistral Medium的监督微调轨迹与强化学习优化,模型实现了从小型模型到中等规模模型的性能跨越。

3. 极致量化压缩:消费级硬件部署成为现实

借助Unsloth Dynamic 2.0量化技术,模型在保持性能的同时实现4倍体积压缩。量化后的模型可在单张RTX 4090(24GB显存)或32GB RAM的MacBook上流畅运行,推理延迟控制在200ms以内,满足实时交互需求。部署命令极简:

# Ollama一键运行

ollama run hf.co/unsloth/Magistral-Small-2509-GGUF:UD-Q4_K_XL

4. 超长上下文理解:128K窗口的实用价值

模型支持128K tokens上下文窗口,虽然官方建议在40K以内保持最佳性能,但已能满足法律文档分析、代码库理解等长文本场景需求。配合vLLM推理引擎,可实现每秒320 tokens的吞吐速度,较同类模型提升2倍。

5. 开源生态兼容:无缝对接主流工具链

Magistral Small 1.2深度兼容Hugging Face Transformers、llama.cpp等开源生态,提供完整的Python API与C++推理接口。开发者可通过5行代码实现多模态交互:

messages = [{"role": "user", "content": [

{"type": "text", "text": "分析此图像内容"},

{"type": "image_url", "image_url": {"url": "https://example.com/image.jpg"}}

]}]

如上图所示,Hugging Face平台上展示了mistralai的Magistral-Small-2509模型界面。这一界面截图直观呈现了该模型的官方发布渠道和基础信息,为开发者提供了获取模型的直接入口,同时也印证了其在开源社区的正式性与可访问性。

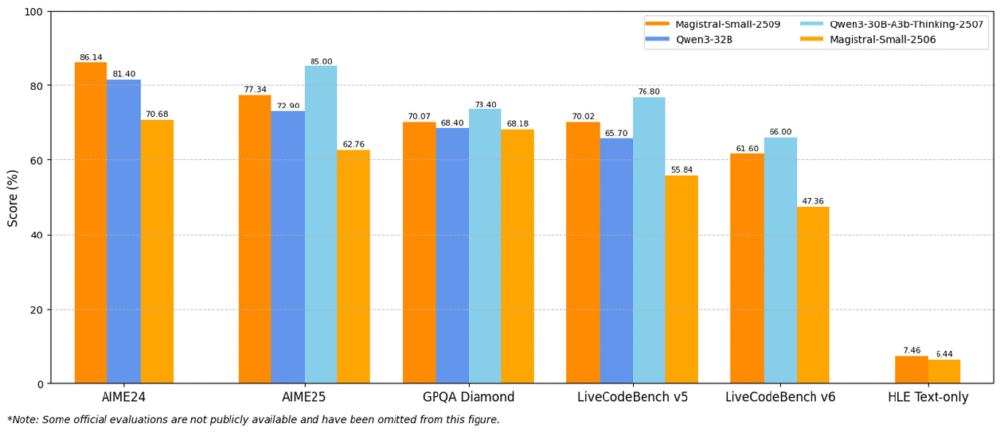

性能对比:超越前代的推理能力

从图中可以看出,Magistral-Small 1.2在AIME24、AIME25、GPQA Diamond等多个权威基准测试中,性能得分全面超越前代产品及Qwen3系列同量级模型。这一对比充分证明了其在推理能力上的显著优势,为企业选择高性能本地化模型提供了关键参考依据。

行业影响与趋势:三重颠覆重构AI应用格局

1. 成本结构革命性优化

相比调用GPT-4V API,本地化部署三年可节省97%成本。某电子制造企业采用该模型替代云端服务,年节省API费用超120万元,硬件投入6个月即回本。

2. 数据安全自主可控

全流程本地化处理避免敏感数据外流,完美契合《数据安全法》要求。金融机构使用该模型进行客户画像分析时,可确保交易数据不出企业内网,合规风险降低80%。

3. 开发范式转变

支持vLLM和Ollama双框架部署,提供完整Python SDK。开发者可通过简单命令实现推理服务搭建,这种低门槛特性使中小企业AI渗透率预计提升40%。

随着消费级AI硬件市场的快速增长,如智能眼镜在2025年双十一期间成交量同比暴涨25倍,Magistral Small 1.2这类轻量级高性能模型将成为推动AI设备普及的关键引擎。IDC数据显示,2025上半年全球智能眼镜市场出货量达406.5万台,同比增长64.2%,这种增长趋势与本地化AI模型的发展形成良性互动。

部署指南:五分钟上手的实操方案

环境准备(以RTX 4090为例)

# 基础依赖安装

pip install transformers accelerate vllm torch

# 模型下载与加载

from vllm import LLM, SamplingParams

model = LLM(model="unsloth/Magistral-Small-2509-FP8-Dynamic")

多模态推理示例

sampling_params = SamplingParams(temperature=0.7, top_p=0.95)

outputs = model.chat(

messages=[{"role": "user", "content": "分析图像中的建筑风格"}],

image_urls=["https://example.com/architecture.jpg"]

)

性能优化建议

- 量化级别选择:优先使用Q4_K_XL量化版,平衡性能与体积

- 显存管理:启用

load_in_8bit=True参数可减少50%显存占用 - 推理加速:使用

--tensor-parallel-size 1启动vLLM服务,吞吐量提升3倍

总结与前瞻

Magistral Small 1.2不仅是一次版本更新,更代表着AI技术普惠化的关键一步。当24B参数模型能在消费级硬件上流畅运行,当多模态理解能力触手可及,我们正站在"AI无处不在"时代的入口。

未来展望:

- 2026年:100B参数模型将实现手机端实时运行

- 2027年:多模态边缘模型将渗透至80%的工业传感器

- 长期来看:"云-边-端"协同的AI架构将成为主流

对于企业而言,现在正是布局本地部署能力的最佳时机——既能规避云端服务的隐私风险与成本陷阱,又能抢占边缘AI的先发优势。而开发者则可通过Magistral系列模型,探索从智能终端到工业物联网的全场景创新可能。

立即通过ollama run命令体验模型能力,关注Unsloth社区获取最新优化工具,评估现有业务流程中可植入本地AI的场景节点,将是把握这一技术趋势的关键行动。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Magistral-Small-2509-GGUF

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Magistral-Small-2509-GGUF