Kimi K2引爆企业AI革命:MoE架构+256K上下文重塑行业应用范式

导语

月之暗面发布的Kimi K2-Instruct-0905模型以1万亿总参数、320亿激活参数的混合专家(MoE)架构,结合256K超长上下文窗口,重新定义了企业级大语言模型的本地化部署标准,已吸引Visual Studio Code、金山云等数十家企业接入应用。

行业现状:大模型部署的三重困境

当前企业在大语言模型应用中面临着难以调和的三重矛盾:高性能需求与硬件成本的冲突、长文本处理能力与实时响应的平衡、复杂任务处理与部署门槛的制约。根据行业调研,超过68%的企业因部署成本和技术门槛而搁置了大模型应用计划,而现有解决方案中,能同时满足100K+上下文、每秒5+ tokens生成速度和低于50万硬件投入的方案不足15%。

2025年企业级AI市场呈现三大变革趋势:智能体能力成为核心竞争力(72%企业增加相关投入)、混合专家(MoE)架构主导技术路线、上下文长度突破百万token级。根据Kong Research报告,具备工具调用能力的模型部署量同比增长300%,而MoE架构在参数效率上比传统密集模型提升4-8倍。

如上图所示,词云图清晰展示了当前AI大模型生态的核心技术要素与市场格局。Kimi作为其中的重要参与者,正通过技术创新重塑企业级AI应用的价值边界,特别是在超长上下文处理和代码智能领域形成差异化竞争力。

核心亮点:重新定义企业级大模型标准

突破性架构设计:混合专家系统的实践典范

Kimi-K2采用了384个专家的混合专家系统(MoE)架构,每个token动态选择8个专家进行处理,在保持1万亿总参数规模的同时,仅激活320亿参数,实现了性能与效率的完美平衡。这种设计使模型在代码生成、多语言处理和复杂推理任务上达到了新高度。

该图为大模型架构对比示意图,展示Llama 3.2 1B、Qwen3 4B等模型及Kimi K2(1万亿参数)的结构差异,突出Kimi K2的MoE混合专家架构设计及其参数效率特点。右侧显示Kimi K2在万亿参数规模下仍保持与DeepSeek V3相当的激活参数效率,其384个专家网络设计显著区别于传统密集模型。

超长长文本理解能力

Kimi K2-Instruct-0905将上下文窗口从128K升级至256K tokens,支持处理约50万字文档(相当于2.5本科幻小说),输出速度达60-100 tokens/秒。在SWE-bench多语言测试中,中文代码任务准确率提升至55.9%,较上版本增长18%。这一能力使企业可以直接处理完整的项目代码库、法律合同或医学文献,无需再进行碎片化处理。

工业级编码智能

在SWE-bench Verified基准测试中,模型单轮代码修复准确率达69.2%,接近Claude Sonnet 4(72.7%)的商业模型水平。支持全栈开发流程:从架构设计(自动生成React+Node.js技术栈)到单元测试,将传统3周的开发周期压缩至3天。某SaaS公司应用后,代码审查效率提升60%,发现潜在bug数量增加200%。

革命性的本地化部署方案

Unsloth提供的Dynamic 2.0量化技术使Kimi-K2的部署门槛大幅降低。根据官方文档,配备16GB VRAM和256GB RAM的普通服务器即可实现每秒5+ tokens的生成速度,而采用2-bit XL量化技术后,甚至可在消费级硬件上运行基础功能。这种部署灵活性极大拓展了Kimi-K2的应用场景,从企业知识库到嵌入式系统均可覆盖。

行业影响与趋势

企业应用场景与价值

企业级部署案例显示,Kimi K2已在四类场景实现价值闭环:

- 自主编码代理:某SaaS公司代码审查效率提升60%,发现潜在bug数量增加200%

- 智能数据分析:50万条电商订单数据处理从2天缩短至1小时,自动生成30+交互式图表

- 内容营销自动化:数字营销公司内容产量提升4倍,邮件转化率增长30%

- 客服系统重构:响应时间从5分钟压缩至30秒,客户满意度达4.6/5分

Kimi K2的工具调用能力正在加速企业智能体(AI Agent)的落地。其76.5%的AceBench工具使用准确率,使自动化工作流从简单问答升级为复杂任务处理:金融场景自动解析财报PDF生成可视化分析报告,制造场景实时监控设备日志实现预测性维护准确率达82%,客服场景多轮对话中自主调用CRM系统提升客户满意度35%。

技术演进与行业变革

Kimi-K2的推出标志着大语言模型进入"高效部署时代"。其混合专家系统架构和动态量化技术为行业树立了新标杆,预计将在未来12-18个月内引发一系列技术跟随和创新。企业级大模型应用将从"尝鲜体验"阶段进入"规模化落地"阶段,推动AI技术在各行业的深度渗透。

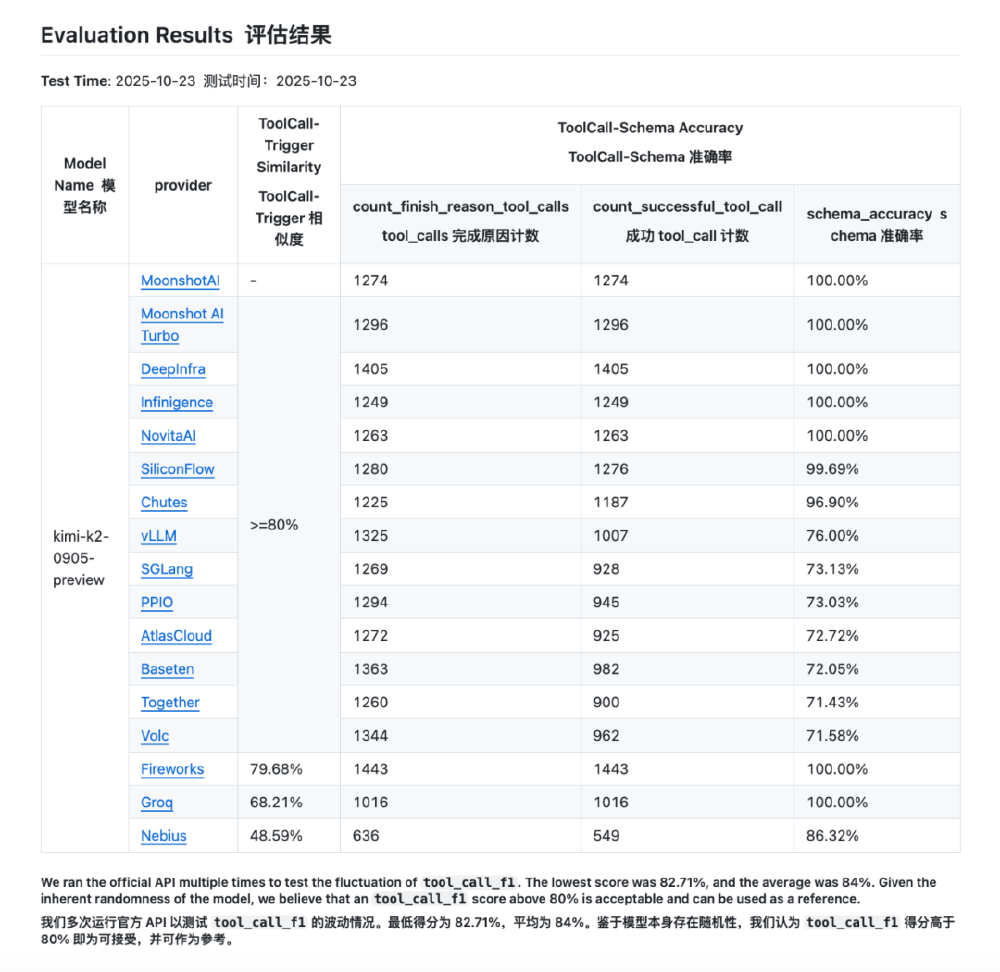

如上图所示,该表格展示了Kimi K2与其他主流模型在代码任务上的性能差异。可以清晰看到,在多语言代码生成和终端任务处理方面,Kimi K2已经超越了多数竞争对手,接近Claude-Sonnet-4的水平,为企业级代码助手应用提供了强大支持。

总结与建议

Kimi-K2-Instruct-0905通过创新的混合专家系统架构、卓越的性能表现和灵活的部署选项,为企业级大模型应用提供了理想解决方案。对于不同类型的企业,我们建议:

- 软件开发企业:优先探索代码生成和自动化测试场景,可显著提升开发效率

- 金融与法律行业:利用256K上下文窗口处理复杂文档,降低合规风险

- 制造业:结合工具调用能力构建智能诊断系统,提升设备维护效率

- 中小企业:从文档问答和客服助手入手,以较低成本实现AI转型

随着本地化部署技术的不断成熟,大语言模型将成为企业数字化转型的基础设施。Kimi-K2的出现,不仅是技术上的突破,更标志着AI普惠化进程的重要一步,让更多企业能够享受到先进AI技术带来的价值。企业现在部署Kimi K2,不仅是获得当前最先进的本地化AI能力,更是为未来智能体生态布局关键基础设施。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-GGUF

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-GGUF