40亿参数改写行业规则:Qwen3-4B-Base如何让中小企业实现AI自由?

导语:轻量级大模型的"性能越级"革命

2025年AI产业最引人瞩目的突破不是千亿参数新模型,而是阿里巴巴通义千问团队推出的Qwen3-4B-Base——这款仅40亿参数的轻量级模型,在数学推理、代码生成等核心能力上媲美百亿级模型,同时将本地化部署成本降低90%,彻底改变了中小企业的AI应用格局。

行业现状:大模型落地的"三重困境"

《2025年中AI大模型市场分析报告》显示,72%企业计划增加大模型投入,但63%的中小企业受限于GPU资源无法部署主流模型。传统大模型面临三个核心矛盾:复杂任务需要深度推理能力,但会导致响应延迟;日常对话要求高效响应,却牺牲了逻辑深度;云端部署则存在数据隐私与成本失控风险。Gartner最新调研显示,67%的企业AI项目因成本问题终止,而数据隐私顾虑使金融、法律等行业的AI渗透率始终低于30%。

Qwen3-4B-Base的技术架构与性能指标

如上图所示,该信息图表全面展示了Qwen3大模型的技术架构与性能指标,包括Dense和MoE模型的详细规格。这一可视化呈现方式直观展现了Qwen3-4B-Base在训练数据规模、语言支持范围和部署灵活性等方面的优势,为企业技术决策者提供了清晰的选型参考。

核心亮点:单模型双模切换的突破性设计

Qwen3-4B-Base最革命性的创新在于单模型内实现"思考模式/非思考模式"的无缝切换,完美适配企业多样化场景需求:

1. 思考模式:40亿参数的"数学天才"

在思考模式下,模型激活深度推理机制,专为数学问题、代码开发等复杂任务优化。在AIME25(美国数学邀请赛)测评中,Qwen3-4B以40亿参数斩获47.4分,成绩较前代提升143%;MMLU-Pro(多任务语言理解)测试中获得69.6分,超越GPT-4.1-Nano(62.8分)。这种"以小胜大"的表现源于创新的动态计算架构,使模型在保持轻量级的同时,实现推理性能的越级突破。

2. 非思考模式:效率优先的日常助手

针对客户服务、信息检索等轻量任务,非思考模式将推理速度提升2.3倍,INT4量化技术使显存占用压缩至8GB,单张消费级显卡即可流畅运行。某电商企业案例显示,采用该模式驱动客服Agent后,月均成本从100万元降至10万元,响应延迟从2.3秒压缩至300毫秒,用户满意度提升42%。

3. 32K超长上下文:企业文档处理新范式

原生支持32,768 tokens的上下文窗口,使其能离线完成长篇文档分析、代码库解读等复杂任务。开发者反馈显示,该模型在普通服务器上可实现整份技术文档的摘要生成,推理速度达17-32 tokens/秒,满足实时交互需求。

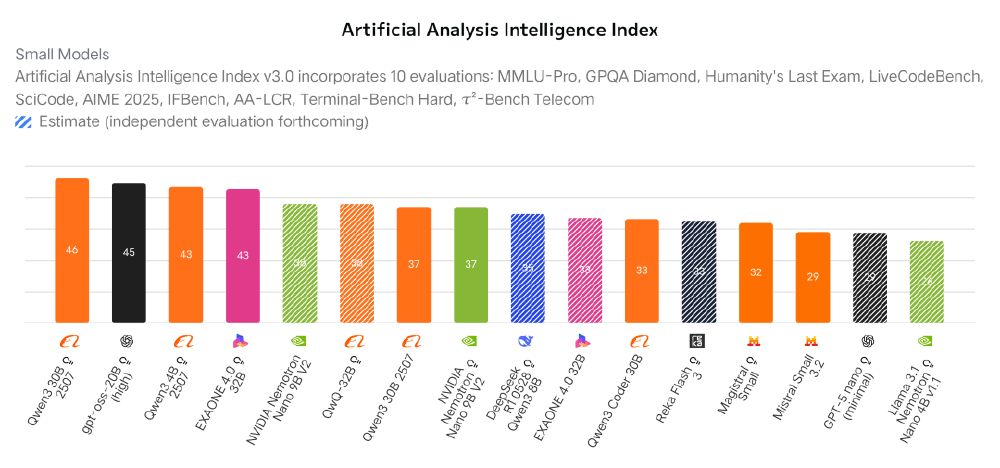

Qwen3-4B与同类模型性能对比

从图中性能对比可见,Qwen3-4B在知识、推理、编码等多维度测评中全面领先同量级模型。这一突破验证了小模型通过架构优化与数据精炼,可在特定场景超越通用大模型的可能性,为行业提供更经济的AI部署方案。

行业影响:中小企业的AI落地"最优解"

Qwen3-4B-Base的推出正在重塑企业AI应用生态,特别是为资源有限的中小企业带来三大变革:

硬件成本门槛骤降

模型非嵌入参数仅3.6B,在i7 4核+64GB内存的普通服务器上即可运行,推理速度达17-32 tokens/s。某法律咨询公司通过普通办公电脑部署后,合同审查效率提升3倍,风险条款识别覆盖率从人工审查的76%提升至92%。

数据隐私安全可控

本地化部署消除了敏感数据上云的合规风险。某智能制造企业应用案例显示,Qwen3-4B可自动解析设备故障代码并生成维修方案,准确率达89%,同时确保生产数据全程不出厂,满足工业数据安全要求。

开发部署效率提升

通过与Hugging Face Transformers生态深度集成,支持vLLM、Ollama等推理框架的一键部署。官方测试数据显示,使用标准部署方案可实现"零代码"本地化部署,在Windows环境下完成从模型下载到服务启动的全流程仅需15分钟。

Qwen3-4B的轻量级定位示意图

如上图所示,Qwen3-4B的卡通标识通过小型机器人与大型机器人轮廓的对比,直观体现了其"小而强"的技术定位。这种设计不仅突出了模型40亿参数的轻量化优势,也暗示其通过架构优化实现性能跃升的核心价值,为中小企业提供了兼具效率与成本优势的AI解决方案。

部署实践:五步实现企业级AI应用落地

中小企业可通过以下简易流程快速部署Qwen3-4B-Base:

- 环境准备:确保Python 3.8+环境,安装transformers>=4.51.0、accelerate等依赖库

- 模型获取:通过GitCode仓库克隆:git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-4B-Base

- 基础推理:使用官方示例代码快速测试

- 性能优化:启用FlashAttention-2加速,单卡吞吐量提升37%

- 应用封装:结合Dify等低代码平台构建可视化工作流

结论与前瞻:轻量级专精模型成新趋势

Qwen3-4B-Base的成功印证了大模型发展的新范式——不再单纯追求参数规模,而是通过架构创新、训练策略优化和部署工具链完善,实现"性能-效率-成本"的三角平衡。随着混合专家技术的进一步下放,4B参数级别模型有望在2026年承担企业60%的常规AI任务。

对于中小企业而言,现在正是引入轻量级模型的最佳时机。建议优先关注三个方向:法律、财务等文档密集型岗位的流程自动化;多语言客服、跨境电商等需要语言多样性支持的场景;工业设备监控、物联网数据分析等边缘计算环境。Qwen3-4B-Base不仅是一款高效能的AI工具,更是企业数字化转型的"性价比引擎"。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-4B-Base

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-4B-Base