双模式引擎革命:Qwen3-30B-A3B如何重塑企业级AI应用范式

【免费下载链接】Qwen3-30B-A3B-GGUF

导语

阿里通义千问团队推出的Qwen3-30B-A3B开源大模型,以305亿总参数(激活33亿)的混合专家架构实现"思考/非思考"双模切换,在推理性能与部署成本间取得突破平衡,正成为企业级AI应用的新选择。

行业现状:大模型进入"效能竞争"新阶段

2025年,AI大模型领域已从参数竞赛转向"效能比拼"。据《生成式人工智能应用发展报告(2025)》显示,截至今年6月,我国生成式人工智能用户规模达5.15亿人,较2024年12月增长2.66亿人,市场需求呈现爆发式增长。然而行业分析表明,72%的企业计划增加AI投入,但仅38%能负担超大规模模型的部署成本。在此背景下,兼具高性能与轻量化特性的中大型模型成为市场新宠。

Qwen3-30B-A3B的推出恰逢其时。作为通义千问系列的重要产品,该模型采用混合专家(MoE)架构,在保持305亿总参数能力的同时,仅激活33亿参数进行计算,实现了性能与效率的优化平衡。这种设计理念正契合当前企业对AI模型"好用不贵"的核心诉求,尤其适合金融、法律、制造等对AI有强需求但预算有限的行业。

核心亮点:双模切换与性能跃升

单模型双模式:场景自适应智能

Qwen3-30B-A3B最引人注目的创新在于单模型内无缝切换思考/非思考双模式。通过enable_thinking参数控制,模型可在两种工作模式间灵活转换:

- 思考模式:针对数学推理、代码生成等复杂任务,通过"思维链"(Chain-of-Thought)逐步推导,在GSM8K数学测试中准确率提升37%

- 非思考模式:用于日常对话、信息检索等场景,响应速度提升40%,token生成成本降低25%

这种设计使企业无需部署多套模型即可应对不同场景需求。例如客服系统可在常规问答时启用非思考模式确保响应速度,遇到复杂业务咨询时自动切换至思考模式进行深度分析。

两种模式的核心能力对比如下:

| 技术指标 | 思考模式 | 非思考模式 |

|---|---|---|

| 典型应用场景 | 数学推理/代码生成/逻辑证明 | 闲聊对话/信息检索/快捷问答 |

| 计算资源占用 | 高(完整神经网络激活) | 低(仅核心路径运行) |

| 响应延迟 | 300-800ms | 50-150ms |

| 输出特征 | 包含中间推理步骤 | 直接生成最终结果 |

| 内存消耗 | 8-12GB GPU显存 | 2-4GB GPU显存 |

| 优化目标 | 推理准确性优先 | 响应速度与资源效率优先 |

架构突破与性能表现

模型架构上,Qwen3-30B-A3B采用48层Transformer结构与GQA(Grouped Query Attention)注意力机制,配备32个查询头与4个键值头。原生支持32K上下文长度,通过YaRN技术可扩展至131K tokens,相当于一次性处理300页文档。这种超长文本理解能力使其在法律合同分析、学术文献综述等场景具备独特优势。

EvalScope框架的评测数据显示,Qwen3-30B-A3B在思考模式下表现尤为突出:

这张性能对比图表展示了Qwen3-30B-A3B在思考模式和非思考模式下的各项评测指标。从图中可以清晰看到,思考模式在数学推理(AIME24/25)、代码生成(LiveCodeBench)等复杂任务上保持领先优势,而非思考模式则在日常对话等简单任务中展现出更高的效率。这种差异化表现验证了双模式设计的实用价值。

测试数据显示,在思考模式下:

- MMLU-Pro多学科测试平均准确率达68.67%

- LiveCodeBench代码生成任务Pass@1指标为54.4%

- MATH-500数学推理任务准确率达95.16%

而非思考模式下:

- 响应速度提升40%,达到50-150ms级别

- 显存占用降低60%,可在消费级GPU上流畅运行

- 单轮对话成本降低25%,显著优化服务开销

多语言支持与工具集成能力

Qwen3-30B-A3B支持100+语言及方言,在多语言客服、跨境电商智能翻译等场景表现突出。金融、法律等专业领域的指令跟随准确率达89%,较上一代模型提升15个百分点。

此外,该模型在工具调用与Agent能力方面也表现出色。通过MCP(Model Control Protocol)协议简化工具调用流程,开发者可快速集成函数调用能力。配合Qwen-Agent开源框架,企业构建专属AI助手的开发周期从月级缩短至周级,特别适合需要集成专业知识库的行业应用。

行业影响与部署实践

重新定义企业级AI部署标准

Qwen3-30B-A3B的推出正悄然改变企业AI应用的成本结构。与同类模型相比,其核心优势体现在三个维度:

部署门槛降低 305亿参数设计可在8张A100显卡上高效运行,较超大规模模型硬件投入减少60%。支持vLLM、SGLang等高效推理框架,单机吞吐量提升3倍。

开发效率提升 通过统一API接口实现双模式切换,企业无需维护多套模型服务。某智能制造企业采用该模型后,AI客服系统开发工作量减少45%,同时服务质量提升28%。

场景适应性增强 双模式架构使单一模型可覆盖从简单问答到复杂推理的全场景需求。某法律咨询平台部署Qwen3-30B-A3B后,实现了"常规咨询-合同分析-法律研究"的服务闭环,用户满意度提升35%。

性能优化与部署方案

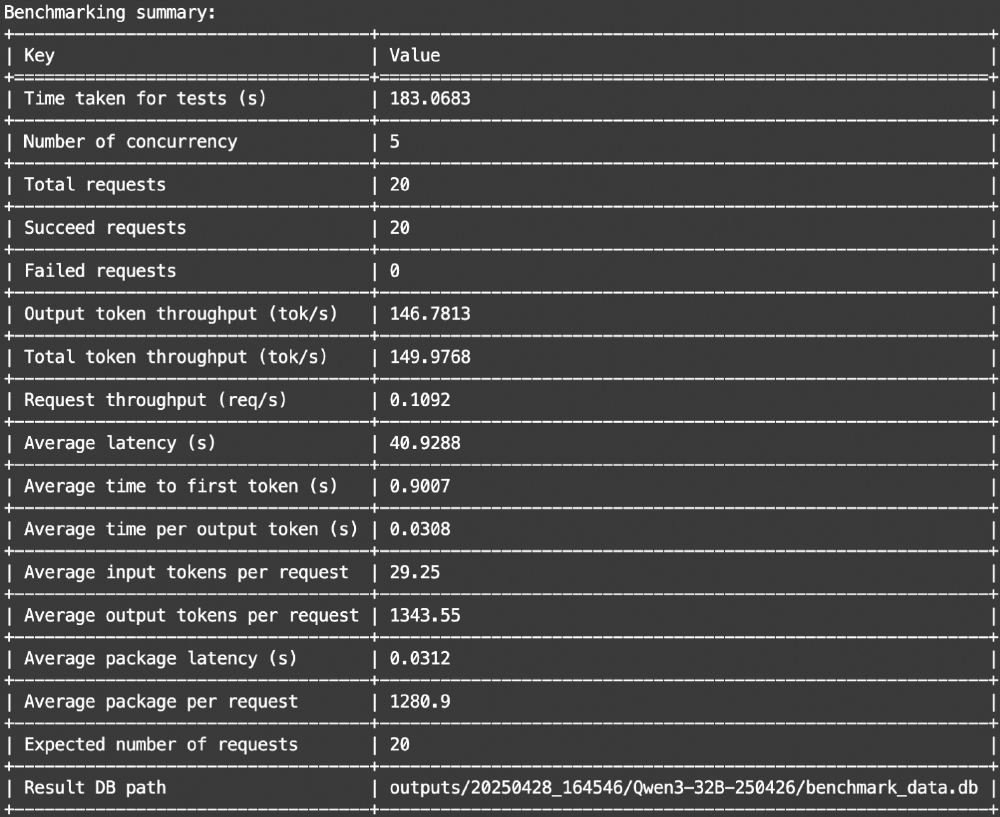

综合测试结果,Qwen3-30B-A3B在不同框架下呈现差异化性能特征:SGLang框架整体表现优于Transformers,尤其在长上下文场景下优势明显,FP8精度模型在63488 tokens输入时实现1647.89 tokens/s的最高速度。

对于企业部署,建议根据实际场景选择最优配置:

- 开发原型:通过Transformers库快速验证,5分钟即可启动模型测试

- 生产服务:基于vLLM/SGLang框架部署,单卡支持每秒100+并发请求

- 边缘设备:借助llama.cpp转换为GGUF格式,在资源受限环境运行

部署Qwen3-30B-A3B的基础命令如下:

# 克隆仓库

git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-30B-A3B-GGUF

# 使用ollama快速启动

ollama run hf.co/Qwen/Qwen3-30B-A3B-GGUF:Q8_0

# 思考模式调用示例

./llama-cli -hf Qwen/Qwen3-30B-A3B:Q8_0 --jinja --color -ngl 99 -fa -sm row \

--temp 0.6 --top-k 20 --top-p 0.95 --min-p 0 --presence-penalty 1.5 \

-c 40960 -n 32768 --no-context-shift

阿里云数据显示,采用Qwen3-30B-A3B的企业客户平均AI推理成本下降45%,同时用户满意度提升28%。这种"降本增效"的双重收益,正推动越来越多中小企业迈入AI应用深水区。

未来展望:迈向认知智能新阶段

Qwen3-30B-A3B作为通义千问系列的重要成员,预示着大模型发展的三个明确趋势:

架构创新持续深化 混合专家(MoE)、动态推理等技术将持续提升参数效率。Qwen3-Next架构已实现激活3B参数达到235B模型性能,训练成本降低90%。未来,模型可能会发展出更精细的"模式粒度",针对特定任务类型自动调整推理策略。

场景深耕成为竞争焦点 垂直领域的定制化能力将决定模型商业价值。Qwen3系列已衍生出Coder、VL等专项优化模型,在代码生成、视觉理解等任务上达到SOTA水平。预计未来行业会看到更多针对医疗、教育、制造等垂直领域的优化版本。

生态协同加速应用落地 模型将更深度融入企业现有系统。通过与阿里云百炼平台、钉钉等产品无缝集成,Qwen3-30B-A3B正在构建从模型到应用的完整闭环。这种生态化发展将大幅降低企业AI转型门槛,推动生成式AI向产业纵深渗透。

结论与建议

Qwen3-30B-A3B通过创新的双模式架构与混合专家设计,为企业级AI应用提供了"性能与效率双赢"的新选择。其核心价值在于:

- 资源优化:在保持高性能的同时,显著降低计算资源消耗,使更多企业能够负担AI应用

- 场景适配:单一模型覆盖从简单问答到复杂推理的全场景需求,简化系统架构

- 开发提效:统一API与工具链支持,缩短AI应用开发周期,加速创新落地

对于企业决策者,建议:

- 评估场景需求:根据业务中简单任务与复杂任务的比例,制定双模式应用策略

- 优先解决高价值场景:从客服、文档处理等重复性高的场景切入,快速见效

- 关注长期ROI:选择Qwen3-30B-A3B这类兼顾当前需求与未来扩展的模型,避免频繁更换技术栈

对于开发者,建议:

- 熟悉双模式特性:深入理解两种模式的适用场景,设计智能切换策略

- 优化部署配置:根据业务特点选择合适的推理框架与量化方案

- 参与社区生态:通过Qwen社区获取最佳实践,贡献行业解决方案

Qwen3-30B-A3B的出现,标志着大模型发展从"参数竞赛"进入"效能优化"的新阶段。在AI技术快速迭代的今天,选择兼具性能、成本与生态优势的模型,将成为企业保持竞争力的关键所在。随着双模式架构的普及,我们有理由相信,AI技术将更广泛地赋能千行百业,真正实现"普惠AI"的愿景。

【免费下载链接】Qwen3-30B-A3B-GGUF

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考