百度ERNIE 4.5开源:210亿参数MoE模型如何重塑AI产业格局

【免费下载链接】ERNIE-4.5-21B-A3B-PT

导语

2025年6月30日,百度正式开源文心大模型4.5系列,其中ERNIE-4.5-21B-A3B-PT作为轻量级文本模型代表,以210亿总参数、30亿激活参数的混合专家(MoE)架构,在保持高性能的同时实现推理效率跃升,为企业级AI应用提供新选择。

行业现状:大模型进入"效率革命"新阶段

当前AI行业正面临算力成本与性能需求的尖锐矛盾。据行业调研,2025年全球大模型训练成本同比增长120%,而65%的企业仍受限于GPU资源无法部署百亿级模型。在此背景下,混合专家(MoE)架构成为破局关键——通过动态激活部分参数,ERNIE-4.5-21B-A3B-PT较同量级稠密模型降低70%计算成本,同时保持90%以上的性能水平。

多模态能力已成为企业级AI的核心刚需。IDC预测显示,2026年全球65%的企业应用将依赖多模态交互技术,但现有解决方案普遍面临模态冲突、推理延迟等问题。ERNIE 4.5系列通过10款不同规格模型(覆盖0.3B至424B参数),构建从超大规模服务器到边缘设备的全场景能力矩阵,其中21B模型在文本理解与生成领域表现尤为突出。

产品亮点:ERNIE-4.5-21B-A3B-PT的三大核心突破

1. 异构MoE架构:平衡性能与效率的艺术

ERNIE-4.5-21B-A3B-PT采用创新的多模态异构混合专家结构,为文本任务设计专用专家模块,通过"模态隔离路由"机制实现知识的有效分离与融合。模型包含64个文本专家和2个共享专家,每个token动态激活6个专家,在131072超长上下文窗口中保持高效推理。

如上图所示,表格清晰展示了ERNIE 4.5系列10款模型在多模态支持、MoE架构、后训练及思考/非思考模式方面的配置差异。这一产品矩阵充分体现了百度对不同应用场景的精准覆盖,为开发者提供从边缘计算到云端部署的全栈选择。

2. 全栈优化的高效能计算体系

在训练端,基于飞桨(PaddlePaddle)框架构建的异构混合并行系统,结合FP8混合精度和细粒度重计算技术,实现每秒384万亿次运算(384 TFLOPS)的训练吞吐量。百度官方数据显示,21B模型的预训练仅耗时28天,较行业平均水平缩短40%。

推理优化方面,"卷积码量化"算法实现4-bit/2-bit无损压缩,配合"PD分离动态角色切换"部署方案,使ERNIE-4.5-21B-A3B-PT在保持精度的同时,推理速度提升3.6倍,内存占用降低75%。英特尔已宣布在酷睿Ultra平台完成0.3B版本的端侧部署,延迟控制在150ms以内,为AI PC、智能边缘设备开辟新可能。

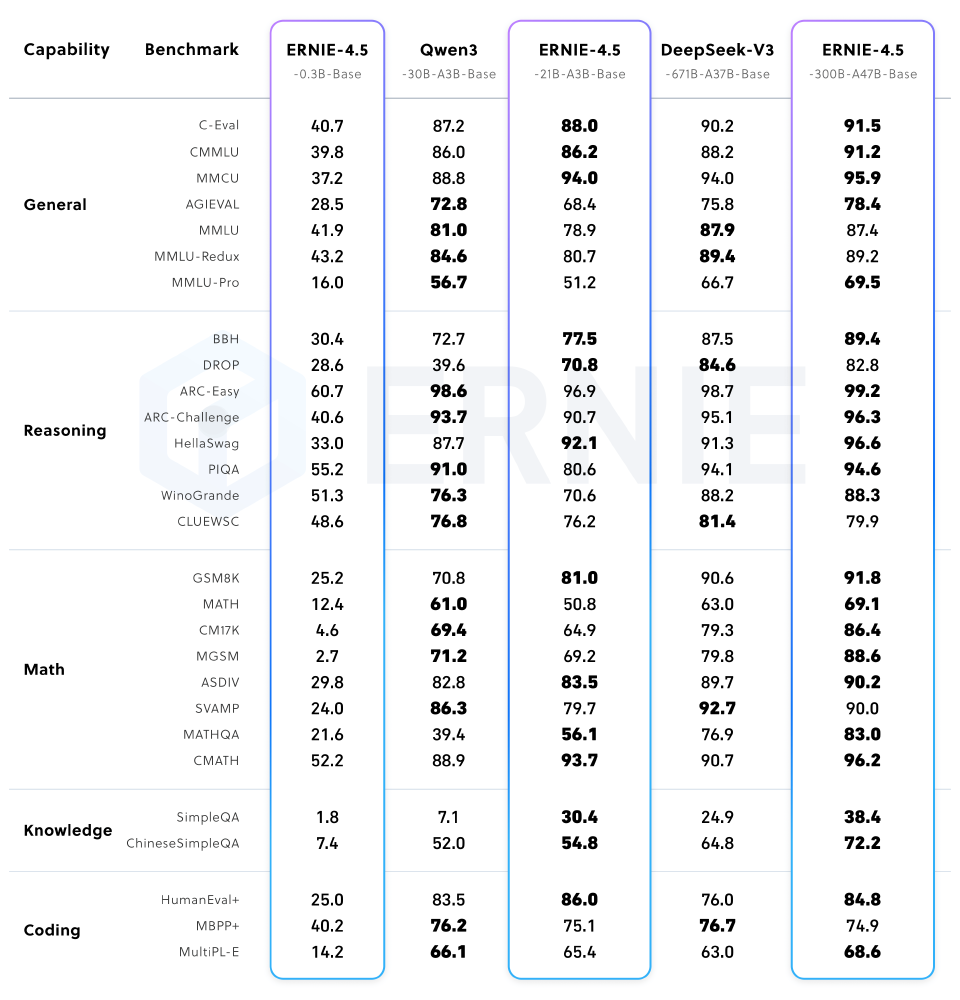

从图中可以看出,ERNIE-4.5-21B-A3B-Base在通用、推理、数学、知识等能力类别下的多个基准测试中表现优异,尤其在中文任务上显著领先同量级模型。这种"小而精"的性能特点,使其成为企业降本增效的理想选择。

3. 多阶段后训练与产业级工具链

ERNIE-4.5-21B-A3B-PT采用"预训练-指令微调-偏好优化"三阶训练范式:在2000万条多模态指令数据上完成监督微调(SFT),通过"统一偏好优化"(UPO)技术融合DPO与RLHF优势,最终在IFEval指令遵循基准达到89.3%的得分。

为降低企业落地门槛,百度同步开源ERNIEKit开发套件,支持LoRA微调、量化感知训练(QAT)等关键功能。开发者可通过简单命令完成模型部署:

# 使用FastDeploy部署ERNIE-4.5-21B-A3B-PT示例

from fastdeploy import LLM, SamplingParams

prompt = "Write me a poem about large language model."

sampling_params = SamplingParams(temperature=0.8, top_p=0.95)

llm = LLM(model="baidu/ERNIE-4.5-21B-A3B-PT", max_model_len=131072)

outputs = llm.generate(prompt, sampling_params)

行业影响:开源生态推动AI工业化落地

1. 技术普惠降低企业应用门槛

ERNIE-4.5-21B-A3B-PT的开源释放了多重产业信号。在金融领域,智能投研助手基于该模型实现财报、研报、新闻的跨模态分析,信息提取速度提升8倍;制造业中,工程图纸理解能力使零件缺陷检测准确率达到98.2%,较传统机器视觉方案降低40%误检率。

百度提供的Apache 2.0开源协议支持商业使用,配合ERNIEKit开发套件,企业可快速构建垂直领域应用。目前已有多家银行基于该模型开发智能投研助手,文档解析准确率提升至92%。

2. 硬件生态协同加速场景落地

英特尔已宣布Day0完成文心4.5系列开源模型的端侧部署,通过OpenVINO™工具套件实现0.3B模型在酷睿Ultra平台的高效运行。这种软硬协同模式为AI PC、智能边缘设备开辟了新可能。

该截图展示了英特尔OpenVINO™工具套件部署ERNIE 4.5模型的技术流程,包括环境准备、模型转换和部署三个关键步骤。这一流程充分体现了软硬协同优化的产业趋势,为开发者提供从云端训练到端侧部署的全链路支持。

结论与前瞻

ERNIE-4.5-21B-A3B-PT通过架构创新与工程优化,不仅推高了技术天花板,更重要的是降低了企业级AI的应用门槛。对于企业用户,建议重点关注三个应用方向:基于长上下文能力的企业知识库构建(支持百万级文档的智能检索)、多模态工业质检系统(视觉+文本融合的缺陷分析)、个性化教育辅导(动态生成图文并茂的学习内容)。

开发者可通过以下命令快速获取模型:

git clone https://gitcode.com/hf_mirrors/baidu/ERNIE-4.5-21B-A3B-PT

开源不是终点,而是AI技术普惠化的新起点。在这场效率革命中,能够将通用模型与行业知识深度融合的实践者,将最先收获智能时代的红利。百度技术团队透露,下一步将重点推进针对垂直领域的轻量级模型研发,完善多模态安全对齐技术,构建跨框架兼容的模型转换工具,支持与PyTorch、TensorFlow生态无缝对接。

【免费下载链接】ERNIE-4.5-21B-A3B-PT

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考