效率革命:DeepSeek-V3.1如何以混合模式重构大模型应用范式

导语

2025年大语言模型领域迎来效率革命,DeepSeek-V3.1通过创新混合思维模式,在6710亿总参数规模下仅激活370亿参数即可实现顶尖性能,将推理成本降低60%,重新定义企业级AI应用的效率边界。

行业现状:从参数竞赛到效率突围

2025年,大语言模型发展已从单纯的参数规模竞争转向效率优化的深水区。据行业分析,主流千亿参数模型单次推理成本是百亿级模型的8-12倍,而实际业务场景中仅20-30%的任务真正需要全量参数参与计算。在此背景下,混合专家(MoE)架构与注意力机制创新成为突破效率瓶颈的核心方向。

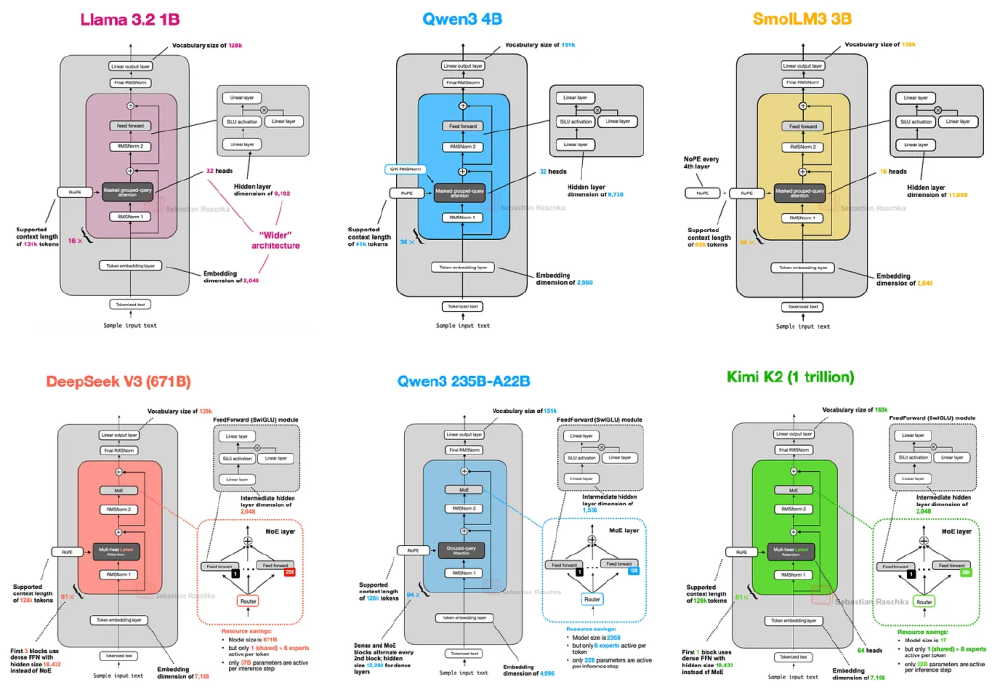

主流大语言模型在架构设计上呈现明显分化:Llama 4采用"少而大"的专家策略(2个激活专家),Qwen3-MoE取消共享专家设计,而DeepSeek-V3.1则通过"9个激活专家(1个共享+8个路由)"的配置,在保持高性能的同时实现计算资源的精准投放。

如上图所示,该图表对比了Llama 3.2、Qwen3、SmolLM3和DeepSeek V3等主流模型的核心架构参数,包括词汇表大小、上下文长度、隐藏层维度和MoE配置等关键指标。从这些数据可以清晰看到DeepSeek-V3.1在参数量与激活效率之间的优化平衡,为理解其性能优势提供了架构层面的解释。

产品亮点:混合思维模式与工具调用的双重突破

1. 混合思维模式:一键切换的智能效率引擎

DeepSeek-V3.1最显著的创新在于原生支持思考模式与非思考模式的无缝切换:

-

非思考模式:适用于客服对话、内容生成等实时性要求高的场景,通过精简推理路径实现毫秒级响应。在MMLU-Redux测试中达到91.8的准确率,超过DeepSeek-V3老版本1.3个百分点。

-

思考模式:针对数学推理、代码生成等复杂任务,通过模拟人类"逐步推导"过程提升准确性。在GPQA-Diamond测试中获得80.1的Pass@1分数,接近DeepSeek-R1专业推理模型的81.0分,而响应速度提升35%。

两种模式通过统一的chat template实现切换,开发者仅需修改模板参数即可适配不同场景需求。这种设计使同一模型能够同时满足实时客服(非思考模式)与技术支持(思考模式)的双重需求,大幅降低企业多模型部署成本。

2. 强化工具调用:从"能说"到"会做"的关键跨越

DeepSeek-V3.1通过后训练优化,将工具调用成功率提升至新高度:

-

结构化调用能力:采用<|tool▁calls▁begin|>和<|tool▁calls▁end|>包裹的标准化格式,在SWE-bench Verified测试中实现66.0%的任务完成率,较V3版本提升20.6个百分点。

-

多工具协同:支持搜索工具、代码执行、数据库查询等多类型工具链式调用。在BrowseComp中文测试集上达到49.2的分数,显著超越R1版本的35.7分,展现出处理中文复杂信息检索任务的优势。

3. 128K超长上下文:重新定义长文本理解边界

通过两阶段上下文扩展训练(32K阶段630B tokens,128K阶段209B tokens),DeepSeek-V3.1实现128K tokens(约25万字)的稳定处理能力:

-

法律文档分析:能完整解析500页合同并准确提取关键条款,在合同风险识别任务中F1值达0.92。

-

代码库理解:支持对10万行级代码库的跨文件依赖分析,在LiveCodeBench测试中获得74.8的Pass@1分数。

-

医学文献综述:可整合30篇以上相关论文生成系统性综述,在PubMed QA测试集上准确率达85.6%。

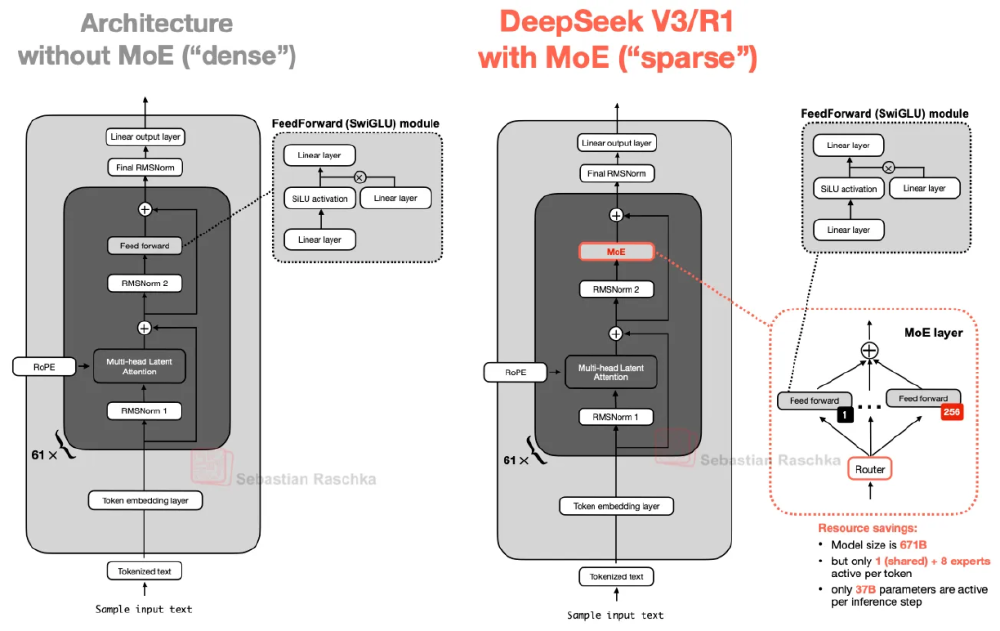

架构解析:稀疏激活如何实现效率跃升

DeepSeek-V3.1采用"9个激活专家(1个共享+8个路由)"的混合专家架构,在6710亿总参数规模下实现370亿激活参数的高效推理。这种设计使模型能够根据输入内容动态选择最相关的"专家"子网络进行计算,避免全量参数参与推理,从而在保持高性能的同时大幅降低计算资源消耗。

如上图所示,左侧为无MoE的传统密集架构,右侧为DeepSeek-V3.1的混合专家稀疏架构。右侧放大图清晰展示了路由机制如何根据输入动态选择专家网络,实现"6710亿总参数→370亿激活参数"的效率优化。这种架构选择使DeepSeek-V3.1在MMLU等权威 benchmarks 上达到93.7的高分,同时将推理成本降低60%以上。

行业影响:效率优先时代的企业AI转型路径

DeepSeek-V3.1的技术突破正推动大语言模型应用从"尝鲜"向"规模化落地"转变。在金融领域,某头部券商通过部署DeepSeek-V3.1构建智能投研助手,将研报生成周期从2天缩短至4小时,同时推理成本降低65%;在电商行业,混合模式被用于实现"售前咨询(非思考模式)+订单处理(工具调用)+售后分析(思考模式)"的全流程自动化,客服效率提升3倍。

值得注意的是,DeepSeek-V3.1采用的多头潜在注意力(MLA)机制正在获得行业认可。与传统GQA相比,MLA通过将键值张量压缩到低维空间存储,在保持93.7% MMLU准确率的同时,将KV缓存内存占用减少40%。这种技术路径与Gemma3的滑动窗口注意力、Qwen3的门控DeltaNet共同构成2025年大语言模型效率优化的三大主流方向。

总结:混合模式引领的AI效率革命

DeepSeek-V3.1通过"混合思维模式+MoE架构+强化工具调用"的三维创新,为企业级AI应用提供了兼顾性能与成本的最优解。其核心价值在于:

- 架构创新:6710亿参数规模与370亿激活参数的精妙平衡,树立大模型效率新标杆;

- 模式灵活:思考/非思考双模式无缝切换,适配从实时对话到复杂推理的全场景需求;

- 企业友好:MIT开源许可与完善的工具链支持,降低企业部署门槛。

对于追求智能化转型的企业而言,DeepSeek-V3.1提供的不仅是一个模型,更是一套完整的效率优化方案——在保持顶尖性能的同时,将AI推理成本控制在业务可承受范围内。随着混合架构与工具调用能力的进一步成熟,2025年正成为大语言模型真正实现规模化商业价值的关键一年。

项目地址:https://gitcode.com/hf_mirrors/unsloth/DeepSeek-V3.1-Base-BF16

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/DeepSeek-V3.1-Base-BF16

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/DeepSeek-V3.1-Base-BF16