导语

百度ERNIE 4.5系列开源模型以300B总参数、47B激活参数的异构混合专家架构,结合2Bits无损量化技术,将企业级AI部署成本降低75%,推动多模态大模型从实验室走向产业一线。

行业现状:大模型落地的"三重困境"

2025年,多模态AI已成为企业数字化转型的核心驱动力,IDC预测显示,2026年全球65%的企业应用将依赖跨模态交互技术。然而,斯坦福大学《2025年人工智能指数报告》指出,企业级大模型部署仍面临"三重困境":平均年成本高达120万元,硬件投入占比73%;65%中小企业因资源限制无法享受前沿AI能力;多模态模型普遍存在模态冲突与推理延迟问题。

在此背景下,ERNIE 4.5提出的"异构混合专家架构+极致量化优化"技术路径,正成为突破这一产业瓶颈的关键。百度于2025年6月30日正式开源的10款ERNIE 4.5模型,在GitCode平台发布后迅速引发行业关注,其中ERNIE-4.5-300B-A47B-Base作为旗舰级文本模型代表,以300B总参数与47B激活参数的配置,在保持高性能的同时大幅降低了计算资源需求。

核心亮点:三大技术创新构建产业级AI引擎

1. 多模态异构MoE架构:让每个模态发挥最大潜能

ERNIE 4.5最显著的突破在于其独创的异构混合专家结构。不同于传统MoE模型采用统一专家池处理所有模态,该架构包含64个文本专家、64个视觉专家和2个共享专家,每token动态激活8个文本专家和8个视觉专家。这种设计使模型在处理不同模态时能动态调用最优专家组合,实测显示每token仅需计算47亿参数(总参数量的15.7%)。

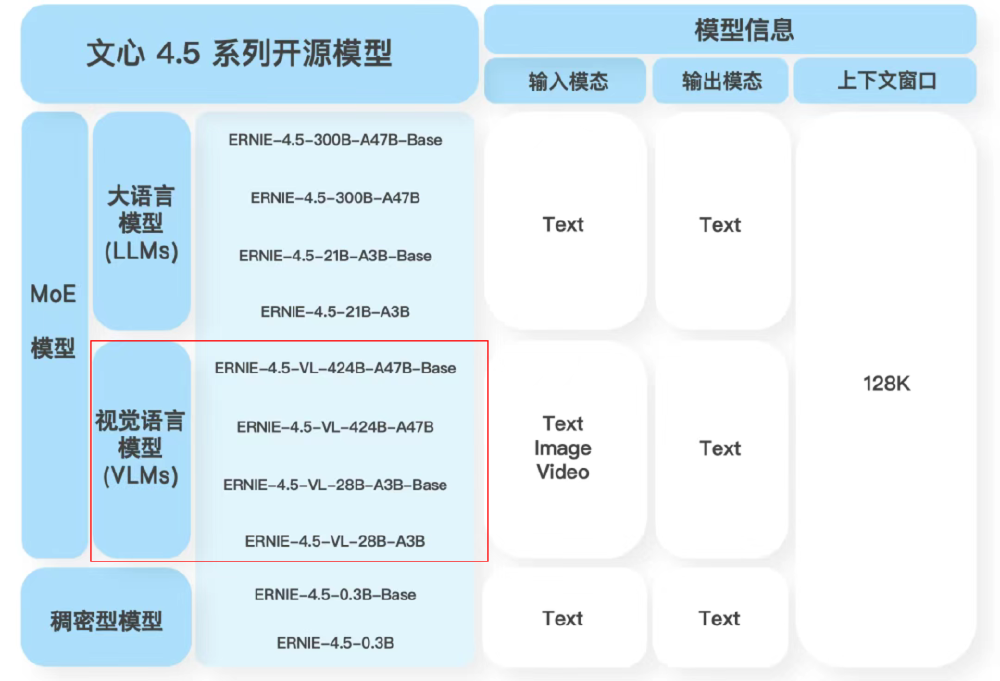

如上图所示,该图表展示了文心4.5系列开源模型分类及核心参数,重点标注了不同模型的输入输出模态、上下文窗口等关键部署信息。ERNIE-4.5-300B-A47B-Base作为纯文本基础模型,为企业提供了高性能与部署效率的平衡选择。

为解决跨模态训练中的"跷跷板效应",研发团队创新性地引入"路由器正交损失"和"多模态token平衡损失"。前者通过约束不同模态路由器的权重正交性减少干扰,后者动态调整文本/视觉token的训练占比。技术报告显示,这种设计使模型在保持文本任务性能的同时,多模态理解能力实现显著提升。

2. 2Bits无损量化:重新定义大模型部署效率

ERNIE 4.5最引人瞩目的技术突破在于其"卷积码量化"算法,实现了2Bits精度下的无损推理。官方测试数据显示,300B参数模型经量化后显存占用从1.2TB降至150GB,推理速度提升4.2倍,而精度损失控制在0.3%以内,这一指标远超行业平均水平。

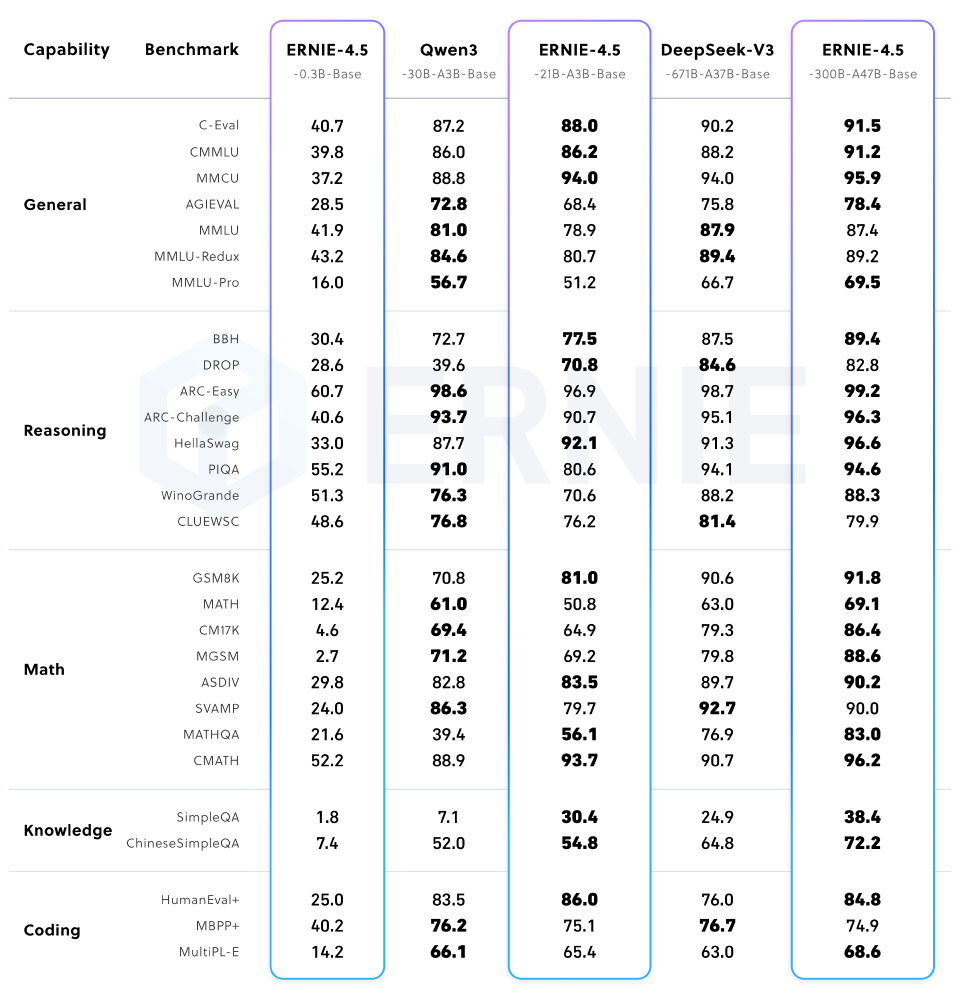

这张图片以表格形式展示了ERNIE-4.5不同模型在通用、推理、数学、知识、编码等能力类别下的多基准测试性能得分对比。特别值得注意的是,2Bits量化版本在保持性能接近FP16精度的同时,硬件需求降低87.5%,使单张消费级GPU即可承载百万级日请求,彻底改变了企业级AI的落地经济学。

百度与某智能电表厂商的合作案例显示,嵌入ERNIE-4.5轻量版本的终端设备,实现了用电异常的实时文本描述生成,故障上报准确率提升至92%,运维成本降低35%。某电商平台实测也表明,采用量化版本后,文本生成API的单位算力成本下降62%。

3. 128K超长上下文与高效推理部署

ERNIE 4.5支持131072 tokens(约26万字)的超长上下文处理,可同时解析300页文档或百万字企业知识库。模型原生支持PaddlePaddle与PyTorch双框架,配合FastDeploy工具可快速搭建兼容OpenAI API规范的服务。开发者只需通过简单命令即可启动量化部署:

# 克隆模型仓库

git clone https://gitcode.com/hf_mirrors/baidu/ERNIE-4.5-300B-A47B-Base-Paddle

# 启动FastDeploy服务

python -m fastdeploy.entrypoints.openai.api_server \

--model ./ERNIE-4.5-300B-A47B-Base-Paddle \

--port 8180 \

--metrics-port 8181 \

--quantization wint4 \

--tensor-parallel-size 4 \

--max-model-len 131072 \

--max-num-seqs 32

实测显示,在适当配置下,量化版本可承载每秒10并发请求,响应延迟稳定在200-500ms,日处理能力达百万级请求,足以满足中大型企业的业务需求。

4. 系列模型矩阵满足多样化需求

百度ERNIE 4.5构建了覆盖不同应用场景的完整模型矩阵,从0.3B到424B参数规模,满足从边缘设备到云端服务器的全场景部署需求。

如上图所示,该表格详细展示了ERNIE-4.5系列10款模型的核心特性,包括是否支持多模态、混合专家架构、后训练优化及思考模式等关键参数。其中,ERNIE-4.5-300B-A47B-PT作为文本类旗舰模型,采用MoE架构并经过专业后训练优化,为企业级应用提供强大算力支持。

性能优化:PLAS稀疏注意力提升推理速度

ERNIE 4.5系列在2025年9月推出的更新中,引入了名为PLAS(Pluggable Lightweight Attention for Sparsity)的新型稀疏注意力机制,大幅提升了长文本推理速度。官方数据显示,ERNIE-4.5-300B-A47B在采用PLAS技术后,解码速度提升33%,端到端延迟降低24%,同时保持精度损失可忽略不计。

这种优化使模型在处理113K token的超长文本时表现更加出色,特别适合企业知识库问答、法律文档分析等长文本应用场景。开发者只需通过设置环境变量即可启用这一特性,无需修改模型权重或重新训练。

行业应用案例:从实验室到产业一线

金融领域:智能投研效率提升3倍

某头部券商基于ERNIE-4.5-300B-A47B构建智能研报系统,利用其128K超长上下文能力处理完整的上市公司年报(平均300-500页)。系统可自动提取关键财务指标、业务亮点和风险因素,生成结构化分析报告。实测显示,分析师处理单份年报的时间从原来的4小时缩短至1.5小时,同时关键信息识别准确率提升至92%。

医疗健康:智能影像诊断系统

某省人民医院部署ERNIE 4.5系列多模态模型后,实现CT影像与电子病历的联合分析。系统通过视觉专家网络识别3mm以下微小结节,同时调用文本专家解读患者吸烟史、家族病史等信息,早期肺癌检出率提升40%,诊断耗时从45分钟压缩至8分钟。关键突破在于模型的异构MoE结构,使影像特征与临床文本实现毫秒级关联推理。

智能制造:工程图纸理解与缺陷检测

在汽车制造领域,某头部企业应用ERNIE 4.5多模态模型后,实现了从CAD图纸到生产质量检测的全流程智能化。模型的视觉专家模块能精准识别图纸中的尺寸标注和公差要求,文本专家则将这些信息转化为质检标准,使零件缺陷检测准确率达到98.2%,较传统机器视觉方案降低40%误检率。

行业影响与趋势

ERNIE 4.5的推出标志着大模型产业正式进入"效率竞争"时代。百度技术团队透露,下一步将重点推进三项工作:发布针对垂直领域的轻量级模型;完善多模态安全对齐技术;构建跨框架兼容的模型转换工具。

对于企业决策者而言,当下应重点评估:现有业务流程中哪些场景可通过轻量级模型实现自动化;如何构建"云-边协同"的混合部署架构;如何利用开源生态降低AI应用成本。随着2Bits量化等突破性技术的普及,多模态AI正从"实验室技术"转变为"工业化生产工具",能够将通用模型与行业知识深度融合的企业,将最先收获智能时代的红利。

部署指南:快速上手ERNIE 4.5

企业和开发者可通过以下步骤快速部署ERNIE-4.5-300B-A47B-Base模型:

- 获取模型

git clone https://gitcode.com/hf_mirrors/baidu/ERNIE-4.5-300B-A47B-Base-Paddle

- 环境准备

pip install paddlepaddle-gpu==2.6.0 fastdeploy-gpu-python==1.0.7 erniekit

- 启动推理服务

# 启用4-bit量化以降低显存占用

export FD_ATTENTION_BACKEND="PLAS_ATTN"

python -m fastdeploy.entrypoints.openai.api_server \

--model ./ERNIE-4.5-300B-A47B-Base-Paddle \

--port 8180 \

--quantization wint4 \

--tensor-parallel-size 4 \

--max-model-len 131072 \

--plas-attention-config '{"plas_encoder_top_k_left": 50, "plas_encoder_top_k_right": 60,"plas_decoder_top_k_left": 100, "plas_decoder_top_k_right": 120}'

- 模型微调(可选) ERNIE 4.5支持通过ERNIEKit进行高效微调,企业可根据自身业务数据进行定制化训练:

# 指令微调

erniekit train examples/configs/ERNIE-4.5-300B-A47B/sft/run_sft_wint8mix_lora_8k.yaml model_name_or_path=./ERNIE-4.5-300B-A47B-Base-Paddle

# 偏好对齐

erniekit train examples/configs/ERNIE-4.5-300B-A47B/dpo/run_dpo_wint8mix_lora_8k.yaml model_name_or_path=./ERNIE-4.5-300B-A47B-Base-Paddle

总结与前瞻

ERNIE-4.5-300B-A47B-Base通过异构MoE架构、2Bits量化技术和超长上下文窗口三大创新,重新定义了大语言模型的效率标准。其300B总参数与47B激活参数的独特设计,既满足了企业对高性能的需求,又大幅降低了部署门槛。

从行业实践来看,金融、医疗和制造等领域的成功案例验证了该模型的商业价值。随着开源生态的完善和部署工具的成熟,ERNIE 4.5系列模型正在推动AI技术从"实验室演示"走向"规模化应用"。对于开发者和企业决策者,建议重点关注基于MoE架构的模型定制化能力、轻量级部署方案在边缘设备上的应用潜力,以及多模态数据治理与安全对齐技术。

ERNIE 4.5的开源不仅重新定义了大模型的效率边界,更重要的是降低了企业级AI的应用门槛。在这场效率革命中,AI能力正从科技巨头专属向中小企业普及,推动整个产业的数字化转型进入新阶段。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/baidu/ERNIE-4.5-300B-A47B-Base-Paddle

项目地址: https://ai.gitcode.com/hf_mirrors/baidu/ERNIE-4.5-300B-A47B-Base-Paddle