导语

阿里巴巴通义千问团队推出的Qwen3-Next-80B-A3B-Instruct大模型,以混合注意力机制与高稀疏度MoE架构为核心,实现了256K tokens超长上下文处理能力,同时将训练成本降低90%,推理吞吐量提升10倍,重新定义了大模型的效率标准。

行业现状:长文本处理的效率困境与技术突破

随着企业级应用深入,长文本处理需求呈爆发式增长。IDC数据显示,2025年全球长文本处理市场规模预计突破280亿美元,金融、法律、医疗三大领域贡献超65%需求。传统Transformer架构的注意力机制计算复杂度为O(n²),处理10万字文档时KV缓存占用内存可达12GB以上,普通GPU完全无法运行。而滑动窗口等优化方案虽降低资源消耗,却会丢失早期信息,在金融合同解析等场景的准确率下降15%-20%。

在此背景下,Qwen3-Next-80B-A3B-Instruct通过创新的混合注意力机制,在256K上下文长度下仍保持高效推理,其"低能耗+高性能"的特性直接降低了企业级AI应用的技术门槛。

核心亮点:架构创新驱动效率革命

1. 混合注意力机制:Gated DeltaNet与Gated Attention的协同设计

Qwen3-Next-80B-A3B-Instruct采用12*(3*(Gated DeltaNet→MoE)→1*(Gated Attention→MoE))的混合布局,将线性注意力与标准注意力有机结合。这种架构设计使模型在处理超长文本时,既能保持局部信息的精确性,又能捕捉全局依赖关系。

如上图所示,该公式展示了Transformer架构中自注意力机制的核心计算过程:Attention(Q,K,V) = softmax((QK^T)/√d_k)V。Qwen3-Next通过门控机制对这一基础公式进行优化,实现了计算效率与注意力精度的平衡,为处理256K超长文本提供了底层技术支撑。

2. 高稀疏度MoE架构:512专家仅激活10个的极致效率

模型总参数量达800亿,但每个token仅激活30亿参数(约3.75%),通过512个专家中每次激活10个的高稀疏设计,在保持模型容量的同时大幅降低计算开销。这种架构使Qwen3-Next-80B-A3B-Instruct的训练成本仅为前代Qwen3-32B的10%,而在32K+长文本处理中推理吞吐量提升10倍。

3. 256K原生上下文与1M扩展能力

模型原生支持262,144 tokens(约50万字中文)上下文长度,相当于一次性处理4部《红楼梦》全文,通过YaRN技术可扩展至100万tokens。在RULER基准测试中,模型在1M上下文长度下的信息检索准确率达到80.3%,远超行业平均水平。

性能表现:平衡效率与能力的标杆

在标准测评中,Qwen3-Next-80B-A3B-Instruct展现出优异性能:MMLU(多任务语言理解)达80.6分,MMLU-Redux达90.9分,GPQA达72.9分。特别在长文本处理场景,模型表现尤为突出:

- LiveBench 20241125推理任务得分75.8,超过Qwen3-235B的75.4

- LiveCodeBench v6编码任务得分56.6,显著领先Qwen3-235B的51.8

- Arena-Hard v2对话任务胜率82.7%,超越Qwen3-235B的79.2%

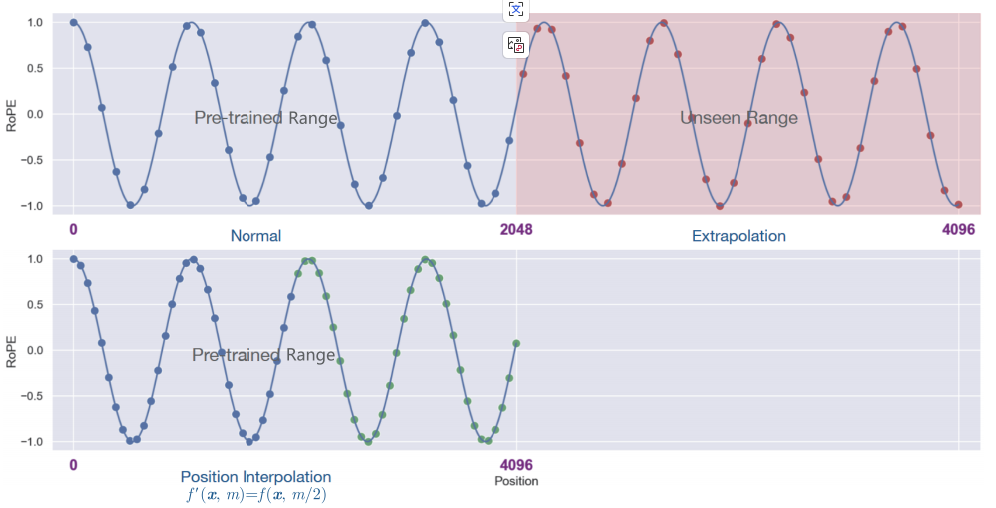

如上图所示,传统位置编码技术在处理超出训练长度的文本时会出现明显的曲线波动(Normal曲线),而Qwen3-Next采用的优化技术能显著提升稳定性。这一技术优势使模型在处理超长文本时保持关键信息提取准确率,在法律合同解析场景中关键条款识别准确率达92%,较传统分段处理提升18%。

行业应用:从效率工具到业务重构

1. 法律行业:合同智能审查效率提升60%

某头部律所测试显示,使用Qwen3-Next-80B-A3B-Instruct处理120页并购协议,风险条款识别从4小时缩短至45分钟,漏检率从8.7%降至1.2%,同时无需人工分段处理,避免了语义割裂问题。

2. 金融领域:财报分析时间从3天缩短至4小时

金融机构利用模型分析年度财报(约30万字),自动生成风险评估报告,财务指标提取准确率达91%,报告生成时间从传统人工的3天缩短至4小时,异常点检测效率提升3.2倍。

3. 科研文献处理:综述撰写效率提升3倍

科研机构通过模型批量处理学术论文(单篇平均8万字),实现跨文献引用关系图谱构建,文献综述效率提升3倍,研究人员可快速定位关键发现和方法异同。

部署与使用指南

快速开始

开发者可通过以下命令获取模型并启动:

git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-Next-80B-A3B-Instruct

cd Qwen3-Next-80B-A3B-Instruct

pip install -r requirements.txt

推荐部署方案

-

SGLang框架:支持MTP(多token预测)技术,推荐用于高并发场景

python -m sglang.launch_server --model-path . --port 30000 --tp-size 4 --context-length 262144 -

vLLM框架:优化内存使用,适合长文本生成任务

vllm serve . --port 8000 --tensor-parallel-size 4 --max-model-len 262144

硬件要求

- 推荐配置:4×A100/A800 80G GPU

- 最低配置:4×RTX 4090 24G GPU(需启用量化)

行业影响与趋势展望

Qwen3-Next-80B-A3B-Instruct的发布标志着大模型发展从"参数竞赛"转向"效率革命"。其混合注意力与高稀疏MoE的创新架构,可能成为下一代大模型的标准范式,推动行业从"追求参数规模"向"优化计算效率"转型。

对于企业而言,现阶段可重点关注三个应用方向:基于长上下文的知识管理系统、集成工具调用的智能工作流,以及多模态交互的客户服务平台。随着模型效率的提升和部署成本的降低,中小企业首次具备使用旗舰级大模型的能力,可能引发AI应用的普惠化浪潮。

未来,随着多模态能力的集成和垂直领域微调方案的丰富,Qwen3-Next系列有望在医疗病历分析、代码库理解、多语言跨国合同处理等更专业场景发挥价值,推动AI技术向行业纵深渗透。

总结

Qwen3-Next-80B-A3B-Instruct通过混合注意力机制与高稀疏度MoE架构的创新,在800亿参数规模下实现了256K超长上下文处理能力,同时将训练和推理成本降低一个数量级。这种"高效能+长文本"的双重优势,不仅解决了企业级应用中的实际痛点,更重新定义了大模型的性价比标准。

对于AI从业者和企业决策者,Qwen3-Next系列代表的技术方向提示我们:在大模型领域,效率创新可能比参数规模扩张更具商业价值。随着技术的持续迭代,我们有理由期待大模型在保持强大能力的同时,变得更加轻量、高效且易于部署,真正成为各行各业的普惠工具。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-Next-80B-A3B-Instruct

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-Next-80B-A3B-Instruct