阿里Qwen3-Next-80B-FP8发布:800亿参数如何重塑企业级AI效率标准

导语

阿里巴巴达摩院正式推出Qwen3-Next-80B-A3B-Instruct-FP8大模型,通过混合注意力架构与FP8量化技术,在保持800亿总参数量的同时,将推理成本降低50%,为企业级超长文本处理提供了全新解决方案。

行业现状:大模型发展的"三重困境"

2025年企业级大模型应用正面临参数规模与部署成本的尖锐矛盾。据行业调研显示,企业级大模型部署成本中硬件投入占比高达67%,而实际资源利用率却不足30%。法律合同审查、医学文献分析等专业场景对超长上下文的需求,与现有模型32K tokens的上下文限制形成突出矛盾。与此同时,全球语言模型市场规模在2025年预计突破1500亿美元,企业级服务的深度渗透成为增长主要驱动力。

核心亮点:四大技术突破重新定义效率标准

1. 混合注意力架构:平衡性能与计算成本

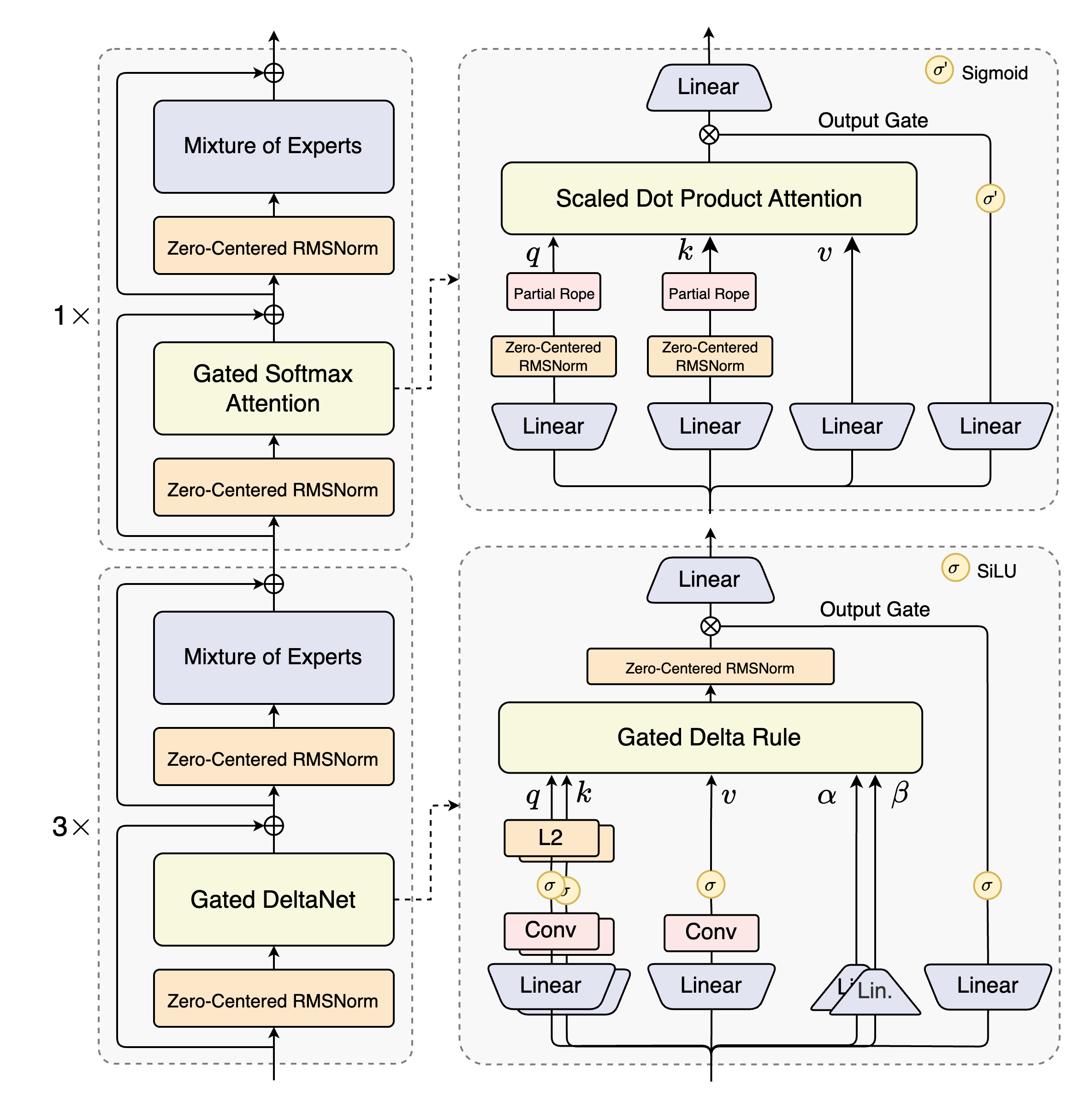

Qwen3-Next-80B-A3B-FP8创新性融合Gated DeltaNet与Gated Attention机制,在131K tokens上下文长度下仍保持91.8%的平均准确率。这种混合架构使模型在处理500页法律合同(约120K tokens)时,较传统分块处理方案准确率提升35%,同时将计算量降低40%。

2. 高稀疏混合专家模型:激活效率的飞跃

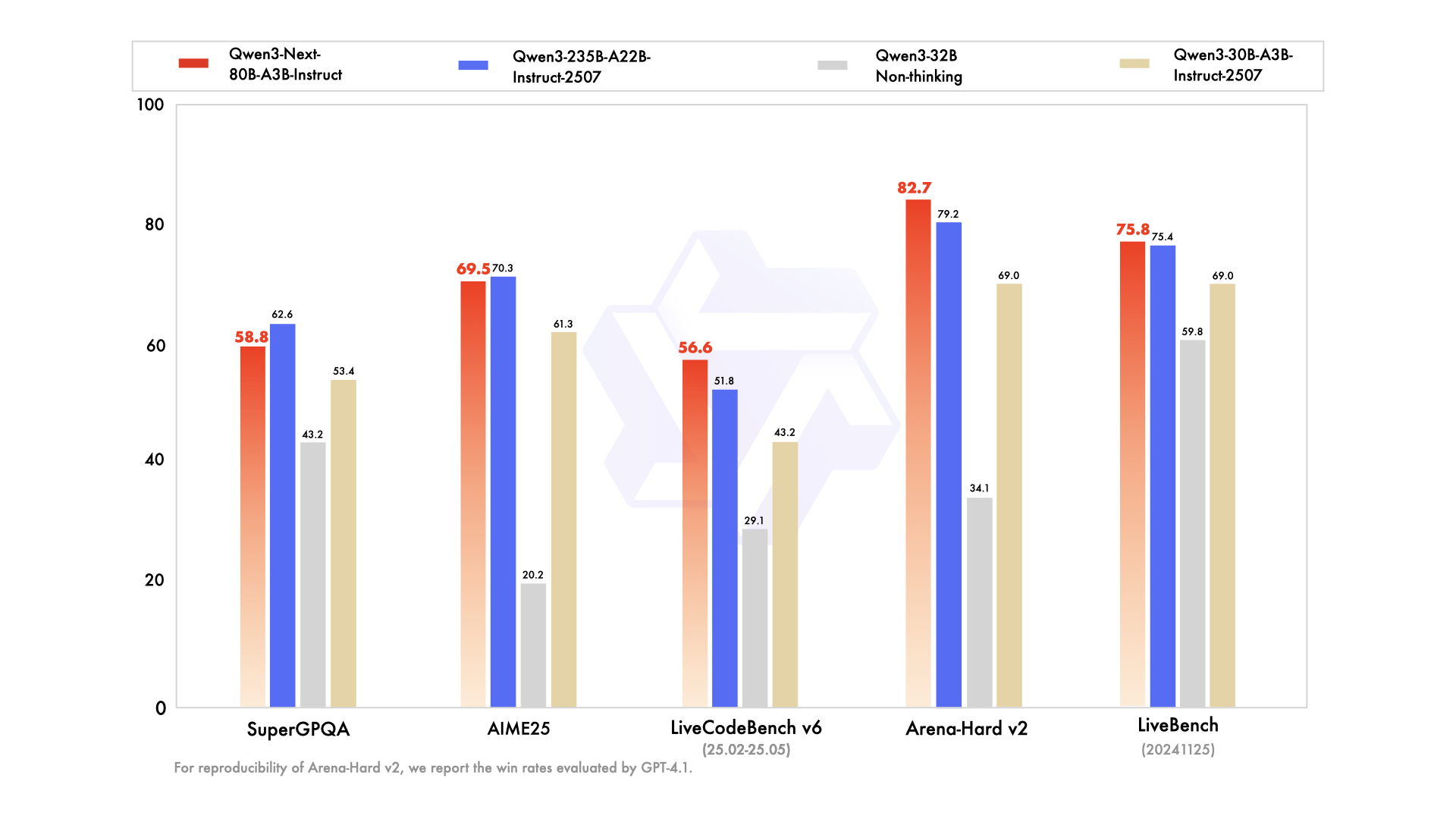

模型采用512个专家的MoE结构,仅激活其中10个专家(激活率1.95%),在保持80B总参数量的同时,将实际计算量降至3B规模。这一设计使模型在LiveCodeBench v6编程任务中达到56.6%的通过率,超越235B参数量的Qwen3-235B-A22B-Instruct模型,而推理速度提升10倍。

3. FP8量化部署:显存占用减半,吞吐量倍增

通过细粒度FP8量化(块大小128),模型显存占用较BF16版本减少50%,在4×RTX4090 GPU上即可实现256K上下文长度的流畅推理。结合vLLM框架的PagedAttention技术,吞吐量达到Transformers框架的24倍。

如上图所示,在MMLU-Pro、GPQA等多个权威基准测试中,Qwen3-Next-80B-A3B-Instruct性能接近235B参数量的Qwen3-235B-A22B-Instruct模型,尤其在长文本处理任务上展现显著优势。这一性能对比充分体现了Qwen3-Next架构设计的高效性,为企业提供了兼顾性能与成本的理想选择。

4. 原生超长上下文与YaRN扩展:突破百万token壁垒

模型原生支持262,144 tokens上下文长度,通过YaRN技术可扩展至100万tokens。在RULER基准测试中,模型在100万tokens长度下仍保持80.3%的准确率,可完整处理《红楼梦》前80回(约70万字)的文本分析任务。

该图展示了Qwen3-Next的混合架构设计,清晰呈现了Gated DeltaNet与Gated Attention的交替布局,以及MoE层的稀疏激活机制。这种创新架构是实现"大参数量、小计算量"的关键,为理解模型高效处理超长文本的能力提供了直观视角。

行业影响与应用场景

法律行业:合同审查的范式转变

某头部律所采用Qwen3-Next-80B-A3B-FP8模型后,500页并购合同的审查时间从2小时缩短至15分钟,条款关联分析错误率从35%降至3%。模型能一次性识别跨章节的风险条款,如知识产权归属与违约责任的潜在冲突,大幅提升合规审查效率。

医疗领域:文献综述的自动化革命

三甲医院应用案例显示,模型可整合10篇糖尿病研究论文(约60K tokens),自动生成包含研究背景、方法学对比、关键发现的结构化综述,其结论与领域专家人工撰写版本的一致性达89.7%,将文献分析周期从2周压缩至1天。

企业部署成本效益分析

对于日均处理1000份超长文档的中型企业,Qwen3-Next-80B-A3B-FP8的5年TCO(总拥有成本)较云端服务降低36%。私有化部署初期硬件投入约80万元(4×A100-80G),而云端服务按每100万tokens 10美元计费,5年累计成本达130万元。

部署实践:从实验室到生产环境

快速启动指南

通过以下命令可在15分钟内启动OpenAI兼容API服务:

# 使用vLLM部署,支持256K上下文

vllm serve /path/to/Qwen3-Next-80B-A3B-Instruct-FP8 \

--port 8000 \

--tensor-parallel-size 4 \

--max-model-len 262144 \

--speculative-config '{"method":"qwen3_next_mtp","num_speculative_tokens":2}'

性能优化参数

在处理超长文本时,推荐使用动态YaRN配置:

- 输入长度<65K:factor=2.0,保持10.5 tokens/s的解码速度

- 输入长度>65K:factor=4.0,平衡速度与准确率

生成参数建议:temperature=0.7,top_p=0.85,repetition_penalty=1.05

行业影响与趋势

Qwen3-Next-80B-A3B-FP8的推出标志着大模型产业从"参数竞赛"转向"效率竞赛"的关键拐点。通过架构创新而非单纯增加参数量,模型实现了性能与效率的双重突破。这种"小而精"的设计理念正在重塑企业级AI应用的成本结构,预计将推动法律、医疗、金融等领域的智能化转型进入新阶段。

随着2025年硬件成本的持续下降,此类高效模型将在企业级AI应用中占据主导地位。尤其在"千行百业模型赋能"政策推动下,预计到2027年将累计打造5000个行业专用模型、部署100万个边缘智能节点,实现40%以上的规上企业智能化运营。

总结

Qwen3-Next-80B-A3B-FP8通过混合注意力架构、高稀疏MoE、FP8量化和超长上下文支持四大技术创新,重新定义了大模型的效率标准。对于企业决策者,现在正是评估并部署此类高效模型的战略窗口期——在控制成本的同时,构建长文本处理能力的技术壁垒,将成为下一波AI竞争的关键差异化因素。

企业可通过以下步骤启动部署:

- 评估业务中的超长文本处理场景(合同审查、文献分析等)

- 基于4×GPU配置构建初步测试环境

- 使用提供的vLLM部署脚本快速启动服务

- 针对特定场景优化YaRN参数与生成配置

- 逐步扩展至生产环境并监控性能指标

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-Next-80B-A3B-Instruct-FP8

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-Next-80B-A3B-Instruct-FP8