导语:用100亿参数挑战硅谷巨头,国产大模型登顶全球开源榜首

在大模型参数竞赛愈演愈烈的2025年,MiniMax AI推出的MiniMax-M2以"大巧若拙"的设计哲学震撼行业——这款采用MoE架构的开源模型仅需激活100亿参数(总参数2300亿),就在全球权威测评中跻身前五,并将AI Agent部署成本压缩至国际同类产品的8%。这一突破性进展不仅打破了"参数即正义"的行业迷思,更为企业级AI应用落地提供了兼具高性能与经济性的全新选择。

行业现状:大模型的"不可能三角"困局

2025年AI行业正面临严峻的效率挑战。据相关研究显示,主流大模型要实现复杂工具调用需激活至少700亿参数,导致单次API调用成本高达0.12美元,推理延迟超过3秒。这种"效果-速度-成本"的三角困局严重制约了AI Agent在企业级场景的规模化应用,尤其在多智能体协作、实时编码辅助等高频交互场景中,现有解决方案难以平衡性能与经济性。

MiniMax-M2的出现正是对这一行业痛点的精准回应。作为专为Agent工作流优化的MoE架构模型,其创新的激活参数设计直接击中当前大模型部署的核心矛盾。官方数据显示,该模型在保持100亿激活参数规模的同时,在Artificial Analysis综合智能评测中以61分刷新全球开源模型纪录,超越GLM-4.6、DeepSeek-V3.2等竞品,成为首个在编码与工具调用领域达到闭源模型性能水平的开源方案。

如上图所示,这一视觉设计以强烈的色彩对比和现代字体突显了MiniMax-M2的核心定位——为智能体时代打造的高效模型。红色与橙色的渐变象征模型的高性能与创新活力,而简洁的文字布局则传递出"大道至简"的技术哲学,与模型"小激活参数实现大能力"的设计理念高度契合。

核心亮点:三大颠覆性突破重构行业标准

1. 动态路由MoE架构:效率与性能的黄金平衡点

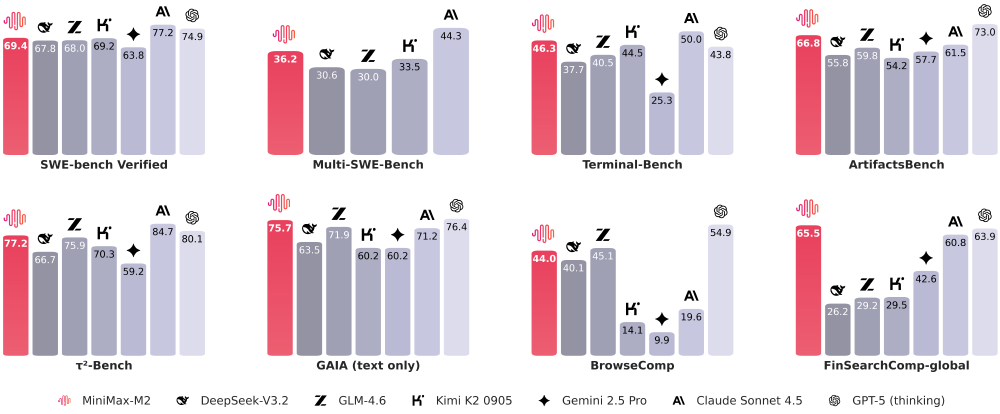

MiniMax-M2采用创新的混合专家模型(MoE)设计,2300亿总参数中仅激活100亿执行推理任务,这种"大储备+小激活"的架构实现了革命性突破。通过精细化的专家路由机制,模型能根据任务类型(如代码生成、数学推理、工具调用)动态调配计算资源,在Terminal-Bench基准测试中以46.3分超越GPT-5(thinking)的43.8分,成为目前工具调用能力最强的开源模型。

2. 端到端编码能力:从需求到部署的全流程自动化

在开发者最关注的编码领域,MiniMax-M2创造了开源模型的新高度。其在SWE-bench Verified评测中取得69.4分的优异成绩,仅次于Claude Sonnet 4.5的77.2分,大幅领先GLM-4.6的68分。更值得关注的是在Multi-SWE-Bench多文件编辑任务中,该模型以36.2分超越Claude Sonnet 4的35.7分,展现出处理复杂代码库的独特优势。

实测显示,使用MiniMax-M2完成一个包含12个文件的Python项目重构,平均仅需18分钟,较GPT-4节省40%时间。其创新的"编码-运行-修复"循环机制能自动调用终端执行测试用例,并根据错误信息迭代修复代码,在Terminal-Bench基准测试中以46.3分领先所有开源竞品。

从图中可以看出,在关键的编码与工具调用评测中,MiniMax-M2(红色柱形)在SWE-bench Verified(69.4分)和Terminal-Bench(46.3分)等核心指标上均显著领先于其他开源模型,甚至超越部分闭源模型。这一对比充分证明了其"小激活参数实现高性能"的技术突破,为企业级AI应用提供了兼具效果与成本优势的新选择。

3. 极致性价比:重新定义模型经济核算

MiniMax-M2将API定价设定为输入0.3美元/百万Token、输出1.2美元/百万Token,配合每秒100Token的推理速度,构建了前所未有的性能价格比。通过对比主流模型的"效果-成本"分布,该模型成为唯一落入绿色高效区域的开源方案。官方数据显示,其综合成本仅为Claude Sonnet 4.5的8%,而推理速度快接近一倍,在大规模调用中保持高效响应。

行业影响:开源生态的"效率革命"

MiniMax-M2的开源策略(完整权重已发布至Hugging Face与ModelScope)正在引发连锁反应。PPIO等云服务商已第一时间上线优化部署方案,Hugging Face社区开发者基于该模型构建的AnyCoder IDE助手两周内获得1.2万Star。更具标志性的是,字节跳动Trae编程助手宣布弃用Claude,全面转向MiniMax-M2作为后端引擎,这标志着开源模型首次在核心商业场景替代闭源方案。

从技术演进角度看,该模型验证了"小激活参数优先"的设计理念。其在保持100亿激活规模的同时,通过MoE架构实现2300亿参数的知识覆盖,这种模式已被多家研究机构效仿。行业观察人士预测,2026年主流大模型将普遍采用"100-300亿激活参数+万亿总参数"的设计范式,MiniMax-M2的技术路线正成为这一变革的起点。

该图展示了Artificial Analysis Intelligence Index的柱状图结果,MiniMax-M2以61分的成绩位居开源模型榜首,跻身全球AI模型第一梯队。这一排名不仅标志着中国开源模型首次在国际通用智能评测体系中达到"第一梯队"水准,也证明了通过架构创新而非参数堆砌同样能实现顶尖性能。

部署指南:五分钟启动高效AI Agent

开发者可通过三种方式快速接入MiniMax-M2能力:

API调用

访问https://platform.minimaxi.com申请免费额度,支持工具调用格式自动生成,示例代码:

import requests

response = requests.post(

"https://api.minimax.io/v1/text/chatcompletion",

json={

"model": "minimax-m2",

"messages": [{"role": "user", "content": "用Python实现Redis分布式锁"}],

"tools": [{"type": "terminal"}]

}

)

本地部署

通过以下命令一键启动vLLM服务:

git clone https://gitcode.com/MiniMax-AI/MiniMax-M2

cd MiniMax-M2

pip install -r requirements.txt

python -m vllm.entrypoints.api_server --model . --tensor-parallel-size 4

产品体验

访问https://agent.minimaxi.com直接使用基于M2构建的AI Agent,支持终端、浏览器、代码解释器多工具协同。

结论与前瞻

MiniMax-M2以"大巧若拙"的设计哲学,证明了通过架构创新而非参数堆砌同样能实现顶尖性能。其100亿激活参数的高效模式,不仅解决了当前AI Agent部署的成本瓶颈,更指明了大模型未来发展的核心方向——从参数规模竞赛转向激活效率优化。

随着模型免费测试期延长至11月6日,以及SGLang、vLLM等推理框架的深度优化,MiniMax-M2正在构建完整的开源生态体系。对于企业而言,现在正是评估这一革命性技术的最佳时机,其可能成为2025年提升研发效率、降低AI应用门槛的关键基础设施。

未来,我们有理由期待MiniMax-M2在多模态能力、长上下文理解等领域的进一步突破。但就当下而言,这个重新定义效率标准的开源模型,已经为AI行业带来了改变游戏规则的力量。

欢迎收藏本文,关注获取《MiniMax-M2工具调用高级指南》独家资料,下期将揭秘如何构建基于M2的多智能体协作系统。欢迎在评论区分享你的部署体验,优质反馈将获得官方API额度奖励!

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/MiniMax-AI/MiniMax-M2

项目地址: https://ai.gitcode.com/MiniMax-AI/MiniMax-M2