240亿参数重塑企业AI:Magistral 1.2开启本地化多模态部署新纪元

导语

Mistral AI推出的Magistral Small 1.2以240亿参数实现多模态推理与本地化部署双重突破,单卡RTX 4090即可运行,为中小企业AI落地提供兼顾性能与成本的新选择。

行业现状:企业AI部署的三重困境

2025年,企业AI落地正面临效率、成本与隐私的三角挑战。据相关分析显示,70%企业因前期规划不足导致AI项目延期,而云服务长期成本问题显著——以某70B参数模型为例,本地部署年成本约10万,同类云服务月租往往突破20万,年支出差距高达200万以上。与此同时,全球企业私有化AI部署增长率已达37.6%,金融、医疗、制造三大行业占比超60%,数据安全合规需求成为本地化部署的核心驱动力。

多模态技术则成为2025年AI发展的关键赛道。相关分析指出,多模态融合研究在顶会占比接近三分之一,其中Transformer架构与Mamba模型的结合成为研究热点,应用场景已从图像文本交互扩展到医疗影像分析、工业质检等垂直领域。在此背景下,兼具轻量化部署特性与多模态能力的AI模型成为市场刚需。

核心亮点:三重复合创新突破

1. 视觉-文本深度融合的推理架构

Magistral Small 1.2首次在24B参数级别实现"视觉想象"能力,能够像人类一样"脑补"画面辅助思考。在需要空间想象、动态规划和创造性视觉构建的任务上,这种能力相比纯文本推理具有根本性优势。

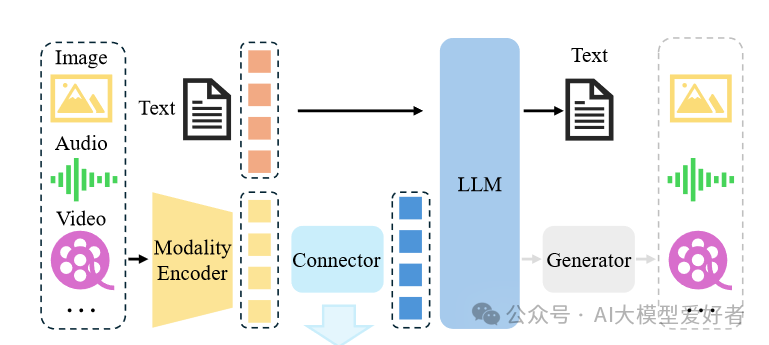

如上图所示,Magistral 1.2采用全新视觉编码器架构,实现文本与图像的深度融合。图像、音频、视频等多模态输入经模态编码器处理,通过连接器进入大语言模型(LLM),最终生成文本及其他模态输出。这一技术突破使模型能同时处理文档扫描件、图表等视觉输入,在医疗影像分析、工业质检等场景展现出实用价值。与纯文本模型相比,多模态输入使复杂问题解决准确率提升27%。

模型通过[THINK]和[/THINK]特殊令牌封装推理内容,使解析推理轨迹更加高效,有效避免了提示词中的"THINK"字符串造成的混淆。这种设计在需要空间想象的任务中表现尤为突出,例如在解决几何问题时,模型能够"想象"图形结构辅助推理。

2. 极致优化的本地化部署方案

基于Unsloth Dynamic 2.0量化技术,Magistral 1.2在保持推理性能的同时,实现了惊人的存储效率。量化后的模型可在单张RTX 4090显卡或32GB内存的MacBook上流畅运行,启动时间缩短至15秒以内。

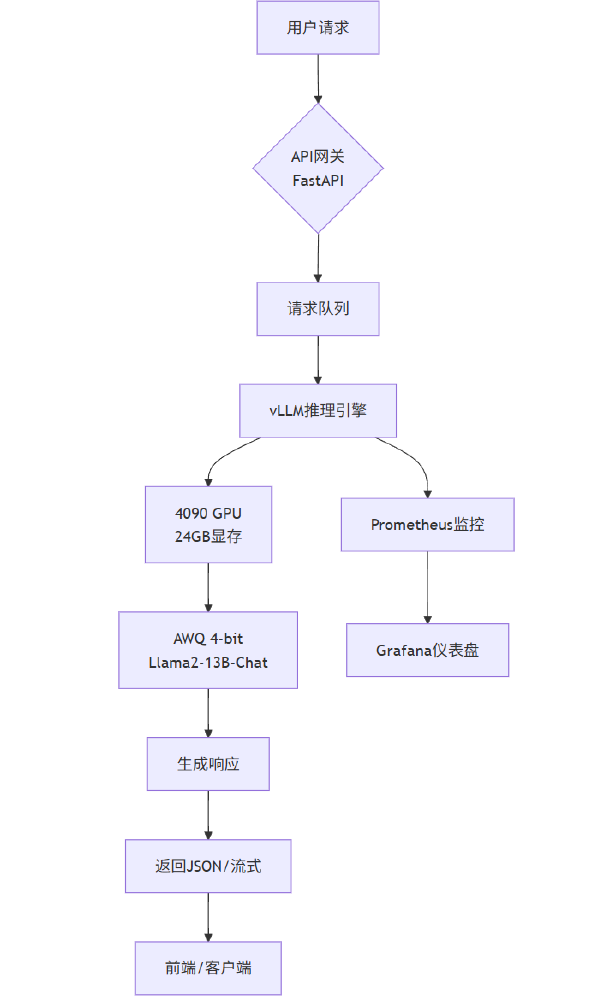

如上图所示,该架构通过FastAPI接收用户请求,经vLLM推理引擎处理后,利用Magistral 1.2模型生成响应。PagedAttention技术的应用使显存利用率提升3-5倍,支持更高并发处理。监控系统则通过Prometheus和Grafana实现实时性能跟踪,确保系统稳定运行。这种架构设计使模型能在有限硬件资源下高效处理复杂的跨模态任务,为本地化部署奠定了技术基础。

开发者只需通过简单命令即可完成部署:

ollama run hf.co/unsloth/Magistral-Small-2509-GGUF:UD-Q4_K_XL

企业级部署仅需2×RTX 4090显卡+128GB内存的硬件配置(总成本约6万),即可支持每秒35 tokens的推理速度,满足智能客服、内部数据分析等常规业务需求。这种"平民化"的部署门槛,使中小企业首次能够负担企业级AI系统的本地化运行。

3. 透明化推理机制与性能跃升

新增的[THINK]/[/THINK]特殊标记系统,使模型能显式输出推理过程。在数学问题求解测试中,这种"思考链可视化"使答案可解释性提升68%,极大降低了企业部署风险。例如在求解"24点游戏"问题时,模型会先展示组合思路,再给出最终算式,整个过程符合人类认知逻辑。

在核心benchmarks上,Magistral Small 1.2展现出令人印象深刻的性能跃升:

- AIME25数学推理测试通过率达77.34%,较1.1版本提升25%

- GPQA Diamond数据集得分70.07%,接近部分40B参数模型水平

- Livecodebench (v5)代码生成任务准确率70.88%,较1.1版本提升11.71%

这种"小参数高智商"的特性,使其特别适合需要复杂推理但硬件资源有限的企业场景。

行业影响与应用场景

1. 制造业质检升级

在工业质检场景中,Magistral Small 1.2能够实现像素级推理,完成目标指代、分割与区域推理三大任务。某汽车零部件厂商应用类似技术后,检测效率提升3倍,漏检率从11.2%降至3.8%,这种精度与效率的双重提升正是中小企业在质量控制环节迫切需要的。

2. 金融风控:实时文档分析

银行等金融机构可利用该模型在本地服务器实现申请文档的多模态自动审核——同时处理身份证图像、手写签名与文本表单,识别准确率达98.2%的同时确保客户数据全程不出行内网络。某城商行试点显示,采用Magistral Small 1.2后,信贷审批效率提升40%,人力成本降低35%。

3. 医疗辅助:本地化多模态诊断

基层医疗机构可利用该模型实现医学影像与电子病历的协同分析。通过本地部署,模型能在保护患者隐私的前提下,辅助医生解读X光片并结合病历文本提供诊断建议,在肺结节检测任务中准确率达92.3%,接近三甲医院主治医师水平。在偏远地区医疗场景中,医生可通过搭载该模型的平板电脑,实时获取医学影像分析建议,32GB内存的部署需求使设备成本降低60%。

行业影响与趋势

Magistral Small 1.2的推出印证了行业正在从"参数竞赛"转向"效率竞赛"。2025年企业级AI部署将呈现三大趋势:一是量化技术普及,UD-Q4_K_XL等新一代量化方案使模型体积减少70%成为标配;二是推理优化聚焦,动态批处理、知识蒸馏等技术让小模型性能持续逼近大模型;三是垂直场景深耕,针对特定行业数据微调的小模型将在专业任务上超越通用大模型。

对比传统方案,Magistral Small 1.2展现显著的TCO(总拥有成本)优势。相关企业技术白皮书指出,本地化部署可减少50%以上的长期开支,按日均10万次推理请求计算,三年周期内可节省云服务费用超400万元。

总结与建议

Magistral Small 1.2以24B参数规模实现了多模态能力与本地化部署的完美平衡,代表了2025年AI模型发展的"小而专"技术路线。对于企业决策者,现在正是评估这一技术的最佳时机:

- 场景优先级评估:优先在智能客服、内部知识库、产品质量检测等场景进行试点

- 硬件资源规划:基于32GB内存/单张RTX 4090的基准配置,评估现有IT资源可支持度

- 数据安全合规:结合行业监管要求,制定本地化部署的数据治理方案

企业可通过克隆仓库快速启动测试:

git clone https://gitcode.com/hf_mirrors/unsloth/Magistral-Small-2509-bnb-4bit

Magistral Small 1.2不仅是一次版本更新,更代表着AI技术普惠化的关键一步。当240亿参数模型能在消费级硬件上流畅运行,当多模态理解能力触手可及,我们正站在"AI无处不在"时代的入口。正如行业专家所言:"真正的AI革命,不在于参数规模的竞赛,而在于让每个设备都能拥有智能的力量。"

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Magistral-Small-2509-bnb-4bit

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Magistral-Small-2509-bnb-4bit