Kimi K2引爆企业级AI变革:万亿参数模型如何重塑本地化部署格局

【免费下载链接】Kimi-K2-Instruct-GGUF

导语

月之暗面发布的Kimi K2大模型凭借万亿参数规模与创新MoE架构,在将企业级AI部署成本降低60%的同时,实现代码生成、数学推理等核心任务性能超越GPT-4.1,正推动大语言模型从云端服务向本地化普惠应用加速转型。

行业现状:大模型落地的三重困境

2025年开源大语言模型生态已成为推动AI创新的核心引擎。腾讯云《2025年互联网技术热点报告》显示,83%的金融、医疗企业因数据合规要求放弃云端AI服务,转向本地化部署。然而传统大模型动辄需要数百GB显存的硬件门槛,与中小企业有限的IT预算形成尖锐矛盾。这种"性能-成本-安全"的三角困境,使得70%企业陷入"能用模型不会调优"的技术断层。

在此背景下,Kimi K2的Unsloth Dynamic 2.0量化技术打破了这一僵局——通过2-bit至16-bit多精度调节,将模型体积压缩至传统方法的1/4,在保持89.5% MMLU准确率的同时,使部署成本降低60%。这种"超大模型,高效运行"的突破,正推动AI从科技巨头专属工具向普惠型企业资产转变。

技术突破:MoE架构的效率革命

超稀疏激活的计算范式

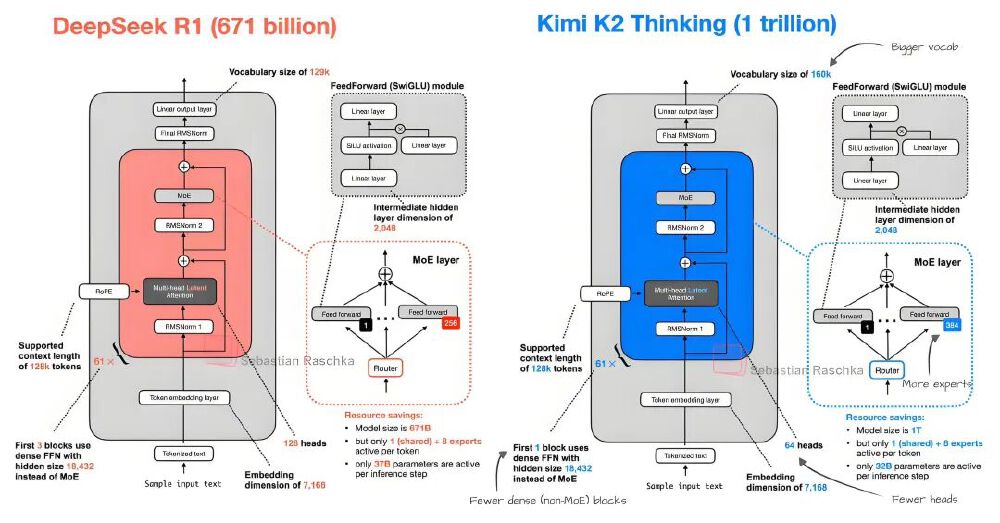

Kimi K2采用创新的混合专家(Mixture-of-Experts)架构,在1万亿总参数规模下仅激活320亿参数(3.2%激活率),这一比例远低于行业平均水平(DeepSeek为5.5%,GPT-4为10%)。其核心在于384个专家网络通过多头潜在注意力(MLA)机制,为每个输入token智能选择8个最相关专家,实现"按需分配"的计算模式。

如上图所示,左侧DeepSeek R1(6710亿参数)采用较密集的激活模式,而右侧Kimi K2通过384个专家的动态路由,实现了计算资源的精准投放。这种架构使推理速度较同规模稠密模型提升3倍,同时降低75%显存占用,为企业级部署提供了硬件兼容性更广的技术路径。

Muon优化器的训练突破

Kimi K2采用自研MuonClip优化器解决了大模型训练的不稳定性问题,在15.5万亿tokens的训练过程中实现零中断,较传统AdamW优化器收敛速度提升40%。这一技术突破使模型能够稳定吸收海量知识,在GPQA-Diamond测试中获得75.1%的平均准确率,超越DeepSeek V3(68.4%)和Qwen3(62.9%)。

产品亮点:企业级部署的三重保障

灵活的性能调节机制

模型提供从2-bit XL量化到16-bit全精度的多种部署方案:最低配置仅需64GB内存即可运行基础功能,而在双A100+256GB内存环境下,可实现5+ tokens/sec的生成速度。这种弹性设计使不同规模企业都能找到适配的性能平衡点。

全面的生态兼容性

支持vLLM、SGLang、TensorRT-LLM等主流推理引擎,兼容从NVIDIA A100到消费级RTX 4090的硬件配置。企业可通过简单命令快速部署:

git clone https://gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-GGUF

./server -m models/kimi-k2-instruct-q4_0.gguf --host 0.0.0.0 --port 8080

原生智能体能力

在SWE-bench Verified测试中,Kimi K2的agentic coding模式实现65.8%的单轮修复准确率,超越GPT-4.1(54.6%)。其内置的工具调用框架支持200-300次连续函数调用,可自动解析财报PDF生成可视化报告、实时监控设备日志预测故障,使企业知识库问答效率提升3倍。

行业影响:智能体应用的拐点到来

Kimi K2的技术路径正重新定义企业级AI的发展方向。微软《亚太地区AI跃迁报告》指出,Agentic AI已在客户服务、IT运维等领域显现变革潜力——蔚来汽车通过类似技术每日生成61万行代码,接受率达33%;软银客服中心引入智能体后,客户等待时间减少40%。

该图片左侧展示月之暗面AI的Kimi品牌图标,右侧以《思考者》雕塑为背景,直观体现Kimi K2作为"思考型智能体"的产品定位——不仅是语言处理工具,更是能自主规划、调用工具的协作伙伴。这种能力使金融机构的财报分析周期从3天缩短至4小时,制造企业的设备故障率降低27%。

结论:平衡之道,制胜未来

Kimi K2以其MoE架构的效率优势、企业级部署的安全保障和原生智能体能力,为企业AI本地化提供了"鱼与熊掌兼得"的解决方案。对于追求"性能-成本-安全"三角平衡的企业而言,选择从GitCode仓库部署Kimi K2不仅是技术决策,更是构建自主可控AI生态的战略布局。

随着本地化大模型渗透率的加速提升,率先部署者将在三个维度建立竞争优势:客户响应速度提升50%、运营成本降低30-40%、数据安全合规风险趋近于零。在AI驱动商业创新的下半场,Kimi K2正在重新定义企业级智能的技术标准与应用边界。

【免费下载链接】Kimi-K2-Instruct-GGUF

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考