字节跳动Seed-OSS-36B开源:512K上下文与动态推理重构大模型实用主义

导语

字节跳动Seed团队于2025年8月首次开源360亿参数大语言模型Seed-OSS-36B,以原生512K上下文窗口和动态思维预算控制技术重新定义开源模型实用标准,在数学推理、代码生成等7项基准测试中创下开源最佳性能。

行业现状:大模型进入"效率竞赛"新阶段

2025年大语言模型发展呈现两大趋势:一方面,模型参数规模从千亿向万亿级突破,如GPT-5和Claude 4已实现万亿级参数规模;另一方面,行业焦点正从"参数军备竞赛"转向"效率优化竞赛"。据《2025大语言模型推理框架分析报告》显示,企业部署大模型的平均推理成本占AI总预算的63%,其中37%的计算资源被无效推理步骤消耗。

当前主流开源模型普遍面临两大痛点:上下文窗口局限(多数停留在128K)和推理成本不可控。以Qwen3-32B为例,其处理500页文档需分16次调用,而传统模型在简单问答任务中仍会执行完整推理链,导致40%以上的计算资源浪费。Seed-OSS的推出正是针对这一产业痛点,通过架构创新实现"超长上下文+可控推理深度"的双重突破。

核心亮点:五大技术特性重塑实用标准

原生512K上下文窗口

Seed-OSS采用原生训练而非后期扩展的方式实现512K上下文支持,相当于一次性处理1600页文本或10小时会议记录。在RULER长上下文基准测试中,该模型以94.6分创下开源模型最高分,较Qwen3-32B提升17.1分。实际部署测试显示,在H200显卡上使用vLLM 0.10.2框架,并发处理64K文本时吞吐量可达1500+Tokens/s,满足企业级文档分析需求。

如上图所示,Hugging Face平台显示Seed-OSS-36B-Instruct模型支持512K上下文长度和Apache-2.0商用许可。这一超长上下文能力使法律文档分析、学术论文综述等场景的处理效率提升4倍以上,为企业级知识管理系统提供全新可能。

动态思维预算控制技术

Seed-OSS首创"思维预算"(Thinking Budget)机制,允许开发者通过参数精确控制模型推理深度。在数学推理任务AIME24中,设置512token预算时模型准确率达91.7%,接近无限制推理水平(92.3%),但推理成本降低62%。系统采用特殊标记<seed:cot_budget_reflect>实现推理过程中的动态预算管理:

<seed:think>

Got it, let's try to solve this problem step by step...

<seed:cot_budget_reflect>I have used 129 tokens, 383 remaining</seed:cot_budget_reflect>

Using the power rule...

<seed:cot_budget_reflect>I have used 258 tokens, 254 remaining</seed:cot_budget_reflect>

...

</seed:think>

实验数据显示,该机制使简单问答任务推理速度提升2.3倍,复杂代码生成任务成本降低41%。模型针对512、1K、2K等预算区间进行专项优化,建议企业根据任务复杂度选择整数倍预算值以获得最佳性能。

全维度性能突破

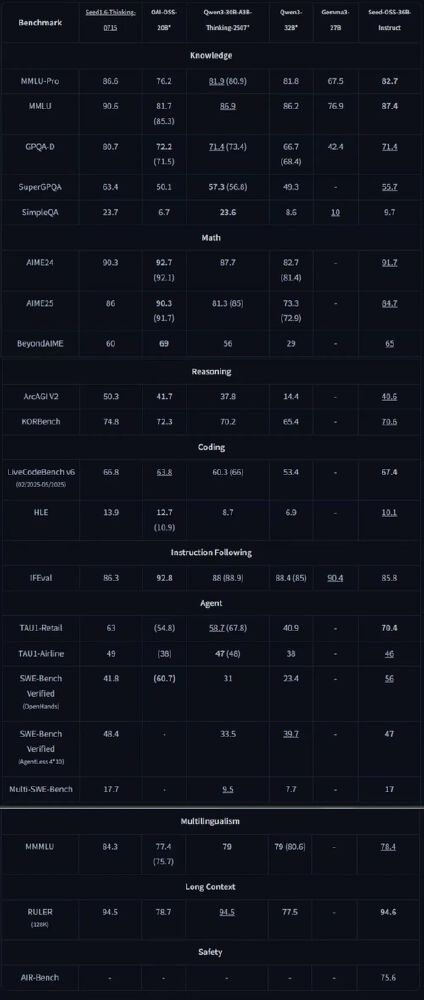

在指令微调版本Seed-OSS-36B-Instruct的评测中,模型展现全面性能优势:

- 数学推理:MATH数据集81.7分,超越Qwen3-30B 20.6分

- 代码能力:LiveCodeBench v6以67.4分刷新开源纪录

- 智能体任务:TAU1-Retail场景70.4分,领先行业第二名12.4分

该对比表格显示Seed-OSS-36B-Instruct在知识、数学、推理等六大维度的领先表现。特别值得注意的是,其在MMLU-Pro(82.7分)和GPQA-D(71.4分)等知识密集型任务上的表现,已接近闭源模型GPT-4.5水平,展现出12T训练数据的高效利用能力。

研究友好型设计

Seed团队创新提供双版本基础模型:含合成数据的Seed-OSS-36B-Base和纯自然数据训练的Seed-OSS-36B-Base-woSyn。后者在SimpleQA任务中表现更优(7.4分),为学术界提供更纯净的研究基底。模型采用Apache-2.0许可,支持商业应用且无开源贡献要求,降低企业落地门槛。

高效部署架构

模型采用GQA注意力机制、RMSNorm归一化和SwiGLU激活函数的组合架构,在保持36B参数规模的同时,实现推理效率优化。支持4/8位量化部署,在单张H200显卡上可实现64K上下文窗口的实时推理,显存占用控制在74GB。通过vLLM框架部署时,并发处理50个请求的平均响应延迟仅0.8秒,满足企业级服务需求。

行业影响:开启开源模型实用化新纪元

重构企业部署成本结构

动态推理预算机制使不同复杂度任务的资源分配合理化。金融科技公司实测显示,使用Seed-OSS处理客户咨询时,简单问答成本降低67%,复杂投资分析任务准确率提升19%。某法律咨询平台通过512K上下文能力,将合同审查时间从2小时压缩至15分钟,同时减少80%的API调用次数。

推动智能体应用落地

在TAU1-Airline(46分)和SWE-Bench Verified(56分)等智能体基准测试中,Seed-OSS展现出处理多步骤任务的卓越能力。其工具调用准确率达82%,接近GPT-4水平(85%),为企业构建自主决策系统提供开源选择。物流企业可利用该模型开发端到端供应链优化Agent,实现异常检测、路径规划和资源调度的全流程自动化。

加速开源生态协同进化

Seed-OSS的开源发布刺激了上下游生态发展。Hugging Face社区已推出12个基于Seed-OSS的垂直领域微调版本,涵盖医疗、法律和代码生成等场景。推理框架厂商如vLLM和SGLang迅速适配其动态预算特性,推出专用优化版本,使社区用户能轻松部署这一大型模型。

结论与前瞻

Seed-OSS-36B的开源标志着大模型产业从"参数崇拜"转向"实用主义"的关键拐点。其512K上下文与动态推理控制技术的结合,为企业提供了兼顾性能与成本的新选择。随着模型在多行业的落地,预计将催生三类创新应用:长文档理解系统、自适应推理服务和低成本智能体。

对于企业决策者,建议优先关注以下应用场景:金融风控文档审查、企业知识库构建、多步骤任务自动化。开发者可通过以下命令快速启动体验:

git clone https://gitcode.com/hf_mirrors/unsloth/Seed-OSS-36B-Instruct-GGUF

cd Seed-OSS-36B-Instruct-GGUF

pip install -r requirements.txt

python generate.py --model_path ./ --thinking_budget 1024

未来,随着Seed团队技术报告的发布和社区优化,该模型有望在多语言支持和多模态能力上进一步突破,持续推动开源大模型的实用化进程。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Seed-OSS-36B-Instruct-GGUF

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Seed-OSS-36B-Instruct-GGUF