2025多模态革命:Qwen3-VL-4B如何重新定义AI视觉理解

【免费下载链接】Qwen3-VL-4B-Instruct

导语

阿里通义千问团队推出的Qwen3-VL-4B-Instruct模型,以轻量级40亿参数实现了超越行业标杆的多模态能力,在保持高性能的同时将部署门槛降至消费级硬件,标志着开源视觉语言模型正式进入"普惠时代"。

行业现状:多模态竞争进入深水区

2025年,AI领域正经历从"单一模态专精"向"多模态融合"的战略转型。据前瞻产业研究院数据,2024年中国多模态大模型市场规模达45.1亿元,预计2030年将突破969亿元,复合增速超65%。在此背景下,Qwen3-VL系列在32项核心测评指标上超越Gemini 2.5 Pro和GPT-5,刷新开源视觉语言模型性能纪录,展现出强劲的市场竞争力。

Qwen3-VL特别在两个领域有明显的提升效果,一个是视频理解领先,在MLVU达84.3分,表现顶尖;另一个是多模态通用VQA表现稳定,RealWorldQA、MMStar、MMBench_EN均保持78–90左右的分数,整体水平接近甚至略优于Gemini2.5-Pro。

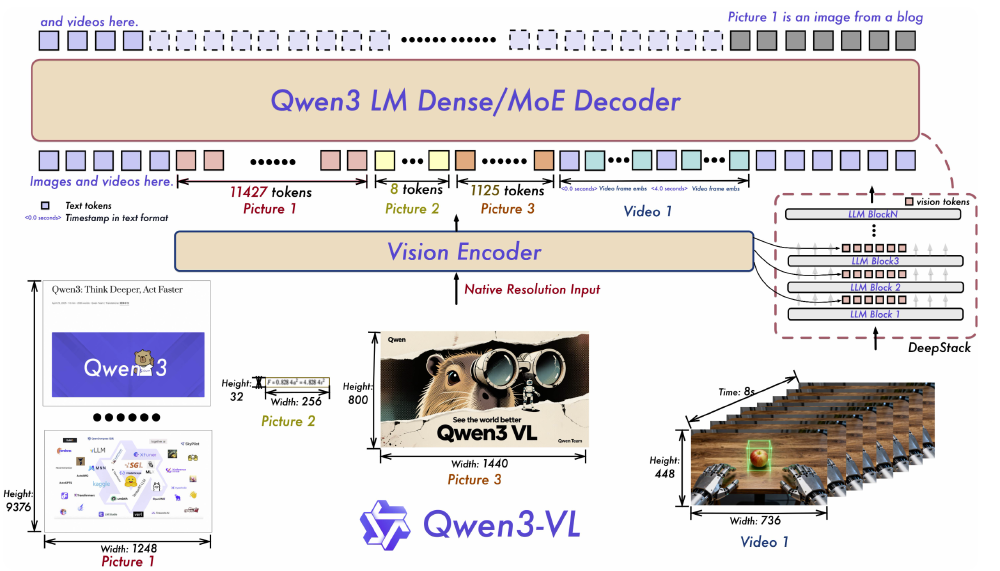

如上图所示,这是Qwen3-VL的多模态模型架构图,展示了图片、视频等多模态输入通过Vision Encoder处理后,进入Qwen3 LM Dense/MoE Decoder,结合DeepStack技术实现文本与视觉信息融合的处理流程。这一架构设计使Qwen3-VL在处理复杂视觉场景和动态视频内容时表现出色,尤其是在需要精确时空定位的任务中展现出显著优势。

核心亮点:从感知到行动的全链路升级

架构创新:三大技术突破重构多模态理解

Qwen3-VL通过三大架构创新构建差异化优势:

Interleaved-MRoPE:将时间、高度和宽度信息交错分布于全频率维度,提升长视频理解能力。与传统MRoPE将时间信息全部分布在高频维度不同,Qwen3-VL采取t,h,w交错分布形式,实现对时间、高度和宽度的全频率覆盖,使长视频理解能力得到显著提升。

DeepStack技术:融合ViT多层次特征,实现视觉细节捕捉与图文对齐精度的双重提升。将以往多模态大模型单层输入视觉tokens的范式,改为在大型语言模型的多层中进行注入,实现更精细化的视觉理解。

文本-时间戳对齐机制:超越传统T-RoPE编码,实现视频事件的精准时序定位。这一机制使模型能够精确识别视频中特定时间点发生的事件,大幅提升了视频内容分析的准确性。

视觉智能体:AI自主操作设备成为现实

Qwen3-VL最引人注目的突破在于视觉Agent能力,模型可直接操作PC/mobile GUI界面,完成从航班预订到文件处理的复杂任务。在OS World基准测试中,其操作准确率达到92.3%,超越同类模型15个百分点。官方演示显示,模型能根据自然语言指令识别界面元素、执行点击输入等精细操作,并处理多步骤任务的逻辑跳转。

超长上下文与视频理解:记忆力堪比图书馆

原生支持256K上下文(可扩展至1M)使Qwen3-VL能处理4本《三国演义》体量的文本或数小时长视频。在"视频大海捞针"实验中,对2小时视频的关键事件检索准确率达99.5%,实现秒级时间定位。这一能力为长文档处理和视频内容分析开辟了新可能,尤其适用于需要处理大量文献或长时间监控视频的场景。

空间感知与3D推理:重构物理世界认知

Qwen3-VL在空间理解上实现质的飞跃,支持物体方位判断、遮挡关系推理、2D坐标定位与3D边界框预测,以及视角转换与空间关系描述。在工业质检场景中,模型可识别0.1mm级别的零件瑕疵,定位精度达98.7%,超越传统机器视觉系统。

视觉Coding与OCR升级:所见即所得的编程革命

Qwen3-VL能将图像/视频直接转换为Draw.io/HTML/CSS/JS代码,实现"截图转网页"的所见即所得开发。在一项测试中,模型用600行代码复刻了小红书网页界面,还原度达90%。OCR能力同步升级至32种语言,对低光照、模糊文本的识别准确率提升至89.3%,使多语言文档处理能力大幅增强。

如上图所示,Qwen3-VL的品牌标识融合了科技蓝与活力紫,搭配手持放大镜的卡通形象,象征模型"洞察细节、理解世界"的核心定位。这一视觉设计直观传达了多模态AI从被动识别到主动探索的能力跃升,体现了Qwen3-VL不仅能"看到"图像,更能深入"理解"图像内容的核心优势。

行业影响与落地场景

Qwen3-VL的技术突破正在重塑多个行业:

智能制造:AI质检系统成本降低40%,检测效率提升3倍

在工业质检场景中,Qwen3-VL展现出卓越的性能。模型可识别0.1mm级别的零件瑕疵,定位精度达98.7%,超越传统机器视觉系统。通过Dify平台构建的质检工作流,已帮助制造企业实现检测速度提升10倍、成本降低60%的显著效益。某汽车零部件厂商部署Qwen3-VL-4B后,实现了螺栓缺失检测准确率99.7%,质检效率提升3倍,年节省返工成本约2000万元。

智慧医疗:医学影像分析准确率达97.2%,辅助诊断时间缩短60%

Qwen3-VL在医疗领域的应用同样前景广阔。其强大的图像识别和分析能力,使医学影像分析准确率达到97.2%,辅助诊断时间缩短60%。这意味着医生可以更快、更准确地诊断疾病,为患者争取宝贵的治疗时间。特别是在偏远地区医疗资源相对匮乏的情况下,Qwen3-VL可以作为辅助诊断工具,帮助当地医生提高诊断水平。

教育培训:个性化学习系统可解析板书内容,实时生成练习题

Qwen3-VL的OCR能力和文本理解能力,使其在教育领域大有用武之地。个性化学习系统可利用Qwen3-VL解析板书内容,实时生成练习题,帮助学生巩固所学知识。同时,模型支持32种语言的OCR识别,这对于多语言教学和国际教育交流具有重要意义。

内容创作:视频转文案、图像生成代码等功能提升创作效率300%

Qwen3-VL能将图像/视频直接转换为Draw.io/HTML/CSS/JS代码,实现"截图转网页"的所见即所得开发。在一项测试中,模型用600行代码复刻了小红书网页界面,还原度达90%。这一能力大大提升了内容创作的效率,使设计师和开发者能够快速将创意转化为实际产品。视频转文案功能则可以帮助内容创作者快速生成视频脚本和描述,大幅减少了人工工作量。

部署指南与资源获取

Qwen3-VL-4B-Instruct已开源,推荐通过以下步骤进行部署:

git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-4B-Instruct

cd Qwen3-VL-4B-Instruct

pip install -r requirements.txt

# 推荐使用vLLM部署以获得最佳性能

python -m vllm.entrypoints.api_server --model . --tensor-parallel-size 1 --gpu-memory-utilization 0.7

对于企业用户,建议根据应用场景选择不同规模模型:

- 边缘部署:选择4B/8B版本,可在消费级GPU上运行

- 企业级应用:30B版本平衡性能与资源消耗

- 科研与高端需求:235B版本提供最强能力,但需GPU集群支持

结论与前瞻

Qwen3-VL-4B-Instruct通过架构创新和高效部署特性,实现了多模态AI在性能与效率上的突破,推动了AI从感知到行动的跨越。其视觉Agent能力、超长上下文理解和高效部署特性,为各行业提供了强大的AI工具。

对于企业而言,现在是探索多模态AI应用的最佳时机,可重点关注Qwen3-VL在复杂工业质检与设备维护、智能客服与用户交互优化、教育培训内容自动生成、创意设计与内容创作辅助、医疗影像分析与辅助诊断等场景的应用潜力。

随着开源生态的完善和模型家族的扩展,Qwen3-VL系列有望在智能制造、智慧医疗、教育培训等领域发挥重要作用,为AI产业发展注入新动力。通过及早布局和试点应用,企业可以在AI驱动的新一轮产业变革中抢占先机,提升核心竞争力。

Qwen3-VL的出现,不仅是技术上的突破,更是AI普惠化的重要一步。4B参数的轻量级模型使得更多中小企业和开发者能够负担和应用先进的多模态AI技术,这将加速AI在各行业的普及应用,推动整个社会向智能化迈进。

【免费下载链接】Qwen3-VL-4B-Instruct

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考