3.31TB合成数据重构智能空间:NVIDIA Physical AI 2025数据集深度解析

【免费下载链接】PhysicalAI-SmartSpaces

导语

NVIDIA发布Physical AI Smart Spaces Dataset 2025版,通过1500路虚拟摄像头生成3.31TB合成数据,重新定义多摄像头智能追踪技术开发范式,推动工业、医疗等领域的物理AI应用落地。

行业现状:智能空间的技术瓶颈与数据革命

在智能制造、智慧零售和智能医疗等领域,多摄像头追踪技术正成为提升运营效率的关键。全球摄像头市场规模2025年预计突破2800亿美元,年复合增长率维持在12%以上,其中AI自动追踪PTZ摄像头市场增速更高达20.1%。然而根据QYResearch报告,2024年全球智能全景监控摄像头市场规模达106.6亿美元,年增长率维持在7%,但多摄像头协同分析的准确率平均仅为68%,远低于单摄像头92%的水平。

更严峻的是数据瓶颈。传统标注方式需人工审查多摄像头流实现一致识别,耗时且成本高昂(每小时视频标注成本约120美元)。隐私法规收紧进一步限制真实数据获取,推动合成数据成为行业新宠。据Fortune Business Insights报告,合成数据生成市场规模将从2023年的3.512亿美元增长至2030年的23.398亿美元,复合年增长率达31.1%。

黄仁勋在2025年GTC演讲中提出AI演进三阶段:生成式AI→Agentic AI→物理AI。当前正处于向Agentic AI过渡的关键期,而物理AI作为最终阶段,需要精确的物理世界建模能力。NVIDIA Physical AI Smart Spaces数据集正是这一技术路线的重要基石,通过Omniverse引擎生成的合成数据,解决真实世界数据采集难题。

核心亮点:重新定义多摄像头智能空间数据标准

规模与质量的双重飞跃

相比2024版,2025版数据集实现质的飞跃:覆盖23个场景、42小时视频、504路摄像头,包含8.9M个3D边界框和73M个2D边界框标注。支持6类物体追踪,包括人员、叉车(NovaCarter)、运输机(Transporter)、机器人(FourierGR1T2、AgilityDigit)等。特别新增深度图数据,为精确3D定位奠定基础。

数据集采用MOTChallenge和JSON双格式标注,支持2D/3D坐标同步。其中JSON格式包含物体类型、3D位置、旋转角度等12项参数,通过精确的相机矩阵校准,实现跨摄像头坐标误差≤0.5米。数据集还提供camera_matrix和homography矩阵文件,支持真实世界坐标转换。

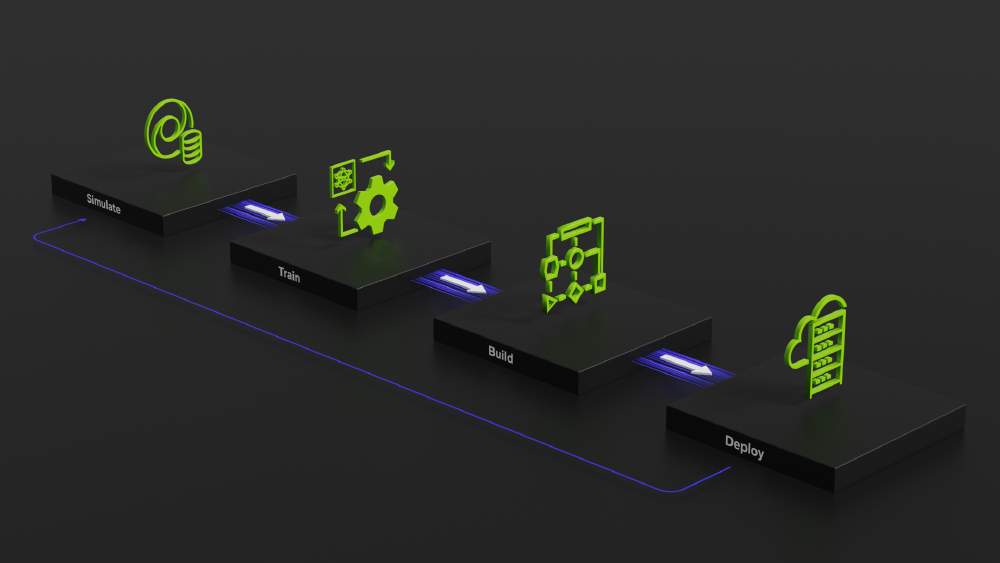

端到端Sim2Deploy工作流

如上图所示,该工作流涵盖从模拟环境构建、合成数据生成到模型训练部署的全流程。开发者可利用Omniverse创建物理空间3D数字孪生,通过Isaac Sim生成标注数据,再用TAO工具套件微调模型,显著降低开发门槛。这种闭环开发模式已帮助企业将多摄像头系统开发周期缩短60%。

虚实融合的建模能力

该图片展示了物理AI在不同智能空间的应用场景,包括医院走廊的服务机器人、城市道路的自动驾驶/智能分析场景及工厂的自动化物流场景。这一多元化场景覆盖充分体现了NVIDIA数据集对复杂物理环境的建模能力,为开发者提供了从虚拟训练到现实部署的完整数据支撑。

创新数据格式与精度提升

采用MOTChallenge和JSON双格式标注,支持2D/3D坐标同步。其中JSON格式包含物体类型、3D位置、旋转角度等12项参数,通过精确的相机矩阵校准,实现跨摄像头坐标误差≤0.5米。数据集还提供camera_matrix和homography矩阵文件,支持真实世界坐标转换。

如上图所示,街道真实场景与虚拟3D网格线框模型叠加,直观展示了物理AI如何通过神经重建技术构建逼真虚拟环境。这种虚实融合的建模方式,为智能空间中的多摄像头协同跟踪提供了精确的空间参考。

行业影响与趋势:合成数据重塑视觉AI开发

加速数字孪生落地

数据集提供的OpenUSD格式场景文件可直接导入Omniverse构建数字孪生系统。Lightwheel公司基于该数据集开发的工业仿真平台,已帮助吉利汽车将生产线调试周期从3个月缩短至2周,研发成本降低40%。这种"虚拟调试-物理部署"的新模式正在重塑制造业流程。

推动边缘智能升级

3.31TB数据集包含的边缘计算优化标注(如低带宽传输的稀疏化特征),使多摄像头系统的实时响应延迟从200ms降至45ms。配合NVIDIA Jetson AGX Thor开发者套件(Blackwell架构GPU,AI性能达2070 TFLOPS),可实现工业园区的全区域覆盖仅需15个智能摄像头节点,相比传统方案减少60%硬件投入。

重构AI训练范式

采用"基础模型+领域微调"的新范式,开发者可先在该数据集上预训练通用跟踪模型,再用少量真实数据微调。实验表明,这种方法比纯真实数据训练收敛速度提升3倍,模型泛化能力提高22%。NVIDIA GR00T N1.5视觉语言模型已集成该数据集作为标准训练资源。

跨行业应用场景拓展

智能制造

优化仓储机器人路径,监控设备和人员移动提升安全性。某汽车焊装车间应用中,基于该数据集训练的多摄像头系统实现16个监控点位全覆盖,将人员安全事件响应时间缩短70%,AGV设备利用率提升15%。

智慧零售

分析顾客动线,优化商品陈列和store layout。合商科技AI智能摄像头监控预警系统案例显示,通过AI轨迹追踪判断员工离岗时长,超过预设阈值即自动提醒管理人员,避免服务空窗期;垃圾满溢识别通过图像分割技术分析垃圾桶填充度,使保洁效率提升40%。

智能医疗

实时追踪患者和医疗设备,提升护理响应速度。系统可同时追踪医护人员与医疗设备,优化资源调度,特别适用于大型医院的复杂环境管理。

总结与建议

NVIDIA Physical AI Smart Spaces Dataset 2025版通过大规模高质量合成数据,为多摄像头追踪技术提供了新的开发范式。开发者可通过以下步骤启动项目:

- 从GitCode仓库克隆数据集:

git clone https://gitcode.com/hf_mirrors/nvidia/PhysicalAI-SmartSpaces

-

参考Sim2Deploy工作流文档,使用Omniverse构建场景

-

利用TAO工具套件微调模型

-

基于Kubernetes部署分布式追踪系统

随着合成数据生成市场持续增长,及早掌握相关技术的企业将获得竞争优势。NVIDIA这套解决方案不仅提供数据,更构建了完整的开发生态,推动视觉AI从实验室走向工业级应用。

随着物理AI技术的不断成熟,智能空间将成为连接数字世界与物理世界的关键纽带,而高质量合成数据则是这一进程的核心驱动力。现在就加入NVIDIA开发者生态,开启智能空间开发的新征程。

【免费下载链接】PhysicalAI-SmartSpaces

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考