Qwen3-Coder-30B-A3B-Instruct-FP8:新一代智能编码模型重磅发布

核心亮点

Qwen3-Coder系列现已推出多规格版本,本次全新发布的Qwen3-Coder-30B-A3B-Instruct-FP8模型在保持卓越性能的同时实现了效率跃升,其核心优势包括:

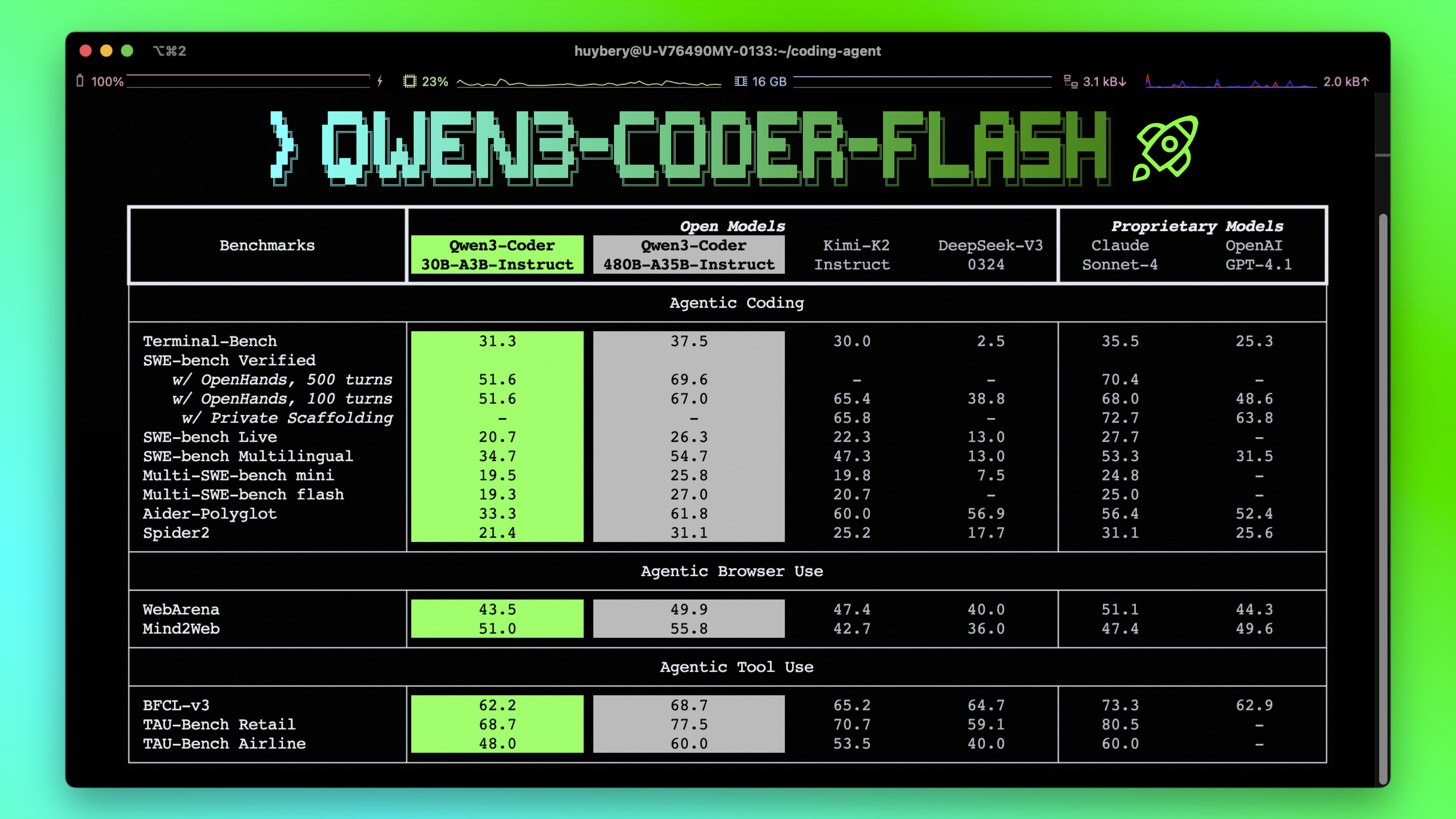

- 在开源模型中展现领先性能,尤其在智能编码代理、浏览器协同操作等核心编程任务中表现突出

- 原生支持256K上下文窗口,通过Yarn技术可扩展至100万tokens,完美适配大型代码库级别的理解需求

- 深度优化智能代理编码能力,兼容Qwen Code、CLINE等主流开发平台,采用专属设计的函数调用格式

模型架构解析

Qwen3-Coder-30B-A3B-Instruct-FP8具备以下技术特性:

- 模型类型:因果语言模型

- 训练阶段:预训练与指令微调双阶段优化

- 参数规模:总计305亿参数,激活参数33亿

- 网络结构:48层Transformer架构,采用GQA注意力机制(32个查询头,4个键值头)

- 专家系统:128个专家网络,每轮推理动态激活8个专家

- 上下文能力:原生支持262,144 tokens超长文本处理

重要提示:该模型仅支持非思考模式输出,不会生成</think>superscript:格式代码块。同时不再需要额外设置enable_thinking=False参数。

关于模型的详细评测数据、硬件配置要求及推理性能指标,可参考技术博客、代码仓库及官方文档获取完整信息。

如上图所示,该概述图系统展示了Qwen3-Coder-30B-A3B-Instruct-FP8的技术架构与核心能力。这一可视化呈现直观反映了模型在参数效率与性能之间的精妙平衡,为开发者理解模型工作原理提供了清晰指引。

如上图所示,该概述图系统展示了Qwen3-Coder-30B-A3B-Instruct-FP8的技术架构与核心能力。这一可视化呈现直观反映了模型在参数效率与性能之间的精妙平衡,为开发者理解模型工作原理提供了清晰指引。

快速上手指南

建议使用最新版本的transformers库进行开发。请注意,当transformers版本低于4.51.0时可能出现以下错误:

KeyError: 'qwen3_moe'

以下代码示例展示了如何使用模型进行文本生成:

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3-Coder-30B-A3B-Instruct-FP8"

# 加载分词器与模型

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# 准备输入数据

prompt = "实现快速排序算法"

messages = [

{"role": "user", "content": prompt}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

)

model_inputs = tokenizer([text], return_tensors="pt").to(model.device)

# 执行文本生成

generated_ids = model.generate(

**model_inputs,

max_new_tokens=65536

)

output_ids = generated_ids[0][len(model_inputs.input_ids[0]):].tolist()

content = tokenizer.decode(output_ids, skip_special_tokens=True)

print("生成结果:", content)

内存优化建议:如遇内存溢出(OOM)问题,可尝试将上下文长度调整为32,768等较小数值。

FP8量化技术说明

为兼顾使用便捷性与推理性能,Qwen3提供了FP8量化版本(模型名称以-FP8结尾)。该版本采用128块大小的细粒度FP8量化方案,具体配置可参考config.json中的quantization_config字段。

Qwen3-30B-A3B-Instruct-FP8模型可无缝对接transformers、sglang、vllm等主流推理框架,使用方式与原始bfloat16版本一致。使用中请注意以下已知问题:

- transformers框架:在分布式推理场景下,"细粒度fp8"方法存在兼容性问题。多设备推理时需设置环境变量

CUDA_LAUNCH_BLOCKING=1

智能代理编码能力

Qwen3-Coder在工具调用方面表现卓越,支持自定义工具集成,以下为使用示例:

# 工具实现

def square_the_number(num: float) -> dict:

return num ** 2

# 工具定义

tools=[

{

"type":"function",

"function":{

"name": "square_the_number",

"description": "计算输入数字的平方值",

"parameters": {

"type": "object",

"required": ["input_num"],

"properties": {

'input_num': {

'type': 'number',

'description': '需要计算平方的数字'

}

},

}

}

}

]

import OpenAI

# 配置语言模型客户端

client = OpenAI(

# 连接兼容OpenAI API的自定义服务端点

base_url='http://localhost:8000/v1', # API基础地址

api_key="EMPTY"

)

messages = [{"role": 'user', 'content': '计算1024的平方值'}]

completion = client.chat.completions.create(

messages=messages,

model="Qwen3-Coder-30B-A3B-Instruct-FP8",

max_tokens=65536,

tools=tools,

)

print(completion.choice[0])

最佳实践建议

为充分发挥模型性能,推荐采用以下配置策略:

-

采样参数设置:

- 建议使用temperature=0.7,top_p=0.8,top_k=20,repetition_penalty=1.05的组合参数

-

输出长度配置:对于大多数指令任务,推荐设置65,536 tokens的输出长度,可满足复杂代码生成需求

引用说明

如果您的研究或工作受益于本模型,欢迎引用相关技术报告:

@misc{qwen3technicalreport,

title={Qwen3 Technical Report},

author={Qwen Team},

year={2025},

eprint={2505.09388},

archivePrefix={arXiv},

primaryClass={cs.CL},

url={https://arxiv.org/abs/2505.09388},

}

Qwen3-Coder-30B-A3B-Instruct-FP8模型的发布,标志着开源编码模型在智能代理能力与长上下文理解方面的重要突破。通过创新的A3B架构与FP8量化技术,该模型成功平衡了性能与效率,为开发者提供了处理复杂编程任务的全新工具。随着模型生态的不断完善,Qwen3-Coder系列有望在软件研发自动化、智能开发助手等领域发挥更大价值。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-Coder-30B-A3B-Instruct-FP8

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-Coder-30B-A3B-Instruct-FP8