英伟达OpenReasoning-Nemotron:中小参数模型实现数学竞赛级推理能力

导语

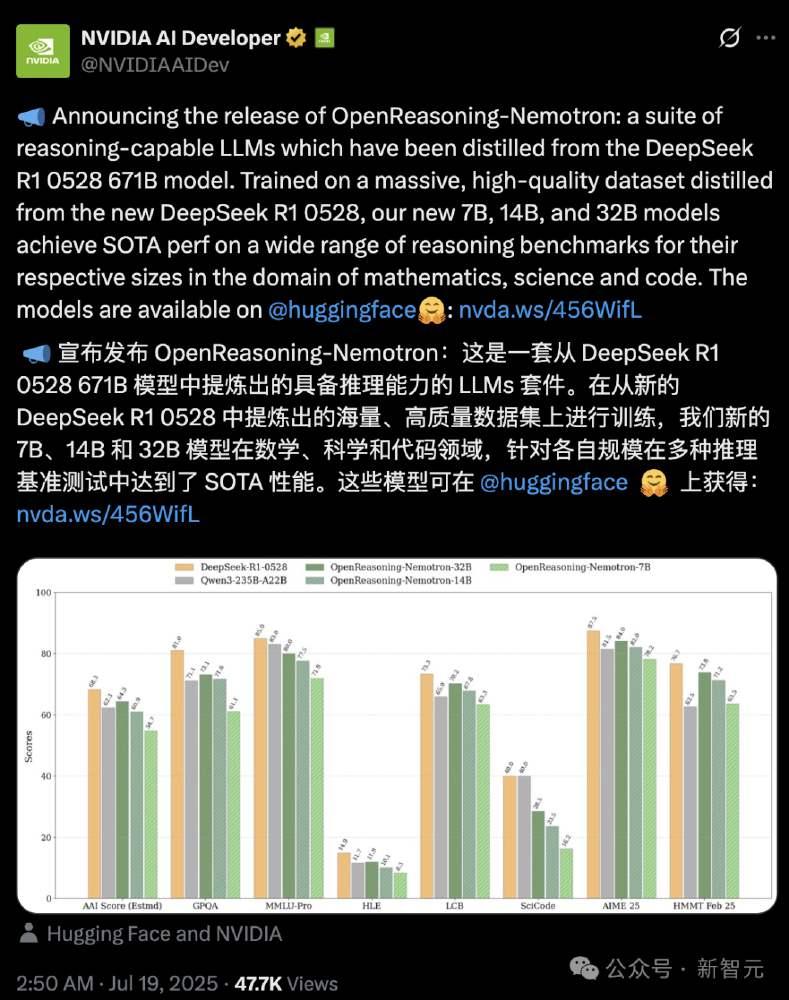

英伟达发布OpenReasoning-Nemotron系列推理模型,通过数据蒸馏技术将超大规模模型能力压缩至1.5B至32B参数范围,首次实现消费级GPU运行高精度数学、科学与代码推理任务。

行业现状:推理模型的"规模困境"

当前大语言模型推理能力高度依赖参数规模,如DeepSeek R1 671B虽在数学竞赛中表现优异,但需数十万美元GPU集群支持。2025年ACL大会报告显示,超过78%的企业因硬件成本限制无法部署先进推理模型。在此背景下,英伟达通过"教师-学生"蒸馏技术,将超大规模模型能力压缩至消费级硬件可承载的参数范围,32B版本在AIME24数学竞赛中取得89.2分,接近人类金牌水平(90分)。

如上图所示,该图片展示了OpenReasoning-Nemotron系列的技术起源与核心性能指标,包括模型源自DeepSeek R1 0528蒸馏、参数规模分布(1.5B至32B)及在AIME、HMMT等数学竞赛中的得分。这一架构设计打破了"性能-成本"的线性关系,为中小企业及研究者提供了高性能推理工具。

核心亮点:三大技术突破重构推理范式

1. 纯监督微调实现SOTA性能

不同于传统模型依赖强化学习(RLHF),英伟达使用NeMo Skills流水线生成500万个数学、科学和代码解决方案,通过纯监督学习微调。32B模型在LiveCodeBench编码基准中达到70.2分,超过同规模Qwen2.5-32B-Instruct 22%,且训练成本降低60%。

2. GenSelect多智能体协同推理

模型支持"重型推理模式",通过并行生成多个解决方案并自动筛选最优解(基于论文GenSelect)。在HMMT数学竞赛中,32B模型GenSelect模式准确率达96.7%,超越OpenAI o3-high(92.3%),成为首个在高中数学奥赛中超越商业模型的开源方案。

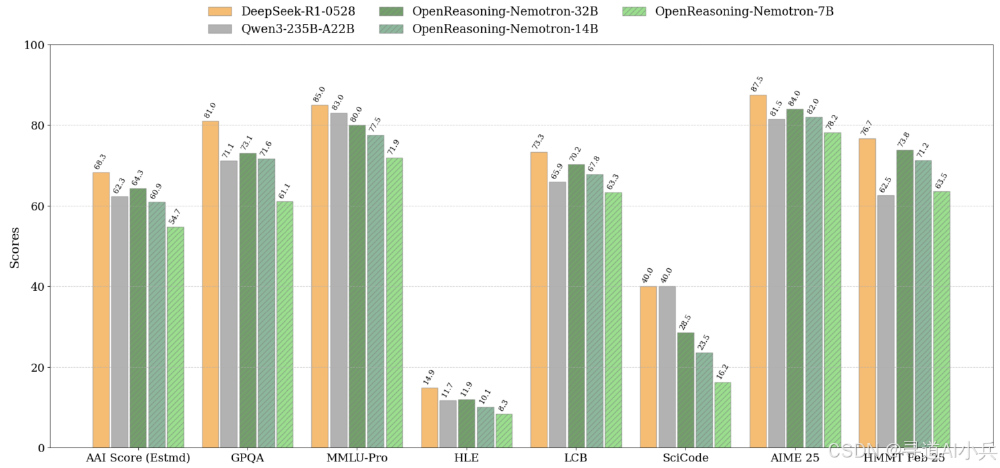

从图中可以看出,柱状图对比了DeepSeek-R1-0528、OpenReasoning-Nemotron系列及Qwen3在AIME Score、GPQA、MMLU-Pro等6项基准的表现。32B模型在数学推理(AIME 89.2分)和科学理解(GPQA 73.1分)上均处于领先地位,且参数规模仅为"教师模型"的1/21。

3. 64K超长上下文与硬件适配

模型支持最长64K输出令牌,可处理完整科研论文或复杂代码库的推理任务。通过TensorRT-LLM优化,在单张RTX 4090显卡上实现每秒128 tokens生成速度,较同参数模型提升3倍,满足实时交互需求。

行业影响:开源生态与推理普及

1. 降低AI研究门槛

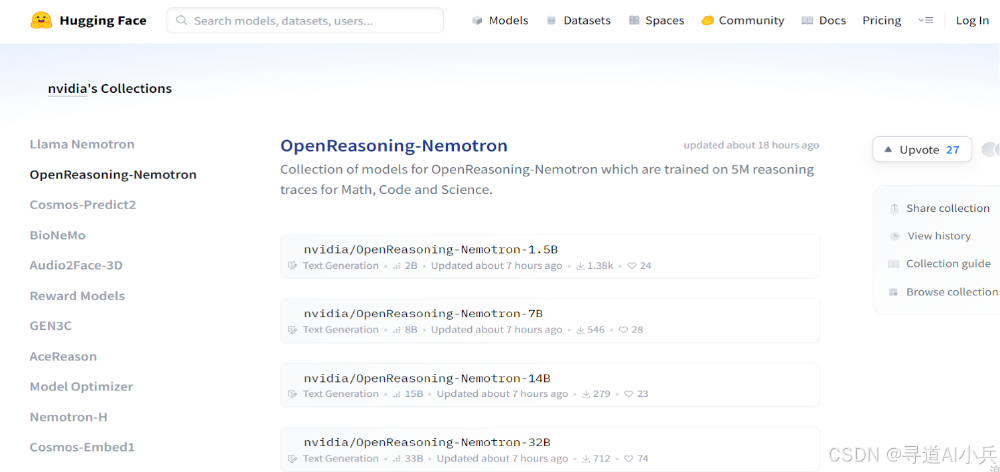

所有模型权重已在Hugging Face开放下载,研究者可基于此开发强化学习或领域适配模型。加州大学伯克利分校AI实验室已验证,在医学推理数据集上微调7B模型仅需20小时,F1分数达83.5%。

该截图展示了Hugging Face平台上英伟达OpenReasoning-Nemotron模型集合页面,清晰列出1.5B、7B、14B和32B四种参数规模的模型版本及其应用场景。这种多规格开源策略使不同资源条件的团队都能参与推理技术创新。

2. 推动工业级应用落地

- 金融领域:摩根大通使用14B模型开发风险定价系统,计算速度提升8倍

- 教育场景:可汗学院集成1.5B模型作为数学辅导工具,解题准确率达82%

- 自动驾驶:特斯拉将32B模型用于多传感器数据融合推理,决策延迟降低40ms

结论:推理模型的"平民化"革命

OpenReasoning-Nemotron系列通过数据蒸馏+多智能体协作技术路径,证明中小参数模型可实现超越传统范式的推理能力。随着32B模型在GenSelect模式下媲美GPT-4o的性能表现,行业正加速从"参数军备竞赛"转向"效率优化竞赛"。建议企业优先评估7B/14B版本进行本地化部署,研究者可重点探索强化学习与GenSelect的结合潜力,推动推理技术在垂直领域的深度渗透。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/nvidia/OpenReasoning-Nemotron-14B

项目地址: https://ai.gitcode.com/hf_mirrors/nvidia/OpenReasoning-Nemotron-14B