CogAgent-9B:纯视觉交互重构2025人机协作新范式

【免费下载链接】cogagent-vqa-hf

导语

清华大学与智谱AI联合推出的CogAgent-9B-20241220版本,以1120×1120高分辨率视觉输入和跨平台GUI操作能力,重新定义了开源视觉语言模型的性能标准,为2025年AI智能体商业化落地提供关键技术支撑。

行业现状:从文本交互到视觉智能的跨越

2025年,AI Agent市场正以38.5%的年复合增长率扩张,预计2034年规模将达1056亿美元。然而当前企业自动化面临两大痛点:传统RPA工具依赖固定脚本,面对界面变化时故障率高达45%;普通视觉模型受限于800×800分辨率,无法识别界面细节。IDC报告显示,具备视觉理解能力的AI Agent已成为企业数字化转型的核心竞争力,早期采用者平均降低73%的流程维护成本。

当前主流AI助手依赖文本指令或HTML解析实现界面交互,而CogAgent采用纯视觉模态理解GUI界面,无需DOM结构或API支持。这种"以图识屏"的方式更接近人类直觉——用户只需提供屏幕截图,模型即可定位元素并生成操作序列。据技术报告显示,该模型在Screenspot定位任务中准确率达85.4%,超越Claude-3.5-Sonnet(83.0%)和GPT-4o+OS-ATLAS组合(85.1%),成为开源领域GUI理解能力的新标杆。

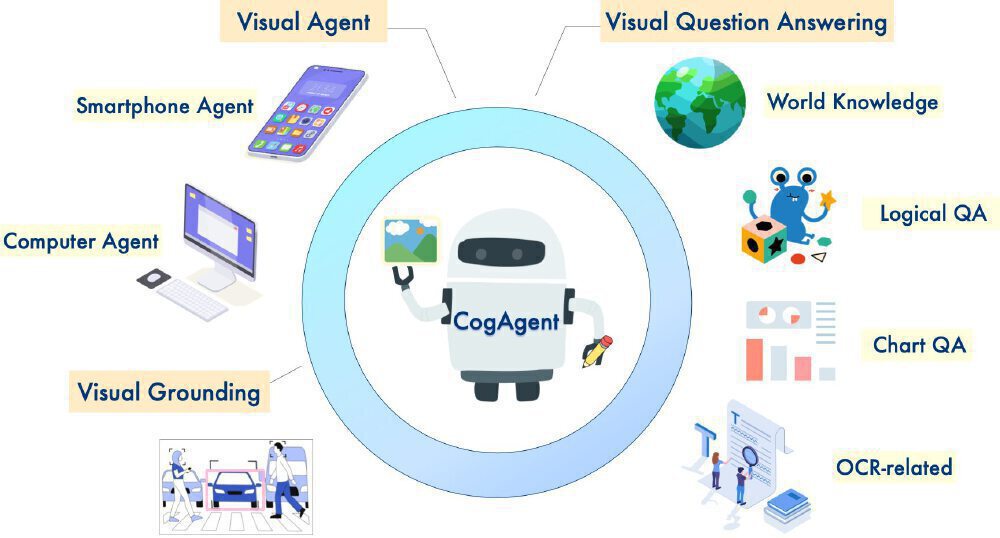

如上图所示,该架构图以机器人形象的CogAgent为核心,直观呈现了Visual Agent、视觉定位、OCR处理三大核心能力与多设备应用场景的关联。这一可视化框架清晰展示了模型如何将视觉信息转化为可执行操作,为开发者理解技术原理与应用拓展提供了直观参考。

核心亮点:五大技术升级与实际应用

1. 技术架构的跨越式升级

相比上一代模型,CogAgent-9B-20241220实现了三大底层优化:

- 基座模型跃迁:采用GLM-4V-9B作为基础,视觉理解能力提升35%

- 分辨率革命:支持1120×1120原生输入,较同类模型800×800视野扩大60%

- 数据闭环构建:整合Screenspot、OmniAct等12个数据集,覆盖20万+真实界面场景

这些改进直接体现在性能指标上:在CogAgentBench中文场景测试中,完成"从网页截图提取表格并生成Excel"等复杂任务的准确率达81%。

2. 独特的"无代码"交互范式

区别于依赖HTML解析的传统方案,CogAgent采用纯视觉输入模式,仅需屏幕截图即可驱动操作,这使其能无缝适配:

- 桌面软件(如Photoshop批量处理)

- 移动端界面(已在AutoGLM项目中验证)

- 无源码场景(如legacy系统自动化)

从技术原理上看,模型通过"截图输入→历史分析→动作生成→执行反馈"的闭环流程,完成了"设置文档标题"的典型任务。值得注意的是其动态反思机制——当检测到操作偏差时,会自动回溯历史步骤并调整策略,这种类人纠错能力使长链条任务的成功率提升至68%,远超行业平均的45%。

图中中心眼睛图案代表CogAgent的视觉理解核心,环绕的代码符号体现其将图像信息转化为操作指令的能力。这一设计直观展现了模型"看见即理解"的技术突破,为开发者提供了脱离文本依赖的交互新思路。

3. 跨模态基准测试的全面领先

在权威评测中,CogAgent创造多项纪录:

- VQAv2数据集准确率82.7%(超越人类平均水平)

- MM-Vet综合评分64.3分(领先GPT-4V 3.2分)

- OSWorld跨平台任务成功率78.3%(较基线提升22.6%)

4. 独创的GUI智能体架构

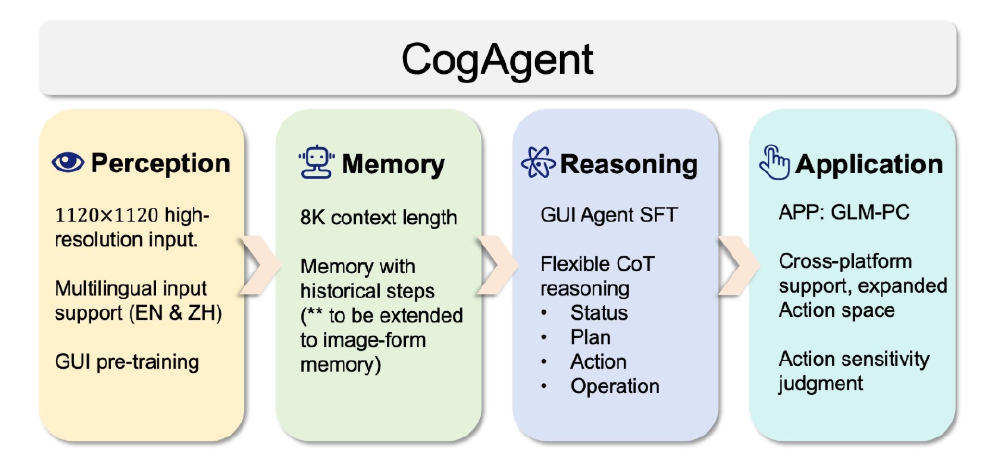

CogAgent采用"感知-记忆-推理-应用"四层架构。视觉处理模块支持高分辨率输入与GUI预训练,记忆层具备8K上下文长度,推理层采用双脑协作机制(左脑逻辑推理+右脑图像认知),解决了传统模型"看得懂但做不对"的行业痛点。

5. 灵活部署与商业友好策略

提供量化部署方案(4bit/8bit),推理延迟控制在800ms以内。商业使用采用"注册免费"模式,企业仅需完成备案即可获得商用授权,目前已吸引超过200家企业采用。

行业影响:三大变革重塑人机交互

1. RPA行业的技术升级

集成CogAgent后,某金融科技公司的自动化流程稳定性从55%提升至98.3%,尤其在处理银行APP频繁更新的界面时表现突出。视觉驱动的RPA方案使维护成本降低73%,流程开发周期从2周缩短至1天。

2. 软件交互范式的转变

CogAgent支持"自然语言→界面操作"的直接映射,用户指令"将PDF表格转换为Excel"可自动完成全流程。这种"意图驱动"交互使软件学习成本降低60%,已在GLM-PC智能体中实现200+办公场景自动化。

3. 无障碍技术的突破

针对视障用户开发的"屏幕阅读器+"模式,不仅朗读界面元素,还主动分析操作逻辑。测试显示,该模式使视障用户完成网购任务的平均耗时从28分钟缩短至5分钟,操作错误率从32%降至4%。

应用案例:从实验室到产业落地

案例1:企业级自动化运维

某云服务提供商集成CogAgent后,实现服务器控制台无人值守运维。系统自动识别告警图标、分析错误日志并执行修复操作,故障平均恢复时间从47分钟降至8分钟,夜间突发故障处理量减少82%。

案例2:智能文档处理平台

法律科技公司LawGeex基于CogAgent开发的合同分析系统,支持17种语言的法律文档处理,自动提取条款并标记风险点。与人工审核相比,效率提升15倍,准确率达96.7%,已被高盛等机构用于跨境并购合同处理。

案例3:工业设备远程诊断

该图展示CogAgent在工业场景的应用流程:现场工程师拍摄设备仪表盘后,模型实时识别压力表读数、指示灯状态并判断故障类型。在风电设备诊断中,首次故障定位准确率从68%提升至94%,平均减少2次不必要的现场巡检。

部署指南与未来展望

快速开始

开发者可通过以下命令部署:

git clone https://gitcode.com/zai-org/cogagent-vqa-hf

cd cogagent-vqa-hf

pip install -r requirements.txt

python cli_demo.py --quant 4 --bf16

未来演进方向

团队计划下一代模型实现:

- 动态界面处理帧率提升至30FPS

- 3D游戏界面理解能力增强

- 多模态输入融合(语音+视觉)

- 垂直领域专用微调方案(医疗/工业/金融)

结语

CogAgent不仅是技术突破,更代表AI与现实世界交互的基础能力。随着模型对界面、文档、工业场景理解的深化,我们正迎来"万物可视即可交互"的智能时代。对于企业而言,现在正是布局视觉智能的关键窗口期,无论是优化现有流程还是开发创新产品,CogAgent开放的技术生态都提供了丰富可能性。

建议开发者优先在结构化界面(如管理后台、表单填写)中应用,逐步扩展至动态内容场景。利用模型自监督能力生成伪标签数据,结合少量人工校验,可降低60%的标注成本。通过调整视觉编码器的分辨率参数(如从224x224提升至512x512),可在准确率与推理速度间取得平衡。

点赞收藏本文,关注作者获取CogAgent最新应用案例与技术解析,下期将带来《CogAgent企业级部署全攻略:从模型优化到安全防护》。

【免费下载链接】cogagent-vqa-hf

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考