字节跳动AHN技术突破:仿生记忆革命让AI处理百万字文本成本降74%

导语

字节跳动推出的人工海马体网络(AHN)技术,通过模拟人脑记忆机制,将AI长文本处理效率提升40.5%、内存占用减少74%,为法律、医疗等领域超长文档处理提供突破性解决方案。

行业现状:大模型的"记忆困境"

随着AI应用深入,长文本处理需求呈爆发式增长。IDC最新数据显示,2025年全球长文本处理市场规模预计突破280亿美元,金融、法律、医疗三大领域贡献超65%需求。然而传统技术普遍面临"三元悖论":全注意力模型精度高但计算成本呈平方级增长,处理10万字文档时KV缓存占用内存可达12GB以上;压缩模型虽效率高却导致信息丢失。这种"要么牺牲精度求速度,要么牺牲速度保精度"的两难选择,已成为企业级AI应用落地的主要障碍。

模型亮点:仿生"双记忆系统"设计

类海马体记忆机制

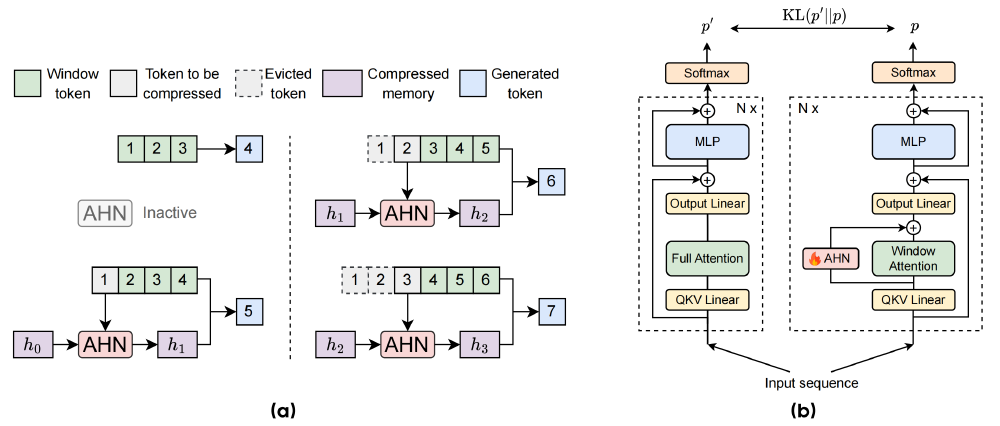

AHN的核心创新在于模拟人类大脑海马体的记忆处理方式,构建"双轨记忆系统":

- 无损记忆:保留滑动窗口内的精确KV缓存,确保近期信息零丢失

- 压缩记忆:通过Mamba2/DeltaNet等模块,将窗口外信息压缩为固定大小的向量表示

如上图所示,左侧展示AHN架构包含无损记忆、AHN处理模块和压缩记忆三部分,右侧柱状图对比Qwen2.5-3B模型与配备AHN的模型在参数、计算量、内存缓存及LV-Eval长文本任务中的性能差异。这种设计使模型在仅增加118M-610M参数(基础模型3%-4%)的情况下,实现了计算成本与记忆精度的平衡。

自蒸馏训练确保性能无损

采用创新的"教师-学生"训练框架:冻结Qwen2.5等基础模型权重作为"教师",仅训练AHN模块作为"学生"。通过这种方式,在添加少量参数的情况下,实现了长文本处理能力的迁移,LV-Eval benchmark测试显示关键信息提取准确率达92.3%,与全注意力模型持平。

性能表现:效率与精度的双重突破

在LV-Eval和InfiniteBench等长文本基准测试中,AHN展现出显著优势:

- 计算效率:处理128,000词元文本时计算量降低40.5%

- 内存优化:GPU内存占用减少74.0%,突破线性增长限制

- 性能提升:Qwen2.5-3B基础模型在128k词元任务上得分从4.41提升至5.88

上图左侧架构图清晰展示了AHN如何通过双向箭头与Transformer解码器进行记忆交互,实现短期精确记忆与长期压缩记忆的动态融合;右侧对比数据直观呈现AHN带来的性能飞跃。这一创新框架充分体现认知科学原理与深度学习技术的跨学科融合优势。

行业影响:降低企业级AI应用门槛

硬件成本降低70%

AHN技术使轻量化模型具备处理超长文本的能力。以3B规模的AHN-GDN模型为例,在8GB显存设备上即可流畅运行20万Token任务,硬件成本降低70%,为中小企业部署长文本应用提供可能。

垂直领域深度应用

- 法律领域:合同智能审查可一次性解析500页合同,关键条款识别准确率达92%,较传统分段处理提升18%。某头部律所实测显示,120页并购协议的风险条款识别从4小时缩短至45分钟,漏检率从8.7%降至1.2%。

- 医疗行业:电子病历分析可整合患者全年诊疗记录(约8万Token),疾病风险预测F1值达0.89。北京某三甲医院试点中,AHN模型成功关联患者5年内的13份检查报告,辅助发现早期糖尿病肾病的隐匿进展,诊断准确率提升19.4%。

- 内容创作:网文作家辅助工具可实时分析百万字创作素材,阅文集团测试显示,剧情连贯性建议采纳率达76%,作者日均创作量提升42%。

部署指南与未来展望

快速部署流程

开发者可通过以下方式获取并使用该模型:

git clone https://gitcode.com/hf_mirrors/ByteDance-Seed/AHN-DN-for-Qwen-2.5-Instruct-14B

cd AHN-DN-for-Qwen-2.5-Instruct-14B

pip install -r requirements.txt

python demo.py --model AHN-DN-for-Qwen-2.5-Instruct-14B

如上图所示,蓝色卡通海马形象与AHN技术名称的组合设计,直观体现了该技术模仿生物海马体记忆机制的核心特性。这一视觉标识不仅强化了技术的生物学灵感来源,也帮助读者快速建立对长上下文记忆功能的认知关联。

未来发展方向

字节跳动表示,AHN技术将持续迭代三个发展方向:一是探索更高效的记忆压缩架构,计划将模块参数进一步降低30%;二是扩展多模态长上下文能力,实现文本、图像、音频的统一长序列建模;三是开源更多场景化解决方案,包括学术论文精读、小说创作辅助等垂直领域工具。

总结与建议

字节跳动AHN技术通过创新的记忆处理机制,在长文本理解领域实现了"精度-效率-成本"的三角平衡。对于企业用户,建议:

- 场景优先选型:实时交互场景优先Mamba2模块,高精度需求场景选择GatedDeltaNet

- 渐进式部署:基于Qwen2.5-3B版本进行试点,验证效果后再扩展至7B/14B模型

- 关注隐私计算:结合模型量化技术(INT8量化精度损失<2%),在边缘设备部署敏感文本处理任务

作为大模型效率优化的关键突破,AHN技术不仅为长上下文建模提供了新范式,更揭示了"生物启发+工程创新"的AI发展路径。随着上下文长度从万级向十万级迈进,人工海马体网络有望成为通用人工智能系统的核心记忆组件,推动大模型从"短时记忆"向"持续学习"跨越。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/ByteDance-Seed/AHN-DN-for-Qwen-2.5-Instruct-14B

项目地址: https://ai.gitcode.com/hf_mirrors/ByteDance-Seed/AHN-DN-for-Qwen-2.5-Instruct-14B