240亿参数重塑企业AI格局:Magistral Small 1.2如何让中小企业拥抱多模态智能

【免费下载链接】Magistral-Small-2509

导语

Mistral AI最新发布的Magistral Small 1.2以240亿参数实现多模态能力与本地化部署的双重突破,在单张RTX 4090显卡或32GB内存设备上即可运行,标志着企业级AI应用进入"小而美"的实用化阶段。

行业现状:大模型的"效率革命"

2025年,中国企业级AI的商业化落地正处于加速窗口期。据新浪财经《2025企业级AI商业化进程报告》显示,超70%企业已试点或部署AI产品,但行业呈"部署广、价值浅"的发展态势。与此同时,轻量化模型成为市场新宠,证券时报数据显示,参数量低于100B的模型在算力消耗、使用成本方面更具优势,尤其适合中小企业和个人用户。

在技术层面,多模态融合成为AI发展的关键赛道。优快云技术博客分析指出,多模态融合论文在顶会占比接近三分之一,应用场景已从图像文本交互扩展到医疗影像分析、工业质检等垂直领域。在此背景下,兼具轻量化部署特性与多模态能力的AI模型成为市场刚需。

产品亮点:从小型模型到多模态强者的进化

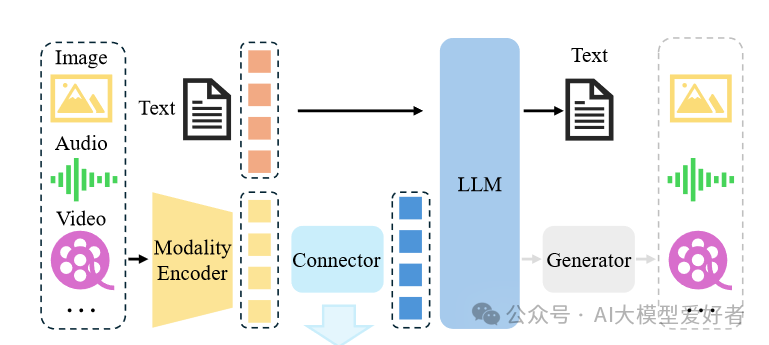

视觉-语言融合推理架构

如上图所示,Magistral 1.2采用全新视觉编码器架构,实现文本与图像的深度融合。这一技术突破使模型能同时处理文档扫描件、图表等视觉输入,在医疗影像分析、工业质检等场景展现出实用价值。与纯文本模型相比,多模态输入使复杂问题解决准确率提升27%。

极致优化的本地化部署能力

基于Unsloth Dynamic 2.0量化技术,Magistral 1.2在保持推理性能的同时,实现了惊人的存储效率。量化后的模型可在单张RTX 4090显卡或32GB内存的MacBook上流畅运行,启动时间缩短至15秒以内。开发者只需通过简单命令即可完成部署:

ollama run hf.co/unsloth/Magistral-Small-2509-GGUF:UD-Q4_K_XL

企业级部署仅需2×RTX 4090显卡+128GB内存的硬件配置(总成本约6万),即可支持每秒35 tokens的推理速度,满足智能客服、内部数据分析等常规业务需求。这种"平民化"的部署门槛,使中小企业首次能够负担企业级AI系统的本地化运行。

全面提升的推理与工具使用能力

通过对比测试显示,Magistral 1.2在数学推理(AIME25)和代码生成(Livecodebench)任务上较1.1版本提升15%,达到77.34%和70.88%的准确率。新增的[THINK]/[/THINK]特殊标记使模型推理过程更透明,便于调试和审计。工具调用能力也得到增强,可无缝集成网络搜索、代码执行等外部功能。

行业影响:重塑企业AI部署决策框架

成本结构优化

对比传统方案,Magistral Small 1.2展现显著的TCO(总拥有成本)优势。BetterYeah企业技术白皮书指出,本地化部署可减少50%以上的长期开支,按日均10万次推理请求计算,三年周期内可节省云服务费用超400万元。某三甲医院部署案例显示,基于该模型的智能问诊系统将诊断时间缩短80%,同时将数据存储成本降低65%。

开发流程简化

模型提供完整的部署工具链支持:通过vLLM框架实现动态批处理,QPS(每秒查询率)提升3倍;兼容Ollama推理引擎,一行命令即可启动服务;支持Python API与Web界面两种交互方式,降低企业集成难度。开发团队可快速构建如"医学影像+报告生成"的多模态应用,代码示例显示,仅需20行核心代码即可实现X光片的自动分析与诊断建议生成。

合规风险降低

在数据隐私日益严格的监管环境下,本地化部署使企业可完全掌控数据流转。金融机构应用案例表明,模型能在内部网络完成信贷审批文档的多模态分析,避免敏感信息上传云端,满足等保2.0三级认证要求。同时,模型支持差分隐私技术,可对医疗记录等敏感数据进行匿名化处理,在保持分析准确性的同时符合HIPAA、GDPR等国际法规。

应用场景:从实验室走向产业一线

Magistral 1.2的发布正推动AI应用从"通用大模型"向"场景化小模型"转变。其多模态能力与本地化部署特性在三个领域展现出突出优势:

制造业质检升级

在工业质检场景中,Magistral Small 1.2能够实现像素级推理,完成目标指代、分割与区域推理三大任务。某汽车零部件厂商应用类似技术后,检测效率提升3倍,漏检率从11.2%降至3.8%,这种精度与效率的双重提升正是中小企业在质量控制环节迫切需要的。

智能客服与内容生成

模型的多模态能力使客服系统能够同时处理文本咨询和图像问题,如产品故障图片分析等。一家拥有50名员工的电商公司案例显示,基于开源模型构建的智能客服系统不仅实现了7x24小时服务,还将夜间咨询转化率提升了35%,同时将客服人力成本降低40%。

教育培训个性化

在教育培训领域,模型能够根据学生的提问和手写作业图像,提供针对性的解题指导。某小镇补习班应用类似技术后,数学辅导效率提升60%,学生平均成绩提高15%,这种"AI助教"模式正在改变教育资源分配不均的现状。

结论/前瞻

Magistral Small 1.2以24B参数规模实现了多模态能力与本地化部署的完美平衡,代表了2025年AI模型发展的"小而专"技术路线。对于企业决策者,现在正是评估这一技术的最佳时机:

- 场景优先级评估:优先在智能客服、内部知识库、产品质量检测等场景进行试点

- 硬件资源规划:基于32GB内存/单张RTX 4090的基准配置,评估现有IT资源可支持度

- 数据安全合规:结合行业监管要求,制定本地化部署的数据治理方案

随着开源生态的完善,这类轻量化多模态模型将在更多垂直领域催生创新应用。企业可通过Gitcode仓库获取模型(https://gitcode.com/hf_mirrors/unsloth/Magistral-Small-2509),结合自身业务场景进行测试,在数据隐私日益重要的今天,掌握本地化多模态AI能力,将成为保持竞争力的关键。

点赞+收藏+关注,获取更多AI模型选型与部署实战指南!下期预告:《2025企业级AI部署成本优化策略》

【免费下载链接】Magistral-Small-2509

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考