阿里Wan2.1开源:视频生成进入消费级GPU时代

【免费下载链接】Wan2.1-FLF2V-14B-720P

导语

2025年2月,阿里巴巴开源视频生成模型Wan2.1正式发布,以1.3B参数规模实现8.19GB显存占用的突破性优化,首次让消费级GPU用户能够本地运行高质量文本生成视频任务,重新定义了视频生成技术的硬件门槛。

行业现状:视频生成的"算力鸿沟"困境

当前文本生成视频技术正处于爆发期,但行业面临严峻的"算力鸿沟"挑战。根据2025年开源视频模型评测报告,主流商业模型如Sora需要至少40GB显存的专业GPU支持,而开源方案如Stable Video Diffusion虽降低门槛,仍需12GB以上显存,这将大量个人创作者和中小企业挡在门外。

与此同时,市场对轻量化视频生成工具的需求激增。数据显示,2025年第一季度,"AI视频生成"相关搜索量同比增长320%,其中"消费级GPU可用"的查询占比达47%。企业级解决方案虽成熟,但单个视频生成成本高达数百元,难以满足中小企业和个人的高频创作需求。

产品亮点:三大突破重构视频生成范式

1. 极致优化的硬件适配能力

Wan2.1通过创新的模型卸载技术和T5编码器CPU部署方案,将1.3B参数模型的显存需求压缩至8.19GB。实测数据显示,在RTX 4090显卡上启用--offload_model True和--t5_cpu参数后,可稳定生成5秒480P视频,耗时约4分钟,而同等质量的视频在Stable Video Diffusion上需要12GB显存且生成时间延长30%。

2. 多任务融合的生成能力

不同于单一功能的视频模型,Wan2.1实现了"五合一"的全能创作体验:

- 文本到视频(T2V):支持中英文双语提示词

- 图像到视频(I2V):静态图像动态扩展

- 视频编辑:局部内容替换与风格迁移

- 文本生成图像:高精度视觉内容创作

- 视频转音频:自动匹配场景音效

特别值得注意的是其首创的视觉文字生成功能,能够在视频中自然呈现中英文字符,解决了长期困扰AIGC领域的"文字生成难题",为教育、广告等场景提供关键支持。

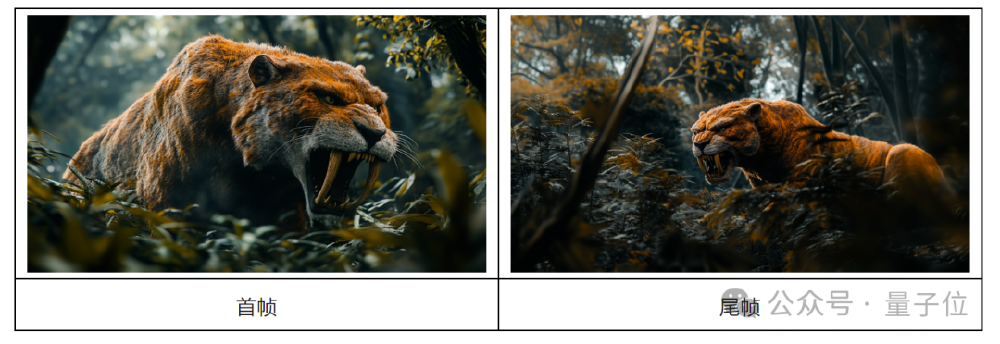

3. 首尾帧视频生成技术

Wan2.1最新推出的首尾帧视频生成(FLF2V)功能,允许用户通过提供开始和结束画面,自动生成连贯的过渡视频。这一技术突破为故事板创作、产品演示和创意表达提供了全新可能。

如上图所示,左侧为首帧剑齿虎在森林中的图像,右侧为尾帧同一生物的不同姿态。Wan2.1能够基于这两张静态图片,生成流畅自然的过渡视频,保持主体一致性和动作连贯性。这一技术充分体现了模型在视觉理解和动态生成方面的强大能力,为动画制作和创意设计提供了高效工具。

行业影响与趋势

1. 营销领域的应用革新

Wan2.1的多任务能力已开始在营销领域产生显著影响。某电商企业利用Wan2.1将产品视频制作成本降低70%,从传统拍摄的人均日产出3条提升至AI辅助的20条。通过文本生成视频功能,企业可以快速生成"同一产品+不同场景"的广告内容,如"咖啡+办公室加班"、"咖啡+周末露营"等不同场景的视频,大幅提升了广告创意的多样性和生产效率。

2. 教育内容创作的效率提升

教育机构通过Wan2.1的文字生成能力,快速制作带字幕的教学短视频,内容生产效率提升3倍。云南某乡村小学用AI生成"太阳系运行"视频:输入"八大行星绕太阳转,地球是蓝色的,木星有光环",AI生成3D动画,学生反馈"原来地球真的像篮球一样转!",显著提升了学习兴趣和理解效果。

3. 开源生态的快速发展

Wan2.1的发布标志着视频生成技术从"专业设备专属"向"大众创作工具"的关键转变。其开源特性已催生丰富的应用场景:社区在发布后两周内贡献了15种语言的本地化版本和20+扩展插件,形成快速迭代的开源生态。技术生态方面,社区已开发多个优化工具:

- CFG-Zero从CFG角度增强Wan2.1(覆盖T2V和I2V模型)

- TeaCache支持Wan2.1加速,可提升约2倍速度

- DiffSynth-Studio提供更多支持,包括视频到视频、FP8量化、VRAM优化、LoRA训练等

性能与效率

Wan2.1在不同硬件配置上的表现如下表所示:

| 模型版本 | GPU配置 | 视频分辨率 | 生成时间(5秒) | 显存占用 |

|---|---|---|---|---|

| 1.3B | RTX 4090 | 480P | 4分钟 | 8.19GB |

| 14B | 48GB显存双卡 | 720P | 3503秒 | 41GB |

| 14B | 12GB显存五卡 | 480P | 1459秒 | 9.6GB |

数据来源:阿里云边缘云部署测试报告

总结与建议

Wan2.1的技术突破验证了"小而美"的模型优化路线在视频生成领域的可行性。随着量化技术和分布式推理的发展,未来12个月内有望实现消费级GPU上的720P实时生成。

对于不同用户群体,我们建议:

创作者:现在正是入局AIGC视频创作的最佳时机——无需高端硬件,只需一台配备RTX 3060以上显卡的普通电脑,即可开启AI视频创作之旅。项目地址:https://gitcode.com/hf_mirrors/Wan-AI/Wan2.1-FLF2V-14B-720P

企业用户:建议关注Wan2.1的API服务进展,其多任务能力可显著降低多模态内容生产成本,尤其在营销、教育等对文字生成有强需求的场景。

开发者:可基于开源代码探索垂直领域优化,在教育、广告等对文字生成有强需求的场景开发专用解决方案,同时参与社区生态建设,推动模型性能和应用场景的进一步扩展。

开源视频生成的黄金时代,正从Wan2.1开始加速到来。

【免费下载链接】Wan2.1-FLF2V-14B-720P

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考