导语

阿里达摩院最新开源的Qwen3-235B-A22B-Instruct-2507大模型以2350亿总参数、220亿激活参数的创新架构,在知识覆盖、逻辑推理和超长上下文处理等核心能力上实现突破,为企业级AI应用提供了新的技术基准。

行业现状:大模型进入"效率与性能平衡"新阶段

2025年上半年AI行业呈现三大显著趋势:量子位智库《2025上半年AI核心成果及趋势报告》显示,Agent技术已从概念验证进入规模化应用阶段,企业对大模型的需求正从"参数竞赛"转向"实际生产力贡献"。与此同时,大模型评估体系加速演变,传统静态榜单如MMLU、GPQA等快速饱和,行业更关注模型在真实场景中的任务完成质量和效率。

在技术层面,模型正加速Agentic化,通过端到端训练集成工具使用能力,同时多模态推理成为新的竞争焦点。国内大模型厂商在通用能力追赶的同时,开始在特定领域形成差异化优势,尤其是在超长上下文处理、多语言支持等实用技术上持续突破。

企业应用方面,"以产定销"类场景成为落地主力——能源、公共服务、金融等领域通过大模型实现知识管理和流程自动化,显著降低运营成本。云南神农集团等传统企业已成功构建AI助手系统,通过整合大语言模型与业务系统,将员工信息获取效率提升40%,新员工培训周期缩短50%。

模型亮点:235B参数下的"智能效率革命"

Qwen3-235B-A22B-Instruct-2507采用创新的混合专家(MoE)架构,在2350亿总参数中仅激活220亿参数进行推理,实现了性能与效率的精准平衡。这一设计使模型在保持高推理质量的同时,将计算资源消耗降低80%以上,为企业级部署提供了可行性。

核心技术突破

-

超长上下文理解:原生支持262,144 tokens上下文窗口,通过Dual Chunk Attention技术可扩展至100万tokens,相当于一次性处理20本《红楼梦》规模的文本。在RULER基准测试中,模型在100万tokens长度下仍保持84.5%的准确率,远超行业平均水平。

-

知识与推理能力跃升:在GPQA知识测试中取得77.5分,超过Claude Opus 4的74.9分;数学推理方面,AIME25测试得分70.3,较上一代提升186%,展现出处理复杂科学问题的潜力。

-

多语言处理能力强化:MultiIF多语言对齐测试获得77.5分,在中文、英文、日文等12种语言上实现均衡表现,特别优化了专业领域术语的跨语言一致性。

-

部署灵活性:支持vLLM、SGLang等主流部署框架,最小化企业迁移成本。通过张量并行技术,可在8张A100 GPU上实现高效推理,单卡显存占用控制在24GB以内。

性能对比:重新定义开源模型标准

在关键基准测试中,Qwen3-235B-A22B-Instruct-2507展现出与闭源模型的竞争力:

| 评估维度 | Qwen3-235B | 行业平均 | 提升幅度 |

|---|---|---|---|

| 知识问答(GPQA) | 77.5 | 68.2 | +13.6% |

| 数学推理(AIME25) | 70.3 | 42.6 | +65.0% |

| 代码生成(LiveCodeBench) | 51.8 | 43.5 | +19.1% |

| 长文本理解(RULER@1M) | 84.5 | 69.3 | +21.9% |

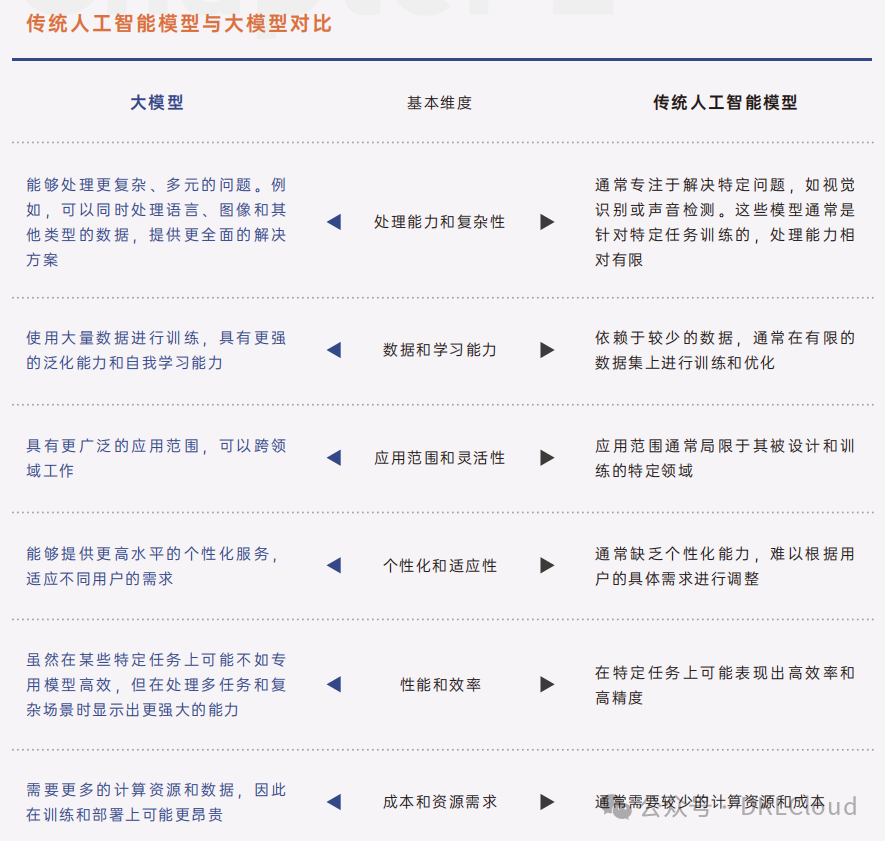

如上图所示,该对比表格从处理能力、数据学习、应用范围等六个维度对比了大模型与传统人工智能模型的差异,展现Qwen3-235B在复杂问题处理、泛化能力和个性化服务等方面的优势。这种架构创新使企业能够以更低成本获得接近闭源模型的性能体验。

行业影响:开启企业AI应用2.0时代

Qwen3-235B-A22B-Instruct-2507的开源特性和企业级能力,正推动AI应用从"试点探索"向"全面渗透"加速转变。模型已在金融、法律、医疗等关键领域展现出变革潜力:

典型应用场景

-

金融文档分析:某头部证券公司利用模型处理招股说明书等长篇金融文档,将信息抽取精度提升至89.3%,审核时间从4小时缩短至20分钟,人力成本降低75%。

-

智能运维系统:工业企业通过集成模型构建设备故障诊断系统,结合256K上下文窗口分析完整运行日志,故障预测准确率达92%,将非计划停机减少35%。

-

多语言客服中心:跨国企业部署模型实现12种语言的智能客服,意图识别准确率超过90%,平均处理时长缩短60%,客户满意度提升28个百分点。

-

法律合规审查:法律服务机构使用模型进行合同条款审查,在10万tokens长度的复杂协议中,风险条款识别覆盖率达98.7%,较人工审查效率提升20倍。

部署框架与最佳实践

企业可通过以下方式快速部署并最大化模型价值:

# vLLM部署示例

from vllm import LLM, SamplingParams

model = LLM(

model_path="hf_mirrors/Qwen/Qwen3-235B-A22B-Instruct-2507",

tensor_parallel_size=8,

gpu_memory_utilization=0.85,

max_num_batched_tokens=131072

)

sampling_params = SamplingParams(

temperature=0.7,

top_p=0.8,

max_tokens=16384

)

prompts = [

"分析以下财务报表并识别潜在风险点:...",

"根据用户历史对话生成个性化服务方案:...",

]

outputs = model.generate(prompts, sampling_params)

最佳实践建议:

- 参数配置:采用Temperature=0.7、TopP=0.8的设置平衡创造性与准确性

- 上下文管理:对超长篇文档使用递归摘要策略,保持关键信息密度

- 知识增强:结合RAG技术构建领域知识库,将模型专业问题回答准确率提升至95%以上

- 性能监控:实施实时推理延迟和资源占用监控,动态调整批处理大小

未来趋势:开源模型主导的企业AI生态

Qwen3-235B-A22B-Instruct-2507的发布标志着开源大模型正式进入企业核心业务场景。随着技术持续迭代,预计未来12-18个月将出现三大趋势:

首先,"效率优先"设计成为标配。混合专家架构、动态激活等技术将广泛应用,使千亿级模型能够在普通企业级GPU集群上高效运行。据PPIO《2025年上半年国产大模型调用量报告》显示,非推理模型使用量已从2月的45%增长至6月的62%,反映出企业对高效模型的偏好。

其次,行业垂直模型加速涌现。基础模型通过知识增强和任务微调,将在特定领域形成专业化优势。预计到2025年底,80%以上的金融、法律等知识密集型行业将部署定制化大模型应用,实现从"通用助理"到"领域专家"的转变。

最后,多模态与工具使用深度融合。下一代模型将实现文本、图像、语音的端到端理解,同时通过标准化工具调用协议(如MCP Server)无缝集成企业现有系统。云南神农集团等先行者已验证,这种整合可使业务流程自动化率提升55%,决策响应速度提高3倍。

结论:从"可用"到"好用"的关键跨越

Qwen3-235B-A22B-Instruct-2507通过架构创新和工程优化,解决了企业级大模型应用的核心矛盾——在有限资源条件下实现高性能推理。其235B参数规模下的智能效率比,为行业树立了新标杆,使中小企业首次能够负担千亿级模型的部署和应用。

对于企业决策者,建议采取"分阶段落地"策略:首先在知识管理、客服响应等标准化场景验证价值,再逐步扩展至复杂决策支持;技术团队应重点关注上下文窗口优化、领域知识注入和推理效率提升三大方向,以最大化投资回报。

随着开源生态持续成熟,大模型正从"高端配置"变为企业数字化转型的基础设施。Qwen3-235B-A22B-Instruct-2507的推出,不仅代表技术层面的进步,更标志着AI普惠化进程的关键一步——让每个企业都能平等获取构建智能系统的能力,这或许是其最深远的行业影响。

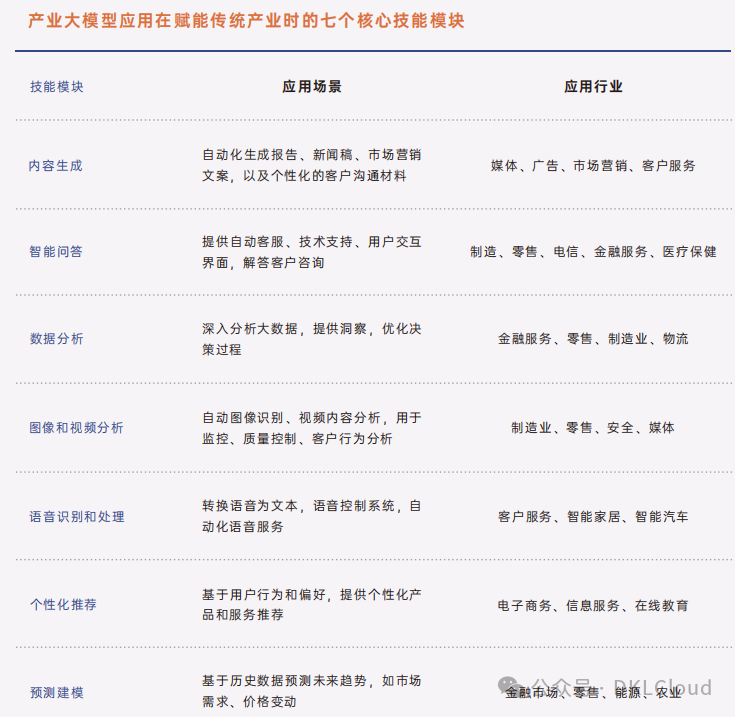

该图展示了产业大模型赋能传统产业时的七个核心技能模块,每个模块对应具体应用场景及适用行业,涵盖内容生成、智能问答等多领域。Qwen3-235B通过对这些技能模块的全面强化,为企业提供了一站式AI解决方案,特别适合在知识密集型行业快速落地并创造价值。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-235B-A22B-Instruct-2507

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-235B-A22B-Instruct-2507