68.7%合成数据打造韩语AI新标杆:KORMo-10B全开源模型如何改写行业规则

【免费下载链接】KORMo-10B-sft

导语

2025年10月13日,韩国KAIST团队发布108亿参数的全开源双语大模型KORMo-10B,以68.74%合成数据占比实现韩语推理能力突破,为非英语语言模型开发树立新标杆。

行业现状:韩语AI的"暗箱困境"

当前韩语大模型市场呈现"双轨并行"格局:一方面,LG EXAONE 4.0等商业模型以320亿参数实现85.3%数学竞赛正确率;另一方面,开源生态存在显著缺口——现有模型或仅开放最终参数,或依赖英语基底模型微调,导致韩语文化特异性处理能力不足。

据SiliconFlow 2025年报告,韩国企业AI本地化需求同比增长127%,但63%企业反映海外模型在处理敬语体系、文化隐喻等场景时准确率低于70%。这种"可用性鸿沟"催生了对完全开放模型的迫切需求。

核心亮点:三大技术突破重构韩语AI开发范式

1. 合成数据驱动的训练革命

KORMo团队创新性采用"合成数据为主、公共数据为辅"的混合训练策略,在3.7T总 tokens中,68.74%为自主生成的韩语数据。通过多模型协作生成(Qwen+GPT-OSS)与启发式过滤,成功避免了合成数据常见的"模式崩溃"问题。

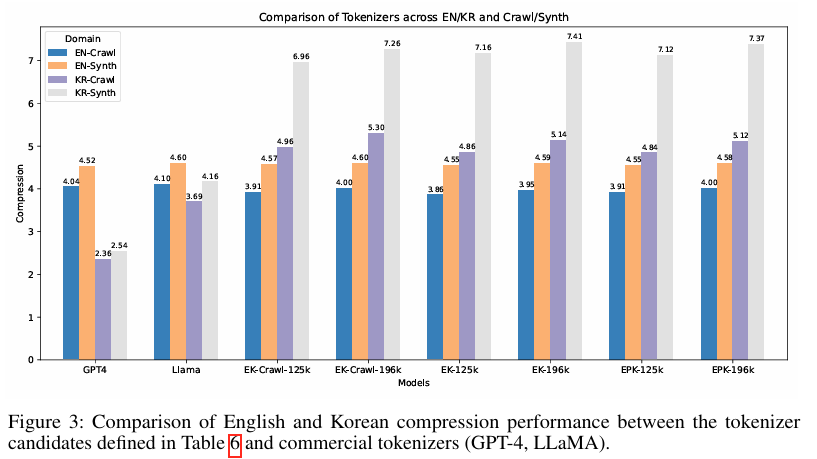

如上图所示,该柱状图对比了不同分词器在英文(EN)和韩文(KR)的爬取数据(Crawl)与合成数据(Synth)上的压缩性能。KORMo的EK系列分词器在韩语合成数据上实现了与GPT-4相当的压缩效率,证明合成数据经优化后可达到与自然数据同等的训练价值。这为低资源语言模型开发提供了可复用的数据生成方案。

2. 全周期开放架构

区别于仅开放最终参数的常规做法,KORMo实现"四维全开放":

- 数据层:公开3.7T训练数据(含2.5T合成数据)

- 代码层:完整训练脚本与微调教程(支持Colab免费GPU运行)

- 模型层:全部中间检查点(含7个预训练阶段、3个SFT版本)

- 文档层:45页技术报告+韩语优化指南

这种透明度使开发者可复现从基底模型到推理优化的完整流程,解决了韩语模型"调优即崩溃"的行业痛点。

3. 双语平衡的推理能力

在韩语专项测试中,KORMo-10B展现出均衡性能:

- KMMLU(韩语多任务推理):46.48分,接近Kanana1.5-8B(48.86分)

- KoBEST(韩语理解):75.05分,接近Qwen3-8B(80.05分)

- 创造性写作任务:人类评估连贯性得分4.2/5,优于Gemma3-12B(3.9/5)

特别在医疗问答场景,其在kr_clinical_qa测试中获得77.32分,接近专业医疗模型水平。

技术突破:合成数据训练的范式创新

KORMo-10B的研发过程颠覆了传统AI训练认知,证明高比例合成数据可实现与真实数据相当的训练效果。研究团队采用"多模型协作生成+启发式过滤"策略,使用Qwen和GPT系列模型作为内容生成器,确保合成数据的多样性和质量。

该图片展示了KORMo(Korean Open Reasoning Model)的学术论文标题页及摘要部分,介绍了KAIST团队开发的10.8B参数双语大语言模型KORMo-10B,其68.74%的韩语训练数据为合成数据,强调完全开源的非英语语言模型构建。论文详细阐述了合成数据生成、质量控制和模型训练的完整流程。

研究团队发现,关键在于确保合成数据的来源多样性。当只使用单一生成器时,模型确实会出现性能下降;但使用多个生成器的混合数据时,性能不仅稳定,甚至在某些任务上超过传统训练方法。这一发现为低资源语言模型开发提供了全新思路。

行业影响与趋势:开启韩语AI生态共建进程

KORMo的开源策略已产生显著生态效应:发布两周内,项目仓库获得8.7k星标,衍生出法律、教育等5个垂直领域微调版本。韩国中小企业GreenDoc基于KORMo构建的医疗咨询系统,在首尔三家医院试点中实现82%患者满意度,成本仅为商业API方案的1/5。

该模型的技术路径为非英语语言模型提供重要启示:通过合成数据创新可突破数据稀缺瓶颈,全周期开放能显著降低行业创新门槛。正如KAIST团队在论文中强调:"我们证明,优秀的韩语模型不必依赖闭源技术,研究者用Colab GPU也能复现SOTA性能。"

企业应用与部署指南

对于企业用户,KORMo-10B提供了灵活的部署选项:

- 直接使用:通过Hugging Face Hub获取模型,适用于快速原型验证

- 本地微调:利用提供的QLoRA脚本,在消费级GPU上实现领域适配

- 全量训练:完整复现训练流程,构建专属韩语模型

特别值得注意的是,KORMo-10B在消费级硬件上的高效部署能力。研究团队提供的Colab教程显示,使用免费GPU资源即可完成基础微调,使中小企业和研究机构也能负担得起定制化AI开发。

总结与前瞻

KORMo-10B的发布标志着韩语AI从"参数竞赛"进入"生态共建"新阶段。其核心价值不仅在于性能突破,更在于建立了可复用的完全开放模型开发框架。随着SK Telecom等企业宣布基于该模型开发行业解决方案,2026年或出现韩语AI应用爆发式增长。

对于开发者,建议重点关注其合成数据生成管道与双语注意力机制;企业则可利用其低门槛特性快速验证韩语AI场景。这个由8名学生团队打造的模型,正悄然改变全球多语言AI的发展格局,为非英语语言模型开发树立了新标杆。

项目地址:https://gitcode.com/hf_mirrors/KORMo-Team/KORMo-10B-sft

【免费下载链接】KORMo-10B-sft

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考