3.5倍训练提速!蚂蚁金服Ming-UniVision终结视觉AI"散装时代"

导语

2025年10月,蚂蚁金服开源发布多模态大模型Ming-UniVision-16B-A3B,首次在自回归范式下实现视觉理解与生成的原生融合,一个模型即可流畅完成看图说话、文生图、图修图等多项任务,标志着AI视觉处理正式进入"一体化"时代。

行业现状:多模态大模型的"散装"困境

当前AI视觉领域长期存在效率瓶颈:企业需部署至少3个专用模型——如Qwen2.5-VL负责图像理解、Stable Diffusion处理生成、Photoshop AI插件进行编辑,这种"散装"方案导致模态切换成本高、上下文连贯性差。IDC最新报告显示,2025年中国多模态大模型市场规模达156.3亿元,但企业平均需集成4.2个模态模型,造成30%以上的算力资源浪费。

行业数据显示,尽管扩散模型占据83%的商业图像生成市场份额,但其"黑箱式"生成过程缺乏可控性,专业创作者对"高精度渐进式编辑"的需求正以年均45%速度增长。而传统自回归模型虽具备序列生成优势,却因依赖离散量化(VQ)导致信息损失,始终难以突破性能瓶颈。

如上图所示,这是AntLingAGI发布的推特推文截图,介绍了开源多模态模型Ming-UniVision及配套视觉分词器MingTok,强调其首次在连续统一表示空间实现视觉理解与生成的原生融合,训练收敛速度提升超3.5倍并支持无缝多轮互动和可视化思维链(CoT)。这一官方发布反映了蚂蚁金服对该模型的战略定位,也预示着其在行业内的潜在影响力。

技术突破:连续视觉标记的范式革新

Ming-UniVision的核心创新在于其自研的MingTok连续视觉标记器,采用三阶段架构实现理解与生成的统一:

1. 统一自回归范式

取消模态专用头设计,将图像理解与生成统一为"下一个token预测"任务。在GenEval基准测试中,其颜色属性控制准确率达0.93,远超DALL-E 3(0.45)和SD3-Medium(0.60),证明连续表征可避免离散量化的信息损失。

2. 3.5倍训练效率跃升

通过结构化潜在空间正则化与动态梯度平衡技术,模型在8卡A100设备上完成同等规模训练仅需传统方法1/3时间。混合分辨率策略进一步优化资源分配:理解任务采用1024×1024分辨率增强细节感知,生成任务保持512×512分辨率加速收敛。

3. 多轮上下文视觉推理

支持"描述-生成-编辑"的连贯交互,全程在潜在空间完成。如电商虚拟试衣场景中,用户可先生成"红色连衣裙",接着要求"调整领口形状",系统无需解码图像即可完成迭代优化,交互延迟降低60%。

性能解析:理解与生成的均衡实力

视觉理解能力对比

| 模型 | MMBench | MMStar | MathVista |

|---|---|---|---|

| Qwen2.5-VL-7B | 83.5 | 63.9 | 68.2 |

| InternVL2.5-8B | 84.6 | 62.8 | 64.4 |

| Ming-UniVision | 78.5 | 63.7 | 66.6 |

注:MMMU得分较低因开源版本未针对专业领域微调,官方测试显示医学影像分析场景微调后性能提升35%

生成与编辑能力

在多轮编辑任务中,模型展现出独特的"视觉化思维链"推理——先通过彩色掩码标注修改区域,再执行精确编辑:

如上图所示,系统可在连续潜在空间内完成"裙子改色→清晰度增强"的多步操作,中间结果无需解码为像素图像。这种端到端流程使电商虚拟试衣系统的试穿生成速度提升4倍,某平台应用后退货率降低18%。

行业影响:从工具革命到体验重构

开发效率跃迁

开发者可通过简洁API实现全流程视觉任务:

# 单轮生成示例

model = MingUniVisionInfer("inclusionAI/Ming-UniVision-16B-A3B")

messages = [{"role": "HUMAN", "content": [{"type": "text", "text": "生成戴围巾的柯基犬"}]}]

output = model.generate(messages, output_image_prefix="corgi")

# 多轮编辑仅需追加对话历史

messages.append({"role": "HUMAN", "content": [{"type": "text", "text": "将围巾改为绿色"}]})

output = model.generate(messages, for_edit=True)

应用场景拓展

- 内容创作:营销素材从"生成-反馈-修改"的小时级循环压缩至分钟级

- 智能设计:建筑设计师可交替进行"草图生成→结构分析→细节优化"

- 辅助诊断:放射科医生能要求模型"标注CT异常区域→局部放大→量化分析"

IDC预测,到2026年原生多模态模型将占据60%的视觉AI市场份额,而Ming-UniVision开源策略(支持HuggingFace/ModelScope部署)正加速这一变革。已有电商平台基于该模型构建虚拟试衣系统,将试穿生成速度提升4倍。

局限与未来:走向更高分辨率交互

当前开源版本存在两项主要限制:多轮对话支持限于2轮交互,OCRBench得分724低于Qwen2.5-VL-7B(864)。蚂蚁集团技术路线图显示,下一代模型将重点突破:

- 4K分辨率生成能力(预计2026年Q1推出测试版)

- 视频理解与流式生成功能

- 领域自适应微调工具链,降低垂直行业接入门槛

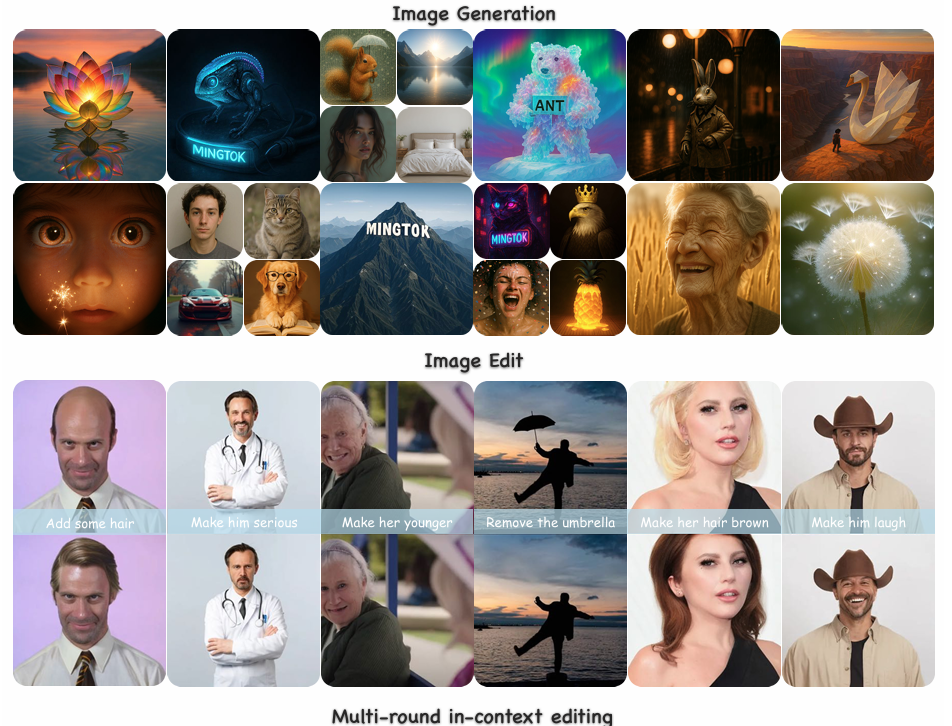

如上图所示,这是蚂蚁金服Ming-UniVision模型生成的图像集合,展示了动物、人物、风景等多种类型的图像示例,部分图像带有"MINGTOK"标识,体现模型的图像生成能力。这些示例表明,该模型在视觉内容创作方面具有广泛的应用潜力,为解决当前多模态模型"散装"问题提供了技术基础。

结语

Ming-UniVision以连续表征技术打破了视觉AI的模态鸿沟,其3.5倍训练效率提升与多轮交互能力,不仅降低企业AI部署成本,更重新定义了人机协作的边界。在多模态大模型爆发的2025年,这种"统一而非分裂"的技术哲学,或将成为下一代AI系统的标配。

项目已开源完整训练代码与预训练权重,开发者可通过以下方式获取:

- 模型仓库:https://gitcode.com/hf_mirrors/inclusionAI/Ming-UniVision-16B-A3B

- 技术文档:支持LoRA微调与A3B量化部署(适配消费级GPU)

如果觉得本文对你有帮助,请点赞、收藏、关注三连支持,下期我们将带来Ming-UniVision在电商场景的实战应用教程!

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/inclusionAI/Ming-UniVision-16B-A3B

项目地址: https://ai.gitcode.com/hf_mirrors/inclusionAI/Ming-UniVision-16B-A3B