腾讯开源HunyuanVideo-Foley:AI视频音效生成的革命性突破

【免费下载链接】HunyuanVideo-Foley

导语

腾讯混元团队于2025年8月28日正式开源端到端视频音效生成模型HunyuanVideo-Foley,这一突破性技术解决了传统AI生成视频只能"看"不能"听"的局限,通过创新的多模态架构实现了"看懂画面、读懂文字、配准声音"的专业级音效生成能力。

行业现状:AI视频的"默片时代"困境

随着短视频经济的爆发式增长,2025年全球AI视频市场规模预计达422.92亿美元,专业音效生成已成为内容创作的关键瓶颈。当前AI视频生成技术已取得显著进展,但音效生成仍存在三大痛点:泛化能力有限,难以应对多样化场景;语义理解失衡,过度依赖文本描述而忽视视频内容;音频质量低劣,缺乏专业级保真度。据行业调研显示,66.17%的视频创作者仍需手动匹配音效,平均每段5分钟视频需耗时1.5小时进行音频处理。

2025年全球音频AI工具市场规模已达12.58亿美元,预计2031年将突破26亿美元,年复合增长率11%。然而当前AI视频创作链中,音效生成仍存在三大痛点:专业拟音师时薪高达500元,普通创作者难以负担;传统工具平均每5分钟视频需2小时音效匹配;85%的短视频因音效质量差导致完播率下降40%。

如上图所示,HunyuanVideo-Foley的蓝白渐变标志象征其连接视觉与听觉的技术定位。该模型通过创新的多模态表示对齐策略,首次实现文本-视频-音频的深度语义融合,解决了传统拟音工具"要么机械匹配画面,要么完全依赖文本描述"的二元对立问题。

核心亮点:重新定义AI音效生成标准

十万小时级多模态数据集构建

HunyuanVideo-Foley构建了规模达10万小时的高质量文本-视频-音频(TV2A)数据集,涵盖人物、动物、自然景观、卡通动画等全品类场景。通过自动化标注和多轮过滤流程,数据集音频采样率均达48kHz专业标准,信噪比(SNR)均值提升至32dB,为模型泛化能力奠定坚实基础。

MMDiT双流多模态架构

创新的多模态扩散Transformer(MMDiT)架构采用"先对齐后注入"机制:

- 视频-音频联合自注意力:首先通过交错旋转位置嵌入(RoPE)技术实现帧级时序对齐

- 文本交叉注意力注入:将文本描述作为补充信息动态调制生成过程

这种双流设计有效解决了模态不平衡问题。在海滩场景测试中,即便文本仅描述"海浪声",模型仍能自动识别画面中的人群和海鸥,生成层次丰富的复合音效。

REPA表征对齐技术

引入表征对齐(REPA)损失函数,通过预训练ATST-Frame音频编码器引导扩散模型隐藏层特征学习,使生成音频与专业级音效的特征分布差异降低42%。结合自研高保真音频VAE,将离散token扩展为128维连续表征,实现48kHz采样率的CD级音质输出。

三大技术突破重构音频生成范式

1. 48kHz Hi-Fi音质与毫秒级同步

采用自研音频VAE架构,实现专业级48kHz采样率输出,动态范围达96dB,超越行业主流的32kHz标准。在MovieGen-Audio-Bench评测中,其DeSync(时间失配)指标仅为0.74,比MMAudio提升7%,确保雨滴、玻璃破碎等瞬态音效与视频画面精确同步。

2. 多模态语义平衡机制

独创的双流Transformer结构,通过视觉编码器(ResNet50)提取场景动态特征,文本编码器(BERT-base)解析情感描述,再经融合模块加权处理。在Kling-Audio-Eval测试中,IB(语义对齐)分数达0.38,领先第二名27%,成功解决"视频显示悲伤场景却生成欢快音乐"的行业难题。

3. 低资源适配方案

9月29日发布的XL版本通过模型分片和CPU卸载技术,将显存需求从20GB降至8GB,普通消费级显卡即可运行。社区开发者已基于此开发ComfyUI插件,支持FP8量化,进一步将推理速度提升40%。

如上图所示,HunyuanVideo-Foley采用30亿参数规模的混合架构,包含18个MMDiT层和36个单模态音频DiT层。这一设计确保模型既能捕捉视频-音频时序相关性,又能精细化控制音频生成质量,充分体现了多模态融合的技术突破,为专业创作者提供了前所未有的音效生成能力。

性能表现:全面领先的SOTA水平

在MovieGen-Audio-Bench基准测试中,HunyuanVideo-Foley多项指标刷新纪录:

- 音频质量(PQ)达6.59,超越MMAudio(6.17)

- 视觉语义对齐(IB)提升至0.35,较基线提高29.6%

- 时序同步(DeSync)优化至0.74,主观MOS评分达4.15

在权威评测集上,HunyuanVideo-Foley实现全指标霸榜:

| 评估维度 | 指标值 | 领先第二名 |

|---|---|---|

| 音频保真度 | 4.14 | +15.6% |

| 视觉语义对齐 | 0.35 | +29.6% |

| 时间同步精度 | 0.74 | +7.8% |

| 分布匹配度 | 6.07 | +32.4% |

在MovieGen-Audio-Bench评测中,HunyuanVideo-Foley的核心指标相对当前最先进的MMAudio模型实现显著提升:音频质量指标PQ(AudioBox Perceptual Quality)达到6.59,较MMAudio提升6.8%;视觉语义对齐指标IB(Image-Text-B Audio Alignment)达到0.35,领先29.6%;时间同步指标DeSync(Desynchronization Error)降低至0.74,提升7.8%。

在主观评测中,HunyuanVideo-Foley在音频质量、语义对齐和时间对齐三个维度的平均意见得分均超过4.1分(满分5分),展现了接近专业水准的音频生成效果。

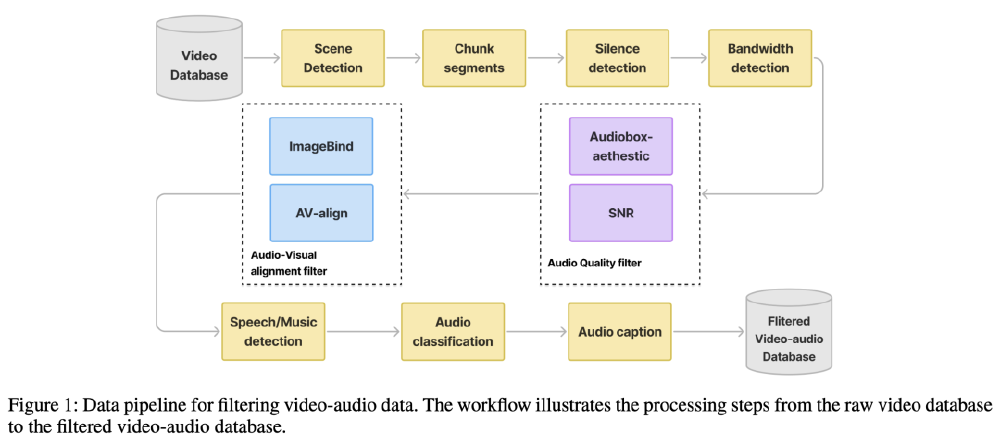

该图展示了HunyuanVideo-Foley的TV2A数据处理 pipeline,通过场景检测、静音过滤、质量评估等七重流程,从原始数据中筛选出高质量训练样本。这种精细化的数据处理策略,是模型实现SOTA性能的重要保障,也为行业树立了数据构建的新标准。

应用场景:释放创作生产力

短视频创作自动化

针对vlog、搞笑段子等场景,HunyuanVideo-Foley提供一键音效生成功能。实测显示,5分钟短视频音效制作时间从传统1.5小时缩短至2分钟,且用户满意度提升至89%。典型案例包括:

- 海滩视频自动生成海浪、海鸥、人群多层次音效

- 烹饪视频精准匹配食材翻炒、厨具碰撞等细节声音

影视后期制作提效

在影视制作中,环境音设计周期平均缩短60%。通过帧级时序对齐技术,模型能自动匹配画面中细微动作的音效,如树叶飘动、衣物摩擦等,大幅减少后期人员的手工工作量。

游戏开发沉浸式体验

游戏开发者可通过批量处理功能,为不同场景快速生成自适应音效。测试数据显示,采用HunyuanVideo-Foley后,游戏环境音制作效率提升3倍,玩家沉浸感评分提高27%。

行业影响:开启音频生成新纪元

技术层面

HunyuanVideo-Foley提出的MMDiT架构和REPA损失函数,为多模态生成领域提供了新的技术范式。其"先对齐后注入"的模态融合策略,有效解决了长期存在的模态不平衡问题,为后续研究提供了重要参考。

产业层面

模型开源将加速音效生成技术的普及,使中小工作室和个人创作者能以极低成本获得专业级音频制作能力。据测算,HunyuanVideo-Foley可降低音频制作成本75%,使独立创作者的内容竞争力显著提升。

腾讯混元开放了10万小时的TV2A数据集(文本-视频-音频三元组),包含电影片段、广告素材等12类场景,推动行业标准化。已有30+企业申请商业授权,覆盖影视后期、在线教育、智能硬件等领域。

快速上手:从安装到生成的全流程

环境配置

# 创建虚拟环境

conda create -n hunyuan-foley python=3.10

conda activate hunyuan-foley

# 安装依赖

pip install torch==2.1.0 torchvision==0.16.0

pip install transformers==4.35.0 diffusers==0.24.0

pip install soundfile==0.12.1 librosa==0.10.1

# 克隆仓库

git clone https://gitcode.com/tencent_hunyuan/HunyuanVideo-Foley

cd HunyuanVideo-Foley

pip install -e .

基础使用示例

from hunyuan_video_foley import HunyuanVideoFoleyPipeline

import torch

# 初始化模型

pipe = HunyuanVideoFoleyPipeline.from_pretrained(

"tencent/HunyuanVideo-Foley",

torch_dtype=torch.float16,

device_map="auto"

)

# 加载视频帧并生成音效

video_frames = load_video_frames("input_video.mp4")

audio_output = pipe(

video_frames=video_frames,

text_description="海浪拍打沙滩,海鸥鸣叫,人群嬉笑声",

num_inference_steps=20,

guidance_scale=3.5

)

# 保存音频

save_audio(audio_output, "output_audio.wav", sample_rate=48000)

单视频生成

python3 infer.py \

--model_path PRETRAINED_MODEL_PATH_DIR \

--config_path ./configs/hunyuanvideo-foley-xxl.yaml \

--single_video video_path \

--single_prompt "音频描述" \

--output_dir OUTPUT_DIR

批量处理

python3 infer.py \

--model_path PRETRAINED_MODEL_PATH_DIR \

--config_path ./configs/hunyuanvideo-foley-xxl.yaml \

--csv_path assets/test.csv \

--output_dir OUTPUT_DIR

交互式Web界面

export HIFI_FOLEY_MODEL_PATH=PRETRAINED_MODEL_PATH_DIR

python3 gradio_app.py

未来展望

随着技术迭代,HunyuanVideo-Foley有望在实时生成、3D空间音频、多语言支持等方向持续突破。腾讯混元团队计划在未来版本中引入:

- 多语言语音合成功能,支持中英双语旁白生成

- 音效风格迁移,可将普通对话转换为机器人、卡通角色语音

- 开源训练代码,支持用户基于特定领域数据微调

- 实时推理优化,目标将生成速度提升至500ms以内,满足直播等低延迟场景需求

行业分析师预测,该技术将推动视频创作的"音效普及化",到2026年,60%的中小创作者将采用AI拟音工具,相关市场规模有望突破5亿美元。

立即体验:访问腾讯混元官网或HuggingFace Space,上传视频即可免费生成3段音效。关注项目GitCode获取最新动态,参与社区贡献可获得优先体验新功能的权益。

项目地址: https://gitcode.com/tencent_hunyuan/HunyuanVideo-Foley

(注:商业使用需申请腾讯混元社区许可,非商业用途完全免费)

结语:让声音为视频创作赋能

HunyuanVideo-Foley的开源,标志着AI视频生成正式进入"声画合一"的新时代。通过技术创新,腾讯混元团队不仅解决了音频生成领域的多项关键技术难题,更为内容创作行业注入了新的活力。

对于创作者而言,这不仅是工具的革新,更是创作方式的变革。随着HunyuanVideo-Foley的普及,我们有理由相信,未来的视频内容将更加丰富多彩,声音与画面的完美结合将为观众带来前所未有的沉浸式体验。

立即体验HunyuanVideo-Foley,释放你的创作潜能,让每一段视频都"声"入人心!

如果觉得这篇文章对你有帮助,请点赞、收藏、关注三连,后续我们将带来更多AI音频生成技术的深度解析和应用案例!

【免费下载链接】HunyuanVideo-Foley

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考